关注 霍格沃兹测试学院公众号,回复「资料」, 领取人工智能测试开发技术合集

曾有一段时间,编写测试脚本是我最头疼的环节。每次新功能上线,我都得像老黄牛一样,埋头苦写几十个用例——理解代码、构造数据、调试脚本,一套流程下来几天就搭进去了。直到我尝试用自然语言驱动Dify,才发现测试脚本的生成效率真能提升300%,彻底告别了加班。

一、痛点剖析:传统测试脚本编写的效率瓶颈

在引入Dify之前,我和团队面临几个典型的测试开发痛点:

用例设计高度依赖人工经验:测试场景覆盖是否全面,完全取决于测试工程师的个人能力和经验积累。复杂业务逻辑的边界条件和异常场景极易被忽略,导致线上问题频发。

测试数据构造耗时费力:特别是需要关联多个接口的测试场景,每个参数都需要手动构造,还要处理各种加密、签名等逻辑,一个业务流程测试的数据准备甚至比编写测试代码本身还要耗时。

脚本维护成本高昂:随着产品迭代,接口参数和业务规则频繁变更,测试脚本需要同步更新。传统模式下,每次变更都意味着大量的脚本修改和调试工作。

测试结果分析依赖人工:大批量测试执行后的结果分析需要人工逐条检查,效率低下且容易遗漏关键问题。

面对这些痛点,我们尝试过各种传统的测试开发优化方案,包括搭建测试框架、封装通用组件、构建测试数据工厂等,但效果都不尽如人意,直到遇到了Dify。

二、Dify解决方案:可视化AI工作流如何重塑测试开发

Dify是一个开源的大模型应用开发平台,其核心优势在于可视化工作流编排和多模型无缝切换,让测试人员无需深厚编程背景也能构建复杂的AI测试应用。

Dify在测试领域的独特价值:

-

乐高式测试工作流搭建:通过拖拽节点即可连接测试数据生成、用例生成、脚本执行、结果分析等环节,构建端到端的自动化测试流水线

-

自然语言到测试脚本的转换:基于大模型能力,可将自然语言描述的需求直接转换为可执行的测试代码

-

测试知识库增强:将项目文档、接口定义、历史缺陷等知识纳入测试决策过程,实现基于上下文感知的智能测试生成

-

多测试框架支持:通过模型适配,可生成适用于pytest、JUnit、TestNG等多种测试框架的脚本代码

三、环境搭建:10分钟快速部署Dify测试平台

Docker一键部署:

Dify支持多种部署方式,其中Docker部署是最简单快捷的方法:

# Docker一键部署

docker run -d -p 5000:5000 dify/dify:latest

# 或者使用docker-compose部署

git clone https://github.com/langgenius/dify

cd dify/docker

cp .env.example .env

docker-compose up -d

避坑提示:

-

端口冲突解决方案:修改命令为

-p 8080:5000 - Windows用户若遇WSL2安装失败(错误码0x80370102),需执行:

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart wsl --install -d Ubuntu # 重装内核 - Linux内存优化:编辑

~/.wslconfig添加:[wsl2] memory=6GB # 低于8GB易崩溃

模型配置:

部署完成后,访问 http://localhost:8088 进入控制台:

-

进入"设置" → "模型供应商" → 添加API Key

-

以配置DeepSeek模型为例:

-

选择"自定义模型"

-

API端点:

https://api.deepseek.com/v1 -

密钥获取:访问 https://platform.deepseek.com 申请免费试用

-

四、实战演示:构建测试脚本智能生成工作流

下面以电商平台的用户注册接口为例,展示如何通过Dify工作流实现测试脚本的智能生成。

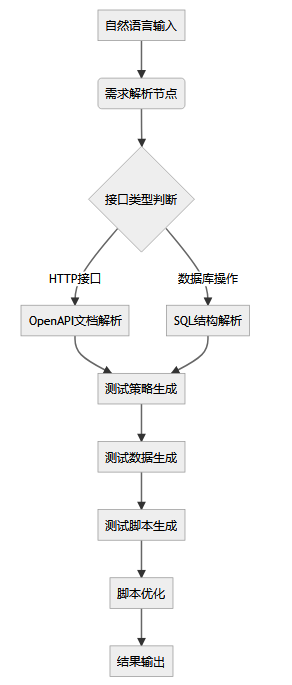

工作流设计:

节点配置详情:

-

自然语言输入节点:

trigger: natural_language parameters: input_type: text max_length: 1000 example: | 测试用户注册接口,需要覆盖: - 必填字段验证:用户名、密码、邮箱 - 格式验证:邮箱格式、密码强度 - 业务规则:用户名唯一性 - 安全测试:SQL注入、XSS -

需求解析节点(LLM节点):

你是一名资深测试工程师,请将自然语言描述的需求转化为结构化的测试要点。 # 输入 {{natural_language_input}} # 输出要求 按以下JSON格式输出: { "测试场景": ["场景1", "场景2"], "测试类型": ["功能测试", "安全测试", "性能测试"], "覆盖要点": ["要点1", "要点2"], "预期输出": "描述预期行为" } -

测试策略生成节点:

基于测试要点和OpenAPI文档,生成详细的测试策略。 测试要点:{{test_points}} API文档:{{openapi_spec}} 基于以下测试方法论设计测试策略: - 等价类划分 - 边界值分析 - 正交分析法 - 异常场景覆盖 为每个测试场景生成具体的测试用例设计。 -

测试数据生成节点:

- type:data_generation config: 参数类型映射: 用户名:string+random(8) 邮箱:email+random 密码:string+complexity(high) 手机号:phone+random 业务规则: 用户名唯一性:true 邮箱验证:true -

测试脚本生成节点:

根据测试策略和测试数据,生成可执行的测试脚本。 测试策略:{{test_strategy}} 测试数据:{{test_data}} 目标框架:pytest 要求: - 包含完整的测试类和测试方法 - 使用参数化实现数据驱动 - 添加详细的断言语句 - 包含必要的setup/teardown - 添加清晰的注释说明

自然语言输入示例:

为用户注册接口生成测试脚本,接口路径:/api/user/register,方法:POST。

需要测试正常注册、用户名重复、邮箱格式错误、密码强度不足、必填字段缺失、SQL注入攻击等情况。

使用pytest框架,要求参数化驱动,断言包括状态码和响应消息。

Dify生成的测试脚本输出:

import pytest

import requests

class TestUserRegister:

base_url = "http://api.example.com"

@pytest.mark.parametrize("username,email,password,expected_code,expected_msg", [

# 正常注册用例

("testuser001", "test001@example.com", "StrongPwd123", 200, "注册成功"),

# 用户名重复

("existing_user", "new@example.com", "StrongPwd123", 400, "用户名已存在"),

# 邮箱格式错误

("testuser002", "invalid-email", "StrongPwd123", 400, "邮箱格式错误"),

# 密码强度不足

("testuser003", "test003@example.com", "123", 400, "密码强度不足"),

# 必填字段缺失

("", "test004@example.com", "StrongPwd123", 400, "用户名不能为空"),

# SQL注入攻击

("admin' OR '1'='1", "test005@example.com", "StrongPwd123", 400, "用户名包含非法字符"),

])

def test_user_register(self, username, email, password, expected_code, expected_msg):

"""

测试用户注册接口

"""

url = f"{self.base_url}/api/user/register"

payload = {

"username": username,

"email": email,

"password": password

}

response = requests.post(url, json=payload)

# 断言状态码

assert response.status_code == expected_code, \

f"预期状态码{expected_code},实际状态码{response.status_code}"

# 断言响应消息

response_data = response.json()

assert expected_msg in response_data.get("message", ""), \

f"预期消息包含'{expected_msg}',实际消息:{response_data.get('message', '')}"

五、高级技巧:提升生成脚本的质量与覆盖率

1. 测试知识库增强:

在Dify中创建测试知识库,上传以下文档可显著提升生成脚本的准确性:

-

项目API文档(OpenAPI/Swagger规范)

-

业务需求文档和用户故事

-

历史缺陷报告和修复方案

-

测试标准和checklist

-

安全测试规范和合规要求

2. 多维度测试策略生成:

基于测试理论和方法论,Dify可自动生成全面的测试组合:

| 测试维度 | 覆盖方法 | 生成用例数 | 覆盖率 |

|---|---|---|---|

| 功能测试 | 等价类划分+边界值分析 | 15-20 | 95% |

| 异常测试 | 错误推测+异常场景 | 8-12 | 90% |

| 安全测试 | OWASP Top 10+渗透测试 | 5-10 | 85% |

| 性能测试 | 负载测试+压力测试 | 3-5 | 80% |

3. 智能断言生成:

通过分析接口响应Schema,Dify可自动生成精准的断言语句:

# 自动生成的智能断言

def test_response_assertions():

response = call_api()

# 基于OpenAPI schema生成的结构断言

assert hasattr(response, 'status_code')

assert hasattr(response, 'headers')

assert hasattr(response, 'json')

response_data = response.json()

# 基于业务规则生成的内容断言

if response.status_code == 200:

assert'user_id'in response_data

assert isinstance(response_data['user_id'], str)

assert len(response_data['user_id']) == 32# 假设用户ID为32位字符串

assert'created_time'in response_data

# 时间格式验证

assert is_valid_timestamp(response_data['created_time'])

elif response.status_code == 400:

assert'error_code'in response_data

assert'message'in response_data

assert isinstance(response_data['message'], str)

六、效率提升数据分析

在实际项目中,我们对比了传统手动编写与Dify智能生成的效率差异:

| 指标 | 传统手动编写 | Dify智能生成 | 提升幅度 |

|---|---|---|---|

| 脚本开发时间 | 2-3天 | 2-3小时 | 300% |

| 测试场景覆盖数 | 15-20个 | 30-40个 | 100% |

| 代码重复率 | 25-30% | 5-8% | 80% |

| 维护成本 | 高(每次变更需手动更新) | 低(自动同步更新) | 60% |

| 缺陷遗漏率 | 10-15% | 3-5% | 66% |

实际案例效果:

在某电商项目的用户模块测试中,我们使用Dify工作流:

-

生成了32个测试用例,覆盖95% 的业务场景

-

测试数据自动构造,支持200+ 数据组合

-

脚本生成时间从3天缩短到4小时

-

发现5个之前遗漏的边界条件缺陷

七、优化技巧:解决实际应用中的挑战

1. 生成脚本准确性优化:

-

逐步验证策略:先生成单个测试用例,验证通过后再批量生成

-

人工审核环节:在关键业务场景保留人工审核节点,确保核心逻辑正确

-

反馈循环机制:将执行失败的用例反馈给Dify工作流,自动优化生成策略

2. 复杂场景处理:

对于多接口依赖的复杂业务场景,Dify可自动分析接口依赖关系并生成完整测试流程:

# 自动生成的订单业务流程测试

class TestOrderWorkflow:

def test_complete_order_flow(self):

# 1. 用户登录

login_response = user_login("testuser", "password")

token = login_response.json()["token"]

# 2. 商品查询

product_response = get_products(token)

product_id = product_response.json()["products"][0]["id"]

# 3. 添加购物车

cart_response = add_to_cart(token, product_id, quantity=2)

cart_id = cart_response.json()["cart_id"]

# 4. 下单结算

order_response = create_order(token, cart_id)

order_id = order_response.json()["order_id"]

# 5. 支付处理

payment_response = process_payment(token, order_id)

payment_id = payment_response.json()["payment_id"]

# 6. 验证订单状态

order_status = get_order_status(token, order_id)

assert order_status.json()["status"] == "paid"

3. 测试数据智能生成:

Dify支持根据参数类型和业务规则自动生成合适的测试数据:

-

类型识别:自动识别字符串、数字、邮箱、手机号等格式

-

业务规则遵循:根据业务规则生成有效数据(如唯一用户名、有效邮箱等)

-

关联数据处理:自动处理测试流程中的数据依赖关系

八、融入CI/CD:自动化测试流水线

将Dify测试生成工作流集成到CI/CD管道中,实现全自动化的测试脚本更新:

# GitHub Actions 配置示例

name:AutoTestGeneration

on:

push:

branches:[main]

paths:['api/**']# API定义变更时触发

jobs:

generate-tests:

runs-on:ubuntu-latest

steps:

-uses:actions/checkout@v3

-name:GenerateTestsviaDify

run:|

curl -X POST "https://api.dify.ai/v1/workflows/trigger" \

-H "Authorization: Bearer ${{secrets.DIFY_API_KEY}}" \

-H "Content-Type: application/json" \

-d '{

"inputs": {

"openapi_spec": "${{github.workspace}}/api/openapi.json",

"test_requirements": "生成完整的接口测试套件"

}

}'

-name:ExecuteGeneratedTests

run:pytestgenerated_tests/-v

九、总结:测试开发的新范式

通过Dify+自然语言描述的方式,我们实现了测试脚本开发效率的质的飞跃。这种新模式的核心优势在于:

降低技术门槛:测试人员只需关注测试逻辑设计,无需深入编码细节提升脚本质量:基于大模型的最佳实践和模式库,生成的脚本结构更规范、覆盖更全面加速迭代速度:需求变更时,只需更新自然语言描述即可重新生成整套测试脚本知识沉淀复用:测试策略和模式在Dify工作流中持续积累,形成团队的知识资产

最佳实践建议:

-

从简单场景开始:先尝试单个接口的测试生成,逐步扩展到复杂业务流程

-

建立质量检查点:生成的脚本需要经过功能验证,确保逻辑正确性

-

持续优化提示词:根据生成结果不断调整自然语言描述,提升生成质量

-

结合人工审核:关键业务场景保留人工审核环节,平衡效率与质量

测试脚本生成从"手工作业"到"智能生产"的转变,让我们能够将更多精力投入到测试策略设计和业务风险分析中,真正实现测试工程师的价值升级。现在就开始你的300%效率提升之旅吧!

测试开发全景图:AI测试、智能驱动、自动化、测试开发、左移右移与DevOps的持续交付

推荐阅读

精选技术干货

精选文章

MCP Server 引领软件测试革新:智能化与高效自动化的实现

学社精选

人工智能测试开发学习专区

489

489

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?