还在为“学AI该买什么显卡”、“跑AI绘画要什么配置”、“训练大模型是不是必须天价卡”纠结?别让参数迷了眼!选显卡的核心就一条:匹配你的真实需求! 本文用一张表说清2025年主流学习、创作、开发三大场景的黄金选择,新手照着选,不花冤枉钱!

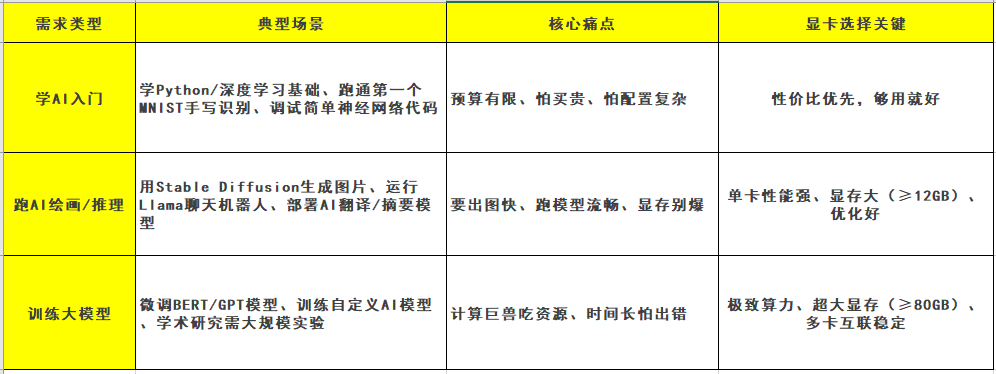

一、 选卡第一步:明确你属于哪类玩家?

✅ 关键提示: 90%的新手其实属于 “学AI入门”或“跑AI绘画”!别盲目追求旗舰卡!

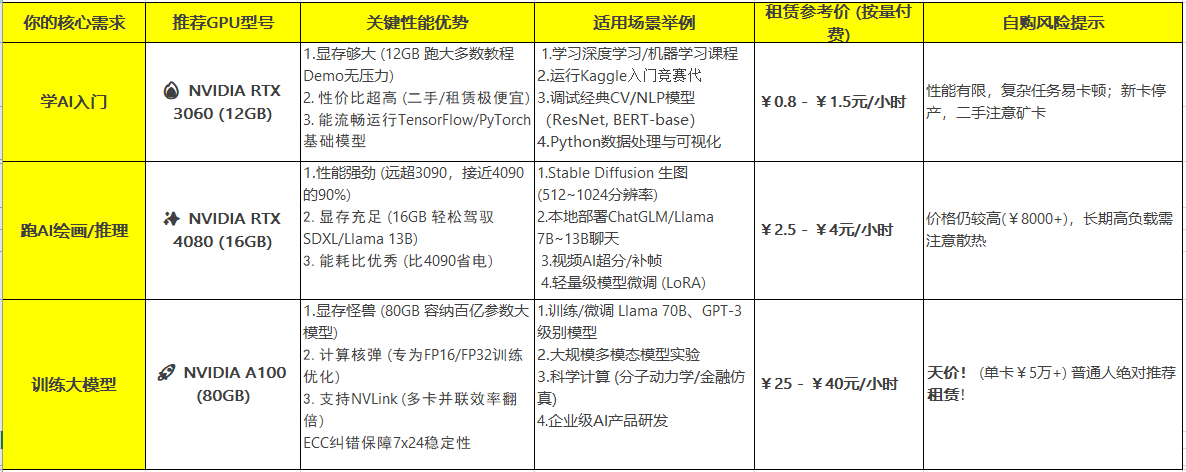

二、 2025新手显卡推荐表:按需对号入座

📌 避坑补充:

警惕“显存刺客”卡: 某些卡(如RTX 4060 Ti 8G)核心强但显存小,跑SDXL生图易爆显存崩溃!

勿选老旧架构卡: GTX 16系(如1650/1660)或更老显卡,缺乏Tensor Core,跑AI效率极低。

Mac M芯片谨慎选: 虽然跑CoreML优化好,但CUDA生态兼容性差,很多AI工具链不支持。

三、 为什么这么选?性能场景深度解析

1. 学AI入门:为什么是RTX 3060 12GB?

-

显存是命门: 许多教程数据集(如CIFAR-10)和基础模型(BERT-base)在加载后需约6-10GB显存,8G卡(如3060 Ti)极易爆显存报错,12GB是安全线。

-

性价比无敌: 二手市场大量流通,租赁成本接近“白菜价”(1元/小时),试错成本趋近于零。

-

生态兼容好: NVIDIA CUDA + PyTorch/TF组合拥有最全教程和社区支持,避开发环境配置的坑。

2. 跑AI绘画/推理:为什么4080比4090更香?

-

4090溢价过高: 2025年RTX 4090仍要¥1.2万+,比4080贵50%,但性能仅提升约20%。

-

16GB显存甜点区: 运行SDXL模型(分辨率1024x1024)仅需约12GB显存,16GB留有充足缓冲应对复杂提示词。80GB的A100对生图属于严重浪费。

-

能效比优势: 4080满载功耗约320W,4090高达450W,长期挂机生图电费差距显著。

3. 训练大模型:为什么只能选A100/H100?

-

显存决定天花板: 训练70B参数模型需约140GB显存,单卡A100 80GB需搭配ZeRO-3优化;消费级显卡(如4090 24GB)连加载都困难。

-

双精度与稳定性: A100的FP64双精度性能是消费卡的数十倍,且ECC内存能防止连续训练一周因内存错误崩掉。

-

多卡扩展刚需: 通过NVLink互联,8卡A100可视为“一台超算”,而消费卡多卡效率折损严重。

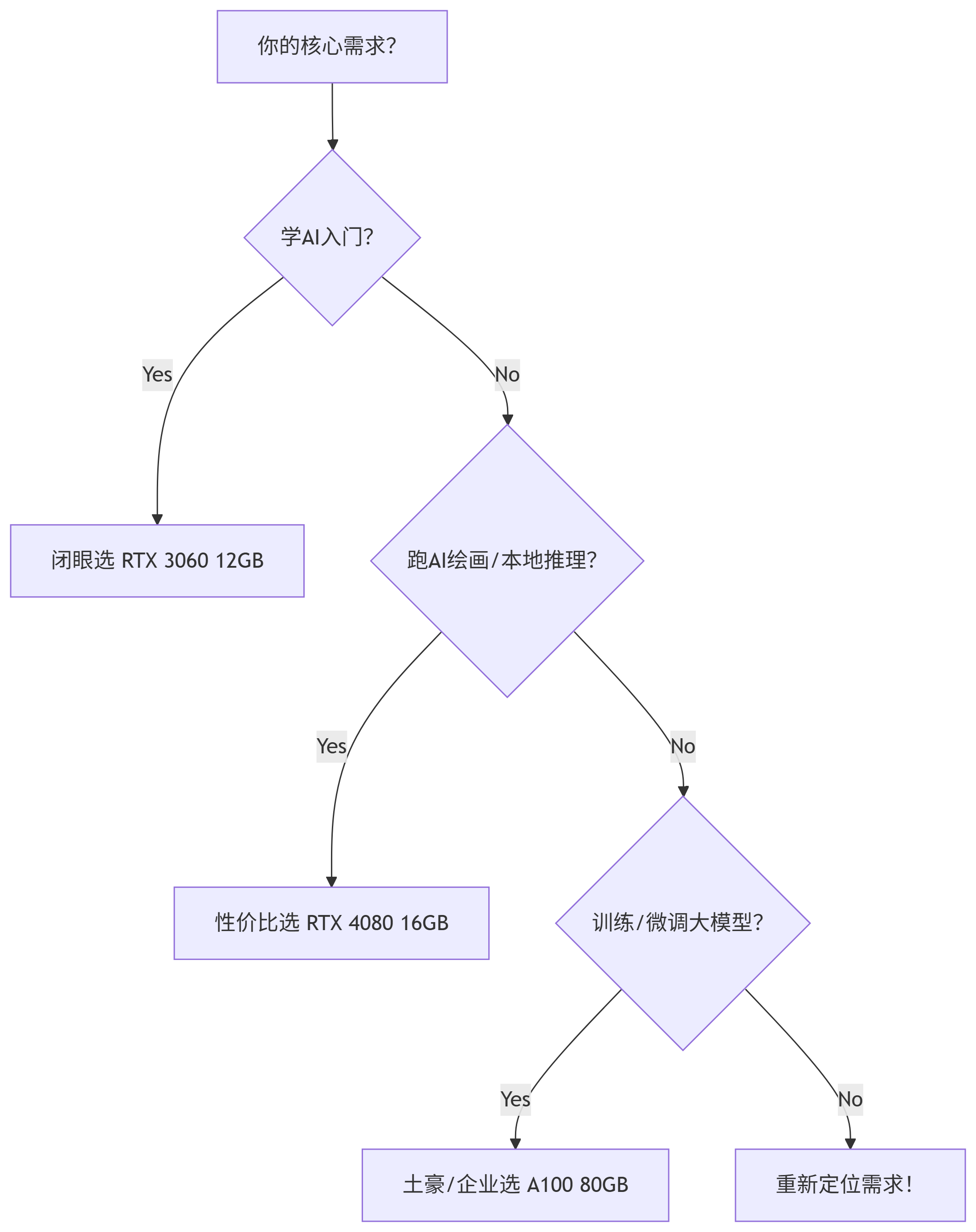

四、 终极懒人选卡流程图

五、 重要提醒:2025年显卡租赁 > 自购!

无论你属于哪一类需求,强烈建议先租后买(或不买)! 原因很现实:

-

试错成本低: ¥50租用费体验4080,比盲目花8000买卡后悔强百倍。

-

技术迭代快: RTX 50系、B100等新卡发布在即,现在买高端卡贬值飞快。

-

免维护省心: 不用操心散热、供电、驱动崩溃,专注任务本身。

-

灵活应对需求: 今天用3060学基础,明天租A100跑大实验,弹性自由。

👉 行动指南:

入门/绘画用户: 在AutoDL/极智算等平台 租用 RTX 3060 或 4080(新用户赠金足够体验)。

大模型玩家: 联系平台租 多卡A100集群,按需付费才是王道。

坚决不自购: 除非你确定每天满载8小时+连用3年不换卡!

记住:匹配需求的显卡,才是好显卡! 用好这张表,选卡不踩雷,聪明开启你的AI之旅吧!🚀

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?