BERT(Bidirectional Encoder Representations from Transformers)

论文: https://arxiv.org/abs/1810.04805.

代码及预训练模型: https://github.com/google-research/bert.

序言

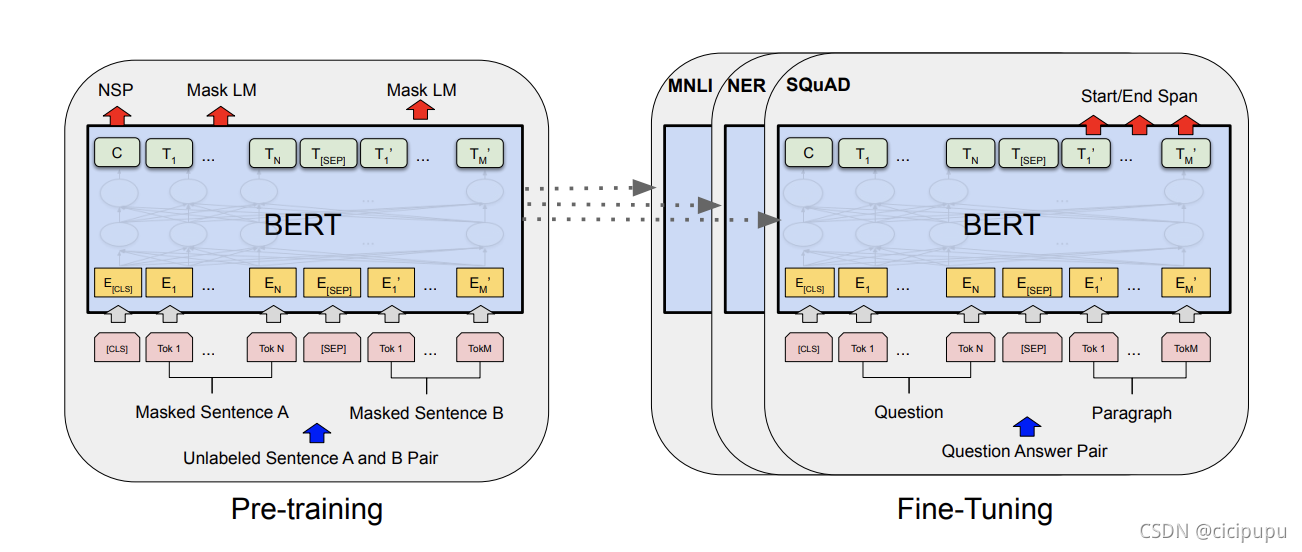

BERT is designed to pretrain deep bidirectional representations from

unlabeled text by jointly conditioning on both left and right context in all layers. As a result, the pre-trained BERT model can be finetuned with just one additional output layer to create state-of-the-art models for a wide

range of tasks, such as question answering and language inference, without substantial taskspecific architecture modifications.

BERT作为大规模预训练模型,使用unlabel的语料进行预训练,但其经过微调后在下游任务中却能取得非常好的表现。

有人用“一切过往, 皆为序章”形容BERT可以说非常有趣,BERT的提出改变了NLP的生态,就如同word embedding被提出时一般,现在的相关比赛都逃不开BERT及其衍生的模型。

在这篇文章,我们主要介绍三个方面内容

- BERT模型结构

- 怎么pre-train

- 怎么fine-tuning

BERT网络架构

BERT采用了双向Transformer堆叠的网络结构,其中large bert 和base bert对应复杂和简单两个bert模型。

BERT是一种采用Transformer架构的预训练语言模型,通过无标签文本的双向编码学习深层表示。该模型在经过微调后,能在各种NLP任务中表现出卓越性能,如问答和语义推理。博客主要探讨BERT的模型结构、预训练方法以及如何进行任务特定的微调。此外,还分享了BERT在NLP领域的广泛应用和影响。

BERT是一种采用Transformer架构的预训练语言模型,通过无标签文本的双向编码学习深层表示。该模型在经过微调后,能在各种NLP任务中表现出卓越性能,如问答和语义推理。博客主要探讨BERT的模型结构、预训练方法以及如何进行任务特定的微调。此外,还分享了BERT在NLP领域的广泛应用和影响。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?