最近实习工作需要自己着手学习多模态大模型微调的相关知识,在此之前笔者只有一些模糊的理论知识,实践经验几乎为0,特此记录学习路径,欢迎大家评论区讨论学习~

一、autodl部署LLaMA Factory

打开LLaMA Factory的github链接:https://github.com/hiyouga/LLaMA-Factory 中的readme文件

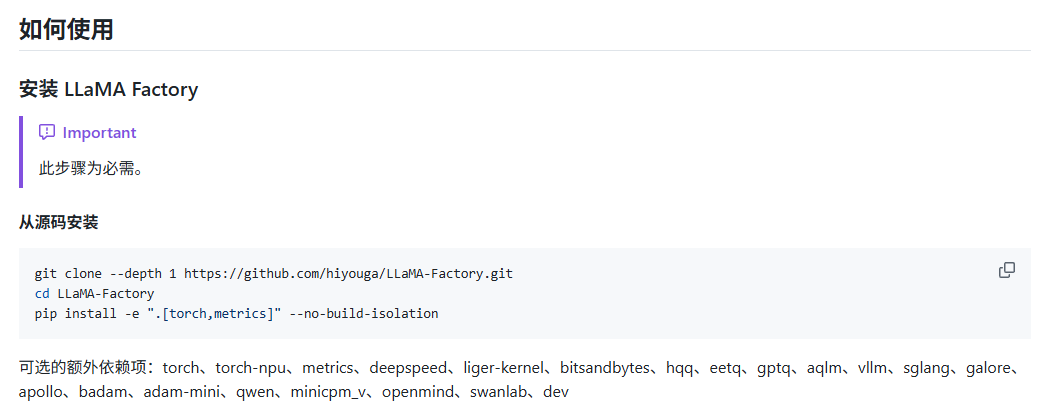

跳转到"如何使用":

在终端执行上述3行命令(如果没办法科学上网,可以先将github项目导入到gitee仓库中,然后复制gitee的项目地址):

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]" --no-build-isolation这样就完成了LLaMA Factory部署和环境的搭建。

二、尝试使用LLaMA Factory的webui页面实现0代码微调

在终端运行:

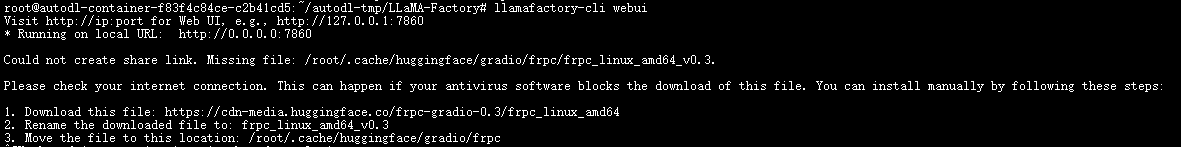

llamafactory-cli webui此时可能会出现下述情况:

按照提示操作:下载文件 --> 文件重命名 --> 并将文件放置在指定目录中

这里如果没办法科学上网的话,可以使用迅雷辅助下载:进入迅雷界面,点击新建,复制链接进去就ok了。

在autodl中的jupyterLab,.cache目录是没办法显式操作的,所以采用下述指令将下载的文件放置到指定目录:

mv autodl-tmp/frpc_linux_amd64_v0.3 /root/.cache/huggingface/gradio/frpc格式是:mv 文件当前地址 目标地址

上述操作完成后再次在终端执行命令:

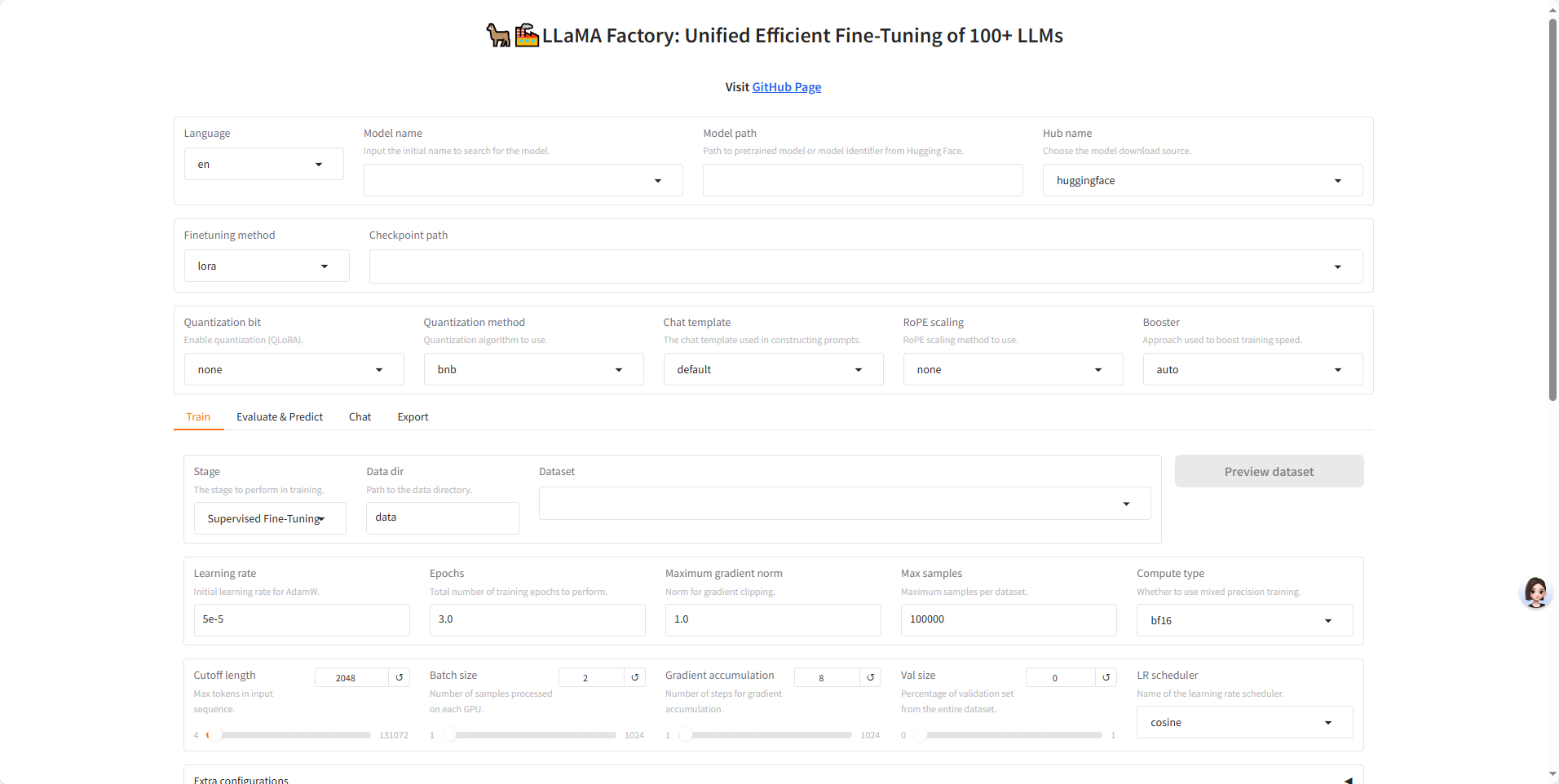

llamafactory-cli webui得到:

![]()

local URL这里我是打不开的,查阅资料说是需要在autodl容器实例---自定义服务配置端口代理。然后按照官方指示操作就好了。配置完成后,点击链接就能访问了:

如果有一些知识上的问题,欢迎指正~

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?