该文章核心是揭示扩散大型语言模型(DLLMs)在长链推理(Long CoT)中存在的“并行-顺序矛盾(PSC)”,并提出缓解策略,同时分析了其推理能力局限与缩放特性。

一、文章主要内容总结

- 核心矛盾:并行-顺序矛盾(PSC)

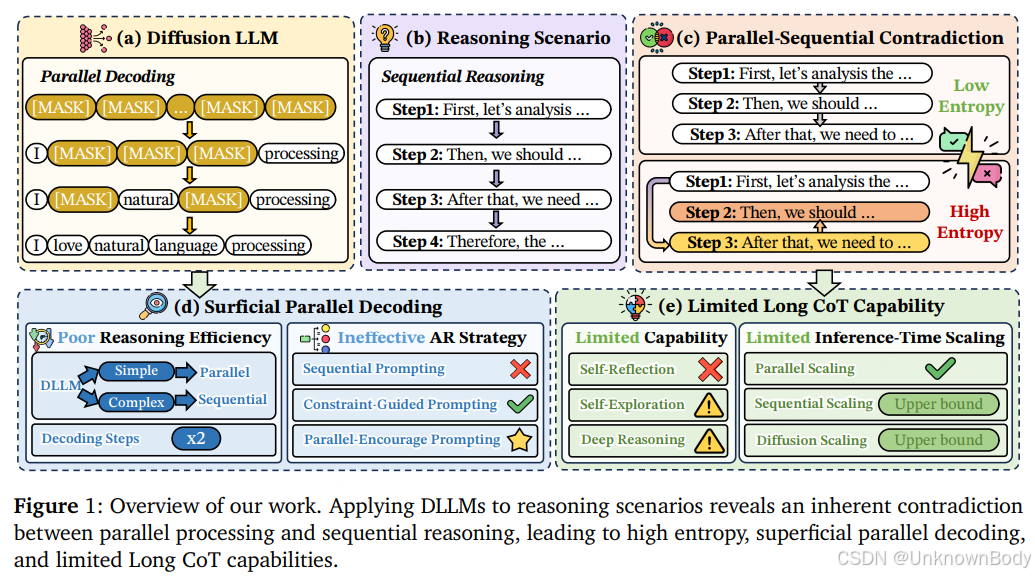

- DLLMs依赖并行解码实现高吞吐量,但长链推理需有序的因果步骤,二者存在本质冲突,即PSC。

- 简单任务中,DLLMs可直接生成结果,表现出表面并行性;复杂任务中,为规避PSC会回归类自回归行为,导致解码步骤翻倍、效率下降。

- DLLMs推理能力局限

- 长链推理三大核心能力不足:自反思效果有限(仅表面优化,重复率高)、推理深度浅(错误多发生在2步内,可行推理边界窄)、探索广度受限(新推理路径占比仅约5%)。

- 传统自回归提示(如Least-to-Most、Plan-and-Solve)会加剧PSC,降低推理性能;约束引导提示(如Complex-CoT)和并行鼓励提示(如Diff-MARP)更适配DLLMs。

- 三大缩放维度特性

- 并行缩放:不受PSC影响,随并行样本量增加,推理准确率呈对数线性提升,是最有效的缩放策略

订阅专栏 解锁全文

订阅专栏 解锁全文

1022

1022

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?