该文章提出了首个系统性的基于大语言模型(LLM)的CUDA内核代码进化框架EvoEngineer,解决了当前自动化CUDA内核优化领域生态碎片化、正确性与性能难以平衡的问题,通过在91个真实CUDA内核上的实验验证了其优越性。

一、文章主要内容

- 研究背景:CUDA内核优化是AI性能的关键瓶颈,手动优化需深厚专业知识,而现有LLM驱动的优化方法存在生态碎片化、问题定义模糊、难以满足正确性要求等缺陷。

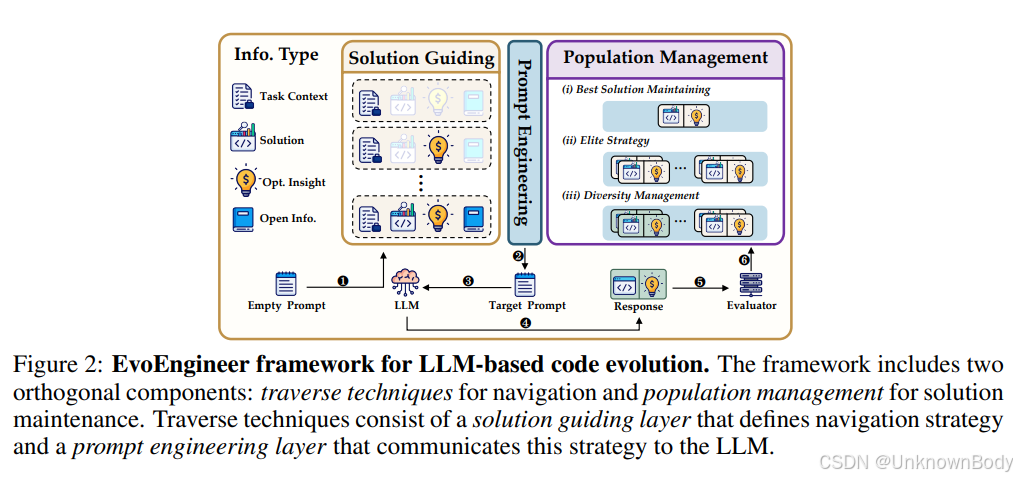

- 核心框架EvoEngineer:将LLM-based代码进化分解为两个正交组件——用于导航策略的两层遍历技术(解决方案引导层定义导航策略,提示工程层将策略传达给LLM)和用于解决方案维护的种群管理(单解决方案、精英保留、多样性维护三种策略)。

- 实验验证:在涵盖6类任务的91个真实CUDA内核上实验,对比AI CUDA Engineer、FunSearch等方法,EvoEngineer展现出性能与正确性的平衡——平均中值加速比达2.72倍,代码有效率69.8%;在超过2倍加速的50个操作中,28个(56.0%)由其实现最高加速比,最高单操作加速比达36.75倍。

- 辅助成果:实现模块化内核优化系统,支持不同优化策略的可复现研究与公平

基于大模型的CUDA内核优化框架

基于大模型的CUDA内核优化框架

订阅专栏 解锁全文

订阅专栏 解锁全文

2210

2210

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?