一、文章主要内容总结

本文针对大型语言模型(LLMs)知识静态化、更新成本高、易产生事实偏差等核心问题,提出了DySK-Attn(Dynamic Sparse Knowledge Attention)框架,旨在实现LLMs高效、实时的知识更新。

1. 研究背景与问题

- LLMs的固有缺陷:知识受“截止日期”限制,无法实时整合新信息,完全重训练计算成本极高;现有知识编辑技术(如ROME)更新慢且易引入副作用,检索增强生成(RAG)依赖非结构化文本,存在噪声大、结构化知识融合效率低等问题。

- 核心挑战:需同时解决“知识时效性”与“计算效率”两大难题,实现LLMs与动态知识源的高效融合。

2. 框架核心设计

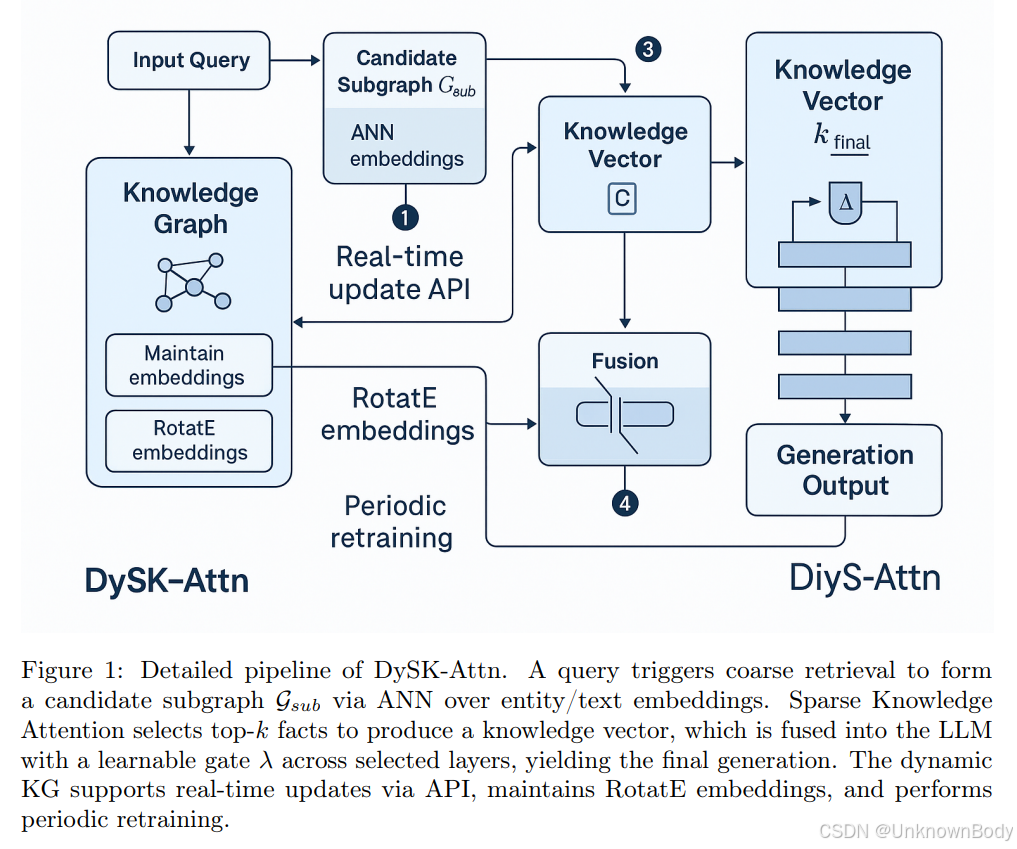

DySK-Attn由三大模块构成,形成“粗粒度检索-细粒度选择-知识融合”的完整流程:

- 骨干LLM:作为主要推理与生成引擎(实验中采用LLaMA-2-7B-Chat)。

- 动态知识图谱(KG)模块:以Wikidata-5M为基础KG,支持实时更新(通过高吞吐量API接入新事实三元组),采用RotatE模型将实体与关系映射为低维向量,定期微调嵌入以保证质量。

订阅专栏 解锁全文

订阅专栏 解锁全文

8007

8007

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?