文章总结与翻译

一、文章主要内容

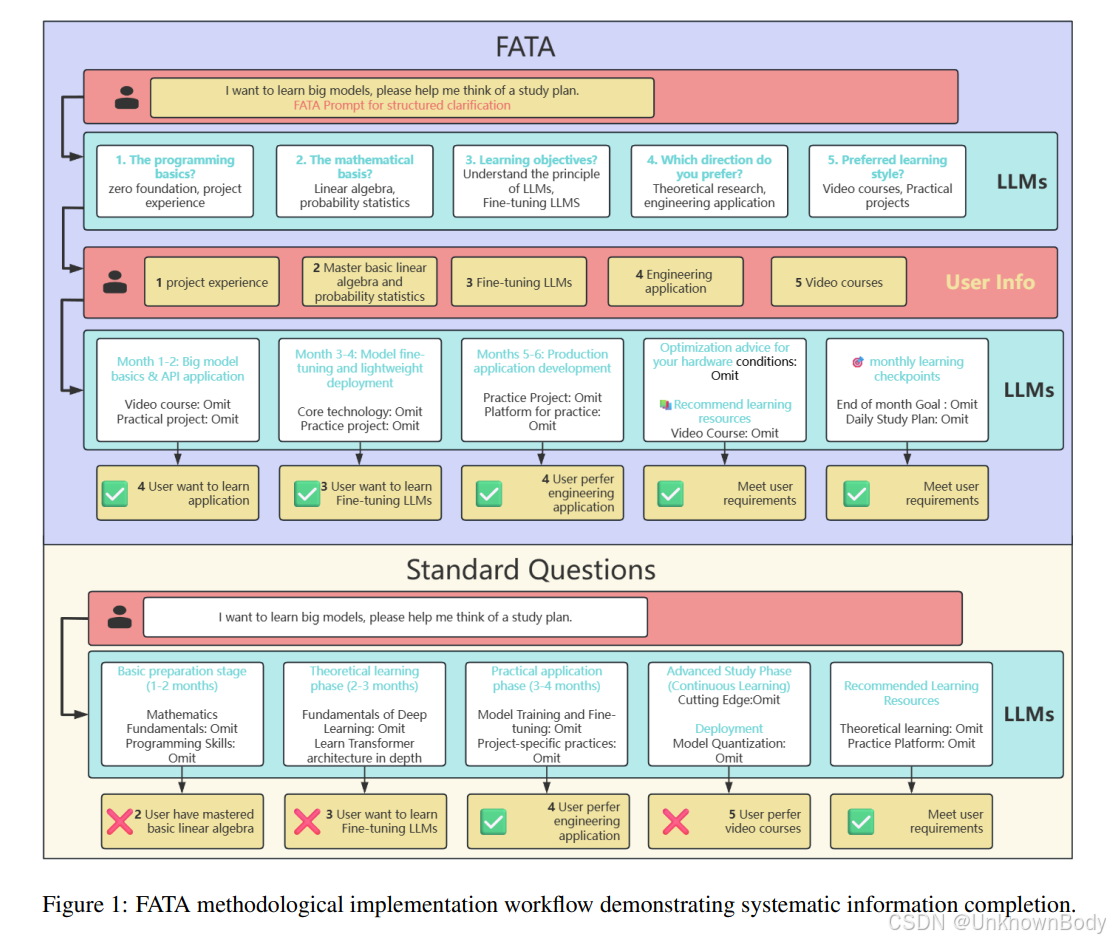

本文针对大型语言模型(LLMs)在用户提供信息不完整或表述不明确时,难以生成准确且可用的回答这一问题,提出了“先提问后回答”(First Ask Then Answer, FATA)的交互框架。

1. 核心背景

现实场景中,非专业用户在咨询时往往会遗漏关键信息(如医疗咨询中的用药细节、行政咨询中的预算限制等),导致LLMs生成不准确或不相关的回答,影响决策效率并降低用户信任。现有方法存在被动响应(仅在检测到歧义时澄清)、单维度聚焦(仅解决歧义或信息不完整中的一个问题)、交互成本高(多轮澄清增加认知负担和语境偏移)三大局限。

2. FATA框架设计

FATA采用两阶段流程,以“主动补充信息+单轮交互”为核心:

- 阶段1:系统性问题生成(F1):LLMs以领域专家视角,从上下文背景、约束条件、偏好、环境因素、历史背景五个关键维度,主动生成多维度补充问题,引导用户提供完整信息。

- 阶段2:语境增强回答生成(F2):整合用户原始查询与补充信息,生成个性化、专业的回答。同时,通过单轮一次性生成所有澄清问题,减少对话长度,提升效率。

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?