一、论文主要内容总结

InternVL3.5 是上海AI实验室 InternVL 团队推出的新一代开源多模态模型家族,聚焦提升模型的通用性、推理能力与推理效率,在多模态任务中表现突出,且大幅缩小了与商业模型(如GPT-5)的性能差距。

1. 模型核心架构与规模

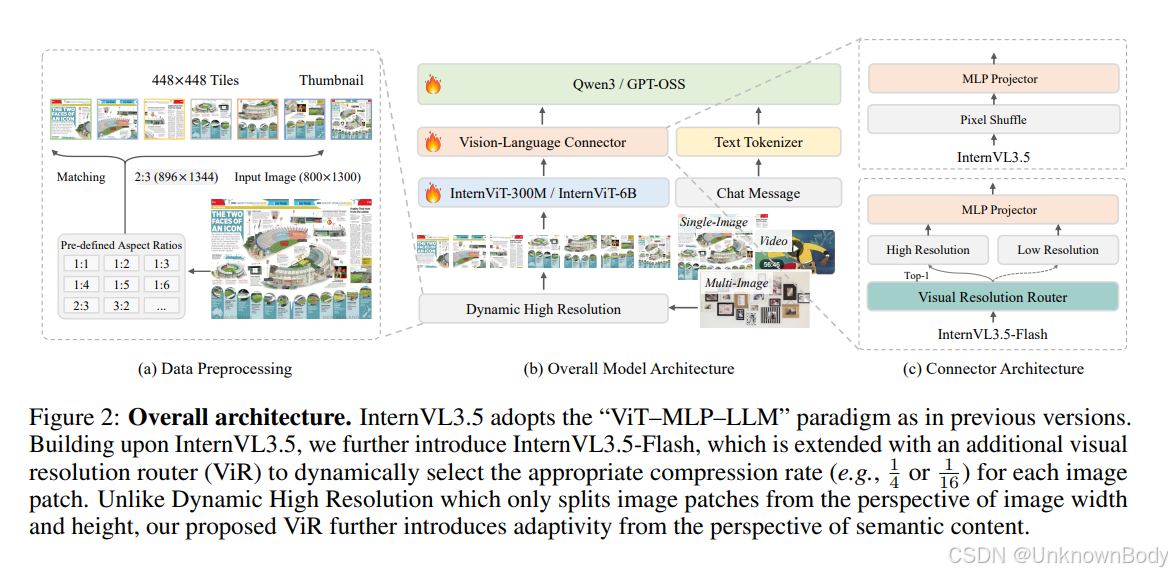

- 架构范式:延续“ViT(视觉编码器)-MLP(投影层)-LLM(语言模型)”架构,视觉编码器采用 InternViT-300M/6B,语言模型基于 Qwen3 系列与 GPT-OSS 初始化,保留动态高分辨率策略。

- 模型规模:涵盖从 1B 到 241B 参数的多种型号,包括稠密模型(如 InternVL3.5-1B/8B/38B)与混合专家模型(MoE,如 InternVL3.5-20B-A4B/241B-A28B),满足不同资源场景需求。

2. 训练流程

分为预训练、监督微调(SFT)、级联强化学习(Cascade RL)、视觉一致性学习(ViCO) 四阶段:

- 预训练:使用约 116M 样本(250B tokens),包含多模态数据(图像

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?