文章主要内容总结

- 研究背景与目的:现有LLM评估基准多聚焦于最终推理结果,忽视了模型在规划、修订及资源约束下的决策等内部推理过程。而理解这些过程对提升模型在真实场景中的可靠性至关重要。

- 方法与框架:

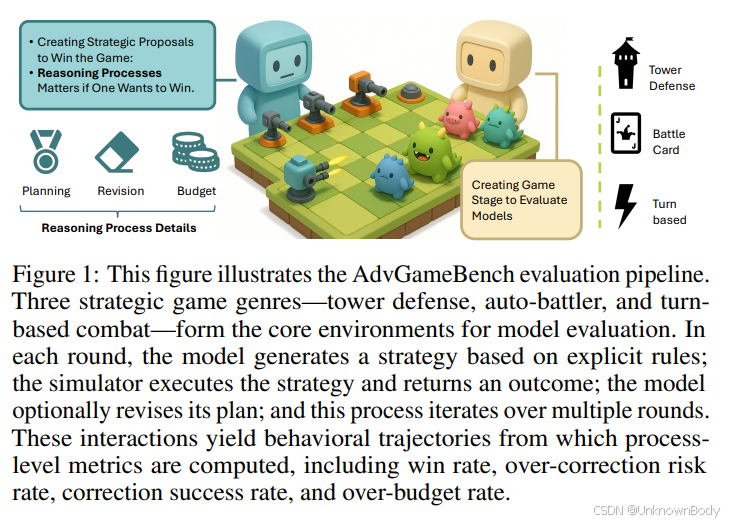

- 提出AdvGameBench框架,将LLM嵌入资源受限的战略游戏(塔防、自动战斗、回合制战斗)中,通过封闭、规则明确的环境观察模型的多步推理行为。

- 定义三大核心评估维度:规划能力、修订能力、资源约束决策能力,并引入一系列过程指标,如过度修正风险率(ORR)、修正成功率(CSR)、改进斜率(β)、超预算率(OBR)等。

- 实验结果:

- 对12个先进LLM进行4320轮对抗测试,ChatGPT-o3-mini表现最佳,综合得分最高(胜率74.7%,修正成功率78.6%,改进斜率+0.041)。

- 发现过度修正风险率与修正成功率呈负相关(Pearson r=-0.51),超预算率与胜率强负相关(r=-0.95),表明频繁修正和资源管理不善会降低模型性能。

- 结论:静态准确率基准不足以反映LLM的真实鲁棒性,AdvGameBench通过动态过程评估,为LLM评估提

AdvGameBench:LLM动态过程评估新方向

AdvGameBench:LLM动态过程评估新方向

订阅专栏 解锁全文

订阅专栏 解锁全文

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?