【图书推荐】《DeepSeek大模型高性能核心技术与多模态融合开发》-优快云博客

《DeepSeek大模型高性能核心技术与多模态融合开发(人工智能技术丛书)》(王晓华)【摘要 书评 试读】- 京东图书

DeepSeek作为开源大模型,为用户提供了广阔的自主性和灵活性。我们固然可以独立自主地部署不同版本的DeepSeek以满足个人使用需求。然而,对于初学者或资源有限的用户来说,直接部署可能存在一定的难度。幸运的是,现在有了更为便捷的选择——使用第三方已经部署好的DeepSeek服务。

这些第三方服务通常提供免费的API接口,使得用户能够一键部署并实现特定的功能,无需关心底层的复杂性和资源配置问题。其中,Modelscope便是一个值得推荐的选项。

在使用API接口之前,我们首先需要注册并登录Modelscope,登录页面如图2-21所示。

图2-21 Modelscope登录页面

在我们登录上Modelscope社区后,点击左侧的“访问令牌”,创建一个可供使用的、免费调用Modelscope的 API-Inference的令牌序列,如图2-22所示。

图2-22 访问令牌创建

图2-22 访问令牌创建

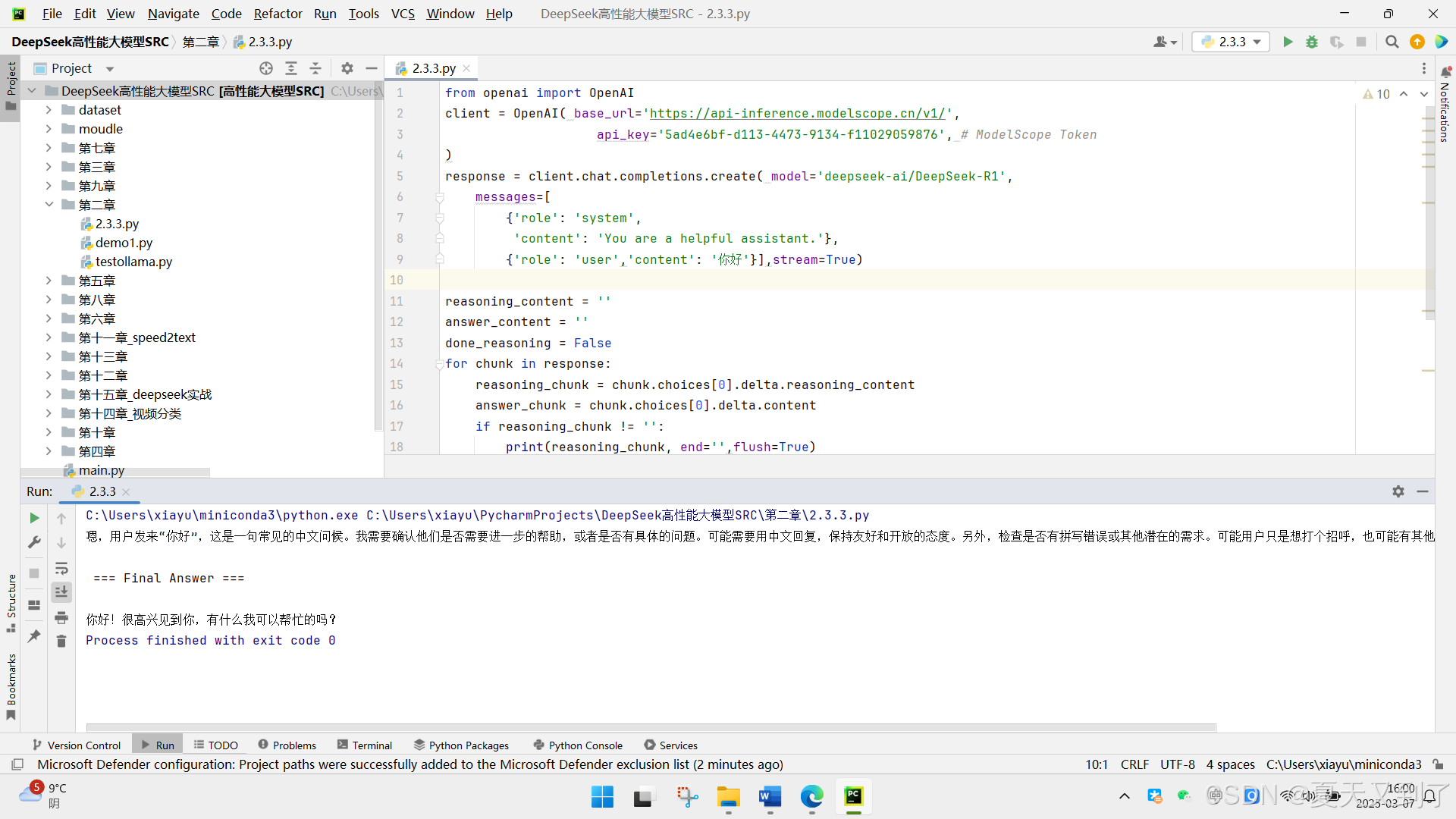

在创建访问令牌后,我们就可以通过代码部署并使用不同的DeepSeek 版本来完成我们的应用开发。下面给出一个示例,帮助读者熟悉DeepSeek 模型的调用。

打开前面安装的PyCharm IDE,先新建一个项目,再新建一个hello_deepseek.py文件,输入如下代码:

from openai import OpenAI

client = OpenAI( base_url='https://api-inference.modelscope.cn/v1/',

api_key='Your_SDK_Token', # ModelScope Token

)

response = client.chat.completions.create( model='deepseek-ai/DeepSeek-R1',

messages=[

{'role': 'system',

'content': 'You are a helpful assistant.'},

{'role': 'user','content': '你好'}],stream=True)

reasoning_content = ''

answer_content = ''

done_reasoning = False

for chunk in response:

reasoning_chunk = chunk.choices[0].delta.reasoning_content

answer_chunk = chunk.choices[0].delta.content

if reasoning_chunk != '':

print(reasoning_chunk, end='',flush=True)

elif answer_chunk != '':

if not done_reasoning:

print("\n\n === Final Answer ===\n")

done_reasoning = True

print(answer_chunk, end='',flush=True)

运行以上代码,结果如图2-19所示。

C:\Users\xiayu\miniconda3\python.exe C:\Users\xiayu\PycharmProjects\DeepSeek高性能大模型SRC\第二章\2.3.3.py

嗯,用户发来“你好”,这是一句常见的中文问候。我需要确认他们是否需要进一步的帮助,或者是否有具体的问题。可能需要用中文回复,保持友好和开放的态度。另外,检查是否有拼写错误或其他潜在的需求。可能用户只是想打个招呼,也可能有其他问题。保持简洁,同时提供帮助的可能性。

=== Final Answer ===

你好!很高兴见到你,有什么我可以帮忙的吗?

Process finished with exit code 0

这里需要说明一下,Modelscope是一个专业提供大模型部署和整合的平台。它汇聚了众多先进的大模型,并通过优化和封装,为用户提供了简洁易用的接口。通过Modelscope提供的已部署好的模型代码,我们可以轻松地调用和使用DeepSeek的多个版本。这不仅降低了技术使用的门槛,还大大提升了使用效率。

872

872

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?