好的文章推荐:https://blog.youkuaiyun.com/qq_45228845/article/details/126339793?spm=1001.2014.3001.5506

好的文章推荐:https://blog.youkuaiyun.com/hanseywho/article/details/125641137?spm=1001.2014.3001.5506

好的文章推荐:https://blog.youkuaiyun.com/controlourself/article/details/126315788?spm=1001.2014.3001.5506

论文地址:https://arxiv.org/abs/2206.04670

代码地址:https://github.com/guochengqian/pointnext

本人是个刚入门的菜鸡,自己写一下总结供自己以后复习。

这篇文章是2022年发布在NeurIPS上的

创作目的

作者发现,最新的一些SOTA方法性能提高的很大一部分是由于改进了培训策略,即数据扩充和优化技术,以及增加了模型大小,而非架构创新。在这项工作中,我们重新审视了经典且广泛使用的网络PointNet++,并发现其全部潜力尚待挖掘。

创新点

本文的创新点提出了以下几点:

- 提出了一套更有效的训练策略。

- 我们发现无论是使用更多的SA模块还是使用更大的channel size都不会显着提高准确性,却反而导致thoughput显著下降。这主要是梯度消失和过度拟合导致的。 为此本文提出了Inverted Residual MLP (InvResMLP,反向残差MLP)模块以实现高效实用的模型缩放。附加InvResMLP块可显著提高性能。

网络框架

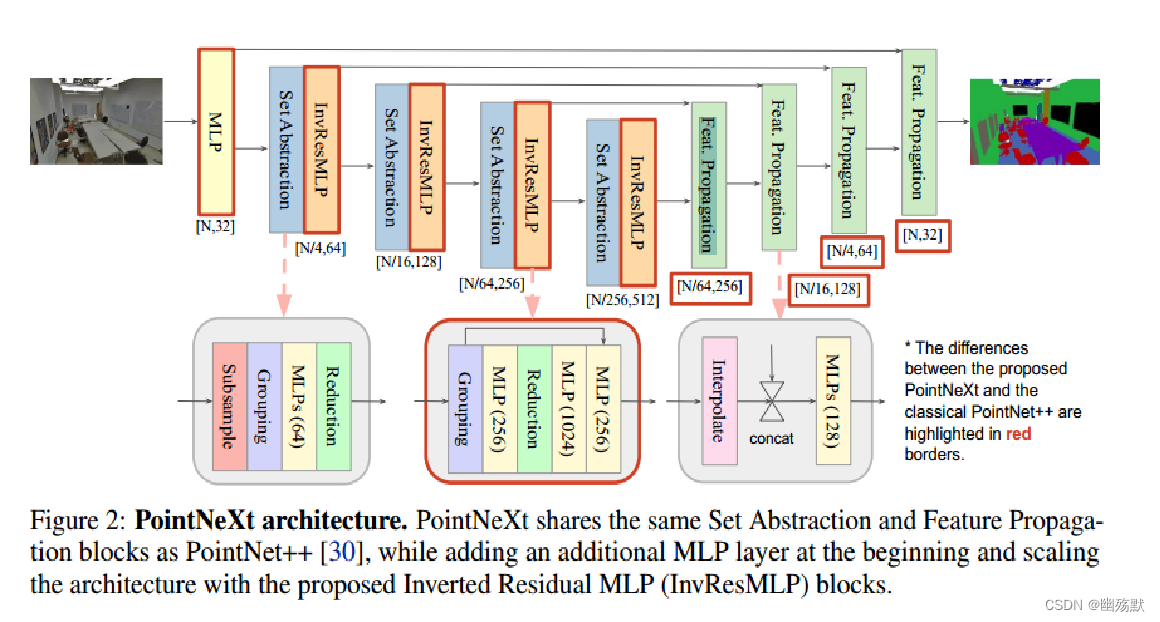

红色框框是和PointNet++不同的地方。

PointNext和PointNet++的不同之处有以下几点:

- 首先在开头引入了一个MLP,以将输入点云映射到更高的维度。

- Set Abstraction(SA)模块由2块变成了4块,与此同时后面的Feat. Propagation(上采样)也对应的变成了4块。

- 反向残差MLP:

- 为了缓解梯度消失问题 (尤其是当网络更深时),我们在模块的输入和输出之间添加了残差连接(就是反向残差MLP模块里的箭头)。

- 为了减少计算量,我们引入了可分离的MLP并加强逐点特征提取。SA中的3层MLPs都是基于邻域特征计算的。 InvResMLP将MLPs分为1层作用于邻域特征(在Grouping层和Reduction层之间

PointNext:深入挖掘PointNet++潜力的创新网络

PointNext:深入挖掘PointNet++潜力的创新网络

PointNext是针对PointNet++的改进工作,通过Inverted Residual MLP模块解决梯度消失问题,提高了3D点云处理的性能。文章探讨了训练策略的改进,包括数据增强、优化策略和感受野缩放,如添加单独MLP、使用InvResMLP和调整PointNet++的多尺度消息传递。此外,还应用了标签平滑和模块缩放策略来提高模型泛化能力和效率。

PointNext是针对PointNet++的改进工作,通过Inverted Residual MLP模块解决梯度消失问题,提高了3D点云处理的性能。文章探讨了训练策略的改进,包括数据增强、优化策略和感受野缩放,如添加单独MLP、使用InvResMLP和调整PointNet++的多尺度消息传递。此外,还应用了标签平滑和模块缩放策略来提高模型泛化能力和效率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6681

6681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?