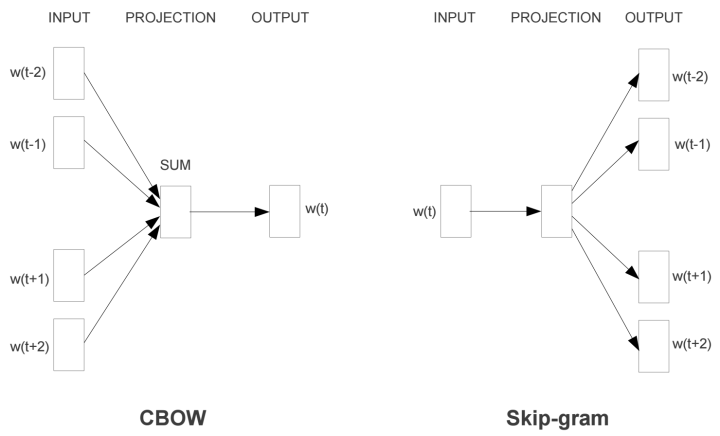

wrod2vec是对NNLM的一种改进,他去掉了激活层,减少了要训练的参数,效率肯定是提高了很多~一共有两个模型,Skip-gram和CBOW。

CBOW是输入附近的词求中间词,Skip-gram是给中间的词求附近的词。

Skip-gram

这个模型其实与NNLM差不多,只是一个简化而已。不过训练目标改变了。Skip-gram的终极目标不是训练一个准确的输出,而是为了获得隐层的权重矩阵,或者说词向量。这种模型一些人取名为“Fake Task”。就是让输出层只是一个调参的工具人而已。

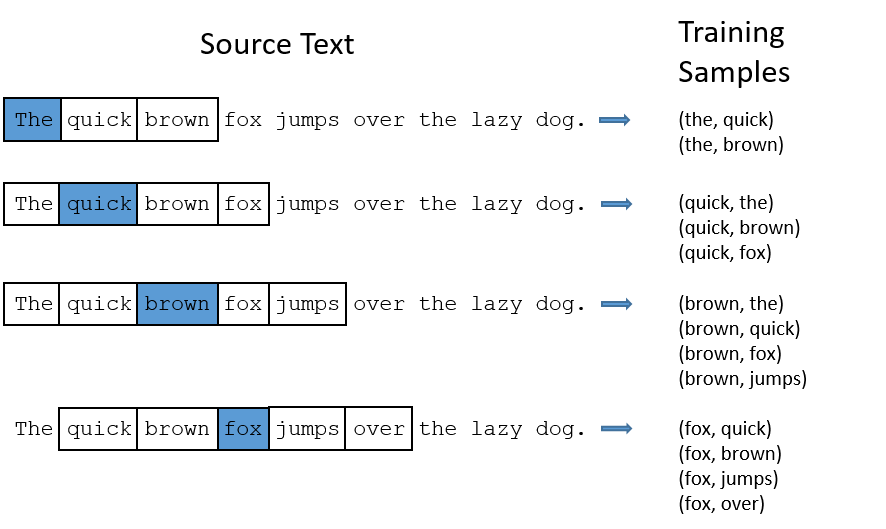

在了解具体模型之前必须要了解这里提出的一个新概念(其实也不新):滑动窗口。这个滑动窗口提供了词与词之间的关系和语义,我认为是这个模型的精髓。其具体表示就是选择一个合适的框框大小window_size,选择输入词前后window_size大小的词进行组合。具体如图:

这样我们每次不是对一个单词进行训练,而是对单词组合进行训练。那神经网络就知道lazy dog和dog lazy的区别了!

模型

输入层 依旧是对单词采用One-hot编码,维度是词典的长度。到哪个词了就哪个词为1进行表示。如果我们的单词表长度为doc_len,那输入层的维度就是doc_len*1。到这里一切还是那么美好

隐层 这里我纠结了很久,最终才搞明白这里有一个超参数词向量的特征数。这个层的目的是用一个人为设定的特征量来表示一个值!!!现在一般都采用谷歌

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1208

1208

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?