StereoCrafter(Tencent AI Lab ARC Lab, Tencent PCG)

论文:https://arxiv.org/abs/2409.07447

代码:https://github.com/TencentARC/StereoCrafter

SVG(Google, The University of Hong Kong)

论文:https://arxiv.org/pdf/2407.00367

代码:https://daipengwa.github.io/SVG_ProjectPage/

StereoDiffusion

论文:https://arxiv.org/abs/2403.04965

代码:https://github.com/lez-s/StereoDiffusion

概要

随着AR、VR设备的兴起,双目立体视频在虚拟现实(VR)、增强现实(AR)和娱乐领域具有广泛的应用前景。然而,生成立体视频面临技术挑战,尤其是如何生成自然的立体视差(stereo parallax),即从两个视角观察时物体位置的差异。传统方法通常需要复杂的3D建模或专用的立体录制设备,这限制了其广泛应用。本文主要介绍最新的基于Diffusion的双目视频生成技术。

技术方案

StereoDiffusion

StereoDiffusion主要用于单图的左右视图合成,利用原始输入生成左侧图像并为其估算时差图(DPT或MiDas模型预测),然后通过立体像素移动操作生成右侧图像的潜在向量,通过Self-Attn对齐左右视图,每隔固定时间步,通过Symmetric Pixel Shift Masking Denoise将左视图特征拷贝到右视进行融合,以保证前景不被扩散过程模糊掉(猜测)。

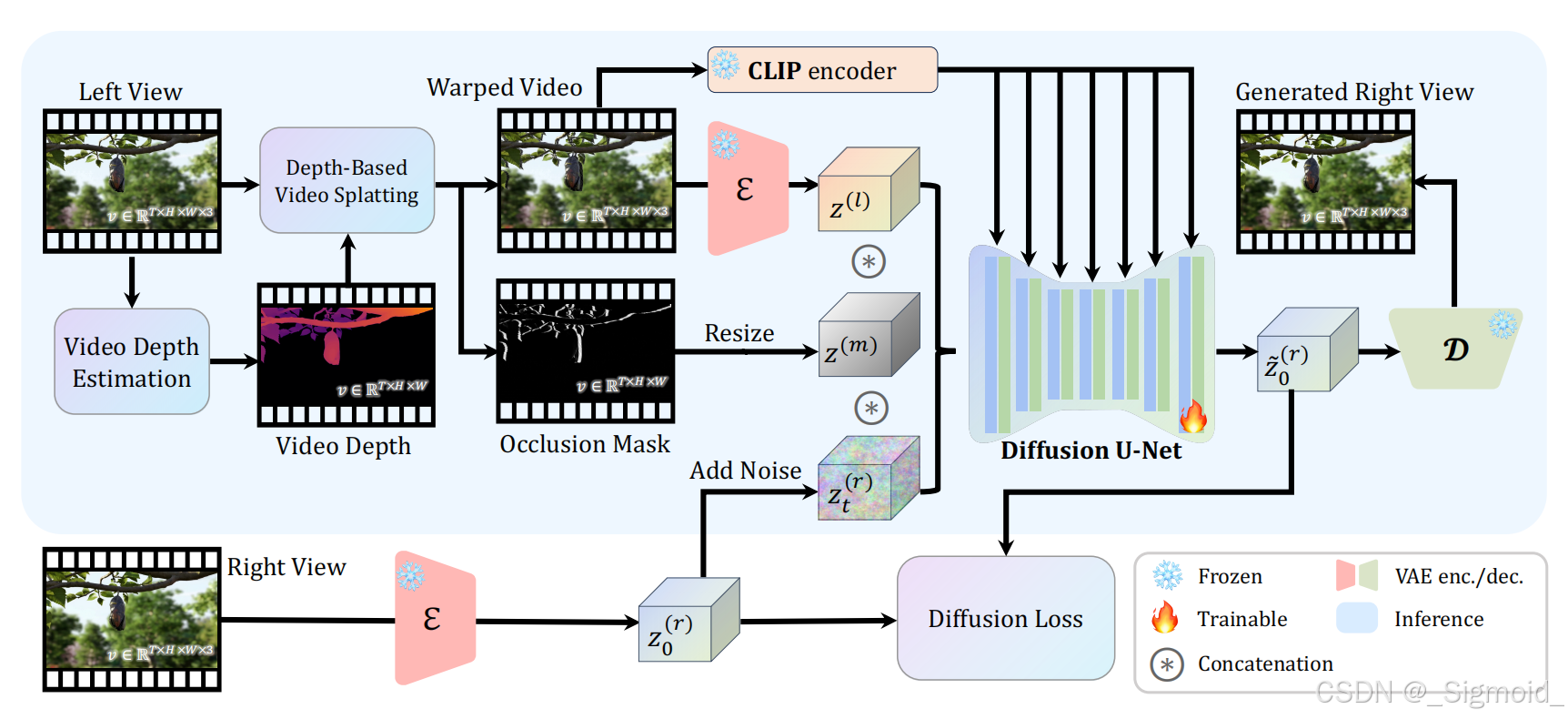

StereoCrafter

StereoCrafter 利用Diffusion模型能力和构建新数据集实现2D视频转换为具有沉浸式体验的立体3D视频。具体步骤如下:

-

首先,使用视频深度估计模型DepthCrafter或Depth Anything V2获取到精细的视频深度;

-

然后将左视图根据视差warp到右视角,具体采用Splatting机制将左视图像素投射到右视图,并采用深度感知方法解决多个像素投影到一个像素的模糊性(类似于OpenGL的深度TEST),同时提取没有像素的mask作为遮挡区域;

-

给定warp后的右视图视频,修改了Stable Video Diffusion(SVD)模型用于立体视

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

707

707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?