我们在很多地方都会看到各种显卡的参数比较,性能天梯图等,但很多都是基于显卡产品规格的纸面数据,在实际应用中,特别是AI方面的应用,各种显卡的实际性能到底如何,或者如何更有效地从应用的角度测试显卡的性能?

这里我们选择了英伟达的RTX 3090和RTX 4090两张显卡,基于实际模型训练的场景下实测性能来比较下被称为「上一代卡皇」的 3090 和「当前消费级主力」的 4090 的实际性能到底差多少。

3090和4090参数对比

先对比先3090和4090两张显卡的参数规格:

| RTX 3090 | RTX 4090 | |

|---|---|---|

| 架构 | Ampere | Ada Lovelace |

| CUDA核心数 | 10,496 | 16,384 |

| 显存容量 | 24 GB GDDR6X | 24 GB GDDR6X |

| 显存带宽 | 936 GB/s | 1,008 GB/s |

| TDP功耗 | 350W | 450W |

| FP32 算力 | 35.6 TFLOPS | 82.6 TFLOPS |

| Tensor FP16 算力 | 142 TFLOPS | 330 TFLOPS |

-

3090和4090在显存层面比较接近,显存容量都是24GB,显存带宽差异也不大

-

算力方面,4090无论是单精度还是Tensor FP16都是3090的2.3倍左右

-

其他方面,4090基于新的Ada Lovelace架构,并且功耗也远高于3090

基于ResNet-50的模型训练测试

ResNet-50是经典的计算机视觉模型,一种深度为50 层的卷积神经网络(CNN)。

我们基于Pytorch框架来训练ResNet-50模型,基于CIFAR-10数据集进行测试,来比较样本吞吐速度、显卡使用、GPU使用率等。

直接从GPU算力平台 晨涧云 分别租3090和4090两种机器进行模型训练的对比测试:

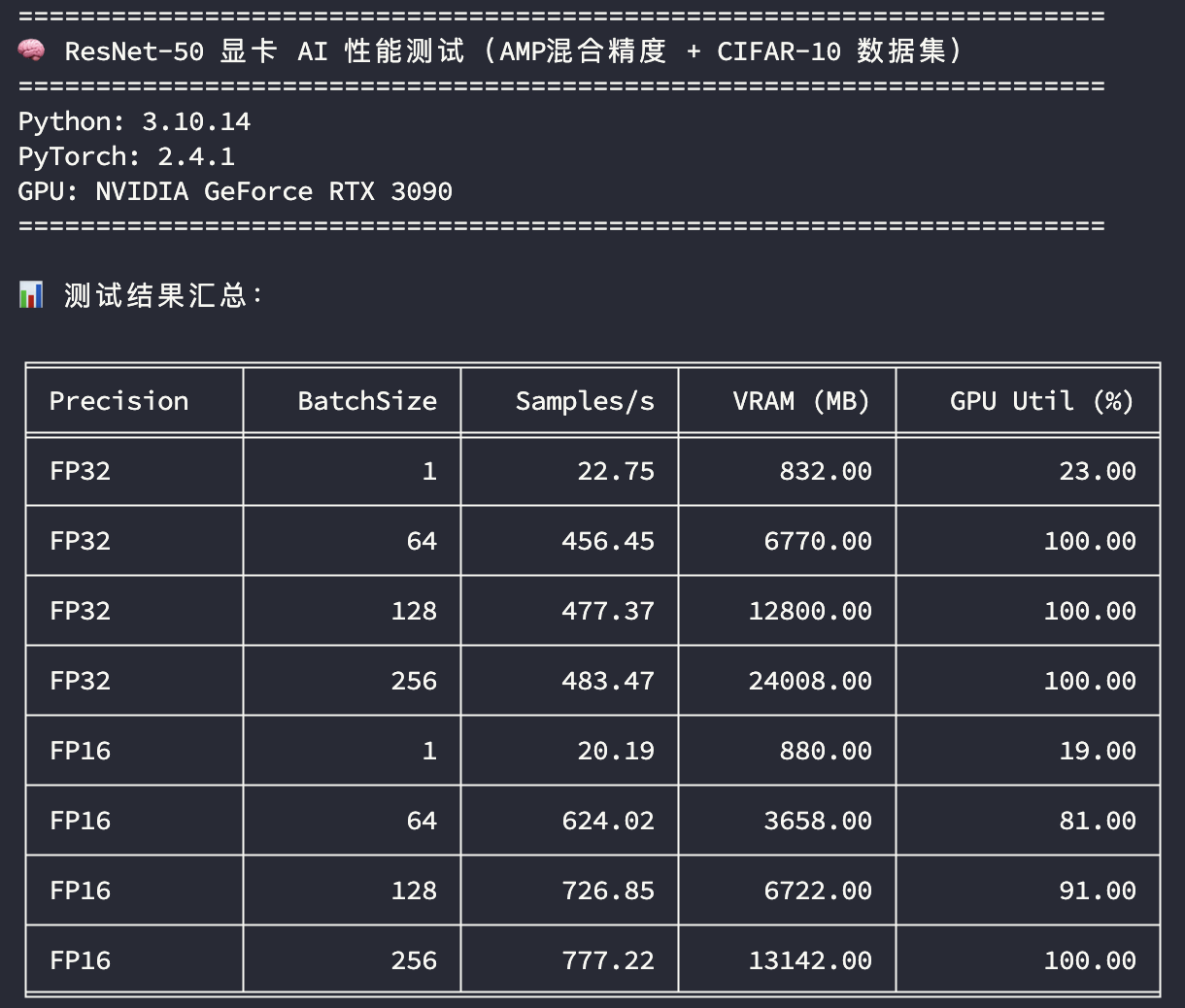

RTX 3090

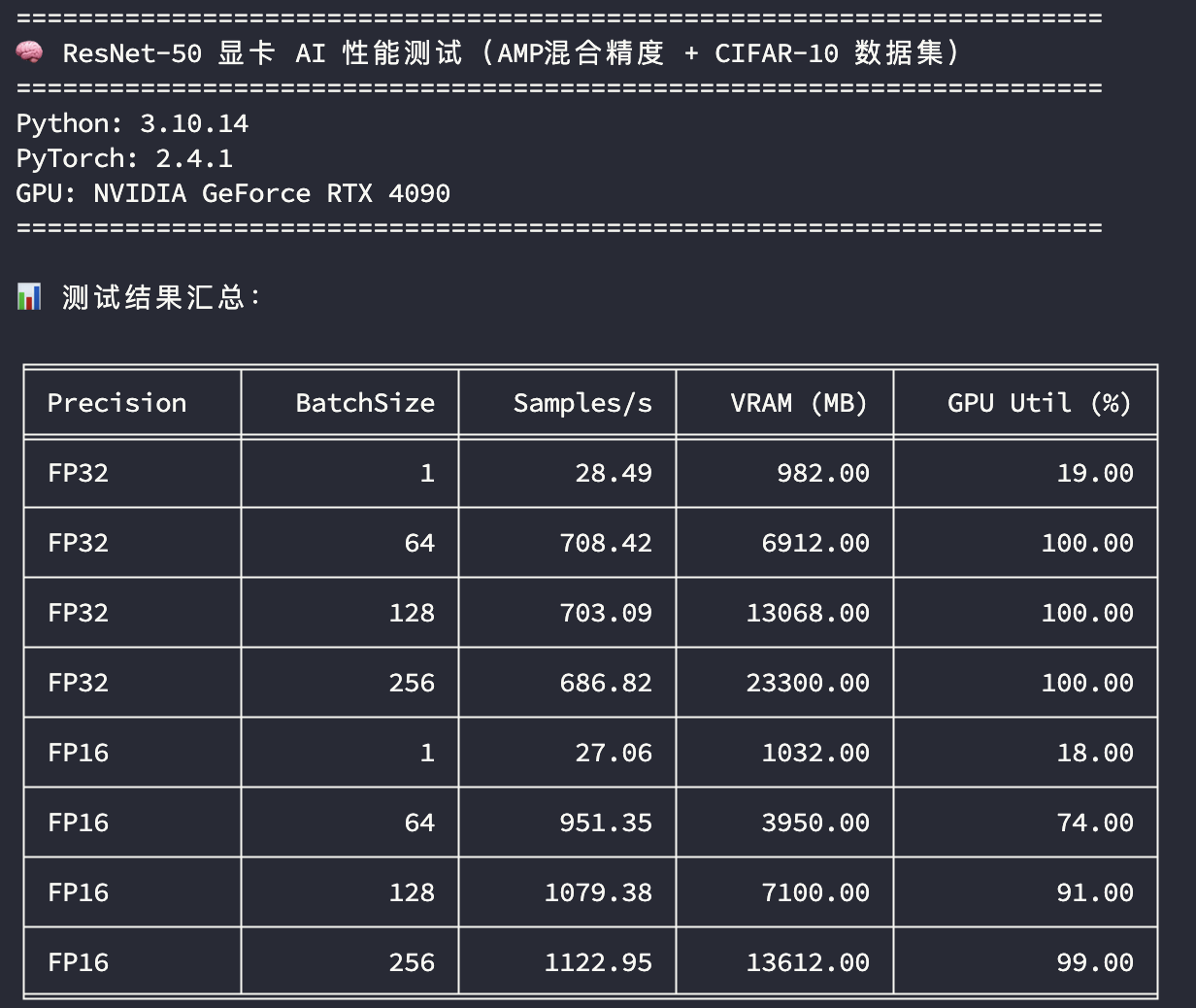

RTX 4090

测试结果解释

-

精度:FP32 表示使用单精度训练,FP16 表示使用混合精度训练

-

BatchSize:训练批次大小

-

Samples/s:每秒样本吞吐量

-

VRAM (MB):峰值显存使用量

-

GPU Util (%):峰值GPU利用率

这里主要看在GPU使用率比较高的场景下(BatchSize=256),模型训练样本的吞吐速度比较;无论是单精度还是混合精度,RTX 4090的样本吞吐速度差不多是RTX 3090的1.45倍左右。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?