<think>我们面对的问题是:DataFrame中每列都是数组(应该是说每列的元素都是数组),需要保存为CSV文件。

但是,CSV文件是纯文本格式,它存储的是表格数据,每列通常是单个值(如整数、字符串等)。如果每列是数组,那么我们需要考虑如何将这些数组转换为CSV能够表示的格式。

通常有两种做法:

1. 将数组展开为多列:例如,如果一列是长度为3的数组,那么我们可以将其拆分成3列。

2. 将数组转换为字符串:例如,将数组[1,2,3]转换为字符串"1,2,3"(或者用其他分隔符)。

根据用户提供的引用,并没有直接给出处理数组列的方法。但我们可以根据一般经验来处理。

步骤:

1. 首先,我们需要确认DataFrame中每列数组的长度是否一致。如果不一致,展开可能会出现问题。

2. 如果选择展开,我们可以使用`apply(pd.Series)`将每一列数组拆分成多列,然后合并成一个新的DataFrame,再保存为CSV。

3. 如果选择转换为字符串,则可以对每列应用一个转换函数,将数组转换为字符串。

但是,注意用户的要求是“保存为CSV”,而CSV文件要求每行每列都是单个值。所以,如果每列是数组,那么实际上我们有两种理解:

- 情况1:每一列是一个数组,每个数组有多个元素,我们希望将每个数组元素拆分成多列(这样列数会增加)

- 情况2:我们不需要拆分,而是将整个数组作为一个字符串存储在一列中(这样列数不变,但数组变成字符串)

下面分别给出两种方法的示例。

方法一:展开数组为多列

假设我们有一个DataFrame,其中两列A和B,每列都是长度为2的数组。

示例数据:

import pandas as pd

import numpy as np

df = pd.DataFrame({

'A': [np.array([1,2]), np.array([3,4])],

'B': [np.array([5,6]), np.array([7,8])]

})

我们希望将A列展开为A0, A1,B列展开为B0, B1。

步骤:

new_df = pd.DataFrame()

for column in df.columns:

# 将每一列(数组)拆分成多列并重命名

expanded = df[column].apply(pd.Series)

expanded.columns = [f'{column}_{i}' for i in range(expanded.shape[1])]

new_df = pd.concat([new_df, expanded], axis=1)

然后保存:new_df.to_csv('output.csv', index=False)

方法二:将数组转换为字符串

df_str = df.applymap(lambda arr: ','.join(map(str, arr)))

df_str.to_csv('output.csv', index=False)

注意:方法二保存后,CSV文件中每列是一个字符串,如A列的值是"1,2",B列的值是"5,6"。

根据后续使用需求选择方法。如果后续需要重新读入并恢复数组,方法二可以通过读取字符串再分割来恢复,但要注意数据类型转换。

另外,如果数组长度不一致,方法一会导致出现NaN(因为展开后的列数不一致),方法二则没有这个问题。

因此,我们根据实际情况选择。

下面给出完整示例代码:

方法一(展开):

```python

import pandas as pd

import numpy as np

# 创建示例DataFrame,每列是数组

df = pd.DataFrame({

'A': [np.array([1,2]), np.array([3,4])],

'B': [np.array([5,6]), np.array([7,8])]

})

# 展开每一列

new_df = pd.DataFrame()

for col in df.columns:

# 将当前列的每个数组拆分成多列

expanded = df[col].apply(pd.Series)

# 重命名这些列,以避免重复列名

expanded.columns = [f'{col}_{i}' for i in expanded.columns]

new_df = pd.concat([new_df, expanded], axis=1)

# 保存为CSV

new_df.to_csv('expanded_output.csv', index=False)

```

方法二(转换为字符串):

```python

# 使用同样的df

# 将每个数组转换为逗号分隔的字符串

df_str = df.applymap(lambda x: ','.join(map(str, x)))

df_str.to_csv('string_output.csv', index=False)

```

如果数组长度不一致,比如:

df = pd.DataFrame({

'A': [np.array([1,2]), np.array([3,4,5])],

'B': [np.array([6]), np.array([7,8,9])]

})

对于方法一,展开后会出现NaN。例如,第一行A展开三列:A0=1, A1=2, A2=NaN;B展开三列:B0=6, B1=NaN, B2=NaN。

而方法二则得到:第一行A列是"1,2",B列是"6";第二行A列是"3,4,5",B列是"7,8,9"。

因此,用户需要根据数组是否等长以及后续使用需求来选择方法。

另外,如果数组很长,展开后列数会非常多,可能不利于后续处理,这时候方法二更合适。

总结:

- 等长数组且需要单独处理每个元素:方法一

- 不等长数组或希望保持原列数:方法二

相关问题:

1. 如何在保存CSV后重新读取并恢复数组格式?

2. 对于不等长的数组,如何避免展开时出现NaN?

3. 如何将每个数组元素展开成多行(而不是多列)?

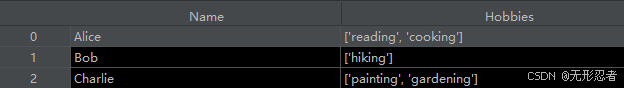

</think>### 如何将每列为数组的DataFrame保存为CSV

当DataFrame的每列都是数组时,需要先将数组转换为CSV可识别的格式。核心解决方案是**将数组序列化为字符串**或**展开为多列**。以下是两种方法的详细实现:

---

#### 方法1:数组序列化为字符串(保留列结构)

将每列的数组转换为字符串格式(如JSON),保持原始列数:

```python

import pandas as pd

import numpy as np

import json

# 创建示例数据(每列为数组)

data = {

'坐标': [np.array([1.2, 3.4]), np.array([5.6, 7.8])],

'特征向量': [np.array([0.1, 0.2, 0.3]), np.array([0.4, 0.5, 0.6])]

}

df = pd.DataFrame(data)

# 将数组列转换为JSON字符串

df['坐标'] = df['坐标'].apply(lambda x: json.dumps(x.tolist()))

df['特征向量'] = df['特征向量'].apply(lambda x: json.dumps(x.tolist()))

# 保存CSV(解决中文乱码)

df.to_csv('array_data.csv', index=False, encoding='utf-8-sig')

```

**输出文件内容**:

```

坐标,特征向量

"[1.2, 3.4]","[0.1, 0.2, 0.3]"

"[5.6, 7.8]","[0.4, 0.5, 0.6]"

```

---

#### 方法2:数组展开为多列(增加列维度)

将每列的数组拆分为多个单值列:

```python

# 展开'坐标'列为两列

coord_df = pd.DataFrame(df['坐标'].tolist(), columns=['x', 'y'])

# 展开'特征向量'列为三列

feature_df = pd.DataFrame(df['特征向量'].tolist(), columns=[f'feat_{i}' for i in range(3)])

# 合并新列

new_df = pd.concat([coord_df, feature_df], axis=1)

# 保存CSV

new_df.to_csv('expanded_data.csv', index=False)

```

**输出文件内容**:

```

x,y,feat_0,feat_1,feat_2

1.2,3.4,0.1,0.2,0.3

5.6,7.8,0.4,0.5,0.6

```

---

### 关键注意事项

1. **数组长度一致性**

- 方法2要求每列内数组长度相同,否则会引发`ValueError`

- 使用`.apply(pd.Series)`前需验证长度:

```python

assert df['特征向量'].apply(len).nunique() == 1 # 确保所有数组等长

```

2. **数据还原策略**

- 方法1保存的CSV读取后需反向解析:

```python

df = pd.read_csv('array_data.csv')

df['坐标'] = df['坐标'].apply(lambda s: np.array(json.loads(s)))

```

3. **大数组优化**

- 超长数组建议使用方法1,避免列数爆炸

- 启用压缩减少存储:

```python

df.to_csv('data.csv.gz', index=False, compression='gzip')

```

---

### 性能对比

| 方法 | 适用场景 | 列数变化 | 数据还原难度 |

|------|-----------|----------|--------------|

| 序列化为字符串 | 数组长度差异大/需保留结构 | 不变 | ★★☆(需JSON解析) |

| 展开为多列 | 数组长度固定/需直接分析 | 增加 | ★☆☆(直接可用) |

---

### 相关问题

1. 如何将CSV中的JSON字符串还原为NumPy数组?

2. 当数组长度不一致时,有哪些替代保存方案?

3. Pandas如何高效处理包含大型数组的DataFrame?

4. 除了CSV,哪些格式更适合存储数组数据(如HDF5/Parquet)?

5. 如何分块处理超大数组的CSV导出?[^1][^4]

> 引用提示:数组操作可结合NumPy实现高效计算[^2],分块处理策略参考大文件处理方案[^1][^4]

535

535

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?