原文首发于微信公众号「3D视觉工坊」——基于自动驾驶车辆的激光雷达与摄像头之间的在线标定算法

本文英文名为《Automatic Online Calibration of Cameras and Lasers》

文献作者:Jesse Levinson, Sebastian Thrun,Stanford Artificial Intelligence Laboratory {jessel,thrun}@stanford.edu

本论文翻译和复现作者来自Kevin Liu

论文主要内容

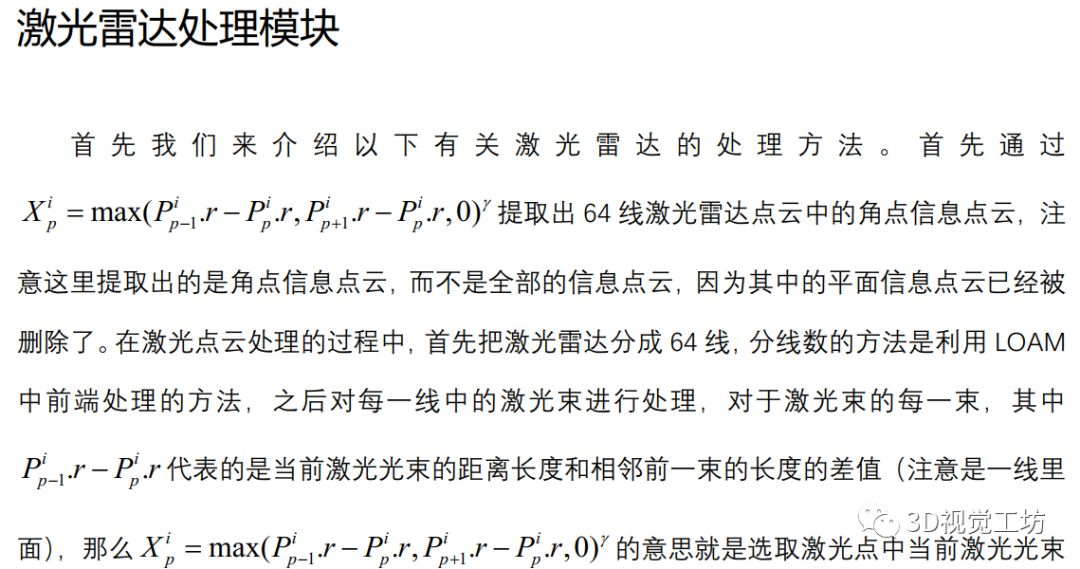

该文章主要针对的是自动驾驶领域中,64线激光雷达和摄像头之间的在线标定修正(注意:是修正,不是在线标定)。该论文的主要思想是通过一个概率检车函数判定,激光雷达和摄像头之间的离线标定在车辆运行的过程中是否偏离,如果发生偏移,就通过一个在线跟踪修正的算法将其拉回到正确的标定矩阵范围内。(注意:该论文需要一个相对比较准的离线标定的转换矩阵建立摄像头和激光雷达之间的一致性联系,因为论文中默认该离线标定的转换矩阵有70%-80%的准度)。

本文探讨了64线激光雷达与摄像头在线标定修正的方法,通过概率检查函数检测离线标定的偏差,并使用在线跟踪算法进行实时校正。论文假定有一个约70%-80%准确的初始离线标定转换矩阵。

本文探讨了64线激光雷达与摄像头在线标定修正的方法,通过概率检查函数检测离线标定的偏差,并使用在线跟踪算法进行实时校正。论文假定有一个约70%-80%准确的初始离线标定转换矩阵。

订阅专栏 解锁全文

订阅专栏 解锁全文

3359

3359

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?