前言:

a. 在ubuntu系统下安装nvidia-driver若不成功,在bios下找到secure boot选项并设为disable关闭;所有操作均在root下进行。

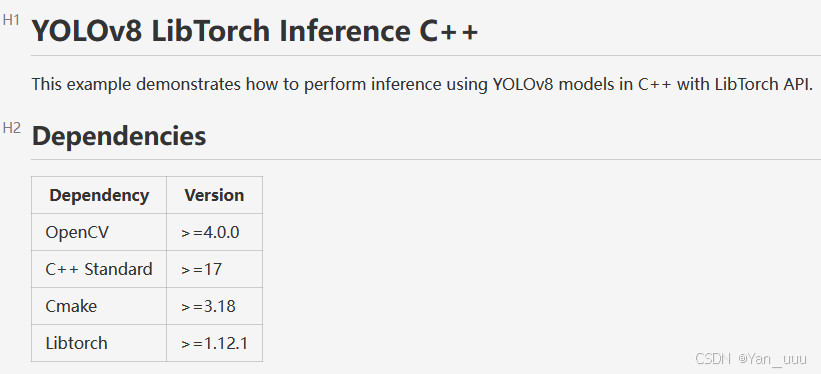

b. LibTorch是PyTorch C++ API,来加载和推理 YOLO模型,ultralytics源码链接:ultralytics/ultralytics: Ultralytics YOLO11 🚀;YOLOv8源码中ultralytics-main\examples\YOLOv8-LibTorch-CPP-Inference中对环境要求如下所示:

c. LibTorch 的版本和 PyTorch 是对应的,CUDA、Python、PyTorch、torchvision版本对应关系

| CUDA | Python | PyTorch | torchvision |

|---|---|---|---|

| cu117,cu118 | cp38,cp39,cp310,cp311 | 2.0.1 | 0.15.1 |

| cu117,cu118 | cp38,cp39,cp310,cp311 | 2.0.0 | 0.15.0 |

| cu116,cu117 | cp37,cp38,cp39,cp310 | 1.13.1 | 0.14.1 |

| cu116,cu117 | cp37,cp38,cp39,cp310 | 1.13.0 | 0.14.0 |

| cu113,cu116 | cp37,cp38,cp39,cp310 | 1.12.1 | 0.14.0 |

| cu113,cu116 | cp37,cp38,cp39,cp310 | 1.12.0 | 0.13.0 |

| cu113,cu115 | cp37,cp38,cp39,cp310 | 1.11.0 | 0.12.0 |

| cu102,cu111 | cu113 cp36,cp37,cp38,cp39 | 1.10.2 | 0.11.2 |

| cu102,cu111 | cu113 cp36,cp37,cp38,cp39 | 1.10.1 | 0.11.1 |

| cu102,cu111 | cu113 cp36,cp37,cp38,cp39 | 1.10.0 | 0.11.0 |

| cu102,cu111 | cp36,cp37,cp38,cp39 | 1.9.1 | 0.10.1 |

| cu102,cu111 | cp36,cp37,cp38,cp39 | 1.9.0 | 0.10.0 |

| cu101,cu102 | cu111 cp36,cp37,cp38,cp39 | 1.8.1 | 0.9.1 |

| cu101,cu111 | cp36,cp37,cp38,cp39 | 1.8.0 | 0.9.0 |

本次配置采用:gcc/g++ 9.4、Cmake-3.31.0、LibTorch-1.13.1、Python-3.8、CUDA-11.7.1、cuDNN-8.8.1.3、Opencv-4.5.5

1. ubuntu18.04 换源

sudo su

vim /etc/apt/sources.list

apt-get update

##清华源

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic main restricted universe multiverse

deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-updates main restricted universe multiverse

deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-updates main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-backports main restricted universe multiverse

deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-backports main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-security main restricted universe multiverse

deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-security main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-proposed main restricted universe multiverse

deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-proposed main restricted universe multiverse

2. ubuntu18.04 升级 gcc、g++

add-apt-repository ppa:ubuntu-toolchain-r/test ## 添加ppa源

apt-get update

apt-get install gcc-9 g++-9

cd /usr/bin/

rm -rf gcc g++

ln -s gcc-9 gcc ## 重新建立链接

ln -s g++-9 g++

gcc --version ## 查看版本

g++ --version

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

934

934

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?