`CountVectorizer` 是 Scikit-learn 库中用于文本特征提取的一个重要工具。它主要用于将文本数据转换为词频(Bag of Words)特征矩阵,这种方法在自然语言处理(NLP)中广泛应用,尤其是在文本分类、情感分析等任务中。以下是对 `CountVectorizer` 的详细介绍,包括它的工作原理、使用方法和示例。

1. CountVectorizer 的概述

目的: 将文本数据(如文档、句子或单词)转换为特征矩阵,表示每个文档中每个单词的出现次数。

输入形式: 输入通常是一组文本数据(如列表或数组),输出是一个稀疏矩阵,其中行对应于文档,列对应于词汇表中的单词。

2. 特点与优点

简单易用: `CountVectorizer` 的实现非常简单,适合快速构建特征矩阵。

词频表示: 每个单词在文档中的出现次数能够反映文本的特征。

处理语料库: 可以处理大量文本,并在转换时自动构建词汇表。

3. 使用方法

3.1 安装 Scikit-learn

如果你尚未安装 Scikit-learn,可以通过以下命令安装:

pip install scikit-learn

3.2 基本用法

下面是 `CountVectorizer` 的基本使用示例:

from sklearn.feature_extraction.text import CountVectorizer

# 示例文档

documents = [

"I love programming in Python.",

"Python is great for data science.",

"I enjoy learning new programming languages."

]

# 创建 CountVectorizer 实例

vectorizer = CountVectorizer()

# 生成特征矩阵

X = vectorizer.fit_transform(documents)

# 查看词汇表

feature_names = vectorizer.get_feature_names()

# 转换为数组并打印

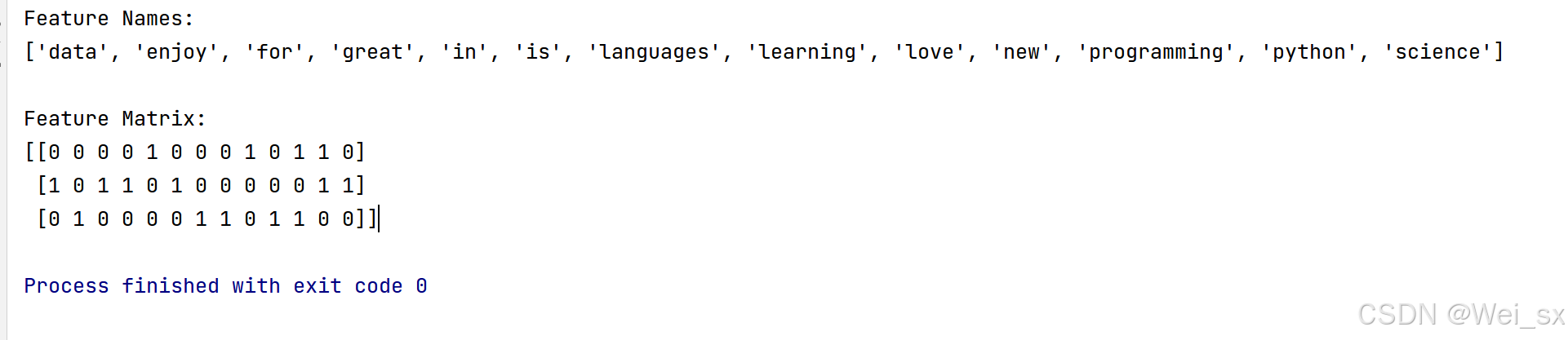

print("Feature Names:")

print(feature_names)

print("\nFeature Matrix:")

print(X.toarray())

5. 参数配置

`CountVectorizer` 提供了多种参数以调整文本特征提取过程:

stop_words: 可以选择去除停用词,如 `stop_words='english'` 来移除英语的常见停用词。

max_features: 限制词汇表的最大特征数,帮助减少维度。例如,`max_features=10`。

ngram_range: 设置 n-gram 范围,如 `(1, 2)` 表示提取单词和双词特征。

binary: 如果设置为 `True`,则所有特征值都被设置为 0 或 1,表示词是否出现,而不是出现的次数。

6. 应用场景

`CountVectorizer` 在文本数据处理中的应用场景包括:

文本分类: 将文本数据转换为结构化格式,以允许机器学习模型进行分类。

情感分析: 提取特征以判断文本的情感倾向。

信息检索: 构建搜索引擎的特征基础。

推荐系统: 基于文本特征进行内容推荐。

7. 结论

`CountVectorizer` 是处理文本数据时一个非常有效的工具,能够帮助快速构建特征矩阵,为后续的机器学习模型训练奠定基础。通过灵活的参数配置,用户可以根据实际需求调整文本特征提取的行为。

871

871

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?