第 1 章:回归模型的可解释性

回归模型是机器学习和统计学中常用的工具,用于预测和分析数据之间的关系。随着模型变得更复杂,理解它们如何做出决策变得越来越重要。本章关注回归模型的可解释性,特别是线性回归和它的扩展形式——广义线性模型(Generalized Linear Models, GLM)。我们将一步步解释这些模型的工作原理、如何解释它们的输出,以及在实际问题中的应用。通过理论说明、例子和代码,我们会展示如何分析模型,并处理常见问题如共线性。内容会逐步展开,确保你能跟上每个步骤。

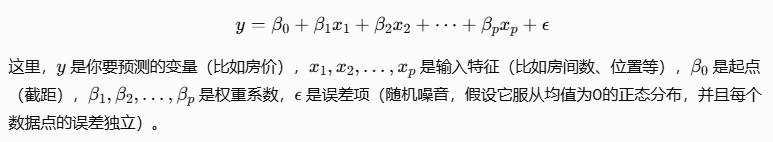

可解释性在回归模型中很重要,因为模型的参数(如权重系数)可以直接告诉你输入特征对输出结果的影响。这让线性回归成为一个简单易懂的起点,常用来比较更复杂的模型。然而,可解释性不是完美的;如果特征之间相关太强,或者关系不是线性的,解释可能会出错。我们会通过统计方法和工具来检查和改进这些问题。

2.1 线性回归与广义线性模型 (GLM)

线性回归假设输入特征和输出变量之间是线性关系,而 GLM 通过一个链接函数扩展了这个假设,让模型能处理更多类型的数据分布,比如计数数据或二分类问题。这些模型的可解释性来自它们的结构:系数可以直观地显示特征的影响大小和方向。

2.1.1 原理:权重系数的统计学意义与 p-value 检验

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?