<think>嗯,用户现在想了解如何使用两个神经网络分别求解V和T,其中V是温度T对时间t的一阶导数。之前已经讨论过双曲型非傅里叶方程的解析和数值解法,现在用户可能对机器学习方法,特别是神经网络的应用感兴趣。

首先,我需要回忆一下物理信息神经网络(PINN)的基本原理。PINN通过将偏微分方程作为损失函数的一部分,训练神经网络来近似解。这里的问题涉及到两个变量,V和T,所以可能需要两个网络,或者一个网络输出两个变量。不过用户明确说使用两个神经网络分别求解,所以得考虑如何分开训练或联合训练。

接下来,原方程是τ*∂²T/∂t² + ∂T/∂t = α*∂²T/∂x²。但用户提到V是∂T/∂t,所以可能需要将原方程转换为包含V的形式。之前的回复中已经分解成两个方程:∂T/∂t = V 和 τ*∂V/∂t + V = α*∂²T/∂x²。这样,T和V的关系就明确了,每个方程可以对应一个神经网络的损失函数。

然后,考虑边界条件和初始条件。T在x=0处为1,x=1处为0,初始时刻T=0。而V作为∂T/∂t,在初始时刻可能也需要满足某些条件,比如初始时刻V(x,0)=0,因为初始温度全为0,可能初始时温度变化率也为0?或者需要根据原方程推导初始的V值。这可能影响到初始条件的设置。

对于神经网络的结构,每个网络可能需要输入x和t,输出对应的T或V。需要设计合适的损失函数,包括方程残差、边界条件和初始条件的匹配。例如,对于T网络,损失函数应包括T在边界和初始时刻的匹配,以及∂T/∂t - V的残差。对于V网络,损失应包括τ*∂V/∂t + V - α*∂²T/∂x²的残差。但这里可能需要两个网络之间有交互,因为V的方程涉及T的二阶空间导数。

可能需要用自动微分来计算导数,比如用TensorFlow或PyTorch的自动微分功能。比如,计算T对x的二阶导数,然后代入到V的损失函数中。这可能需要两个网络同时训练,因为V的损失依赖于T网络的输出。

另外,初始条件的矛盾仍然存在,即t=0时,T在x=0处应该从0跳变到1,这可能引起训练困难。或许需要引入软边界条件,比如在损失函数中使用较大的权重来强调边界条件的重要性,或者采用渐进的方法逐步逼近。

还需要考虑采样点的分布,是否在边界和初始区域密集采样,以提高网络的准确性。同时,训练过程中可能需要调整损失函数的权重,平衡方程残差、边界条件和初始条件的影响。

可能存在的一些挑战包括:如何高效地计算高阶导数,如何处理两个网络之间的耦合,以及如何解决初始条件的不连续问题。此外,双曲方程的波动特性可能导致训练过程中出现不稳定的解,需要合适的正则化或网络结构来捕捉波动行为。

可能需要查阅相关文献,看看是否有类似的工作,比如用PINN求解双曲方程,或者使用多个网络分别处理不同变量。例如,有些研究可能使用一个网络同时输出多个变量,但用户要求分开使用两个网络,所以需要调整方法。

最后,可能需要建议用户使用现有的深度学习框架(如TensorFlow或PyTorch)实现这两个网络,并详细说明损失函数的构建、数据采样和训练策略,同时提醒可能遇到的难点,如初始条件的不连续和方程的耦合性。</think>---

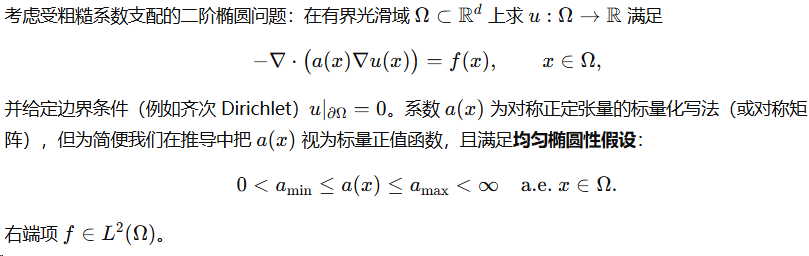

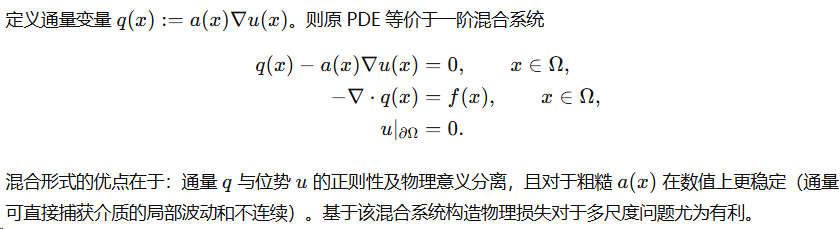

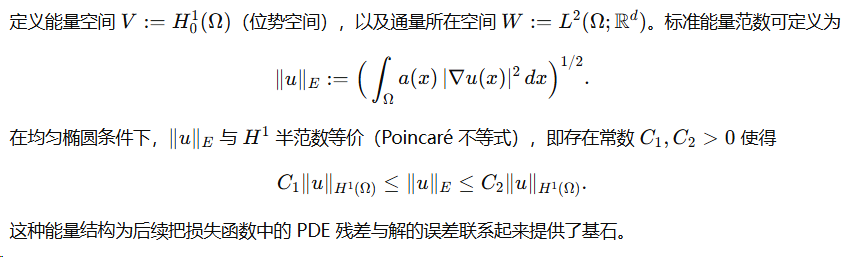

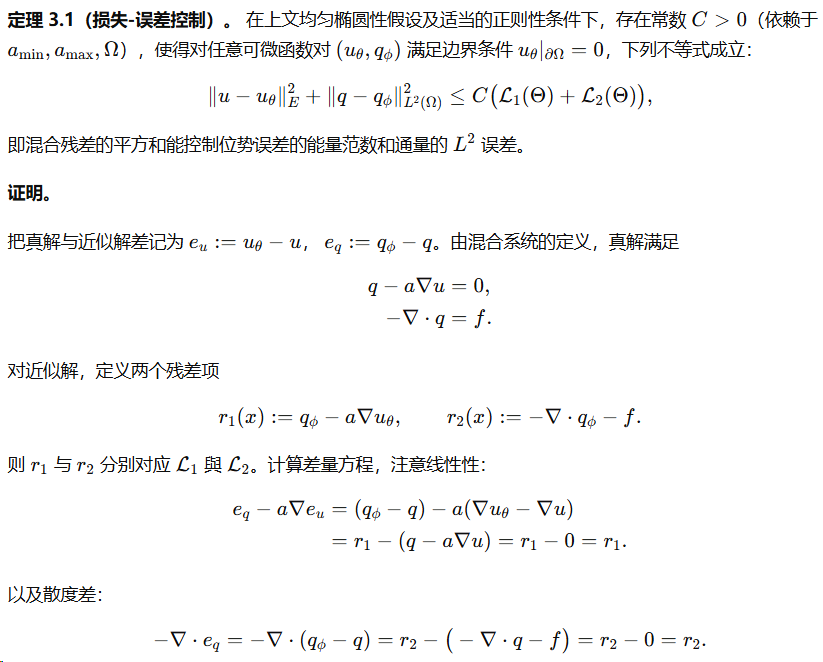

### **使用双神经网络求解 $V$ 和 $T$ 的步骤与原理**

针对一维双曲型非傅里叶方程,假设 $V = \frac{\partial T}{\partial t}$,可通过两个神经网络分别建模 $V(x,t)$ 和 $T(x,t)$。以下是具体方法和关键分析:

---

#### **1. 方程分解与变量定义**

原方程:

$$

\tau \frac{\partial^2 T}{\partial t^2} + \frac{\partial T}{\partial t} = \alpha \frac{\partial^2 T}{\partial x^2}.

$$

引入辅助变量 $V = \frac{\partial T}{\partial t}$,得到方程组:

$$

\begin{cases}

\frac{\partial T}{\partial t} = V, \\

\tau \frac{\partial V}{\partial t} + V = \alpha \frac{\partial^2 T}{\partial x^2}.

\end{cases}

$$

目标是通过两个神经网络 $\mathcal{N}_T(x,t)$ 和 $\mathcal{N}_V(x,t)$ 分别近似 $T(x,t)$ 和 $V(x,t)$。

---

#### **2. 神经网络的输入与输出**

- **网络 $\mathcal{N}_T$**:输入为 $(x,t)$,输出为预测的 $T_{\text{pred}}$。

- **网络 $\mathcal{N}_V$**:输入为 $(x,t)$,输出为预测的 $V_{\text{pred}}$。

---

#### **3. 损失函数设计**

损失函数需满足以下约束:

- **方程残差**:确保解满足偏微分方程(PDE)。

- **边界条件**:在 $x=0$ 和 $x=1$ 处满足温度约束。

- **初始条件**:$t=0$ 时 $T=0$,且 $V=0$(由初始时刻无温度变化假设)。

具体损失项如下:

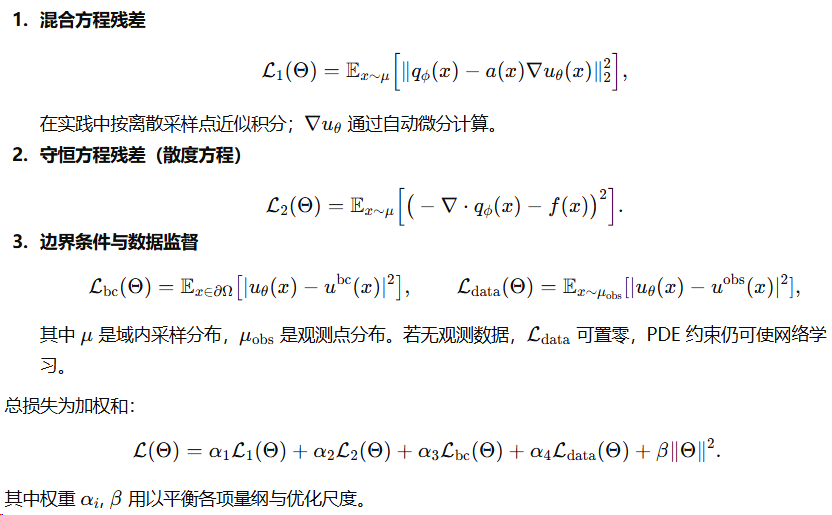

1. **PDE 残差损失**:

- 方程 1 残差:$\mathcal{L}_{\text{eq1}} = \left\| \frac{\partial T_{\text{pred}}}{\partial t} - V_{\text{pred}} \right\|^2$,

- 方程 2 残差:$\mathcal{L}_{\text{eq2}} = \left\| \tau \frac{\partial V_{\text{pred}}}{\partial t} + V_{\text{pred}} - \alpha \frac{\partial^2 T_{\text{pred}}}{\partial x^2} \right\|^2$。

2. **边界条件损失**:

- $x=0$ 处:$\mathcal{L}_{\text{BC0}} = \| T_{\text{pred}}(0,t) - 1 \|^2$,

- $x=1$ 处:$\mathcal{L}_{\text{BC1}} = \| T_{\text{pred}}(1,t) - 0 \|^2$。

3. **初始条件损失**:

- $\mathcal{L}_{\text{IC}_T} = \| T_{\text{pred}}(x,0) - 0 \|^2$,

- $\mathcal{L}_{\text{IC}_V} = \| V_{\text{pred}}(x,0) - 0 \|^2$。

**总损失**:

$$

\mathcal{L}_{\text{total}} = \lambda_1 (\mathcal{L}_{\text{eq1}} + \mathcal{L}_{\text{eq2}}) + \lambda_2 (\mathcal{L}_{\text{BC0}} + \mathcal{L}_{\text{BC1}}) + \lambda_3 (\mathcal{L}_{\text{IC}_T} + \mathcal{L}_{\text{IC}_V}),

$$

其中 $\lambda_1, \lambda_2, \lambda_3$ 为权重系数,用于平衡不同约束。

---

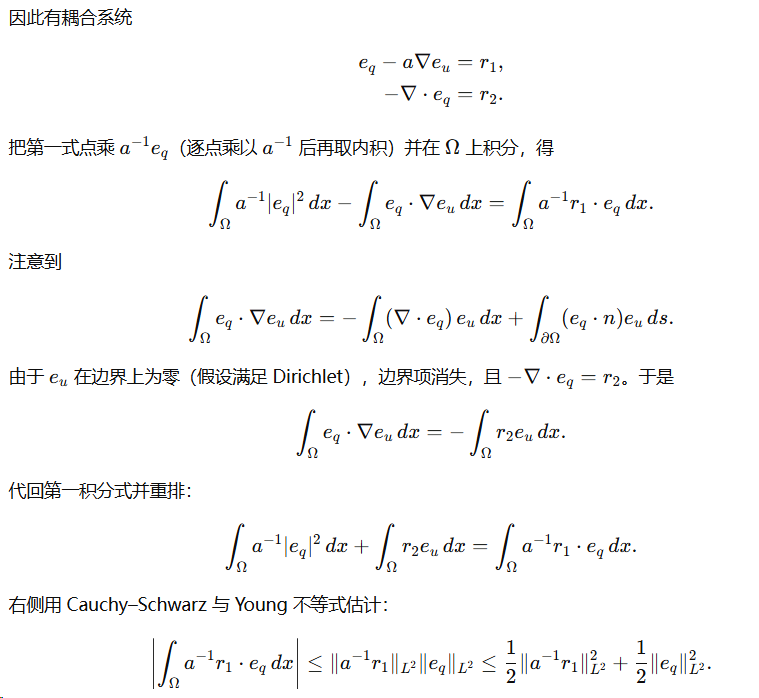

#### **4. 自动微分与实现**

- **导数计算**:利用深度学习框架(如 TensorFlow 或 PyTorch)的自动微分功能计算 $\frac{\partial T}{\partial t}$、$\frac{\partial V}{\partial t}$ 和 $\frac{\partial^2 T}{\partial x^2}$。

- **网络耦合**:两个网络需联合训练,因 $V$ 的方程依赖 $T$ 的二阶空间导数。

---

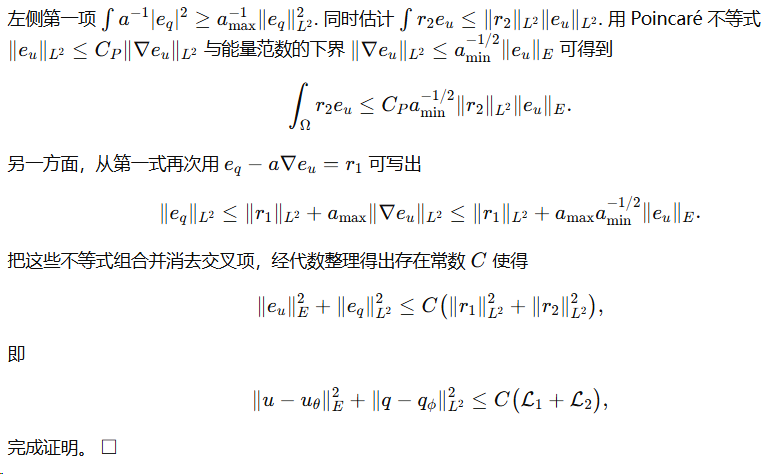

#### **5. 关键挑战与解决方案**

- **初始条件的跳跃性**:

- 在 $t=0$ 时,$x=0$ 处 $T$ 从 0 突变到 1,导致梯度爆炸。

- **解决方案**:在初始时刻附近增加采样点密度,或引入光滑过渡函数(如 $T(0,t) = 1 - e^{-kt}$,$k$ 为大常数)。

- **双曲方程的波动特性**:

- 温度波动的传播需在损失函数中体现波前特性。

- **解决方案**:在波前区域(如 $x = vt$)附近加密采样点。

- **训练稳定性**:

- 损失项权重($\lambda_i$)需动态调整,优先保证边界和初始条件。

---

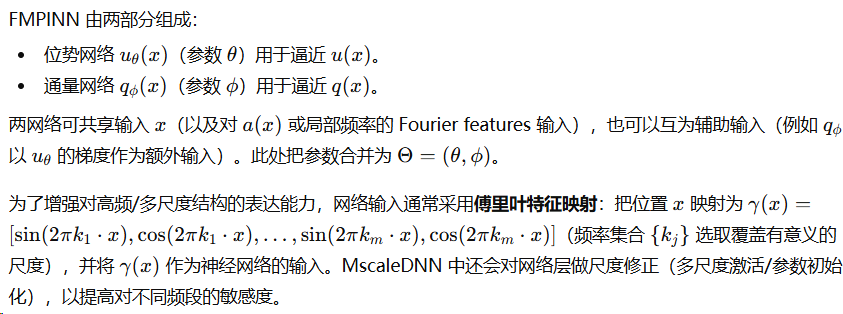

#### **6. 代码实现框架(PyTorch 示例)**

```python

import torch

import torch.nn as nn

# 定义两个神经网络

class Net_T(nn.Module):

def __init__(self):

super().__init__()

self.fc = nn.Sequential(

nn.Linear(2, 50), nn.Tanh(),

nn.Linear(50, 50), nn.Tanh(),

nn.Linear(50, 1)

)

def forward(self, x, t):

return self.fc(torch.cat([x, t], dim=1))

class Net_V(nn.Module):

def __init__(self):

super().__init__()

self.fc = nn.Sequential(

nn.Linear(2, 50), nn.Tanh(),

nn.Linear(50, 50), nn.Tanh(),

nn.Linear(50, 1)

)

def forward(self, x, t):

return self.fc(torch.cat([x, t], dim=1))

# 损失函数计算

def compute_loss(net_T, net_V, x, t, tau, alpha):

x.requires_grad_(True)

t.requires_grad_(True)

# 预测 T 和 V

T_pred = net_T(x, t)

V_pred = net_V(x, t)

# 计算导数

dT_dt = torch.autograd.grad(T_pred, t, grad_outputs=torch.ones_like(T_pred), create_graph=True)[0]

dV_dt = torch.autograd.grad(V_pred, t, grad_outputs=torch.ones_like(V_pred), create_graph=True)[0]

dT_dx = torch.autograd.grad(T_pred, x, grad_outputs=torch.ones_like(T_pred), create_graph=True)[0]

d2T_dx2 = torch.autograd.grad(dT_dx, x, grad_outputs=torch.ones_like(dT_dx), create_graph=True)[0]

# 方程残差

loss_eq1 = torch.mean((dT_dt - V_pred)**2)

loss_eq2 = torch.mean((tau * dV_dt + V_pred - alpha * d2T_dx2)**2)

# 边界和初始条件

# 此处需根据采样点具体实现

# ...

return loss_eq1 + loss_eq2 + loss_bc + loss_ic

```

---

#### **7. 验证与改进**

- **解析解对比**:若存在简化情况的解析解(如 $\tau=0$ 退化到抛物型方程),可验证网络预测的准确性。

- **自适应加权**:使用软注意力机制动态调整 $\lambda_i$,聚焦难优化的区域。

- **物理一致性**:检查解是否满足温度波速 $v = \sqrt{\alpha/\tau}$。

---

### **总结**

通过双神经网络分别建模 $T$ 和 $V$,结合物理约束的损失函数,可有效求解双曲型非傅里叶方程。需注意初始条件的不连续性、波前特性的捕捉以及训练稳定性。实际应用中建议逐步调试损失权重,并可视化解的空间-时间演化以验证合理性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

904

904

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?