这篇文章提出了一种名为自解释符号图Transformer(SE-SGformer)的新模型,用于解决符号图神经网络(SGNN)在链接符号预测任务中的可解释性问题。符号图包含正边和负边,分别表示节点之间的正负关系。现有的SGNN模型在预测链接符号时缺乏可解释性,限制了其在需要解释预测结果的关键场景中的应用。

主要内容总结:

-

问题背景:

-

符号图神经网络(SGNN)在链接符号预测任务中表现出色,但缺乏可解释性,难以解释预测结果。

-

现有的解释方法多为后验解释,可能产生偏差,无法真实反映模型的决策过程。

-

-

提出的方法:

-

SE-SGformer:一种自解释的符号图Transformer模型,能够在预测链接符号的同时提供解释。

-

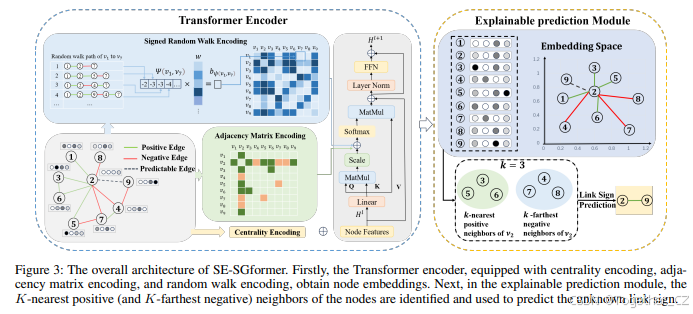

编码模块:使用Transformer架构,结合中心性编码、邻接矩阵编码和符号随机游走编码,增强节点表示的能力。

-

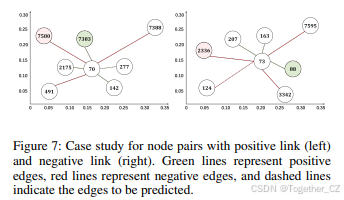

可解释预测模块:通过识别每个节点的K近正邻居和K远负邻居,预测边的符号,并提供解释信息。

-

-

理论贡献:

-

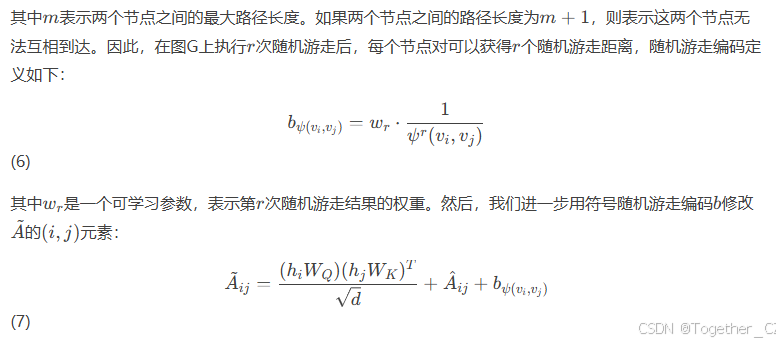

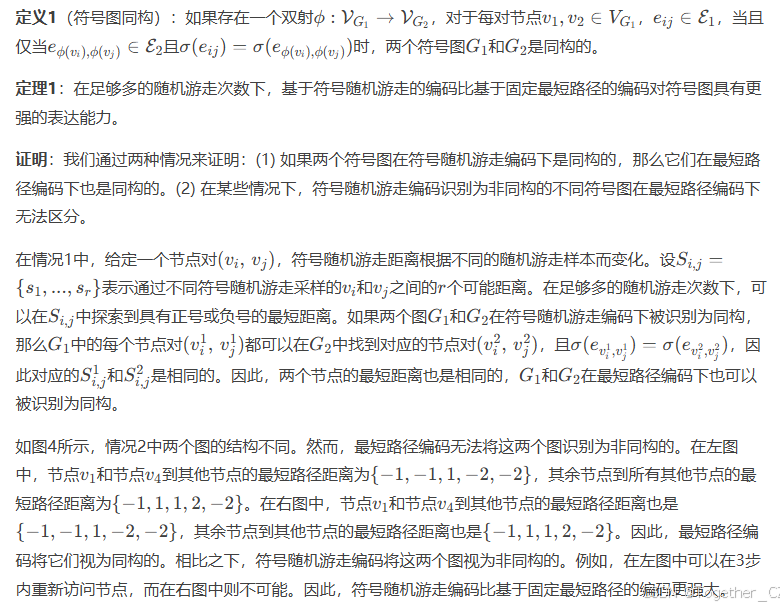

证明了符号随机游走编码比最短路径编码更具表达能力。

-

证明了基于符号随机游走编码的Transformer架构比现有的SGCN模型更具表达能力。

-

-

实验验证:

-

在多个真实世界的数据集上进行实验,SE-SGformer在预测准确率和解释准确率上均优于现有的基线方法。

-

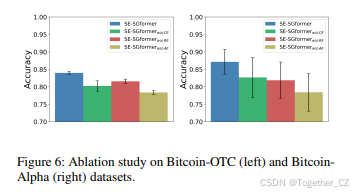

通过消融实验验证了模型中各个编码模块的有效性。

-

-

主要贡献:

-

提出了首个自解释的符号图Transformer模型,专门用于链接符号预测任务。

-

设计了新的编码方法,增强了模型的表达能力。

-

通过实验验证了模型在预测和解释方面的优越性。

-

SE-SGformer通过结合Transformer架构和符号随机游走编码,不仅提高了链接符号预测的准确性,还提供了可解释的预测结果。该模型为解决符号图神经网络的可解释性问题提供了新的思路,并在多个真实数据集上验证了其有效性。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

官方项目地址在这里。

摘要

符号图神经网络(SGNNs)在分析现实世界中正负链接共存的复杂模式方面表现出色。然而,SGNN模型的可解释性较差,这限制了其在需要理解预测背后原理的关键场景中的应用。据我们所知,目前还没有关于SGNN模型可解释性的研究工作。我们的目标是解决符号图神经网络在链接符号预测下游任务中的决策可解释性问题。由于后验解释并非直接来自模型,它们可能存在偏差,并不能真实反映模型的解释。因此,本文提出了一种自解释符号图Transformer(SE-SGformer)框架,该框架不仅能够输出可解释的信息,同时还能保证高预测精度。具体来说,我们提出了一种新的符号图Transformer架构,并从理论上证明了基于符号随机游走的位置编码比当前的SGNN方法和其他基于位置编码的图Transformer方法具有更强的表达能力。我们通过发现节点的K近(远)正(负)邻居来构建一种新的可解释决策过程,以替代基于神经网络的解码器来预测边的符号。这些K正(负)邻居代表了节点之间形成正(负)边的关键信息,因此可以作为决策过程中的重要解释信息。我们在多个真实世界的数据集上进行了实验,验证了SE-SGformer的有效性,在最佳情况下,预测精度提高了2.2%,解释精度提高了73.1%。

引言

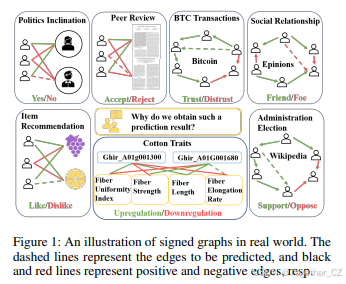

符号图神经网络(SGNNs)广泛用于学习符号图的表示,如图1所示。尽管近年来以链接符号预测为核心任务的SGNNs引起了越来越多的关注[4, 22, 23, 24],但现有的SGNN研究尚未解决可解释性问题,这阻碍了其在关键领域的应用。例如,在金融网络中,能够解释为什么某些交易被标记为可疑可以提高欺诈检测和预防的能力。因此,理解为什么某些关系被分类为正或负可以帮助SGNNs更广泛地应用。

GNN可解释性研究主要分为两类:后验解释[25, 26]和自解释方法[3, 27]。后验解释方法如GNNExplainer[28]和PGExplainer[16]为训练好的GNN模型提供解释,但这些解释可能存在偏差,并不能真实反映模型。因此,当前的研究正在转向自解释方法,即模型在生成预测的同时生成解释。例如,SE-GNN[5]使用KK近标记节点进行可解释的节点分类,而ProtGNN[25]通过原型学习增强可解释性。虽然这些方法有效,但它们主要设计用于无符号图的图或节点分类任务,因此不适用于专注于链接符号预测的SGNNs。这凸显了需要一种新的符号图表示学习可解释框架,能够同时提供预测和解释。

图1:现实世界中的符号图示例。虚线表示待预测的边,黑色和红色线分别表示正边和负边。

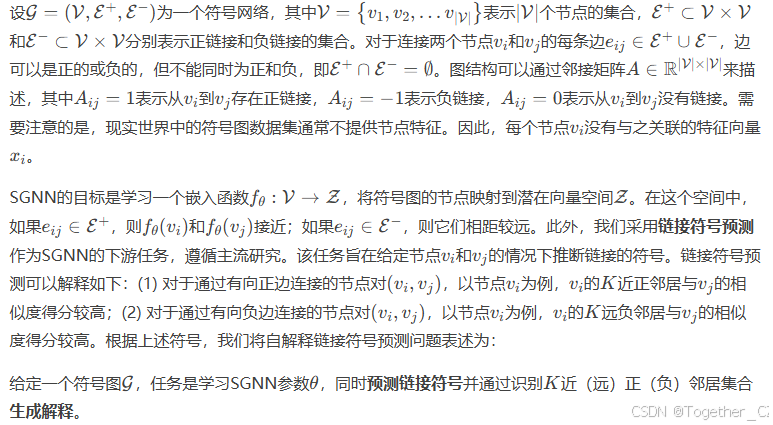

问题定义

方法

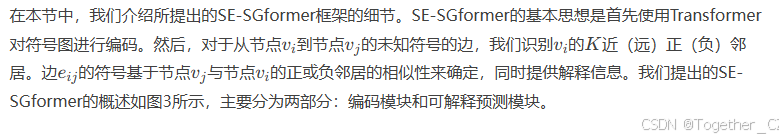

编码模块

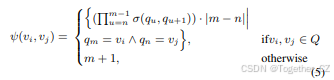

对于图表示,将图的结构信息整合到Transformer模型中至关重要。因此,我们引入了三种新的编码方式,具体细节如下:

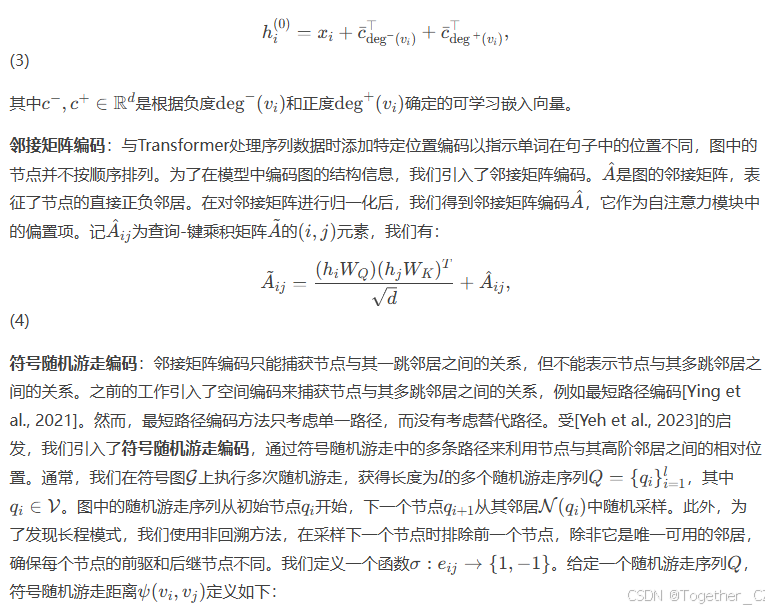

中心性编码:度中心性衡量了节点在图中的影响力,较高的度表示潜在的影响力较大。然而,这些见解在注意力计算中常常被忽略。因此,我们设计了一种针对符号图的中心性编码,以反映每个节点的重要性。具体来说,我们根据每个节点的正度和负度为每个节点分配两个实值嵌入向量。我们直接将每个节点的中心性编码添加到其原始特征xi中,形成新的节点嵌入:

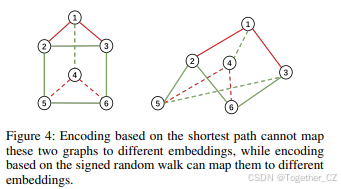

接下来,我们通过实验验证了符号随机游走编码的表达能力,结果可以在附录中找到。符号图的最短路径编码计算两个节点之间的距离,并使用平衡理论为路径分配正或负关系。

对于挑战1中的问题,我们进一步分析了基于符号随机游走编码的图Transformer架构与基于SGCN的SGNN模型的表达能力。我们的结论如下:

定理2:(证明见附录)在足够多的随机游走长度下,基于符号随机游走编码的图Transformer架构比SGCN更具表达能力。

图4:基于最短路径的编码无法将这两个图映射到不同的嵌入,而基于符号随机游走的编码可以将它们映射到不同的嵌入。

图3:SE-SGformer的整体架构。首先,Transformer编码器配备了中心性编码、邻接矩阵编码和随机游走编码,获得节点嵌入。接下来,在可解释预测模块中,识别节点的K近正(和K远负)邻居,并用于预测未知的链接符号。

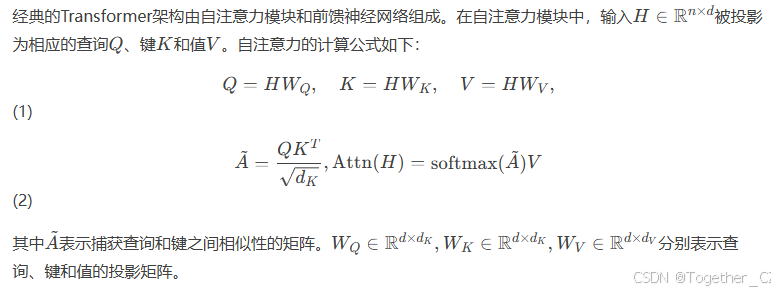

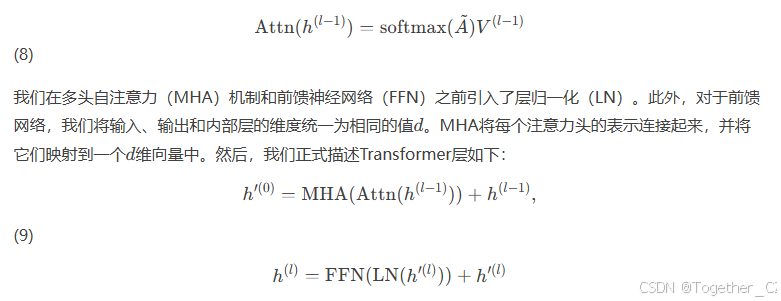

Transformer层

在自注意力层中,每个注意力头的计算公式如下:

损失函数遵循SGCN [Derr, Ma, and Tang, 2018],可以在附录中找到。编码模块的训练算法在算法3.2中给出。

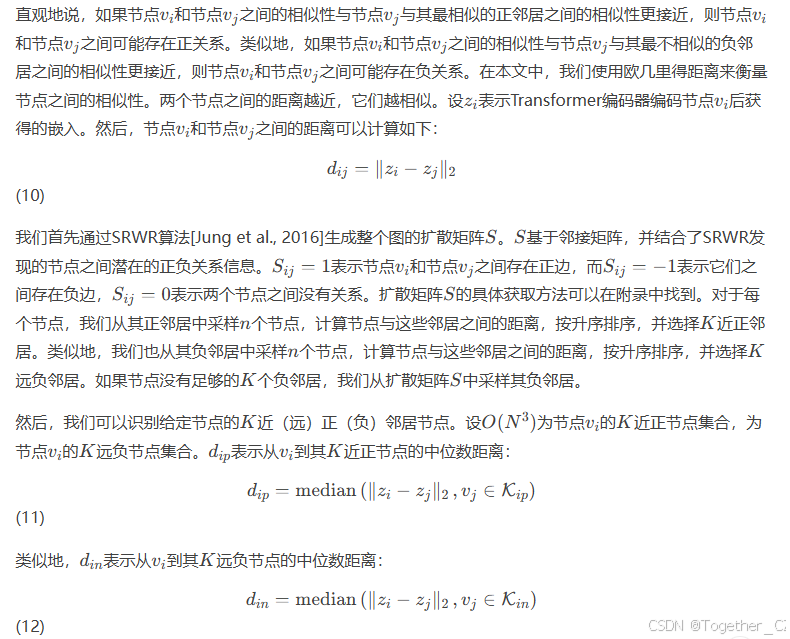

可解释预测模块

实验

在本节中,我们在真实世界的数据集上进行实验,以验证SE-SGformer的有效性。特别是,我们旨在回答以下研究问题:

-

RQ1:SE-SGformer能否提供准确的预测和解释信息?

-

RQ2:超参数如何影响SE-SGformer的性能?

-

RQ3:SE-SGformer的每个组件如何对链接符号预测性能做出贡献?

我们的实验数据集包括Bitcoin-OTC、Bitcoin-Alpha、WikiElec、WikiRfa、Epinions、KualRand、KualRec和Amazon-music,基线方法为GCN [12]、GAT [13]、SGCN [4]、SNEA [16]、SGCL [19]和SIGFormer [5]。有关数据集和基线的详细信息,请参阅附录。

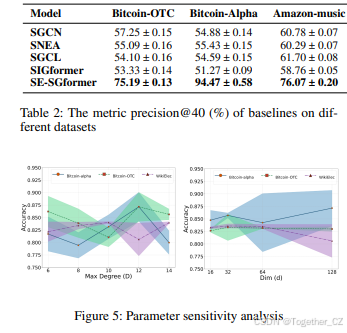

性能和解释质量(RQ1)

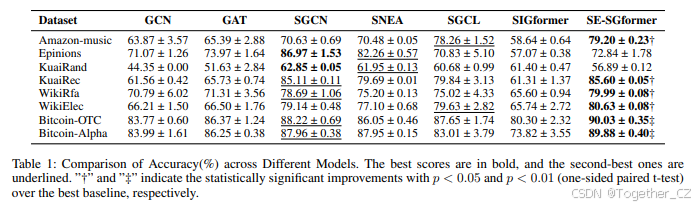

为了回答RQ1,我们在真实世界的数据集上比较了SE-SGformer与基线方法在链接符号预测方面的性能。所有数据集均进行了五次实验,链接符号预测准确率和标准差如表1所示。从表中可以观察到以下结果:

-

我们的方法在大多数数据集上优于SGCN、SNEA和SGCL,表明我们的编码方法生成了合适的图表示,并结合我们的可解释决策,取得了优异的结果。如前所述,我们的方法可以缓解符号图中负边稀缺和无法为不平衡环学习适当表示等问题。因此,我们的方法可以实现更好的性能。

-

SE-SGformer的性能远远超过GCN和GAT,这是因为我们的方法比无符号GNN更好地利用了负边的信息。

-

SIGformer是一个相对较新的符号图Transformer模型,用于推荐系统,我们的模型在大多数数据集上优于SIGformer。这也证明了我们独特编码设计的有效性。

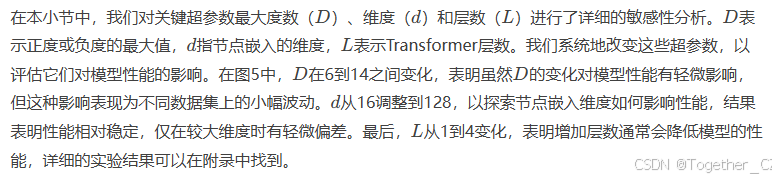

超参数敏感性分析(RQ2)

消融研究(RQ3)

结论

在本文中,我们通过提出SE-SGformer来解决自解释SGNNs的挑战,SE-SGformer是一种用于符号图的新型图Transformer模型。我们的模型通过识别K近正和K远负邻居来预测链接符号。我们还从理论上证明了我们的符号随机游走编码比最短路径编码更强大,并且我们的基于符号随机游走编码的Transformer架构比SGCN更强大。在真实世界数据集上的广泛实验验证了我们模型的有效性。作为链接符号预测可解释性的首次探索,我们期待在这一领域的进一步研究。

3262

3262

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?