1.1 背景

1.1.1 问题引入

-

编写一个应用程序,接受地理信息、卫星图像和一些历史天气信息,并预测明天的天气;

-

编写一个应用程序,接受自然文本表示的问题,并正确回答该问题;

-

编写一个应用程序,接受一张图像,识别出该图像所包含的人,并在每个人周围绘制轮廓;

-

编写一个应用程序,向用户推荐他们可能喜欢,但在自然浏览过程中不太可能遇到的产品。

1.1.2 机器学习

机器学习(machine learning,ML)是一类强大的可以从经验中学习的技术。通常采用观测数据或与环境交互的形式,机器学习算法会积累更多的经验,其性能也会逐步提高。

1.2 日常生活中的机器学习

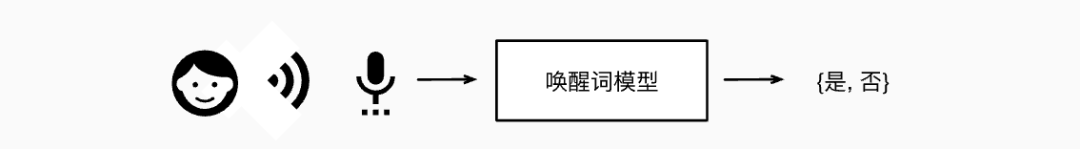

1.2.1 识别唤醒词

-

参数(parameter)

我们只需要定义一个灵活的程序算法,其输出由许多参数(parameter)决定,然后使用数据集来确定当下的“最佳参数集”,这些参数通过某种性能度量方式来达到完成任务的最佳性能。

-

模型(model)

任一调整参数后的程序被称为模型(model)。

-

学习(learning)

在机器学习中,学习(learning)是一个训练模型的过程。通过这个过程,我们可以发现正确的参数集,从而使模型强制执行所需的行为。

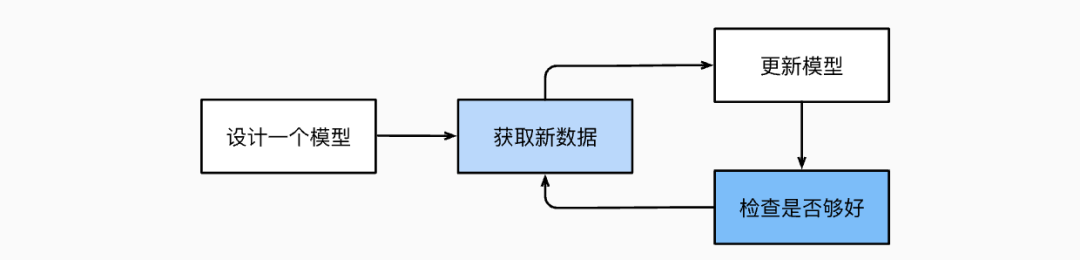

1.2.2 模型训练

-

从一个随机初始化参数的模型开始,这个模型基本没有“智能”;

-

获取一些数据样本(例如,音频片段以及对应的是或否标签);

-

调整参数,使模型在这些样本中表现得更好;

-

重复第(2)步和第(3)步,直到模型在任务中的表现令人满意。

1.3 机器学习中的关键组件

-

可以用来学习的数据(data);

-

如何转换数据的模型(model);

-

一个目标函数(objective function),用来量化模型的有效性;

-

调整模型参数以优化目标函数的算法(algorithm)。

1.3.1 数据

-

每个数据集由一个个样本(example, sample)组成。

-

大多时候,它们遵循独立同分布(independently and identically distributed, i.i.d.)。

-

样本有时也叫做数据点(data point)或者数据实例(datainstance),

-

通常每个样本由一组称为特征(features,或协变量(covariates)的属性组成。

-

机器学习模型会根据这些属性进行预测。 在上面的监督学习问题中,要预测的是一个特殊的属性,它被称为标签(label,或目标(target))。

-

当每个样本的特征类别数量都是相同的时候,其特征向量是固定长度的,这个长度被称为数据的维数(dimensionality)。

1.3.2 模型

-

深度学习

深度学习与经典方法的区别主要在于:前者关注的功能强大的模型,这些模型由神经网络错综复杂的交织在一起,包含层层数据转换,因此被称为深度学习(deep learning)。

1.3.3 目标函数

-

目标函数

在机器学习中,我们需要定义模型的优劣程度的度量,这个度量在大多数情况是“可优化”的,这被称之为目标函数(objective function)。

-

损失函数

我们通常定义一个目标函数,并希望优化它到最低点。因为越低越好,所以这些函数有时被称为损失函数(loss function,或cost function)。当任务在试图预测数值时,最常见的损失函数是平方误差(squared error),即预测值与实际值之差的平方。

-

-

损失函数是根据模型参数定义的,并取决于数据集。

-

该数据集由一些为训练而收集的样本组成,称为训练数据集(training dataset,或称为训练集(training set))。

-

在训练数据上表现良好的模型,并不一定在“新数据集”上有同样的性能,这里的“新数据集”通常称为测试数据集(test dataset,或称为测试集(test set))。

-

训练数据集用于拟合模型参数,测试数据集用于评估拟合的模型。

-

-

过拟合

当一个模型在训练集上表现良好,但不能推广到测试集时,这个模型被称为过拟合(overfitting)。

1.3.4 优化算法

-

梯度下降

当我们获得了一些数据源及其表示、一个模型和一个合适的损失函数,接下来就需要一种算法,它能够搜索出最佳参数,以最小化损失函数。深度学习中,大多流行的优化算法通常基于一种基本方法–梯度下降(gradient descent)。

1.4 机器学习问题

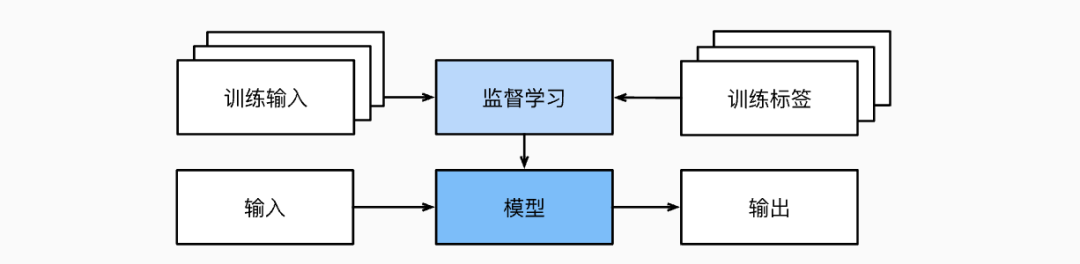

1.4.1 监督学习

监督学习(supervised learning)擅长在“给定输入特征”的情况下预测标签。每个“特征-标签”对都称为一个样本(example)。

-

监督学习的学习过程:

-

从已知大量数据样本中随机选取一个子集,为每个样本获取真实标签。有时,这些样本已有标签(例如,患者是否在下一年内康复?);有时,这些样本可能需要被人工标记(例如,图像分类)。这些输入和相应的标签一起构成了训练数据集;

-

选择有监督的学习算法,它将训练数据集作为输入,并输出一个“已完成学习的模型”;

-

将之前没有见过的样本特征放到这个“已完成学习的模型”中,使用模型的输出作为相应标签的预测。

-

-

监督学习的模型

-

回归(regression)判断回归问题的一个很好的经验法则是,任何有关“有多少”的问题很可能就是回归问题。

-

分类分类问题希望模型能够预测样本属于哪个类别(category,正式称为类(class))

-

标记问题学习预测不相互排斥的类别的问题称为多标签分类(multi-label classification)。

-

搜索在信息检索领域,我们希望对一组项目进行排序。

-

推荐系统推荐系统(recommender system),它的目标是向特定用户进行“个性化”推荐。

-

序列学习序列学习需要摄取输入序列或预测输出序列,或两者兼而有之。标记和解析、自动语音识别、文本到语音、机器翻译。

-

1.4.2 无监督学习

这类数据中不含有“目标”的机器学习问题通常被为无监督学习(unsupervised learning)

-

聚类(clustering)问题:没有标签的情况下,我们是否能给数据分类呢?

-

主成分分析(principal component analysis)问题:我们能否找到少量的参数来准确地捕捉数据的线性相关属性?

-

因果关系(causality)和概率图模型(probabilistic graphical models)问题:我们能否描述观察到的许多数据的根本原因?

-

生成对抗性网络(generative adversarial networks):为我们提供一种合成数据的方法,甚至像图像和音频这样复杂的非结构化数据。

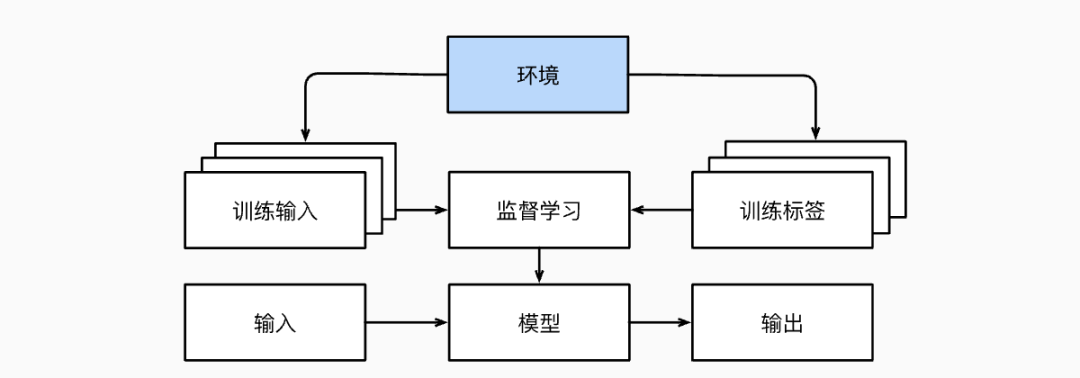

1.4.3 与环境互动

-

离线学习

不管是监督学习还是无监督学习,我们都会预先获取大量数据,然后启动模型,不再与环境交互。 这里所有学习都是在算法与环境断开后进行的,被称为离线学习(offline learning)。

1.4.4 强化学习

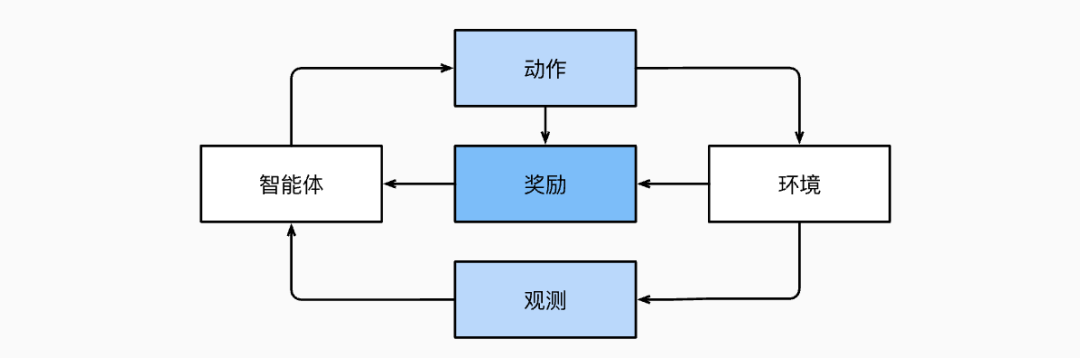

在强化学习问题中,智能体(agent)在一系列的时间步骤上与环境交互。

在每个特定时间点,智能体从环境接收一些观察(observation),并且必须选择一个动作(action),然后通过某种机制(有时称为执行器)将其传输回环境,最后智能体从环境中获得奖励(reward)。

1.5 深度学习的发展

-

新的容量控制方法,如dropout (Srivastava et al., 2014),有助于减轻过拟合的危险。

-

注意力机制解决了困扰统计学一个多世纪的问题:如何在不增加可学习参数的情况下增加系统的记忆和复杂性。

-

多阶段设计。例如,存储器网络 (Sukhbaatar et al., 2015) 和神经编程器-解释器 (Reed and De Freitas, 2015)。它们允许统计建模者描述用于推理的迭代方法。

-

生成对抗网络 (Goodfellow et al., 2014) 的发明。生成式对抗性网络的关键创新是用具有可微参数的任意算法代替采样器。然后对这些数据进行调整,使得鉴别器(实际上是一个双样本测试)不能区分假数据和真实数据。通过使用任意算法生成数据的能力,它为各种技术打开了密度估计的大门。

-

构建并行和分布式训练算法的能力有了显著提高。

-

并行计算的能力也对强化学习的进步做出了相当关键的贡献。

-

深度学习框架在传播思想方面发挥了至关重要的作用。允许轻松建模的第一代框架包括Caffe、Torch和Theano。

零基础入门AI大模型必看

陆陆续续也整理了不少资源,希望能帮大家少走一些弯路!

无论是学业还是事业,都希望你顺顺利利 !

1️⃣ 大模型入门学习路线图(附学习资源)

2️⃣ 大模型方向必读书籍PDF版

3️⃣ 大模型面试题库

4️⃣ 大模型项目源码

5️⃣ 超详细海量大模型LLM实战项目

6️⃣ Langchain/RAG/Agent学习资源

7️⃣ LLM大模型系统0到1入门学习教程

8️⃣ 吴恩达最新大模型视频+课件

以上大模型资料包的内容都整理在了我的gzh里,【小灰熊大模型】回复【6】自动掉落,都是🈚️尝分享,可以自取~

8680

8680

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?