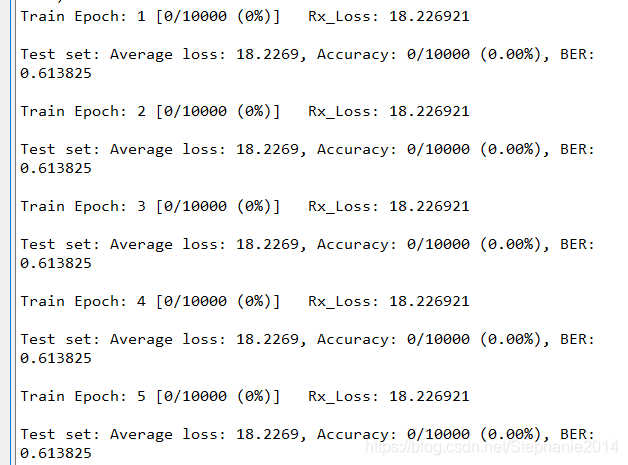

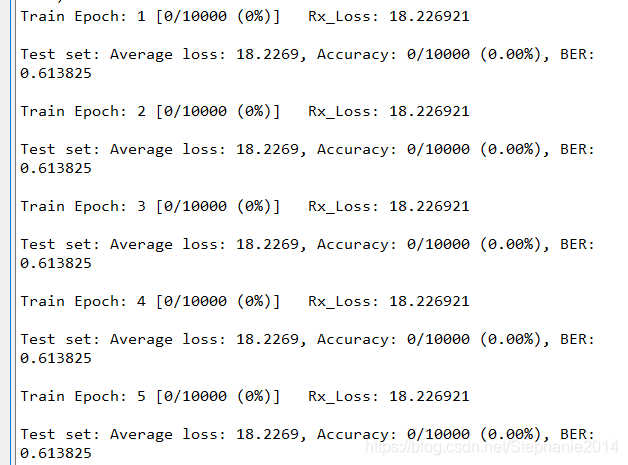

遇到奇怪的问题的时候总是会特别绝望,比如,网络参数完全不更新

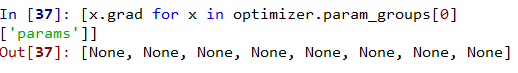

不知道怎么解决,所以就查看了一下参数的梯度,结果发现完全没有梯度

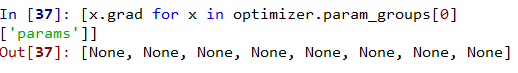

[x.grad for x in optimizer.param_groups[0]['params']]

惊不惊喜,意不意外

惊不惊喜,意不意外

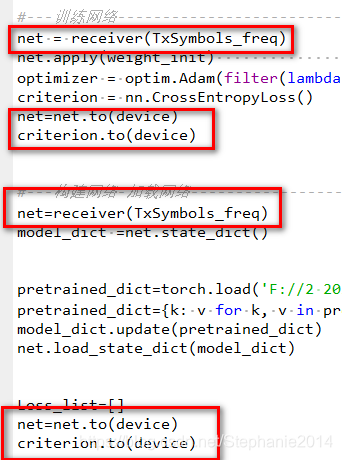

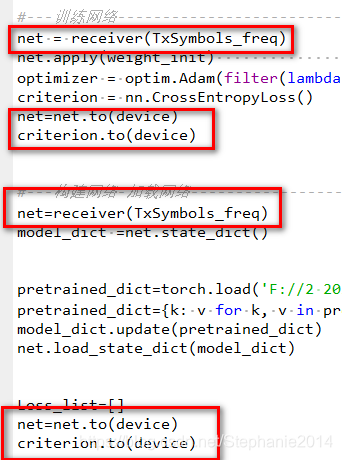

非常生气,我都是copy的以前的代码,结果,调了两天,就是自己的沙雕错误,我copy代码copy太多了,网络被写了两遍,删掉重复的就好了,不过不清楚为什么,反正网络调通了。。

遇到奇怪的问题的时候总是会特别绝望,比如,网络参数完全不更新

不知道怎么解决,所以就查看了一下参数的梯度,结果发现完全没有梯度

[x.grad for x in optimizer.param_groups[0]['params']]

惊不惊喜,意不意外

惊不惊喜,意不意外

非常生气,我都是copy的以前的代码,结果,调了两天,就是自己的沙雕错误,我copy代码copy太多了,网络被写了两遍,删掉重复的就好了,不过不清楚为什么,反正网络调通了。。

您可能感兴趣的与本文相关的镜像

PyTorch 2.6

PyTorch 是一个开源的 Python 机器学习库,基于 Torch 库,底层由 C++ 实现,应用于人工智能领域,如计算机视觉和自然语言处理

5925

5925

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?