摘要

反向传播算法(Backpropagation)是深度学习训练的核心引擎,依托微积分中的链式法则与偏导数概念,实现了多层神经网络参数的高效更新。本文从微积分视角剖析反向传播的数学基础与核心流程,结合经典与前沿代码示例,展望未来优化方向,并通过行业数据与对比分析,呈现其在产业界的广泛应用与发展趋势。

1 引言

深度学习的崛起离不开高效的梯度计算机制,而反向传播正是基于微积分实现这一过程的关键算法。随着模型规模与应用场景不断扩张,对反向传播的高效性、稳定性和可扩展性提出了更高要求。本文将系统梳理反向传播原理、实现技巧与行业实践。

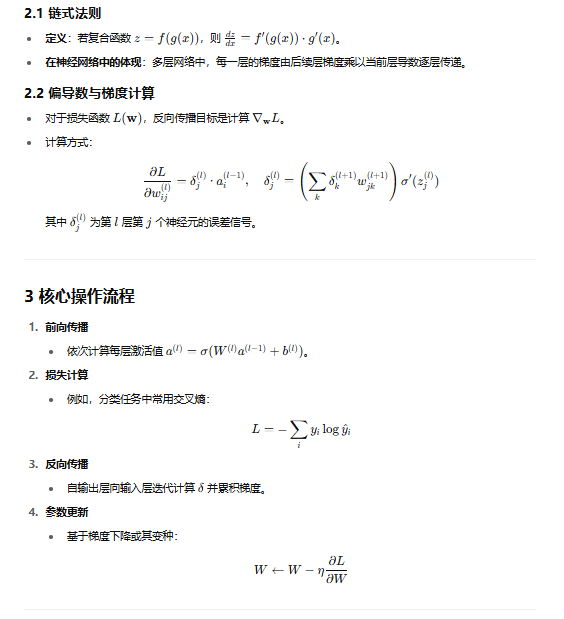

2 反向传播的数学基础

4 经典代码实现(NumPy版)

import numpy as np

def sigmoid(x): return 1 / (1 + np.exp(-x))

def sigmoid_grad(x): return sigmoid(x) * (1 - sigmoid(x))

# 前向与反向

def backprop(X, y, W1, W2, lr=0.1):

# 前向

z1 = X.dot(W1); a1 = sigmoid(z1)

z2 = a1.dot(W2); a2 = sigmoid(z2)

# 损失梯度

delta2 = (a2

订阅专栏 解锁全文

订阅专栏 解锁全文

866

866

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?