ACL2025结合大语言模型的推荐系统文章简读(1)

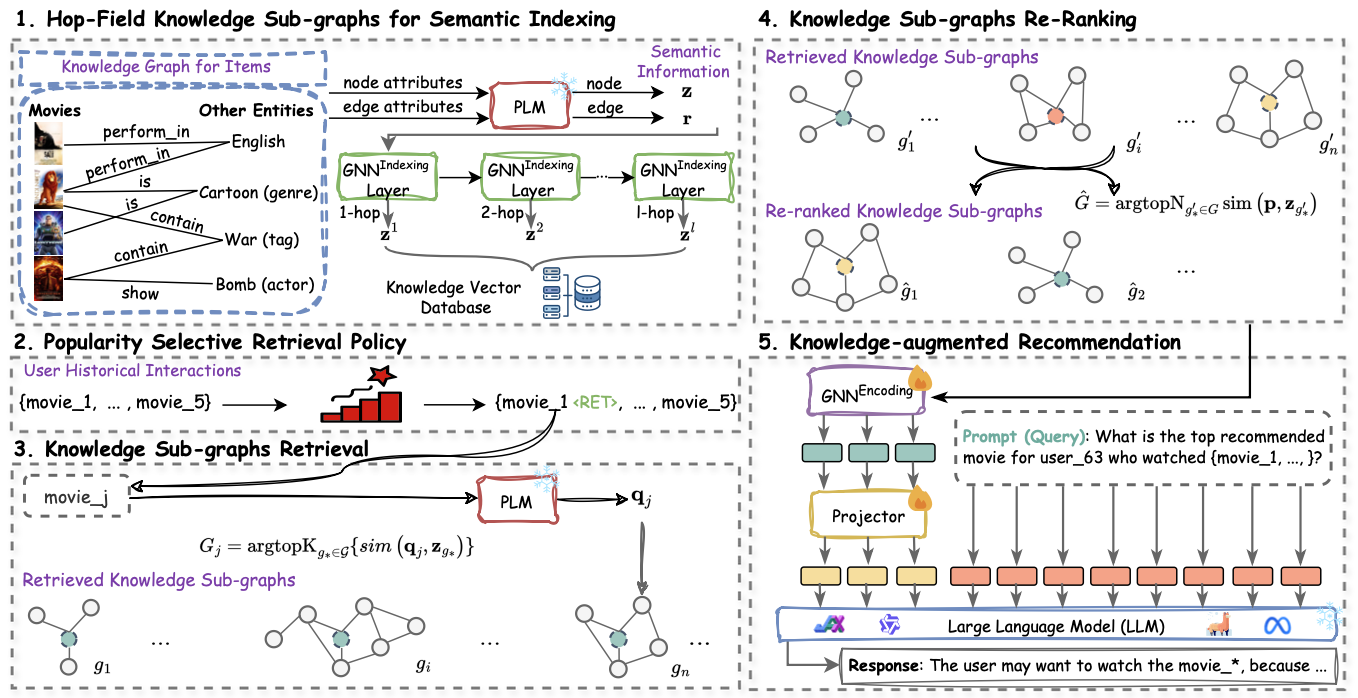

Knowledge Graph Retrieval-Augmented Generation for LLM-based Recommendation

基于LLM的推荐系统通常存在幻视和实时知识匮乏的问题,而检索增强生成(RAG)是有效的解决方法。然而,现有RAG方法所依赖的文本数据通常包含噪声,且缺乏推荐实体的结构信息。针对该问题,论文提出基于知识图谱(KG)检索增强方法K-RagRec。KG包含丰富的结构化实时事实知识,有助于提高推荐准确度。具体而言,K-RagRec首先基于语义信息和图卷积,将知识图谱以子图为单位编入向量数据库;然后,K-RagRec设计基于流行度的选择检索策略,确定用户购买历史中需要检索增强的物品;最后,K-RagRec重排检索所得子图,设计图卷积网络对子图编码,并将编码结果融入模板,输入LLM实现推荐。

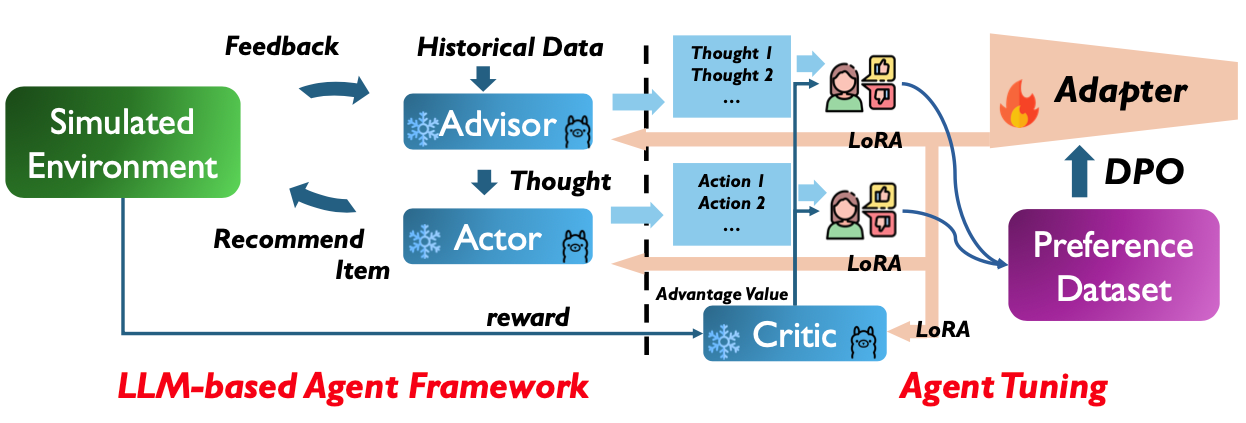

Tunable LLM-based Proactive Recommendation Agent

传统推荐系统注重识别用户兴趣,通常导致极端推荐结果分布,长此以往将加剧过滤气泡效应,影响推荐系统的长期生态健康。针对该问题,论文提出一种基于LLM的可微调主动推荐代理(T-PRA)。T-PRA根据用户反馈实时调整推荐策略,并基于长期奖励优化推荐策略。首先,T-PRA设计基于LLM的代理,包含负责实时推荐的Actor和负责深度推理以辅助Actor的Advisor。为实现推荐策略的优化,T-PRA设计Critic从长期角度实时评估推荐质量,采用DPO技术优化Actor和Advisor。

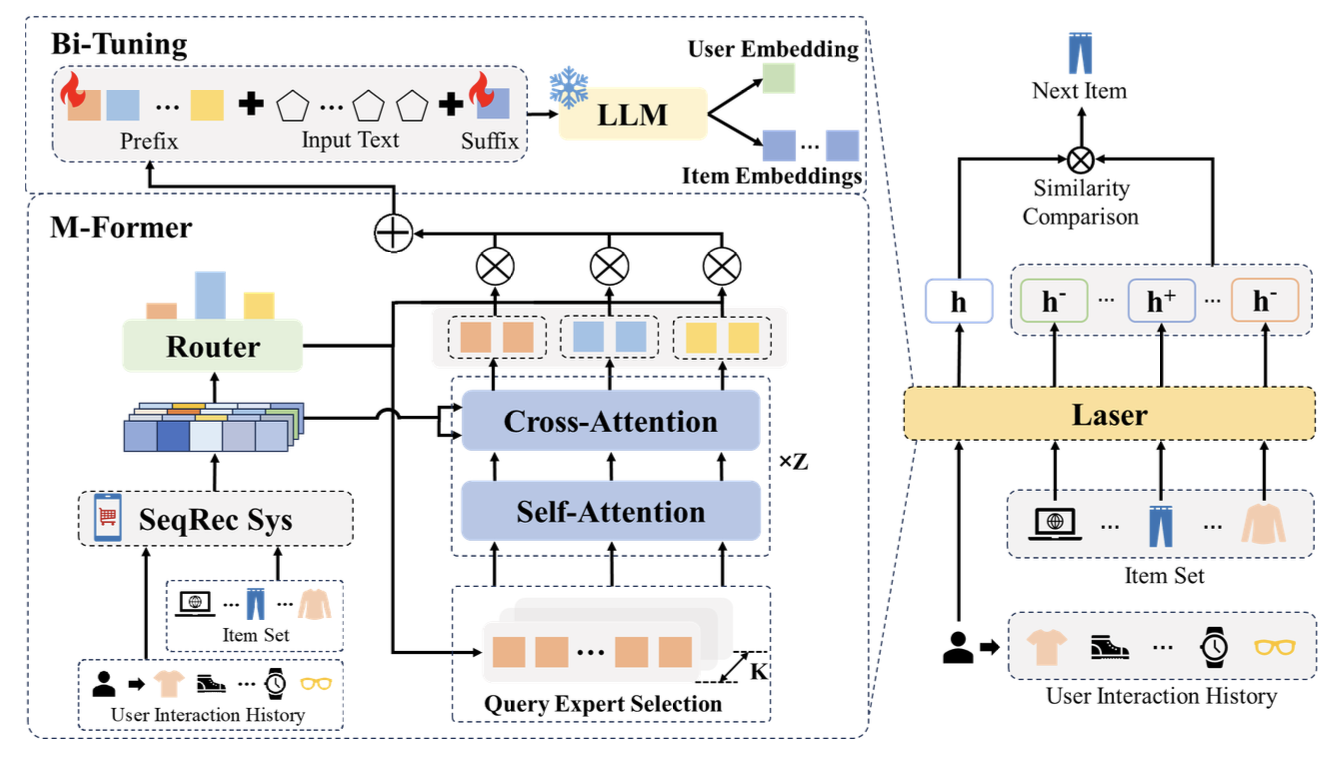

Bi-Tuning with Collaborative Information for Controllable LLM-based Sequential Recommendation

现有基于LLM的生成序列推荐方法面临协同知识缺失和生成过程不可控的问题。针对该问题,论文提出一种基于两头微调的可控序列推荐方法(Laser)。其中,两头微调指在LLM输入模板的头部和尾部分别插入可微调的虚拟token。头部token基于多专家模块,或编码用户历史交互序列协同信息生成用户embedding,或径直编码商品embedding。尾部token则将LLM输出转换到推荐空间,使得用户和商品embedding可用于相似度计算,实现可控生成式推荐。

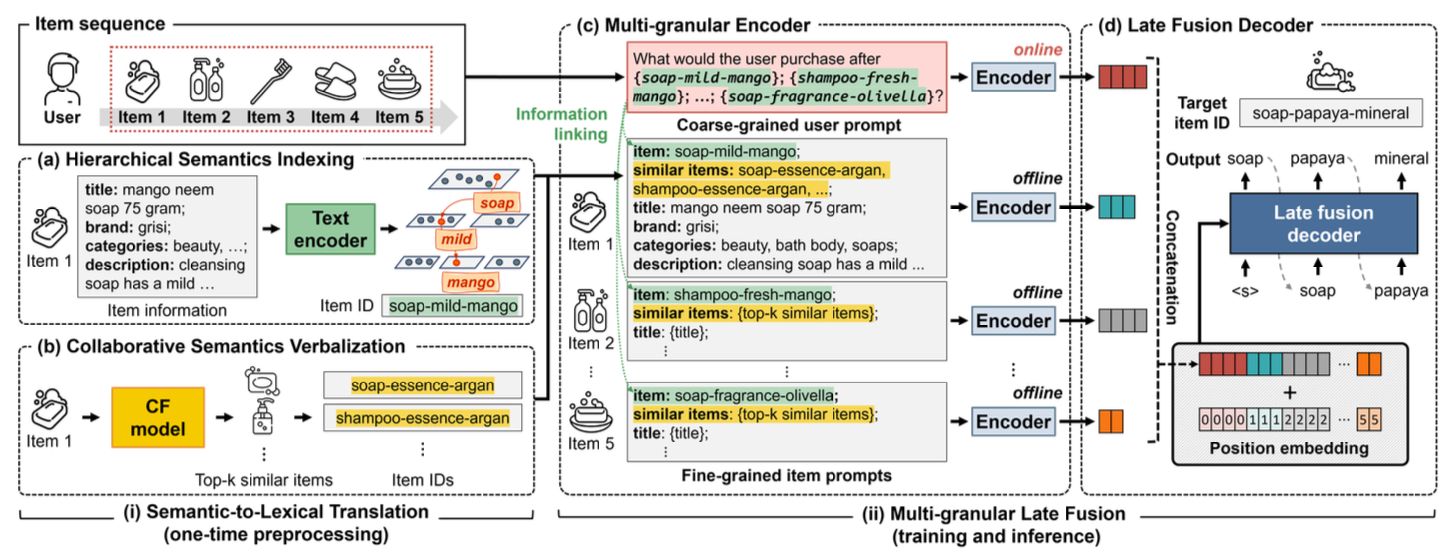

GRAM: Generative Recommendation via Semantic-aware Multi-granular Late Fusion

现有生成式推荐方法面临两个挑战:(1)商品关系建模不足;(2)输入文本序列过长。对此,论文提出基于语义感知与多粒度后融合的生成式推荐框架(GRAM)。针对第一个挑战,GRAM设计语义-词汇转换方法,将商品的层次语义信息和协同语义信息转换为LLM可理解的文本。具体而言,语义-词汇转换方法首先基于商品文本信息对商品层次聚类,随后计算簇的代表性单词以标识商品。该标识符即捕捉商品关系信息(同簇商品共享同标识),又实现商品与LLM空间的兼容(标识符均由LLM可理解的单词组成)。与此同时,语义-词汇转换方法基于传统协同过滤方法,抽取相似商品的文本标识符,实现协同语义信息的捕捉。针对第二个挑战,论文提出多粒度后融合方法,对于用户历史交互信息和商品信息分别设计粗细粒度prompt,并行输入不同编码器编码,从而降低输入文本序列的长度。该方法将编码向量拼接后输入解码器实现推荐商品生成。

小结

生成式推荐方法有以下几个问题值得关注:(1)商品结构信息的捕捉;(2)LLM计算成本的降低;(3)过滤气泡效应的避免。

5532

5532

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?