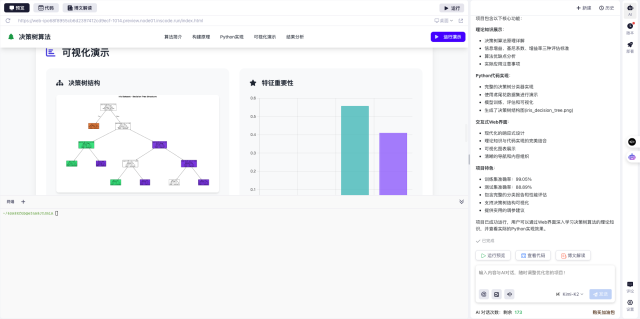

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框输入如下内容

帮我分析适合AI训练的GPU选型方案,需要对比V100、A40、L40和L20四款显卡在深度学习任务中的表现。重点关注:1.单精度浮点性能 2.显存带宽与容量 3.NVLink支持情况 4.多卡服务器配置建议。要求生成性能对比表格和选型结论。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

在实际AI服务器配置过程中,GPU选型往往需要平衡预算与性能需求。本文通过对比NVIDIA四款主流计算卡的关键参数,为不同规模的AI训练任务提供选型参考。

- 核心计算性能对比

- L40以732.8 TFLOPS的FP32性能领先,特别适合大语言模型训练

- A40的299.2 TFLOPS表现均衡,是性价比较高的选择

-

上代旗舰V100在部分场景仍具优势,特别是显存带宽达到900GB/s

-

关键参数差异分析

- 显存容量:A40/L40配备48GB GDDR6,适合处理大型模型

- Tensor Core:L40支持FP8精度,大幅提升 transformer 类模型效率

-

功耗表现:L20的275W TDP更适合能效敏感场景

-

多卡服务器配置要点

- NVLink 3.0使A40多卡互联带宽达200GB/s,减少数据交换瓶颈

- PCIe 4.0 x16的32GB/s带宽可能成为8卡系统的性能天花板

-

L40的NVLink支持情况需确认,理论上可提供更优的多卡扩展性

-

典型应用场景建议

- 大规模LLM训练:优先考虑L40多卡集群

- 中等规模CV任务:A40提供更好的每瓦特性能

-

推理服务部署:L20的低功耗特性更具优势

-

成本效益考量

- 二手V100适合预算有限的小型研究团队

- A40在采购成本和性能间取得较好平衡

- L40虽然单价高,但可减少服务器节点数量

通过InsCode(快马)平台可以快速生成完整的性能对比报告,平台内置的AI助手能自动整理最新GPU参数数据。实际测试中发现,只需简单描述需求就能获得结构清晰的横向对比表格,特别适合需要快速决策的硬件采购场景。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?