人们眼中的天才之所以卓越非凡,并非天资超人一等而是付出了持续不断的努力。1万小时的锤炼是任何人从平凡变成超凡的必要条件。———— 马尔科姆·格拉德威尔

华为云Flexus+DeepSeek征文 | “开箱即用”体验报告:DeepSeek-V3/R1 商用服务初探

目录

二、开通实录:5分钟搞定DeepSeek-V3/R1商用服务

一、前言:为何选择华为云DeepSeek商用服务?

1.1 快速接入:分钟级开箱即用

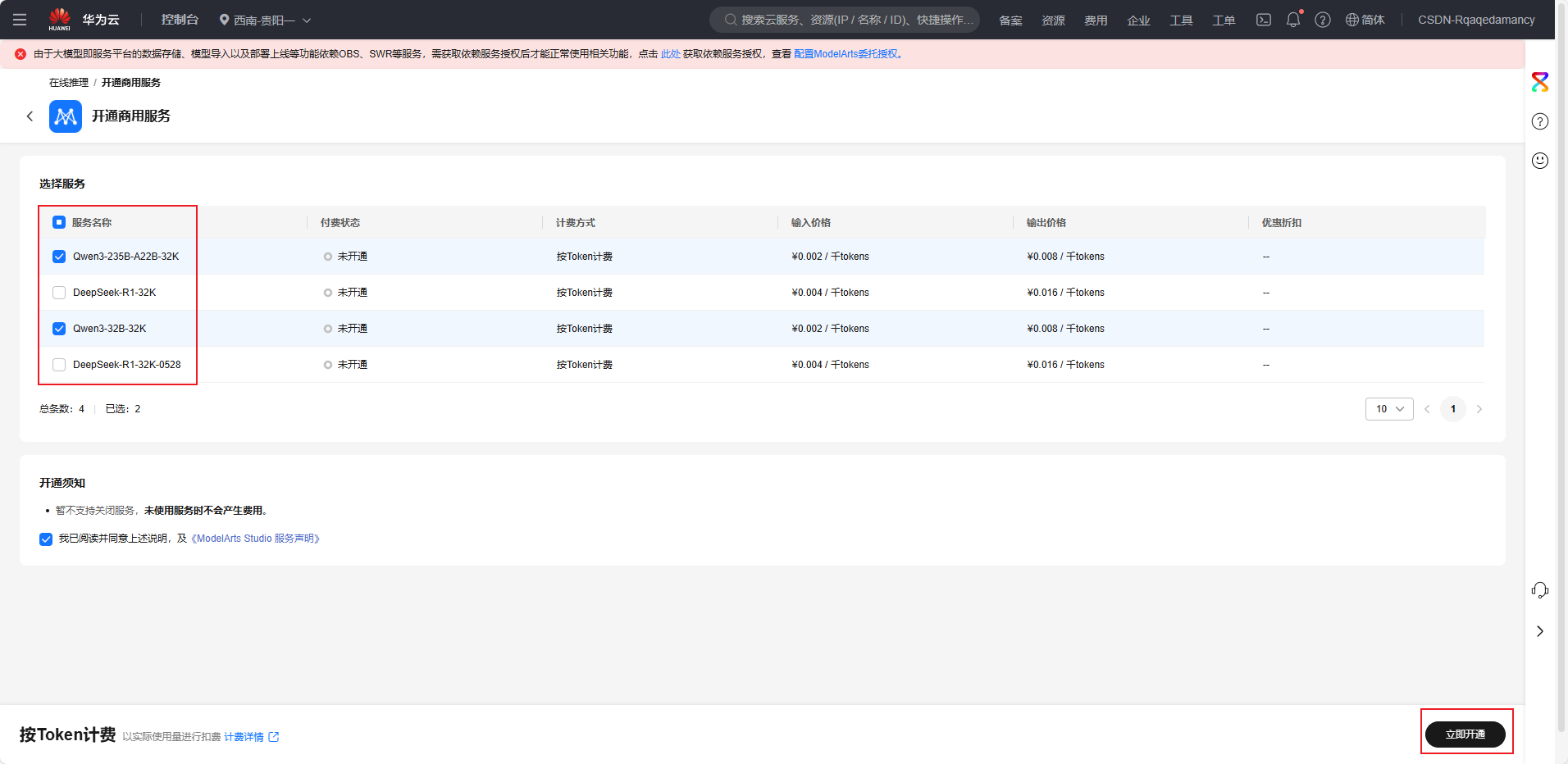

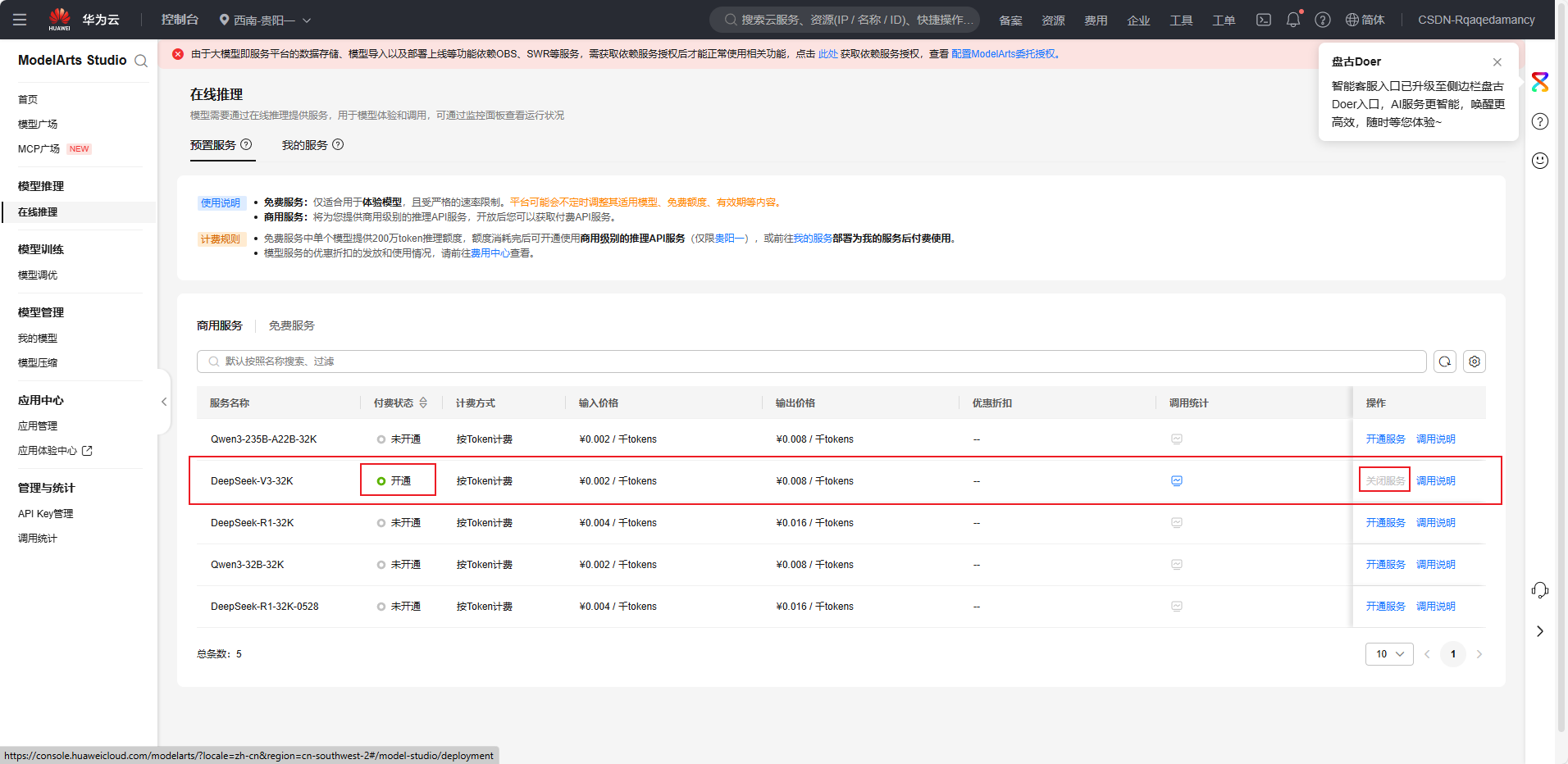

- 零配置部署:通过华为云ModelArts Studio平台,开发者无需关注底层算力调度或环境配置,仅需“登录控制台→服务授权→点击开通”三步操作,即可启用DeepSeek-V3/R1商用服务,全程耗时不超过3分钟。

- 登录控制台

- 服务授权

- 开通服务

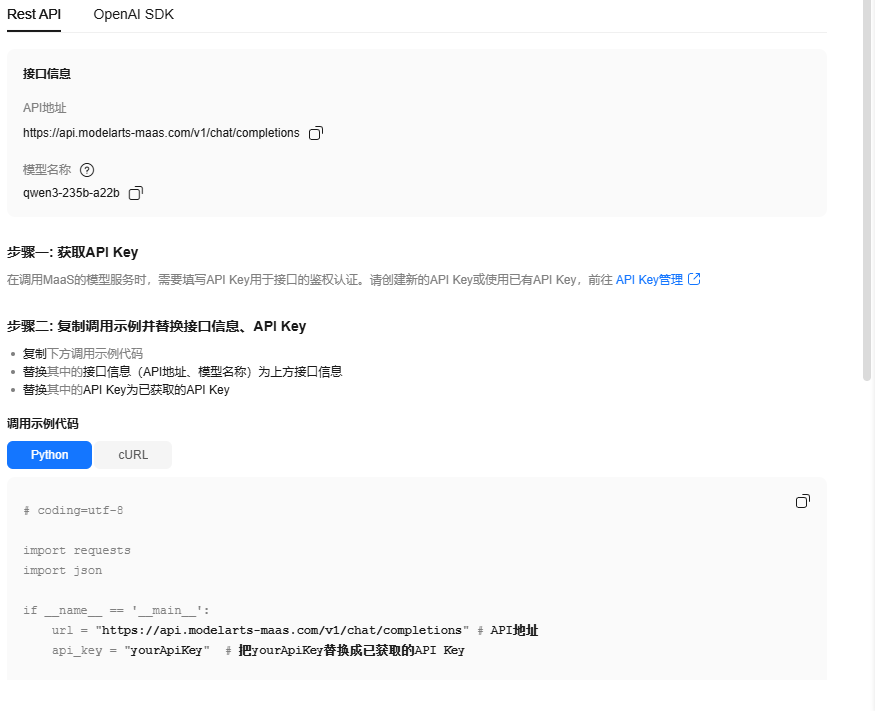

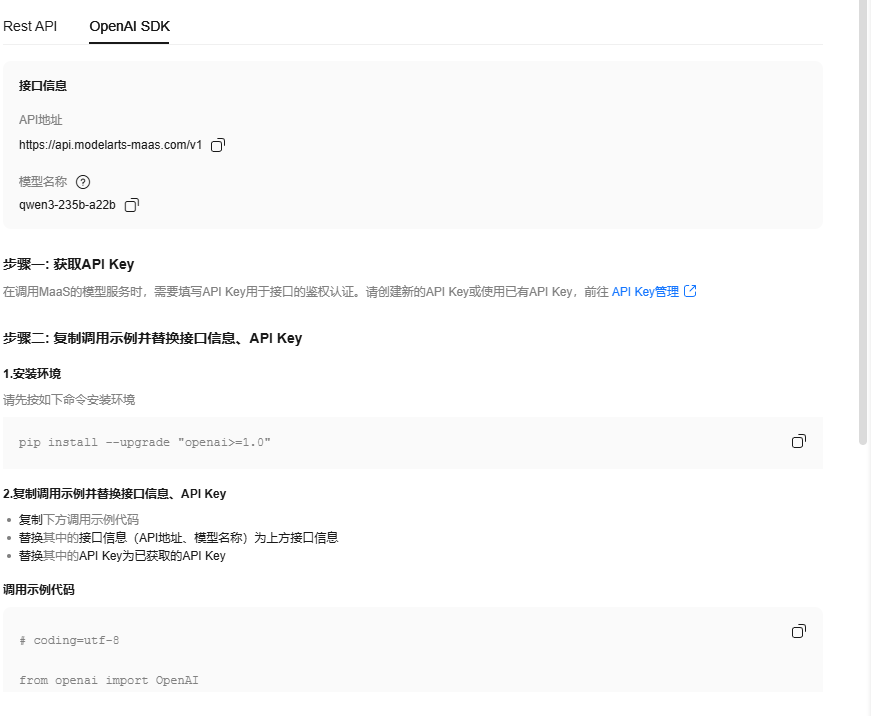

- 准化API集成:提供兼容OpenAI格式的RESTful API及SDK,支持Python/Java等主流语言,开发者可直接嵌入现有业务系统,降低集成成本。

- RESTful API调用

示例代码:

# coding=utf-8 import requests import json if __name__ == '__main__': url = "https://api.modelarts-maas.com/v1/chat/completions" # API地址 api_key = "yourApiKey" # 把yourApiKey替换成已获取的API Key # Send request. headers = { 'Content-Type': 'application/json', 'Authorization': f'Bearer {api_key}' } data = { "model":"qwen3-235b-a22b", # 模型名称 "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "你好"} ], # 是否开启流式推理, 默认为False, 表示不开启流式推理 "stream": True, # 在流式输出时是否展示使用的token数目。只有当stream为True时改参数才会生效。 # "stream_options": { "include_usage": True }, # 控制采样随机性的浮点数,值较低时模型更具确定性,值较高时模型更具创造性。"0"表示贪婪取样。默认为0.6。 "temperature": 0.6 } response = requests.post(url, headers=headers, data=json.dumps(data), verify=False) # Print result. print(response.status_code) print(response.text) - SDK调用

示例代码:

# coding=utf-8 from openai import OpenAI base_url = "https://api.modelarts-maas.com/v1" # API地址 api_key = "yourApiKey" # 把yourApiKey替换成已获取的API Key client = OpenAI(api_key=api_key, base_url=base_url) response = client.chat.completions.create( model = "qwen3-235b-a22b", # 模型名称 messages = [ {"role": "system", "content": "You are a helpful assistant"}, {"role": "user", "content": "你好"}, ], temperature = 1, stream = True ) print(response.choices[0].message.content)

1.2 稳定推理:企业级高可用保障

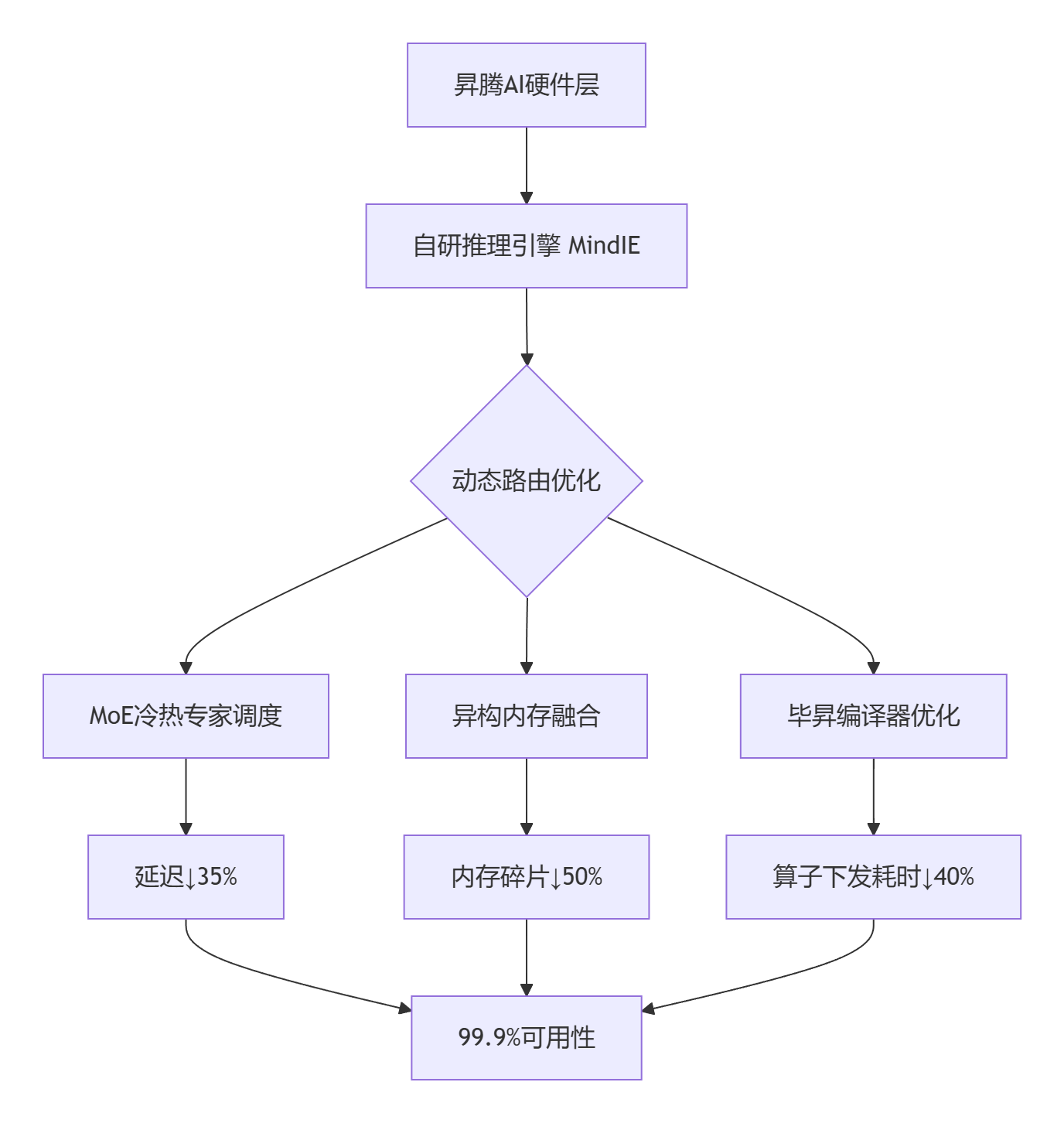

- 昇腾云服务全栈优化:基于昇腾AI硬件与自研推理引擎,实现99.9%服务可用性与300ms内响应延迟,显著优于开源部署方案。

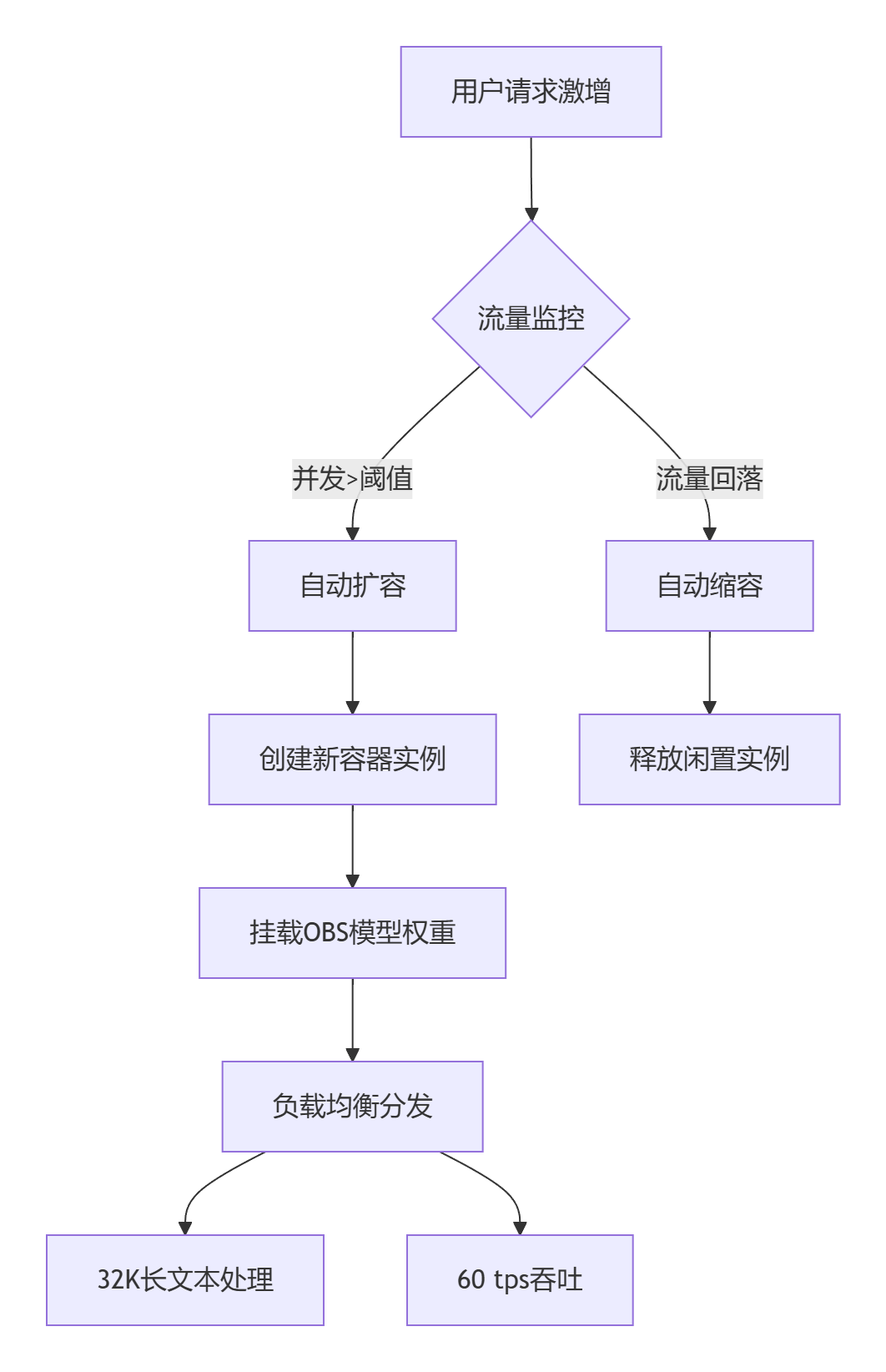

- 弹性扩缩容:支持突发流量自动扩容,单实例支持32K长文本处理,并发请求吞吐量达60 tps(Tokens per Second),满足高负载场景需求。

1.3 企业级支持:全生命周期服务

- SLA保障与运维监控:提供7×24小时运维支持、实时调用日志分析及异

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1457

1457