1. 概述

最近拿到了OrangePiAIPro开发板,评测下资源、可用性和性能。

OrangePiAIPro开发板是香橙派联合华为精心打造的高性能AI开发板,其搭载了昇腾AI处理器,可提供8TOPS INT8的计算能力,内存提供了8GB和16GB 两种版本。可以实现图像、视频等多种数据分析与推理计算,可广泛用于教育、机 器人、无人机等场景。

2. 开箱

2.1 开箱图

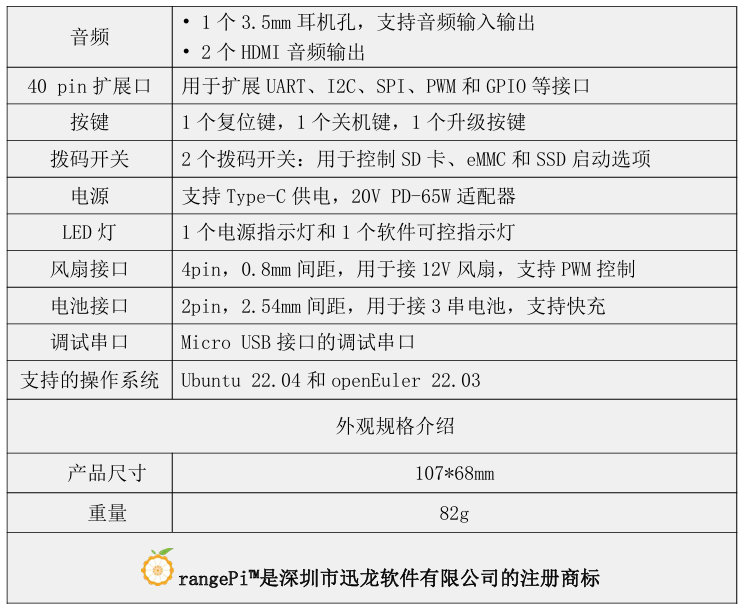

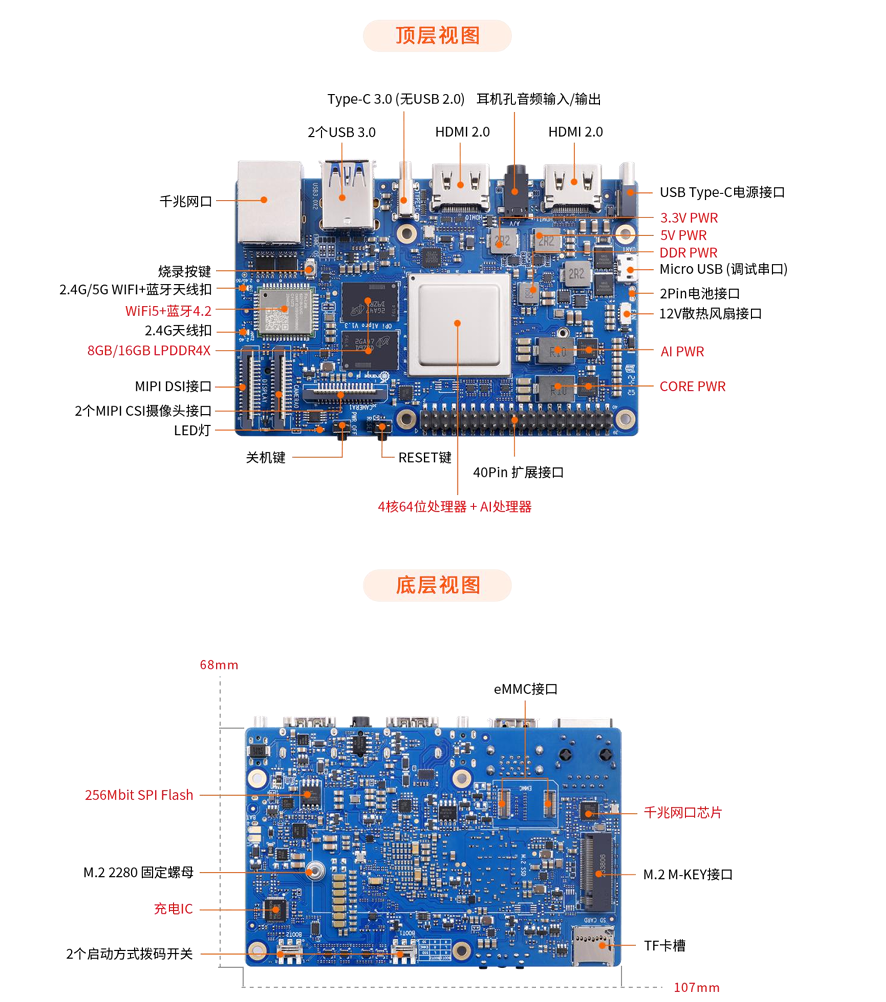

2.2 概述(包含资源情况)

资源比较多,像MIPI接口、WIFI、以太网、蓝牙、显示、音频输入输出都有,性能也比较强劲,可以做很多事情了。

2.3 接口详情

3. 环境搭建

3.1 资源下载

下载链接:[Orange Pi - Orangepi](Orange Pi - Orangepi)

如果不重新编译KDR,可以不用下载官方镜像。

3.2 工具准备

- 设备

- OrangePi AIPro开发板一台

- MicroUSB线一根

- 开发板自带电源一个

- 开发板自带32G TF卡一张

- 软件

- Windterm终端软件

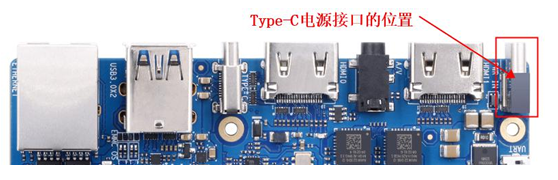

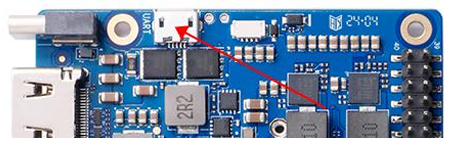

3.2 设备连接及启动设置

-

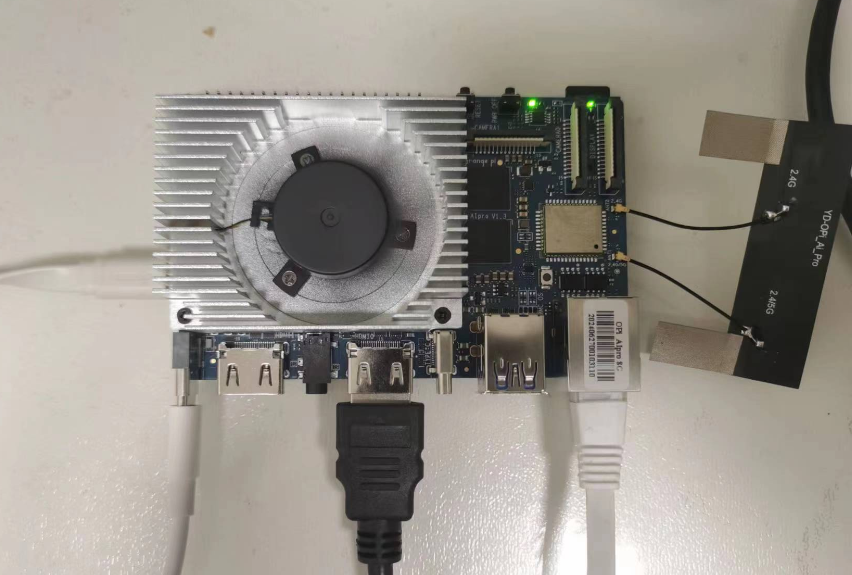

接线图

-

电源连接

-

MicroUSB串口线连接至电脑

-

-

启动配置

官方自带了32G的TF卡,BOOT1和BOOT2拨动到右侧即可。

3.3 开机

开机后,可以在串口看到启动信息

ep/rc mode: 0

Enable wdg.

#1

Pll Init ..pll[0] inited

pll[2] inited

pll[3] inited

pll[4] inited

pll[5] inited

OK.

....

[ OK ] Started Command Scheduler.

Starting Light Display Manager...

Starting Hold until boot process finishes up...

Starting Hostname Service...

[ OK ] Started OpenSSH server daemon.

[ OK ] Created slice User Slice of UID 0.

Starting User Runtime Directory /run/user/0...

[ OK ] Finished User Runtime Directory /run/user/0.

Starting User Manager for UID 0...

openEuler 22.03 LTS dracut-055-4.oe2203 (Initramfs)

Kernel 5.10.0+ on an aarch64

orangepiaipro login:

- 账号密码:

root Mind@123 或 HwHiAiUser Mind@123

3.4 网络配置

开发板支持以太网和WIFI两种网络连接方式,这里因为连接有线不太方便,就直接使用WIFI连接了。

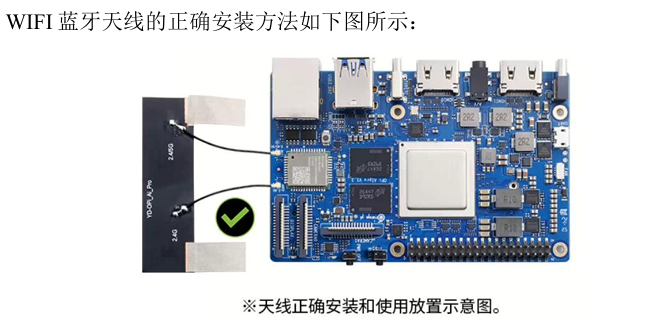

WIFI的天线安装如下图(不可以粘贴到开发板背面,防止短路):

# 扫描可用的wifi热点

(base) HwHiAiUser@orangepiaipro:~$ nmcli dev wifi

[sudo] password for HwHiAiUser:

IN-USE BSSID SSID MODE CHAN RATE SIGNAL BARS SECURITY

D8:3D:CC:1A:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3081

3081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?