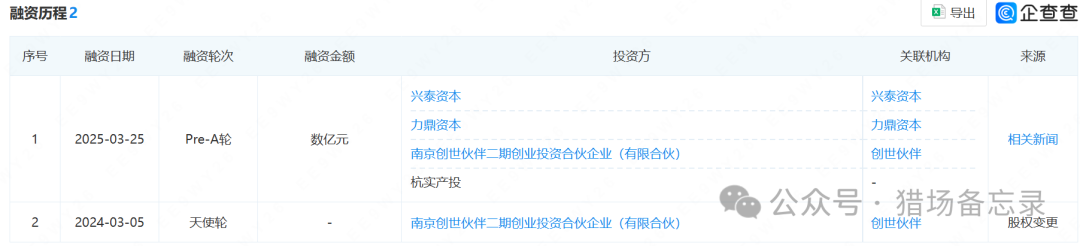

国内领先通用具身智能公司【ELU.AI】完成数亿元Pre-A轮融资!

2025年3月25日,通用具身智能技术研发公司[ELU.AI](原力无限机器人)宣布完成数亿元Pre-A轮融资,投资方包括力鼎资本、杭实产投、兴泰资本等,老股东创世伙伴创投追投。

至此,公司累计完成两轮融资,曾于2024年3月5日获创世伙伴创独投天使轮融资;随着最新一轮融资完成,将进一步巩固ELU.AI在具身智能、AI Agent和机器人大脑的核心竞争力;据官方介绍,本轮融资资金将重点用于三大方向:强化AI决策系统、推进下一代智能机器人研发和加速全球市场布局。

随着新一轮融资敲定,ELU.AI正式宣布品牌升级,作为全球领先的人工智能科技集团,ELU.AI聚焦AI智能机器人、行业AI Agent和类脑智能三大核心领域,旗下包括原力无限(INFIFORCE)、原力光年(LIGHTFORCE)、原力万象(UNIFORCE)三大子品牌,分别专注于智能机器人、行业AI应用和机器人大脑,构建全球领先的具身智能生态体系。

ELU.AI品牌全面升级

ELU.AI由阿里巴巴前副总裁白惠源博士创立,她在人工智能、互联网、云计算等领域深耕多年,兼具深厚的技术研发能力与丰富的产业落地经验。作为一位极具科学家特质的企业家,在创立ELU.AI前已经拥有极其成功的创业经验,她提出“AI Agent EPOCH进化论”,系统性描绘了AI从涌现(Emergent)到和谐(Harmonious)的演进路径,并推动具身智能在多个核心行业的深度落地。

ELU.AI的核心团队汇聚全球顶尖AI科学家,硕博比例高达70%,成员来自清华、浙大、北航、哈工大、斯坦福等顶尖学府,并曾就职于阿里巴巴、华为、百度、腾讯、吉利、蔚来等科技巨头。团队在计算机视觉、深度学习、多模态大模型、机器人控制系统、VLA等前沿领域积累深厚,已申请核心技术专利100余项,构建了坚实的技术壁垒。

ELU.AI的技术实力已在实战中验证:自主研发的分布式多Agent协同决策系统响应速度提升87%,神经符号混合推理引擎在不确定环境下的适应能力超行业平均3倍。依托完整的全栈技术体系,ELU.AI构建软硬一体的具身智能架构,让AI智能体具备更强的感知、决策与执行能力,实现从数字世界到物理世界的深度融合,加速AI全面落地。

“AI+机器人+Agent”的具身智能生态系统

公司介绍:

[ELU.AI](原力无限机器人)于2023年8月16日杭州注册成立,公司以具身智能为核心,聚焦AI智能机器人、行业AI Agent和类脑智能三大核心领域,旗下包括原力无限(INFIFORCE)、原力光年(LIGHTFORCE)、原力万象(UNIFORCE)三大子品牌,分别专注于智能机器人、行业AI应用和机器人大脑;其中,原力无限是技术与商业化落地的关键支点,而原力光年和原力万象则分别赋能具身智能的行业应用和大脑,共同构建完整的AI智能生态体系。

三大核心业务并驾齐驱,具身智能生态加速成型:

原力无限(INFIFORCE):领先的具身智能机器人品牌,依托“一脑多身”全栈自研技术,实现AI在物理世界的感知—决策—执行闭环。

“一脑多身”具身智能产品矩阵

2024年10月,公司发布全球首创的智能全自动充电机器人FORCE-01,打通“自动驾驶、自动泊车、自动充电”全链路,推动自动驾驶商业化进程;当前,已在北京、广州等核心城市落地,服务于千家万户,与中石化、中国铁塔、万达集团、恒源能源等头部企业达成战略合作,同时已与国电投、国家能源、浙江能源、浙江省交投、山东高速、宁波城投等多家达成战略合作意向,并累计签约近亿元商业订单,展现了从技术突破到商业落地的强大转化能力。

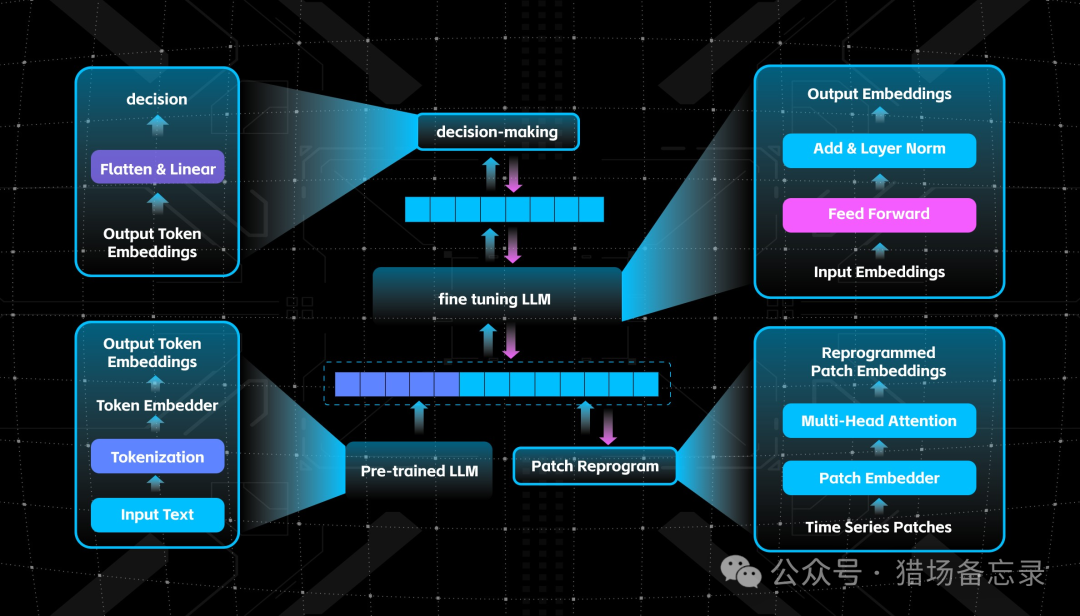

原力光年:基于具身智能的行业应用需求,打造行业AI大模型,已在电力调度等领域落地,可提升电网调度效率32%,缩短故障响应时间47%。

原力光年全栈自研行业大模型架构

原力万象:作为AI决策系统,集成了神经符号推理、因果推断、元学习等前沿技术,为具身智能提供更强的认知和自主决策能力,从而助力工业自动化、智能物流、智慧医疗等多种场景的落地。

ELU.AI创始人白惠源(博士)曾在TEDx2025的演讲中提到:“AI真正的价值在于与物理世界的深度融合,具身智能的崛起是AI从“云端”到“大地”的觉醒。原力无限的使命,是打造「会思考、善学习的机器人」,让具身智能不仅具备认知能力,更能通过具身智能实现自主行动、自我学习和自然交流,从而彻底改变智能体的存在形式,为人机共生的未来奠定基石。”

小编往期文章有提到大模型决定了人形机器人泛化能力,是现阶段人形机器人商业化核心壁垒;区别于其他具身智能机器人企业,[ELU.AI]在AI智能机器人、行业AI Agent和类脑智能三大领域全面布局,构建全球最强的具身智能基础设施;旗下具身智能机器人品牌原力无限(INFIFORCE)依托“一脑多身”全栈自研技术,已累计签约近亿元商业订单。

... ... ...

[ELU.AI]是具身智能大模型领域代表企业之一,接下里小编继续盘点具身智能大模型领域,全球初创公司(PI、Skild AI、Covariant、穹彻智能、若愚科技、X Square等)介绍及产品进展、全球科技巨头/大厂(谷歌、英伟达、微软、OpenAI、华为、阿里、腾讯、字节等)现阶段产品进展、人形机机器人本体厂家与科技巨头/大厂合作现状以及科技巨头入局人形机器人本体赛道现状。

... ... ...

本文内容仅展示一部分,更多详细解读,加入知识星球“机器人头条”,查看完整版文章:[原创]具身智能大模型赛道:科技巨头技术进展、初创公司盘点,第一款“机器人通用大脑”花落谁家(文字6W+),并深度了解“具身智能&人形机器人”赛道

1293

1293

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?