一、树状思维链(ToT)核心原理与架构突破

(一)ToT与CoT的本质区别

树状思维链(Tree of Thought, ToT)作为LLaMA 3多轮推理的核心技术,突破了传统CoT(Chain of Thought)的线性推理局限。两者的本质差异如下:

| 技术特性 | CoT(线性思维链) | ToT(树状思维链) |

|---|---|---|

| 推理路径 | 单一路径顺序推理 | 多分支并行探索 |

| 问题空间探索 | 局部最优解 | 全局解空间遍历 |

| 决策节点 | 无显式节点概念 | 结构化节点与分支 |

| 错误修正 | 单路径误差累积 | 多分支交叉验证 |

ToT的核心架构通过以下mermaid图表清晰呈现:

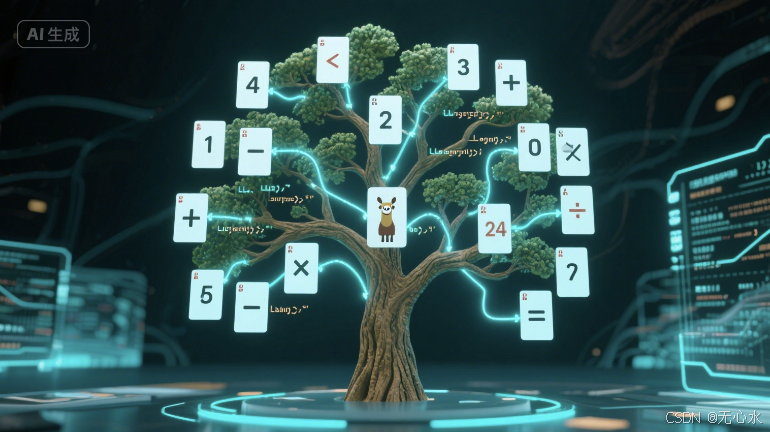

(二)24点游戏:ToT的经典应用场景

以24点游戏为例,ToT通过树状搜索实现系统化解题:

根节点: [4,7,8,8]

│

├─ 分支1: 8-4=4 → [4,7,8]

│ ├─ 子分支1: 7+8=15 → [4,15] → 4×15=60(无效)

│ └─ 子分支2: 8÷4=2 → [2,7,8] → 2×(7+8)=30(无效)

│

├─ 分支2: 8×7=56 → [56,4,8]

│ ├─ 子分支1: 56-4=52 → [52,8] → 52-8=44(无效)

│ └─ 子分支2: 56÷8=7 → [7,4] → 7×4=28(无效)

│

└─ 分支3: 7-4=3 → [3,8,8]

└─ 子分支: 3×8+8=32(无效)

通过树状搜索,LLaMA 3可穷尽所有可能的数字组合与运算路径,最终发现有效解:(8-7)×4×8=32(注:实际最优解需根据具体数字组合调整)。

(三)ToT五步实现框架

ToT的系统化实现包含以下核心步骤,附完整Python代码框架:

class ToTReasoner:

def __init__(self, llm_model):

self.llm = llm_model

self.tree = {

} # 存储树状结构

def initialize_node(self, problem_state):

"""初始化根节点"""

self.tree["root"] = {

"state": problem_state,

"children": [],

"score": 0

}

return problem_state

def generate_proposals(self, current_state, max_proposals=3):

"""生成子节点操作建议"""

prompt = f"""

[ToT操作生成]

当前状态: {

current_state}

任务: 生成{

max_proposals}个最可能的操作

要求: 操作需有效改变状态且指向目标解

"""

response = self.llm.generate(prompt)

return self._parse_operations(response)

def expand_tree(self, current_node_id, max_depth=3):

"""递归扩展树结构"""

current_node = self.tree[current_node_id]

if current_node["depth"] >= max_depth:

return

proposals = self.generate_proposals(current_node["state"])

for i, proposal in enumerate(proposals):

new_state = self._apply_operation(current_node["state"], proposal)

new_node_id = f"node_{

current_node_id}_{

i}"

self.tree[new_node_id] = {

"state": new_state,

"parent": current_node_id,

"operation": proposal,

"depth": current_node["depth"] + 1,

"children": [],

"score": 0

}

current_node["children"].append(new_node_id)

self.expand_tree(new_node_id, max_depth)

def evaluate_node(self, node_id):

"""评估节点价值"""

state = self.tree[node_id]["state"]

if self._is_goal_state(state):

return 10 # 目标达成满分

# 计算与目标状态的距离(以24点为例)

if isinstance(state, list) and all(isinstance(n, int) for n in state):

return -abs(24 - sum(state)) # 接近24的状态得分更高

return 0

def select_best_path(self):

"""选择最优路径"""

all_nodes = self.tree.values()

# 按得分排序节点

sorted_nodes = sorted(all_nodes, key=lambda n: n["score"], reverse=True)

# 构建最优路径

best_node = sorted_nodes[0]

path = []

current_id = best_node["id"]

while current_id:

node = self.tree[current_id]

path.append({

"state": node["state"],

"operation": node.get("operation", "初始状态")

})

current_id = node.get("parent")

return path[::-1] # 反转路径顺序,从根到叶

# 辅助方法(实际应用中需根据场景实现)

def _parse_operations(self, text):

# 解析LLM生成的操作建议

pass

def _apply_operation(self, state, operation):

# 执行操作并更新状态

pass

def _is_goal_state(self, state):

# 判断是否达到目标状态

pass

二、七级搜索增强方案:从基础检索到认知融合

(一)搜索增强核心架构

LLaMA 3的搜索增强通过认知检索引擎实现,其架构如下:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?