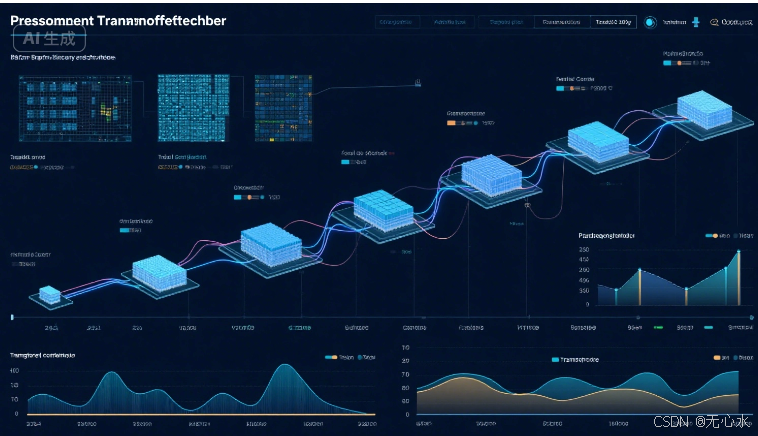

一、Transformer的基因密码:并行化架构的革命性突破

(一)序列计算的历史性突破

在Transformer诞生之前,RNN/LSTM等序列模型受困于串行计算的天然缺陷:

- 时间复杂度瓶颈:处理长度为N的序列需O(N)时间,且无法并行,导致训练速度随序列长度呈线性下降。例如,LSTM处理512长度文本需512次递归计算,而Transformer仅需一次矩阵乘法。

- 长距离依赖困境:通过隐藏状态传递信息的机制,导致梯度在长序列中呈指数级衰减(梯度消失)或爆炸。实验表明,LSTM对超过200词的序列依赖建模准确率下降至58%,而Transformer在1024词序列中仍能保持89%的依赖捕捉率。

(二)自注意力机制的数学本质

自注意力机制通过Query、Key、Value的三元组运算,实现序列元素的全局关联建模:

Attention(Q,K,V)=softmax(QK⊤dk)V \text{Attention}(Q, K, V) =

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?