Talk主页:http://qingkeai.online/

首发:https://mp.weixin.qq.com/s/zCoVTi7lCMjVycUugu2NxA

发展更为通用的智能技术是下一代人工智能的重要突破口,学习一个可以广泛应用于各种模态和各种任务的通用感知模型是发展更为通用的智能技术的重要步骤。

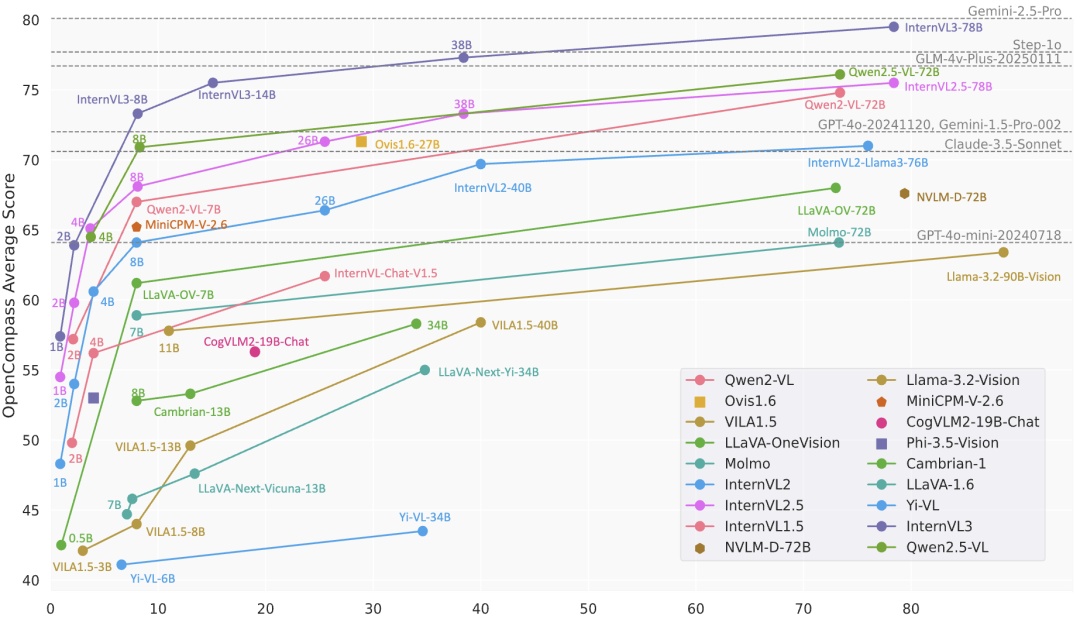

InternVL3 是 OpenGVLab 开源的一款先进的多模态大型语言模型 (MLLM) 系列。与 InternVL 2.5 相比,InternVL3 展现出卓越的多模态感知和推理能力,同时进一步扩展了其多模态能力,涵盖工具使用、GUI 代理、工业图像分析、3D 视觉感知等。

香港中文大学博士后、上海人工智能实验室青年科学家、“书生”系列视觉基础模型核心开发者王文海:最强开源多模态大模型InternVL 2.0是怎么炼成的?

InternLM/InternVL系列多模态大模型核心技术解析

此外,得益于原生多模态预训练,InternVL3 系列的整体文本性能甚至优于 Qwen2.5 系列(后者是 InternVL3 中语言组件的初始化部分)。

InternVL3 系列基于以下设计构建:

- 可变视觉位置编码:集成了 可变视觉位置编码 (V2PE) ,该编码使用更小、更灵活的位置增量来表示视觉标记。这种改进有助于处理更长的多模态上下文,而无需过度扩展位置窗口。

-

原生多模态预训练:提出了一种原生多模态预训练方法,将语言预训练和多模态对齐训练整合到一个预训练阶段。传统范式通常先训练一个仅包含语言的大型模型(通常先进行语言预训练,再进行语言后训练),然后再进行调整以适应其他模态。与此不同,InternVL3在预训练过程中通过将多模态数据(例如,图文、视频文本或交错图文序列)与大规模文本语料库进行交织,进行集成优化。这种统一的训练方案使预训练模型能够同时学习语言和多模态能力,最终增强其处理视觉-语言任务的能力,而无需引入额外的桥接模块或后续的模型间对齐程序。

-

混合偏好优化 (Mixed Preference Optimization):在预训练和 SFT 阶段,模型会根据先前的真值 token 来预测下一个 token。然而,在推理阶段,模型会根据自身先前的输出来预测每个 token。真值 token 与模型预测 token 之间的这种差异会导致分布偏移,从而削弱模型的思路链 (CoT) 推理能力。为了缓解这个问题,InternVL3 采用了 混合偏好优化 (MPO) ,它引入了来自正样本和负样本的额外监督,以使模型响应分布与真值分布对齐,从而提升推理性能。

-

使用 VisualPRM 进行测试时间缩放:测试时间缩放已被证明是增强 LLM 和 MLLM 推理能力的有效方法。在本研究中,InternVL3 采用 Best-of-N 评估策略,并使用 VisualPRM-8B 作为评估模型,以选择最佳答案进行推理和数学评估。

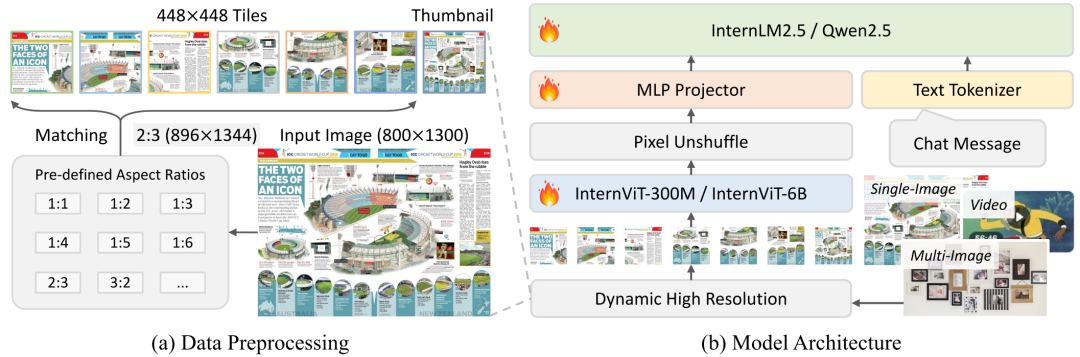

InternVL3 的架构遵循与其前代产品相同的通用框架,并遵循“ViT-MLP-LLM”范式。与上一版本一样,应用了像素反混洗操作,将视觉标记的数量减少到原来的四分之一。此外,害采用了与 InternVL 1.5 类似的动态分辨率策略,将图像划分为 448×448 像素的图块。从 InternVL 2.0 开始,关键区别在于额外引入了对多图像和视频数据的支持。

值得注意的是,在 InternVL3 中,集成了 可变视觉位置编码 (V2PE) ,它为视觉标记提供了更小、更灵活的位置增量。得益于 V2PE,InternVL3 相比其前代产品展现出更出色的长上下文理解能力。

6月21日10:00点,青稞Talk第56期,复旦大学博士生王玮赟,将直播分享《InternVL3,GPT-4o开源平替:探索多模态通用感知大模型的技术演进与应用探索》。

本期Talk旨在围绕书生·万象多模态大模型的技术演进过程来介绍多模态大模型研究的相关研究,包括多模态增量预训练/指令微调/后训练/测试时增强等技术及其中的训练算法设计,探索多模态通用感知模型的高效研发方案。

分享嘉宾

王玮赟,复旦大学在读博士生。研究方向为多模态通用感知模型、多模态大模型后训练算法,在人工智能国际顶级会议及期刊发表论文十余篇,作为核心作者(共一二作)参与研发的多模态大模型InternVL-Chat系列模型在HuggingFace社区累计下载量突破1000万次,开源代码在Github获得stars超过8000个。

主题提纲

InternVL3,GPT-4o开源平替:多模态通用感知大模型的技术演进与应用探索

1、多模态大模型的介绍及实现路径

2、InternVL 核心技术解析

- 多模态增量预训练/指令微调

- 后训练/测试时增强

3、训练算法设计及应用实践

直播时间

6月21日10:00 - 11:00

往期推荐

张祥雨访谈精华版:多模态大模型研究的挣扎史和未来

从幻觉到o1-reasoning!万字长文总结多模态大模型后训练

深入解析多模态大模型的主要技术和最新发展

多模态大模型MLLM的架构发展及思考

557

557