梦晨 西风 发自 凹非寺

量子位 | 公众号 QbitAI

斯坦福最新“技能转移”大法,让人类沦为给机器人提供训练数据的工具人。

小哥拿上机械手做示范,机器人就能从收集到的数据中学会刷碗,并且能随机应变。

打开水龙头、抓取盘子、用百洁布清洗一气呵成,外界干扰使坏也不怕。

整套系统从硬件到代码完全开源,成本只需400美元,就可以在没有机器人的情况下收集训练机器人所需数据。

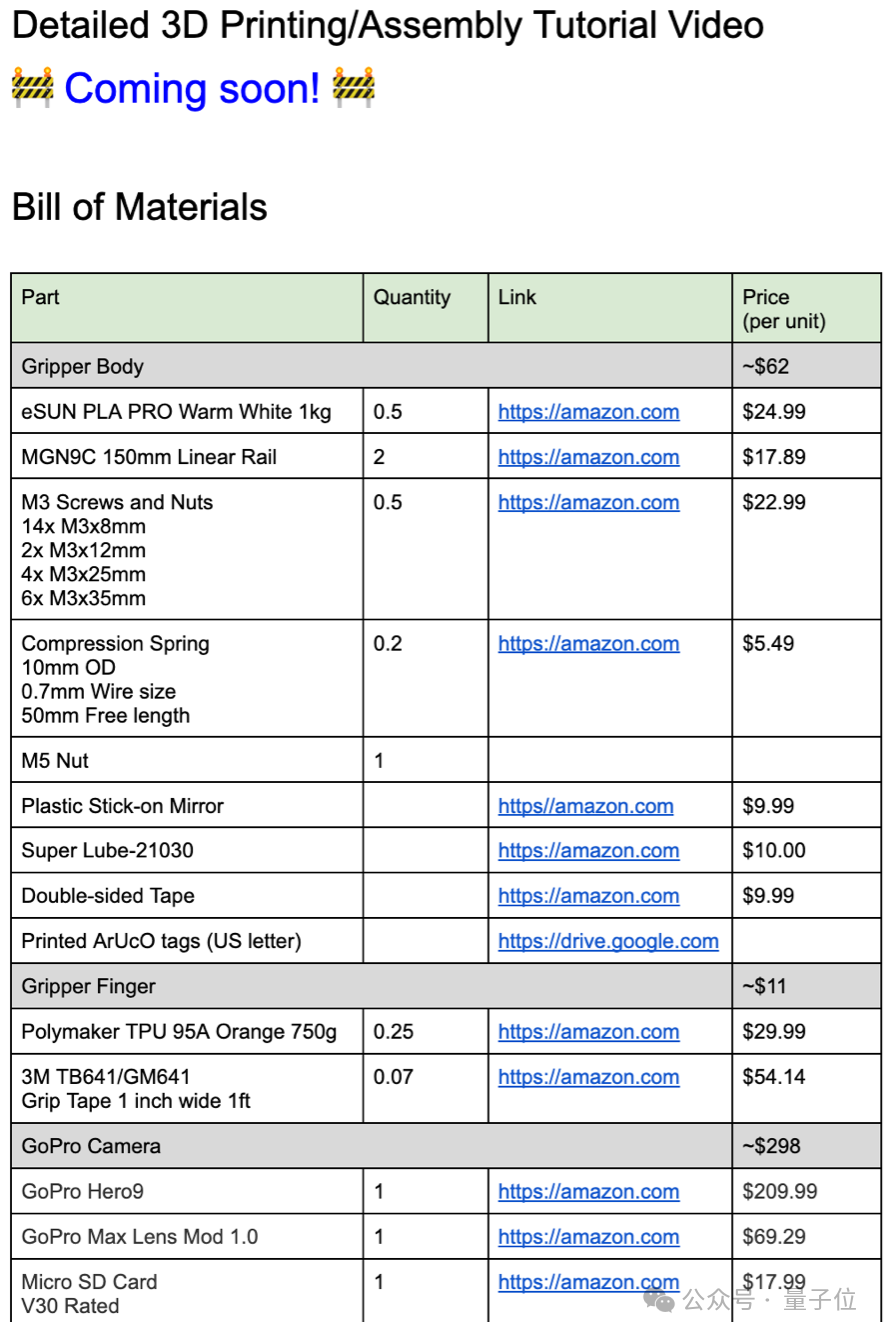

更详细的3D打印、组装教程视频也即将发布。

要知道,在这项工作之前要想大规模训练机器人be like:

对此,李飞飞团队具身智能成果VoxPoser一作黄文龙表示:惊人的工作,破解了机器人数据收集中的先有鸡先有蛋难题。

有网友觉得,这项工作和之前爆火的斯坦福家务机器人ALOHA等工作同样令人印象深刻。

实际上,都是来自斯坦福大学的两个团队,已经在实验室里带着各自的机器人对练碰拳、握手了。

破解数据的先有鸡先有蛋难题

新方法收集数据的秘密,就藏在这对手持夹持器里。

左右手各一个300美元的Go Pro摄像头,搭配一面镜子就能得到隐式立体信息,大大节省成本和重量。

再加上内置的惯性传感器,联合优化视觉跟踪和惯性姿态。

录好的第一视角演示影像就像这样:

机器人学会之后,即使照明环境发生剧烈变化也丝毫不受影响。

再叠加上人为干扰,机器人最后也不忘把水龙头关好。

除刷碗之外,还展示了叠衣服、摆放餐具和抛物投篮,都是学习了人类演示后,机器人全自主行动无遥控,1倍速播放。

通用操作接口

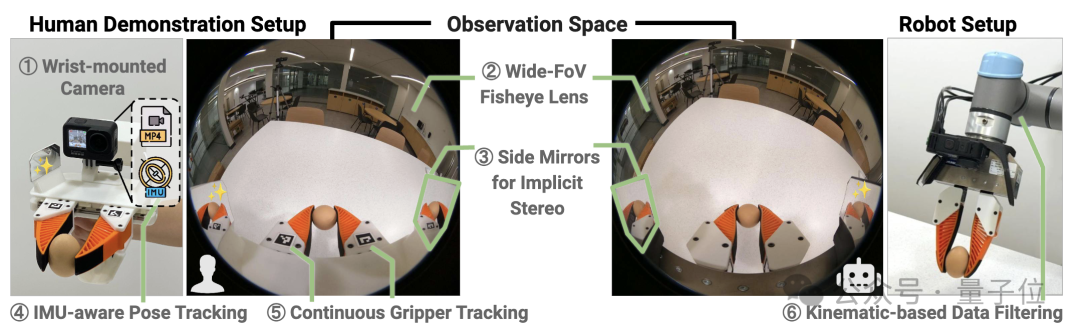

斯坦福的这项研究名为通用操作接口(UMI),是一种数据收集和策略学习框架,允许将技能从人类演示直接转移到可部署的机器人策略。

其中硬件,设计了一个手持夹持器,长这样婶儿:

上面搭载的GoPro运动相机,是唯一的传感器和记录设备,这种设计可以最小化人机观测空间上的差异,保证策略部署时的鲁棒性,同时也简化了硬件搭建。

相机配有155°宽视角鱼眼镜头,可以收集足够的视觉上下文和关键深度信息。相机的两边还配有两块物理侧镜,用于提供隐式的立体视角,辅助深度估计。

下图中绿色框圈出的部分就是侧镜在相机镜头上的显示:

结合内置的IMU传感器,UMI能够在快速运动下稳健跟踪,即使在运动模糊或视觉特征缺失时也能在短时间内保持跟踪。

并且,可以通过视觉标记实时检测夹持器张开宽度,进行精细和连续的抓取控制,同时可隐式检测抓取力度。

总的来说,UMI夹持器的重量为780克,其中3D打印的夹持器材料成本为73美元,GoPro相机及配件的总成本为298美元。

可谓集便携、低成本、信息丰富的数据收集于一身,在任何家庭或餐厅,2分钟内就可以开始进行数据收集。

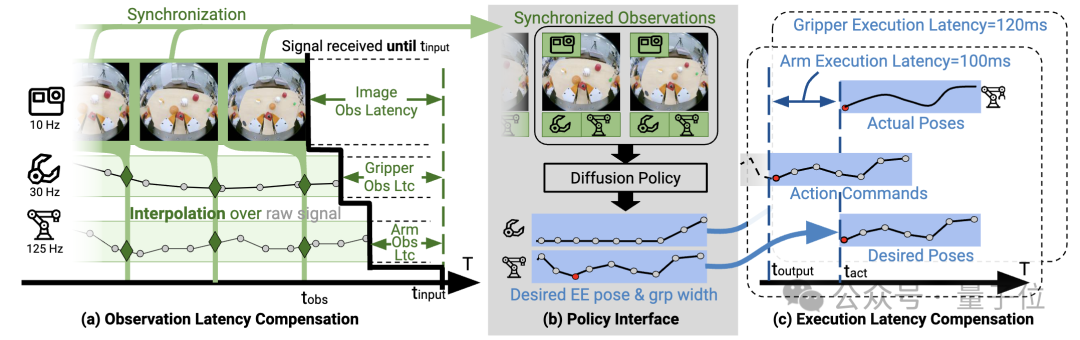

再来看策略接口设计。

UMI在观测和推理时间上可能会有延迟,为此研究人员进行了延迟匹配。

具体来说,测量不同数据流的延迟将其对齐到最大延迟,通过图像时间戳进行线性插值,获得同步观测序列;测量机械臂和手持夹持器延迟,提前对应时间发送控制指令。

此外,作为策略输入的端效器(机械臂)位姿状态采用的是相对位姿序列的表示方法,所以与机器人基座的位置无关,可跨多个机器人平台部署,不需要重新训练或校准。

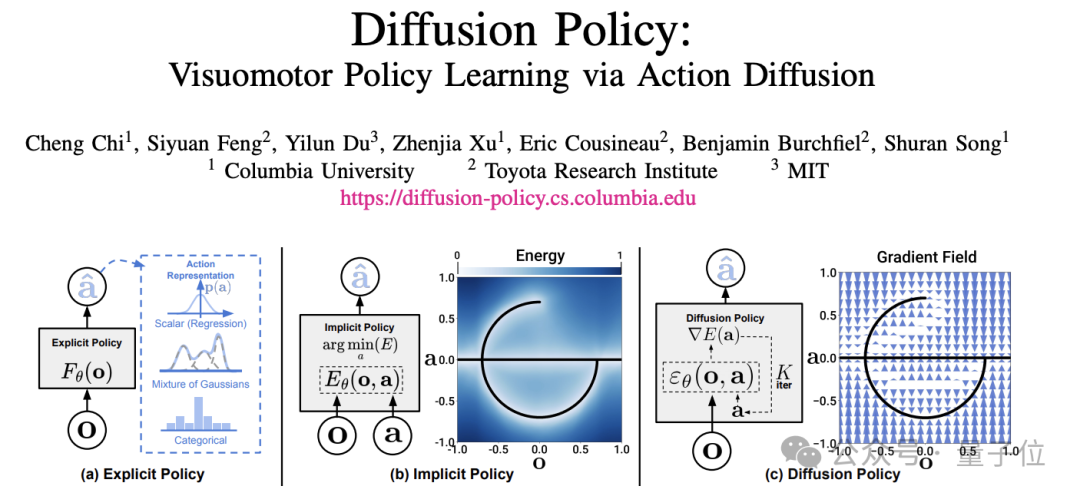

凭借多样化操作数据集,UMI能训练出一个扩散策略(Diffusion Policy),实现零样本泛化到新环境和对象,使得机器人在新环境下执行任务,也能展示出高度的适应性和灵活性。

扩散策略基于团队之前的研究成果,把扩散模型用于机器人视觉运动策略学习,可优雅地处理多模态动作分布、适用于高维动作空间以及表现出令人印象深刻的训练稳定性。

做到即使是水上作业也游刃有余:

斯隆奖得主领衔

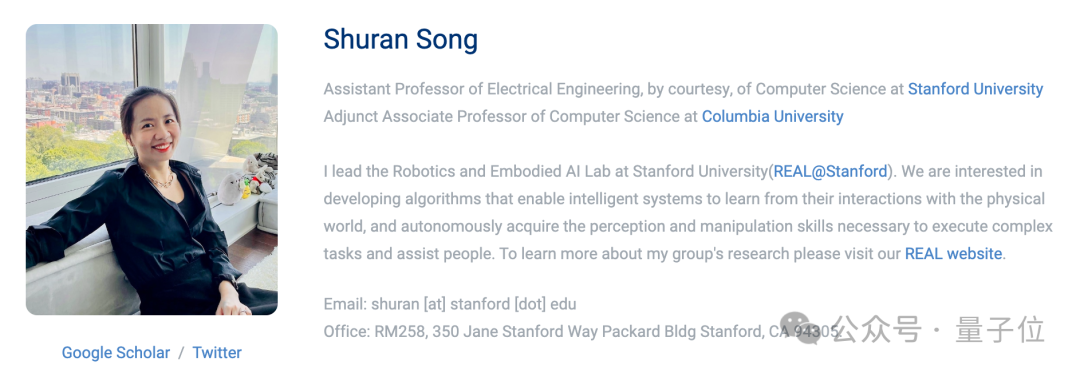

UMI来自斯坦福大学 、哥伦比亚大学 、丰田研究院联合团队。

通讯作者为斯隆奖得主、斯坦福助理教授、哥伦比亚大学兼职副教授宋舒然,两位共同一作都是宋舒然的博士生。

论文公布后,她还补充总结了在这个项目中学到的三件事:

通过正确的硬件设计,腕戴式相机足以应对具有挑战性的操作任务。

通过合适的策略接口,可以实现跨实体(cross-embodiment)的策略。

如果数据合适,行为克隆(BC)可以实现泛化。

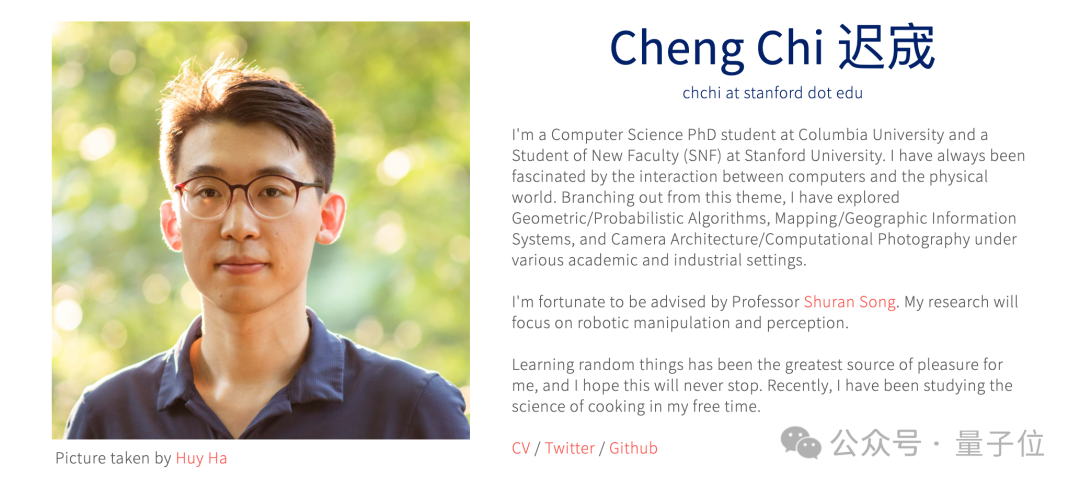

共同一作Cheng Chi(迟宬),哥伦比亚大学博士生及斯坦福Student of New Faculty。

共同一作上交大校友Zhenjia Xu,哥伦比亚大学博士生及斯坦福大学机器人与具身智能实验室 (REAL)成员。

Cheng Chi认为,新方法在大多数任务上实现了70-90%的成功率,但仍然没有达到商业部署的标准。

最后还自曝了一波UMI系统的翻车集锦。

可以看出,机器人在真实场景中还会碰到很多意想不到的问题,但这回新方法启动了数据飞轮,解决也只是时间问题。

论文地址:

https://umi-gripper.github.io

参考链接:

[1]https://twitter.com/chichengcc/status/1758539728444629158

[2]https://twitter.com/chichengcc/status/1758539728444629158

— 完 —

报名中!

2024年值得关注的AIGC企业&产品

量子位正在评选2024年最值得关注的AIGC企业、 2024年最值得期待的AIGC产品两类奖项,欢迎报名评选!

评选报名截至2024年3月31日

中国AIGC产业峰会同步火热筹备中,了解更多请戳:在这里,看见生成式AI的应用未来!中国AIGC产业峰会来啦!

商务合作请联络微信:18600164356 徐峰

活动合作请联络微信:18801103170 王琳玉

点这里👇关注我,记得标星噢

8

8

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?