尚恩 发自 凹非寺

量子位 | 公众号 QbitAI

前不久跑男为了让“kunkun”原地消失,后期只能一帧一帧的抠图。

现在,只要编辑一帧,整个视频就跟着变!

就是点点kunkun,整集就自动消失的那种(手动狗头)。

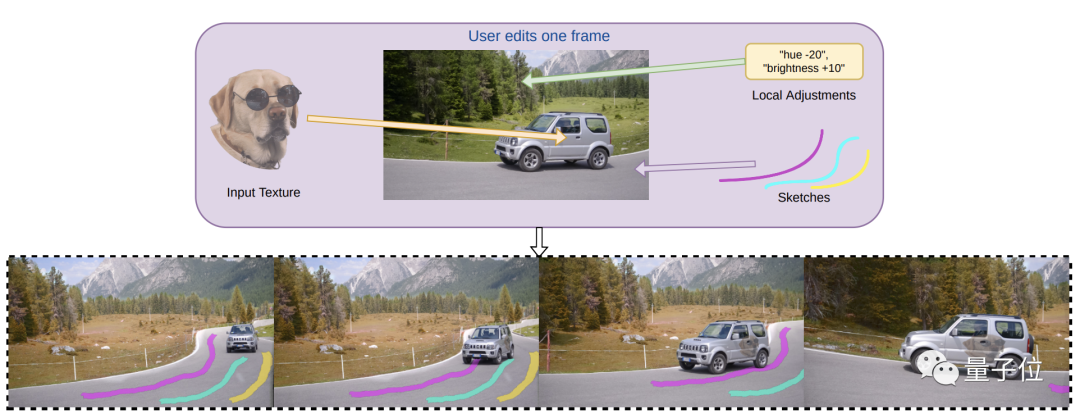

Adobe Research和英属哥伦比亚大学的研究人员发现,使用INVE(交互式神经视频编辑),只需在单帧上“画笔涂鸦”,就能自动应用改动到整个视频中。

不仅可以编辑视频中的对象并保留空间和光影关系,甚至可以编辑移动对象的纹理色彩。

网友惊呼:太牛了!

交互式神经视频编辑

INVE(Interactive Neural Video Editing)是一种实时视频编辑解决方案。

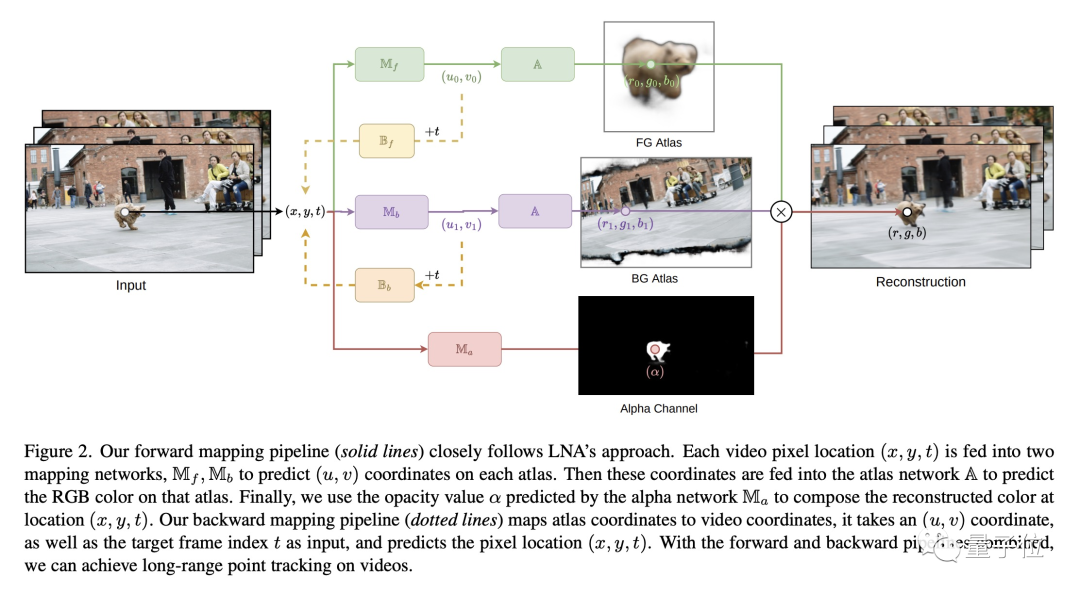

研究团队受到分层神经图集(LNA)的研究启发。测试发现,通过使用INVE,可以将稀疏帧编辑一致地传播到整个视频剪辑,辅助视频编辑过程。

视频中的场景通常由非静态背景和一个或多个前景物体组成,运动轨迹也会不同。

早期的2D方法需要独立编辑每一帧,并使用帧间跟踪来协调整个视频。

假如我们要把这个小狗头像放在车门上,按照传统方式,视频中车是往前移动的,为避免不出现溢出效果,就需要一帧一帧训练和测试反复编辑。

这种方式费时费力不说,还容易导致明显的视觉伪影。

而最近发展起来的分层神经图集(LNA)方法,可以通过一组分层神经网络2D图集对单个训练和测试,达到编辑整个视频的效果。

虽避免了逐帧编辑,但也有一些问题,比如处理速度较慢、对某些编辑用例支持不足。

因此,研究团队基于LNA方法,通过学习图像图集和图像之间的双向函数映射,并引入矢量化编辑,使得在图集和图像中一致编辑成为可能。

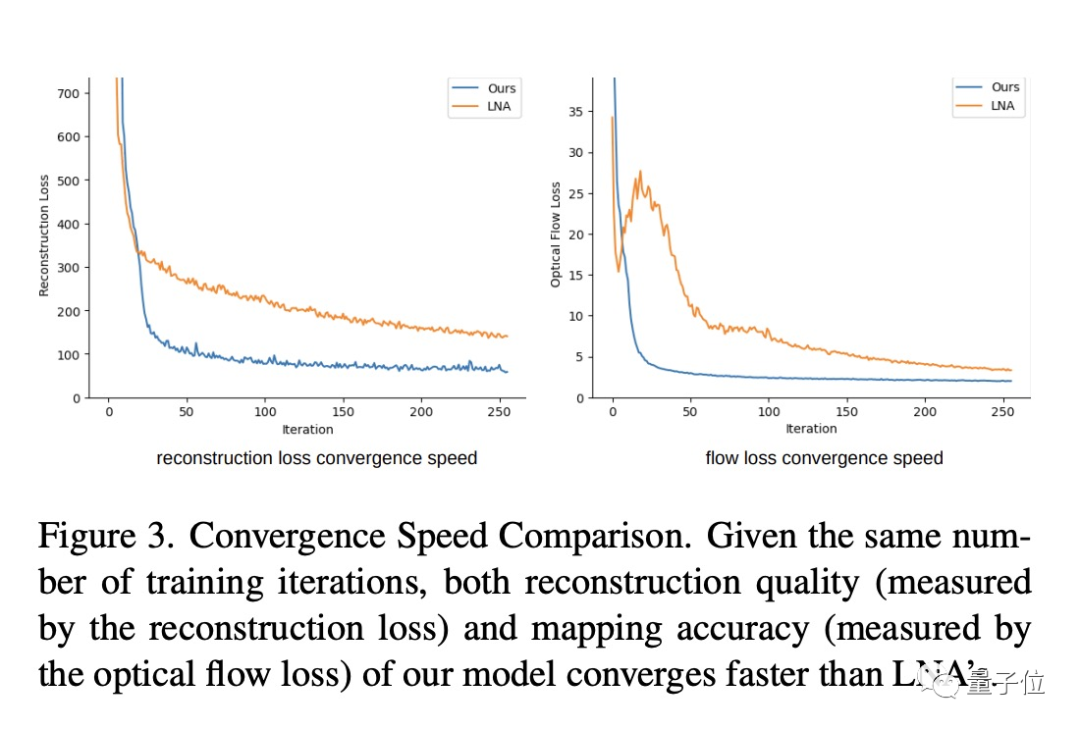

同时,采用多分辨率哈希编码来改善模型的收敛速度。

如何实现

研究团队基于光流提取算法RAFT,在包含70帧且分辨率为768×432的视频上训练和测试模型。

首先,团队在每个训练批次中随机采样了10,000个视频像素,然后设定了一个模型参数值。

通过将GPU优化的Fully Fused MLP架构引入,仅迭代大约12,000个次数就完成训练,相比于LNA的300,000个迭代次数要少得多。

测试显示该方法在单个NVIDIA RTX 4090 GPU上的渲染速度为24.81 FPS,对比LNA的渲染速度5.34 FPS,渲染速度快了近5倍。

经过相同数量的迭代训练,团队模型的重建、流场损失都比LNA更快地收敛。

此外,为实现点跟踪,团队选择逆映射的方法,允许添加跟踪单个/少数点的刚性纹理。

团队提出“矢量化素描技术”,将多边形链直接映射到图集中,更精确地控制线条,从而减少计算成本并避免有视觉伪影。

再通过分层编辑,允许在图集之上叠加多个可编辑图层,使每个图层都可独立访问和编辑。

分层编辑支持多种类型的编辑,包括画笔涂鸦、局部调整、纹理编辑。

比如画笔涂鸦,就可以直接使用画笔工具草图涂鸦。

比如纹理编辑,可以导入外部图形,跟踪和变形的运动对象。

研究团队

作者团队由来自Adobe Research、英属哥伦比亚大学、AI Vector研究所和CIFAR AI组成。

第一作者是Jiahui Huang,目前是Adobe Research的研究工程师,硕士毕业于英属哥伦比亚大学。

其他作者包括Kwang Moo Yi、Oliver Wang和Joon Young Lee,整个团队研究方向主要也是在计算机视觉、机器学习和视频编辑领域。

论文地址已贴,感兴趣的可以去看看。

论文传送门 :

https://arxiv.org/abs/2307.07663

参考链接:

[1]https://twitter.com/_akhaliq/status/1681162394393886720/

[2]https://gabriel-huang.github.io/inve/

— 完 —

「AIGC+垂直领域社群」

招募中!

欢迎关注AIGC的伙伴们加入AIGC+垂直领域社群,一起学习、探索、创新AIGC!

请备注您想加入的垂直领域「教育」或「广告营销」,加入AIGC人才社群请备注「人才」&「姓名-公司-职位」。

点这里👇关注我,记得标星哦~

13

13

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?