大型语言模型(LLMs)的每一次输出都蕴含着强大的能力,许多用户会发现,模型的生成结果有时显得随机或不稳定。这并非模型不可控,而是因为我们尚未充分利用那些影响其输出的“幕后推手”——生成控制参数。

这些参数是LLM从内部概率分布中选择词元(Token)时遵循的核心指令,它们决定了模型的:

- 风格: 倾向于创新还是严谨?

- 结构: 长度如何限制?何时自动停止?

- 倾向: 是否鼓励话题多样性或避免重复?

掌握这些关键参数,是实现LLM从**“能够生成”到“精准控制”**的关键飞跃。接下来将深入解析影响LLM输出的七个核心控制参数,为您提供定制和优化模型表现的实用指南。

控制随机性与多样性的三大策略

这组参数直接影响模型在选择下一个词元(Token)时的不确定性,是控制模型创意性与确定性的核心。

1. Temperature(温度)

| 参数 | 描述 | 最佳场景 |

|---|---|---|

| 低温度 (e.g., 0.2) | 使模型的输出更确定性 (Deterministic) 和聚焦。模型几乎总是选择概率最高的词元。 | 事实性任务 (如摘要、代码生成、直接问答)。 |

| 高温度 (e.g., 1.0) | 使输出更随机和有创意。模型更有可能选择概率较低的词元,产生新颖且多样的文本。 | 创意写作 、头脑风暴、开放式对话。 |

原理: 温度通过缩放词元(Logits)的概率分布来控制采样时的平滑度。温度越低,概率分布越“尖锐”,高概率词元被选中的可能性越高。

2. Top-p (核心采样)

核心机制:**Top-p(也称核采样**)选择一个动态的词元子集。模型会考虑概率累积和达到指定阈值 的最小词元集合。

示例: 若 ,模型仅从累积概率占前 的词元中进行选择。

优势: Top-p 在保证一定随机性的同时,能有效避免选择那些概率极低、可能导致荒谬输出的词元,因此常被推荐作为温度参数的替代或辅助手段,提供良好的平衡性。

3. Top-k (固定数量采样)

核心机制:**Top-k 将模型的选择范围限制在概率最高的 个词元**内。

示例: 若 ,模型只会在概率最高的 50 个词元中进行采样,不论这 50 个词元的累积概率是多少。

优势: Top-k 是一种更直接的限制方法,可以有效防止模型选择到那些异常低概率的词元,使输出在保持连贯性方面优于单纯的高温度采样。

控制长度与结构的参数

这些参数主要用于对模型生成过程的边界和终止条件进行硬性约束。

4. Max Tokens / Max New Tokens(最大词元数)

核心机制: 设置模型在单次API调用中可以生成的最大词元数量的硬性上限。

作用: 严格控制响应长度,有效管理计算成本,并防止模型陷入无限循环或无意义的冗长输出(即“跑飞”)。

5. Stop Sequences(停止序列)

核心机制: 用户定义的一个或一组字符字符串。一旦模型生成了这些序列中的任何一个,输出将立即终止。

作用: 极其关键的结构化工具,用于控制输出格式(例如 JSON 对象的结束符)、创建问答或对话中的回合转换,以及模拟代码块或特定文档的结尾。

控制重复性与主题切换的惩罚机制

惩罚机制旨在调整词元的选择概率,以鼓励多样性和新颖性。

6. Frequency Penalty(频率惩罚)

核心机制: 根据词元在已生成文本中出现的次数来惩罚(降低其被选中的概率)。

正值(如 ):鼓励语言多样性,降低模型重复使用相同词语的倾向。零值():无惩罚。

7. Presence Penalty(存在惩罚)

核心机制: 只要词元在已生成文本中出现过至少一次,就对其应用一次性的惩罚。

正值(如 ):鼓励引入新概念和新主题。因为它惩罚的是词元是否出现过,而非出现的频率,能有效避免模型被限制在一个想法或主题上,推动其进行主题切换。

总结

生成参数是LLM的**“调音台”。在实际应用中,通常需要组合使用**这些参数以达到最佳效果:

- 对于严谨的任务:使用低 Temperature 或中高 Top-p(如 0.8-0.95),并设置适当的 Max Tokens 和 Stop Sequences。

- 对于创意任务:使用较高 Temperature(如 0.8-1.0),同时配合 Frequency Penalty 和 Presence Penalty 来鼓励新颖和多样的输出。

理解并熟练调整这些控制项,是实现LLM精准控制和高性能输出的必经之路。

如何学习大模型 AI ?

我国在AI大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着Al技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国Al产业的创新步伐。加强人才培养,优化教育体系,国际合作并进,是破解困局、推动AI发展的关键。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

2025最新大模型学习路线

明确的学习路线至关重要。它能指引新人起点、规划学习顺序、明确核心知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

对于从来没有接触过AI大模型的同学,我帮大家准备了从零基础到精通学习成长路线图以及学习规划。可以说是最科学最系统的学习路线。

针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

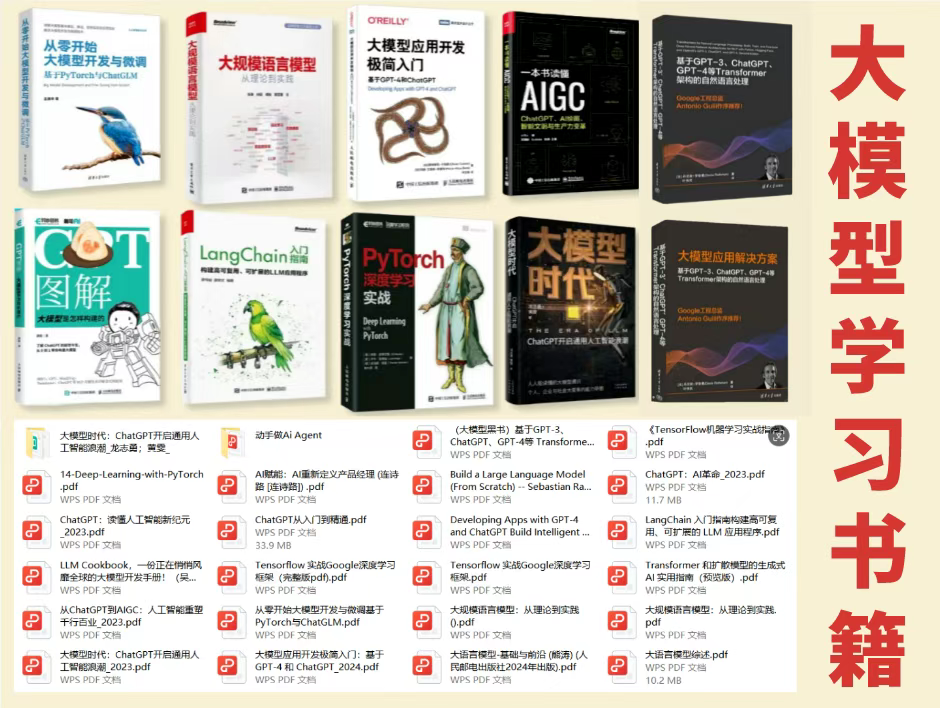

大模型经典PDF书籍

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路!

配套大模型项目实战

所有视频教程所涉及的实战项目和项目源码等

博主介绍+AI项目案例集锦

MoPaaS专注于Al技术能力建设与应用场景开发,与智学优课联合孵化,培养适合未来发展需求的技术性人才和应用型领袖。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

2025人工智能大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

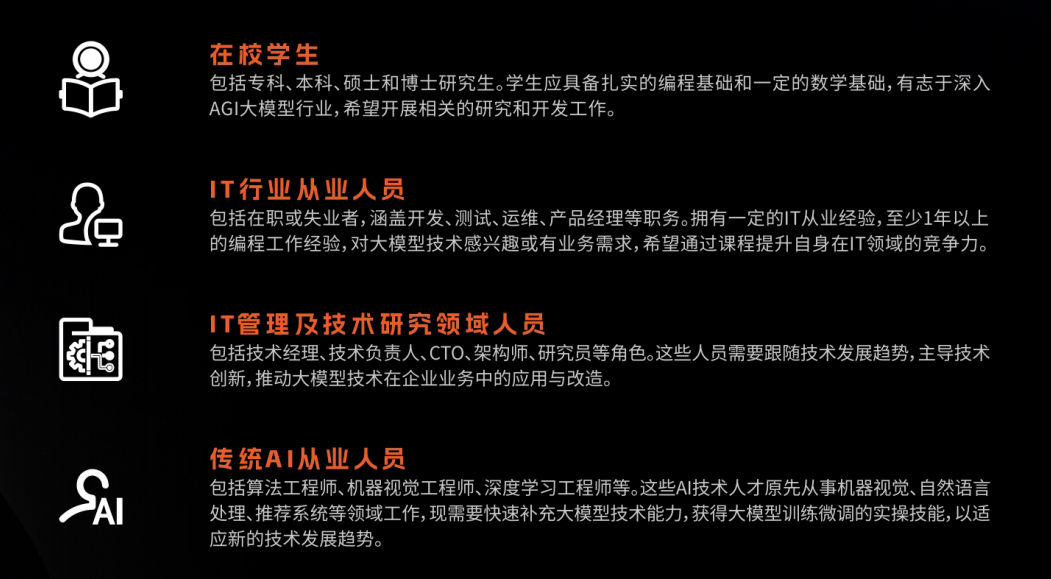

适合人群

- 在校学生:包括专科、本科、硕士和博士研究生。学生应具备扎实的编程基础和一定的数学基础,有志于深入AGI大模型行业,希望开展相关的研究和开发工作。

- IT行业从业人员:包括在职或失业者,涵盖开发、测试、运维、产品经理等职务。拥有一定的IT从业经验,至少1年以上的编程工作经验,对大模型技术感兴趣或有业务需求,希望通过课程提升自身在IT领域的竞争力。

- IT管理及技术研究领域人员:包括技术经理、技术负责人、CTO、架构师、研究员等角色。这些人员需要跟随技术发展趋势,主导技术创新,推动大模型技术在企业业务中的应用与改造。

- 传统AI从业人员:包括算法工程师、机器视觉工程师、深度学习工程师等。这些AI技术人才原先从事机器视觉、自然语言处理、推荐系统等领域工作,现需要快速补充大模型技术能力,获得大模型训练微调的实操技能,以适应新的技术发展趋势。

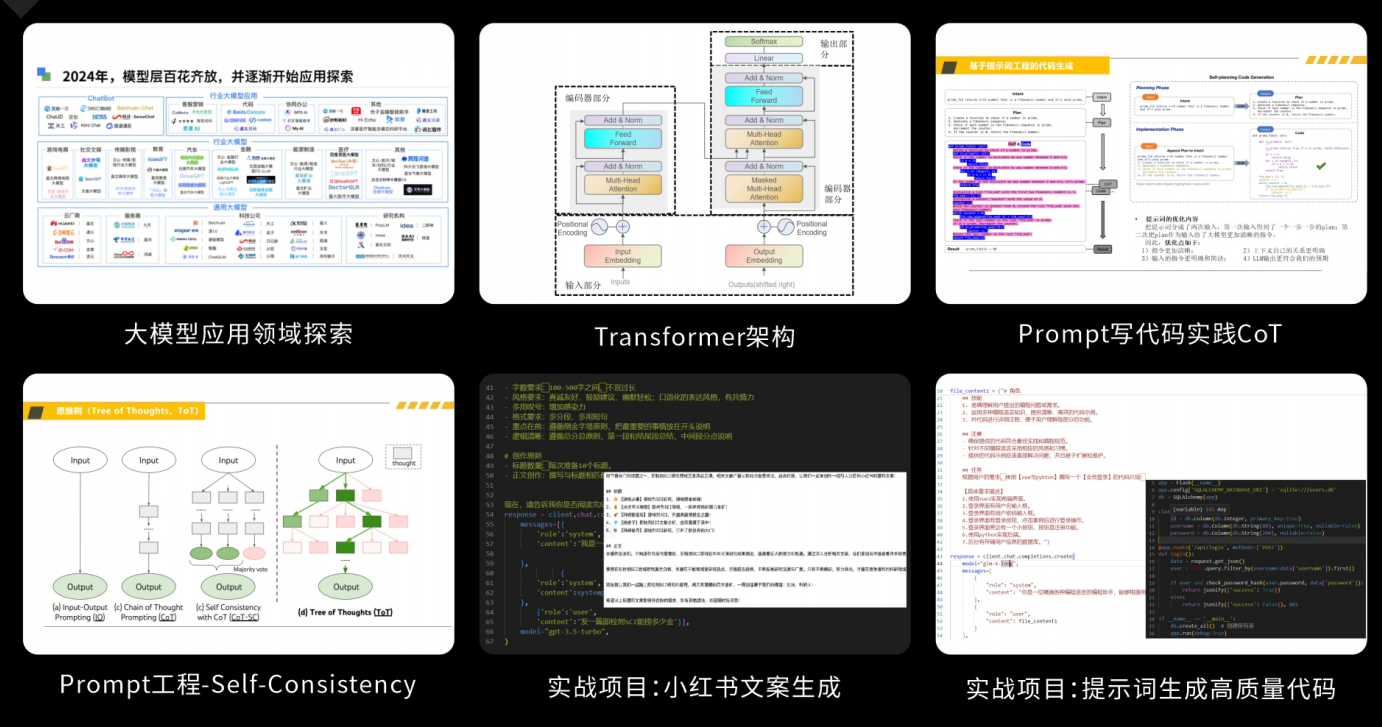

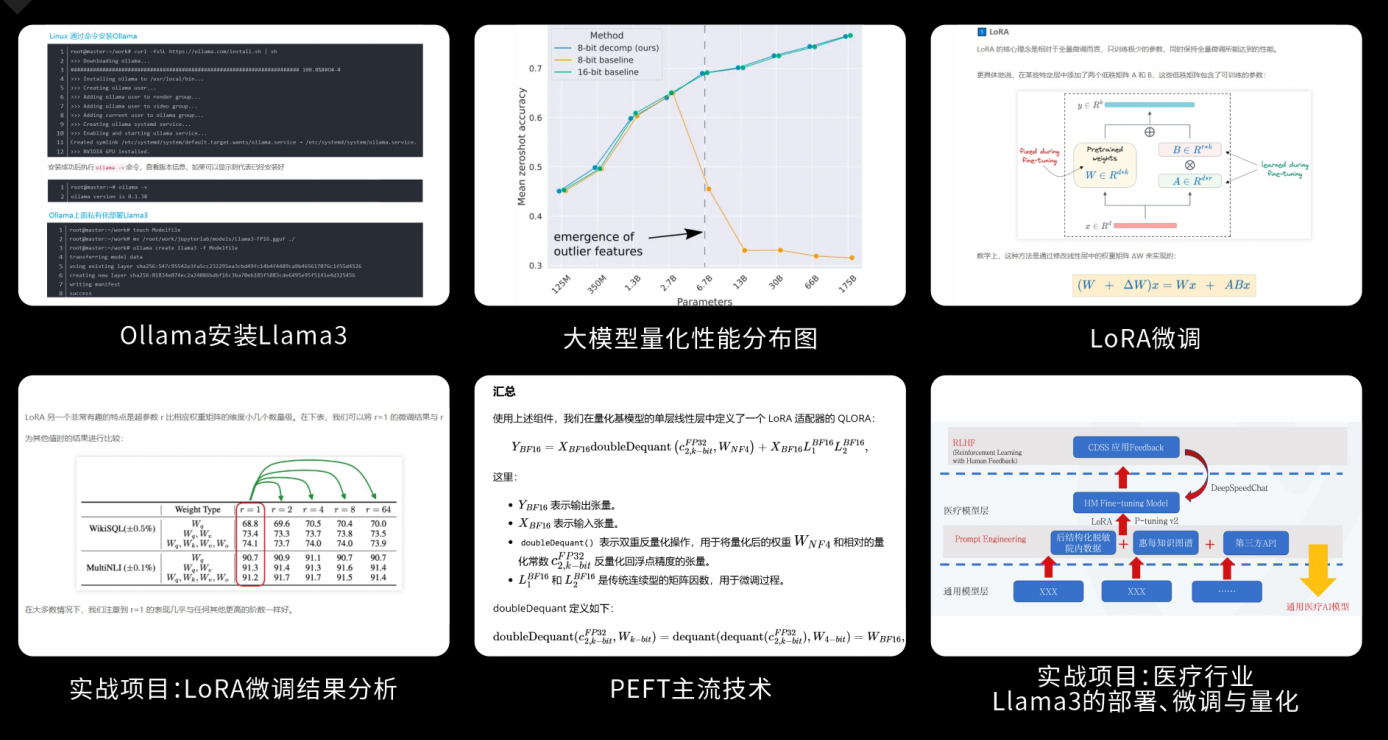

课程精彩瞬间

大模型核心原理与Prompt:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为Al应用开发打下坚实基础。

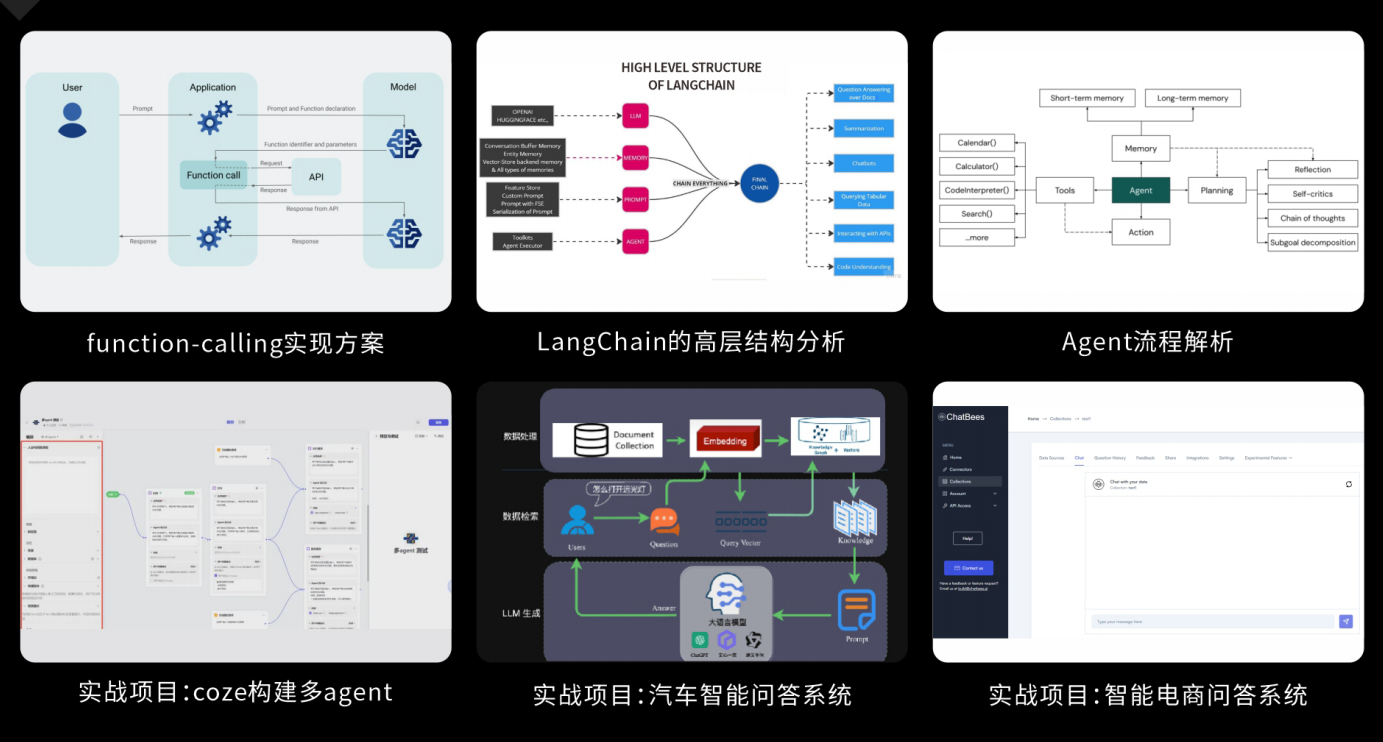

RAG应用开发工程:掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

Agent应用架构进阶实践:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

模型微调与私有化大模型:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

顶尖师资,深耕AI大模型前沿技术

实战专家亲授,让你少走弯路

一对一学习规划,职业生涯指导

- 真实商业项目实训

- 大厂绿色直通车

人才库优秀学员参与真实商业项目实训

以商业交付标准作为学习标准,具备真实大模型项目实践操作经验可写入简历,支持项目背调

大厂绿色直通车,冲击行业高薪岗位

文中涉及到的完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

951

951

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?