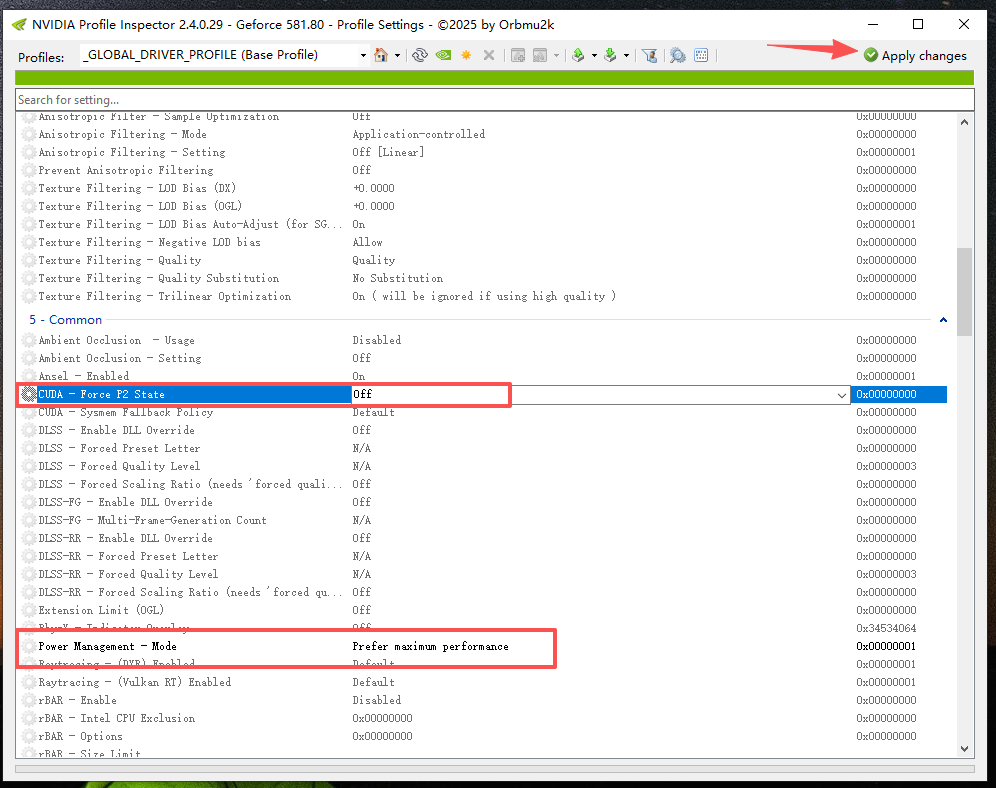

Windows10 设置 NVIDIA GPU GPU P-State 模式为 P0(最高性能)的办法

于 2025-11-19 14:19:42 首次发布

部署运行你感兴趣的模型镜像

您可能感兴趣的与本文相关的镜像

TensorFlow-v2.9

TensorFlow

TensorFlow 是由Google Brain 团队开发的开源机器学习框架,广泛应用于深度学习研究和生产环境。 它提供了一个灵活的平台,用于构建和训练各种机器学习模型

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?