Adaptive Spot-Guided Transformer for Consistent Local Feature Matching

该论文在LoFTR基础上进行改进

代码:

1.Introduction

研究背景:

1.局部特征匹配问题是3D视觉任务的基础,应用于诸如SfM、3D重建、视觉定位和姿态估计等领域。

2.局部特征匹配方法在光照变化、尺度变化、纹理不清晰和重复图案等因素下,很难找到一致且准确的匹配点。

3. 匹配方法分为两类:

1)基于检测器的匹配方法

需要设计一个关键点检测器来提取两幅图像之间的特征点,并建立这些特征点之间的匹配。检测到的关键点的质量将显著影响基于检测器的匹配方法的性能。这种方法能够在保持高计算和内存效率的同时取得令人满意的性能,但在无纹理区域可能难以找到可靠的匹配。

2)无检测器的匹配方法

不需要检测关键点,试图在局部特征之间建立像素级的匹配,因此能够在无纹理区域建立匹配。

4. 近年来出现了许多基于Transformer的方法,利用其在捕获长距离依赖关系方面的优势。然而,一些最近的研究出,Transformer在连续密集预测任务中缺乏空间上的归纳偏差,可能导致局部匹配结果的不一致。

现有方法存在问题:

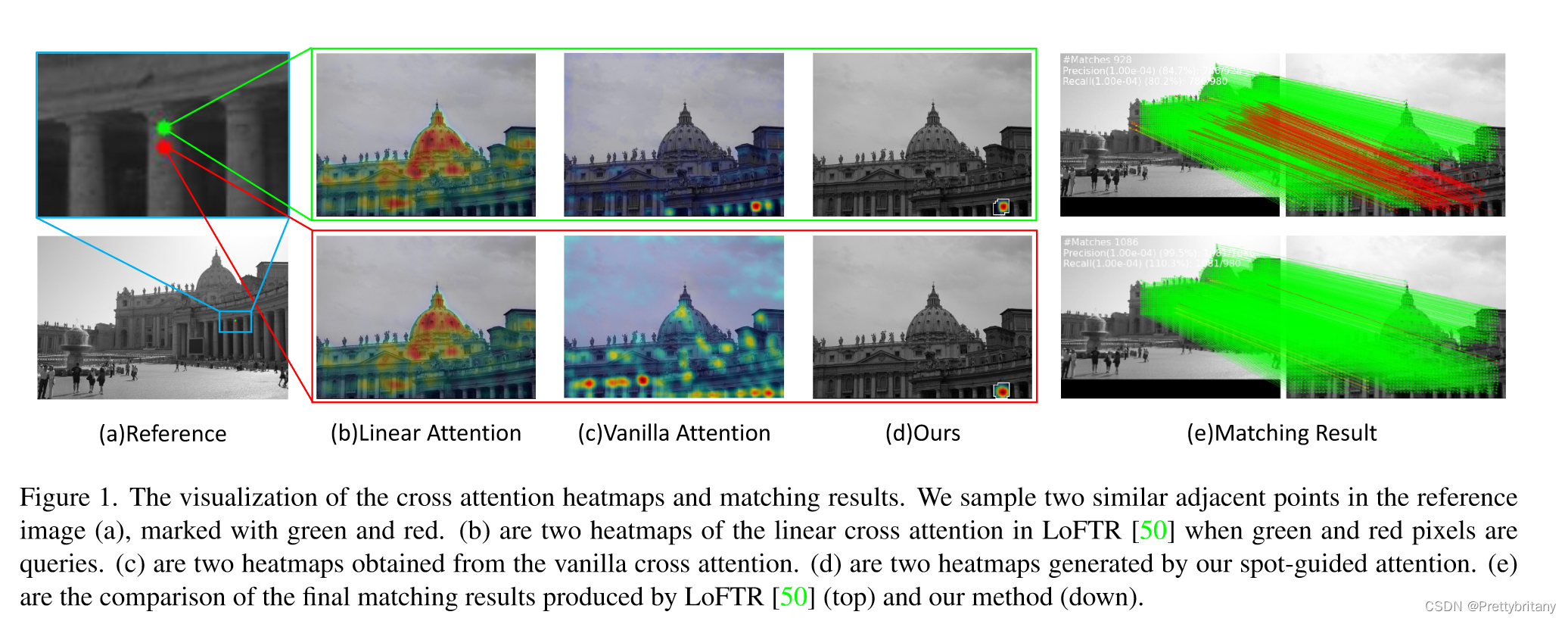

1. 如何保持局部一致性:

- 现有方法利用全局注意力进行特征聚合,引入了许多无关的区域,影响特征更新,导致局部一致性的匹配结果不准确。

- 为了解决这一问题,有必要利用局部一致性将注意力集中在正确的位置上。

2. 如何处理尺度变化:

- 在粗到细的架构中,由于粗阶段的注意机制对尺度变化不敏感,因此应该专注于细阶段。然而,以往的方法在细阶段选择固定大小的网格进行匹配。然而,当图像之间的尺度变化太大时,正确的匹配点可能超出网格的范围,导致匹配失败。

- 因此,裁剪网格的方案应根据视图之间的尺度变化进行自适应调整。

研究方法:

本研究提出了一种新的自适应点引导变换器(ASTR),包括点引导聚合模块和自适应缩放模块。

点引导聚合模块利用了

论文提出了一种新型的自适应点引导Transformer(ASTR),针对局部特征匹配中的问题,通过点引导聚合模块保持局部一致性,自适应缩放模块处理尺度变化。ASTR在SfM等领域展现优秀性能,超越现有方法。

论文提出了一种新型的自适应点引导Transformer(ASTR),针对局部特征匹配中的问题,通过点引导聚合模块保持局部一致性,自适应缩放模块处理尺度变化。ASTR在SfM等领域展现优秀性能,超越现有方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2338

2338

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?