学习爬虫代理中,出现了如下问题

from urllib.error import URLError

from urllib.request import ProxyHandler,build_opener

proxy = '127.0.0.1:9743'

proxy_handler = ProxyHandler({

'http':'http://' + proxy,

'https':'https://' + proxy

})

opener = build_opener(proxy_handler)

try:

response = opener.open('http://httpbin.org/get')

print(response.read().decode('utf-8'))

except URLError as e:

print(e.reason)

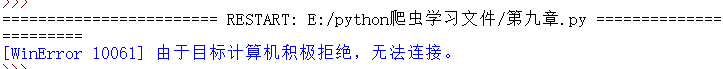

运行结果:

这是个很常见的问题,之前在用pip安装python第三方库的时候也会遇到。

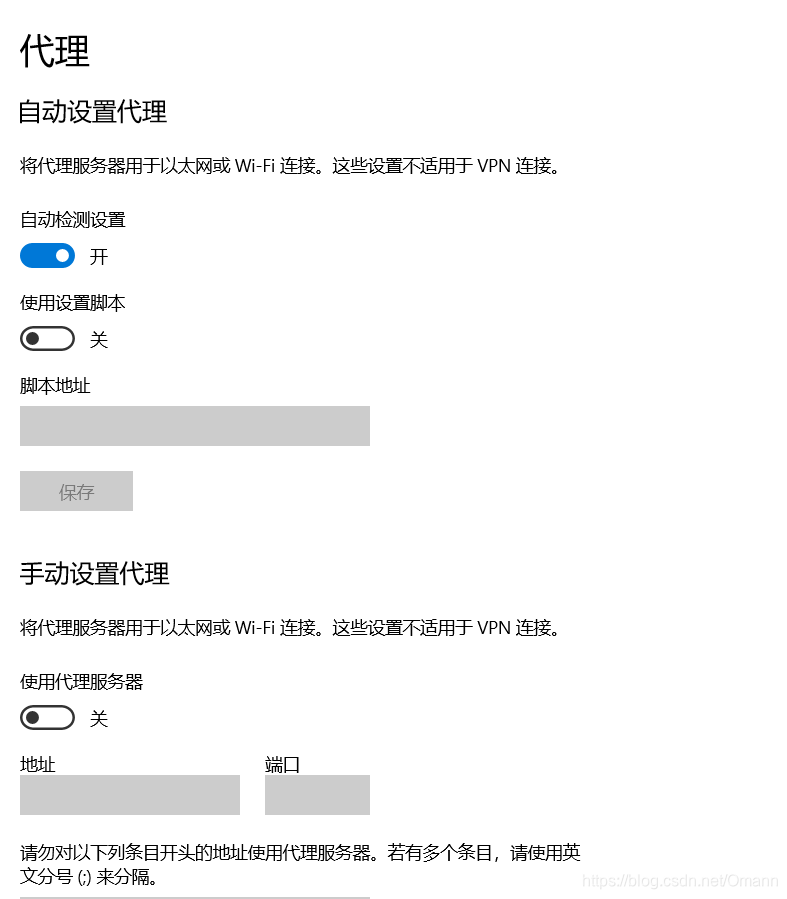

网上有很多关于在本机设置代理的方法,但我没采用,而是直接换了个代理,毕竟原书中所给出的代理到现在也不一定可用。

这是本机的代理设置,仅供参考

更改代码如下

from urllib.error import URLError

from urllib.request import ProxyHandler,build_opener

proxy = '171.37.11.194:9797'

proxy_handler = ProxyHandler({

'http':'http://' + proxy,

'https':'https://' + proxy

})

opener = build_opener(proxy_handler)

try:

response = opener.open('http://httpbin.org/get')

print(response.read().decode('utf-8'))

except URLError as e:

print(e.reason)

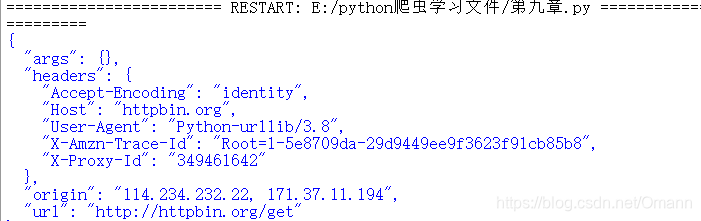

运行后得出正常反馈

在学习Python爬虫使用代理时遇到'计算机积极拒绝'问题。常见于网络请求,可能是由于代理不可用导致。解决方法是检查并更换有效的代理。文中提供了本机代理设置的参考,并通过修改代码成功获取了正常反馈。

在学习Python爬虫使用代理时遇到'计算机积极拒绝'问题。常见于网络请求,可能是由于代理不可用导致。解决方法是检查并更换有效的代理。文中提供了本机代理设置的参考,并通过修改代码成功获取了正常反馈。

686

686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?