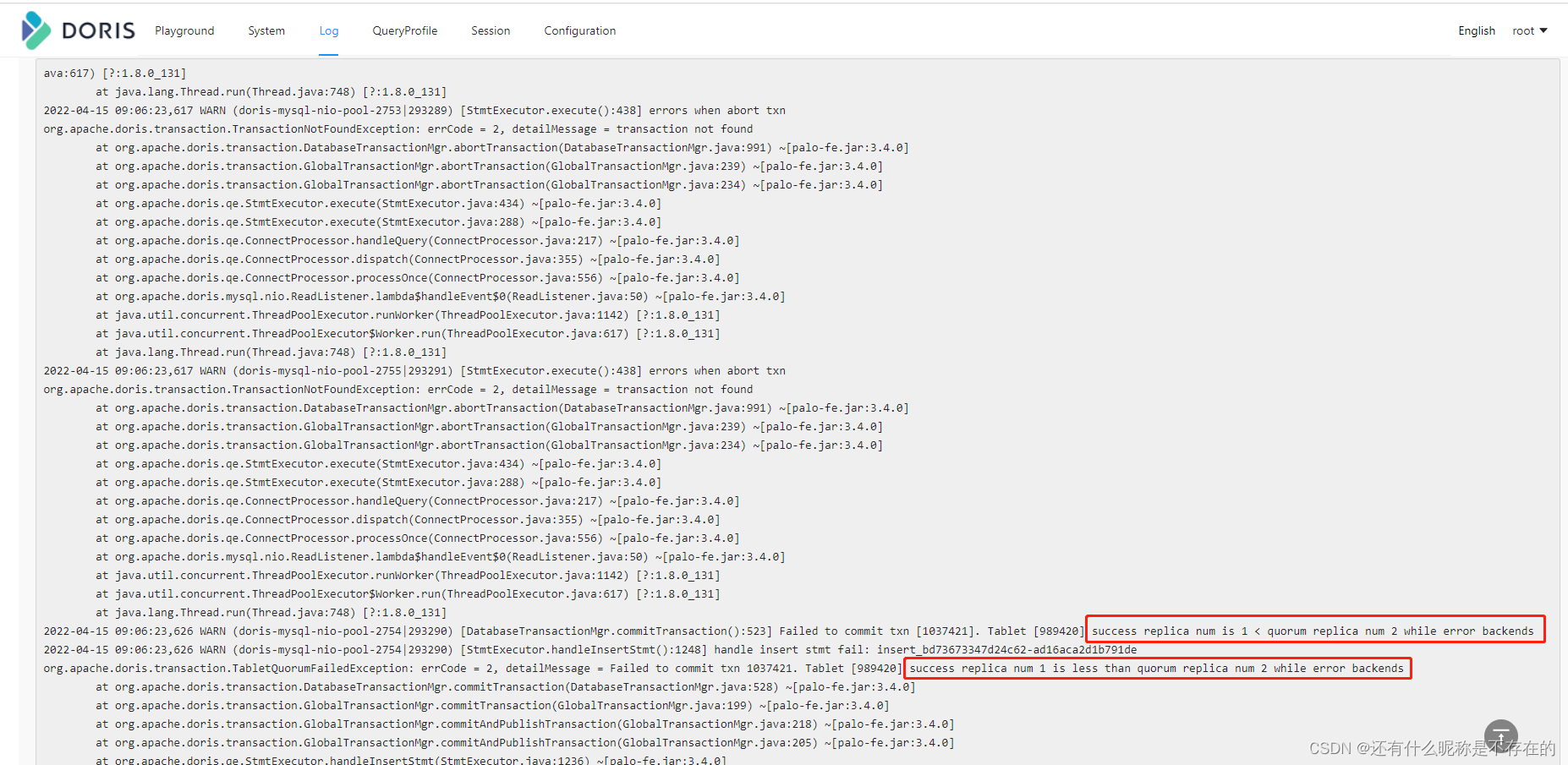

1. Doris导入几十万条数据时,部分数据成功,查看FE日志报以下错误

success replica num is 1 < quorum replica num 2 while error backends

2. 查看官方文档

min_replication_num_per_tablet默认值是1,结果集较大时,可能需要增大该值

3. 此时这样登录FE服务器 修改fe.conf 文件 添加 min_replication_num_per_tablet = 3

设置多少取决于报错的时候是多少,我这里报错是2,所以我设置3,问题就得到解决

当Doris导入大量数据时遇到错误,通过官方文档了解到min_replication_num_per_tablet的重要性。博主发现报错为successreplicanumis1<quorumreplicanum2whileerrorbackends,调整配置为3解决了问题。

当Doris导入大量数据时遇到错误,通过官方文档了解到min_replication_num_per_tablet的重要性。博主发现报错为successreplicanumis1<quorumreplicanum2whileerrorbackends,调整配置为3解决了问题。

1302

1302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?