通过将基于模型的决策引入环境,我们可能会破坏模型(因为模型决策在于穿皮鞋的人更不会欠款,导致了所有人开始穿皮鞋,这也让我们的决策失去了原本的意义)

4.9.1.1. 协变量偏移(狗还是狗 只不过变成了卡通狗)

虽然输入的分布可能随时间而改变, 但标签函数(即条件分布P(y∣x))没有改变。 统计学家称之为协变量偏移(covariate shift), 因为这个问题是由于协变量(特征)分布的变化而产生的。这里的例子是,一个数据集中都是真实图片,另一个是卡通图片,导致了偏移。

4.9.1.2. 标签偏移(狗不是狗 变成了犬或者其他的认定)

这里我们假设标签边缘概率P(y)可以改变, 但是类别条件分布P(x∣y)在不同的领域之间保持不变。预测患者的疾病,我们可能根据症状来判断, 即使疾病的相对流行率随着时间的推移而变化。 标签偏移在这里是恰当的假设,因为疾病会引起症状。 在另一些情况下,标签偏移和协变量偏移假设可以同时成立。 例如,当标签是确定的,即使y导致x,协变量偏移假设也会得到满足。 有趣的是,在这些情况下,使用基于标签偏移假设的方法通常是有利的。 这是因为这些方法倾向于包含看起来像标签(通常是低维)的对象, 而不是像输入(通常是高维的)对象。

4.9.1.3. 概念偏移(人们认知不一样)

我们也可能会遇到概念偏移(concept shift): 当标签的定义发生变化时,就会出现这种问题。 这听起来很奇怪——一只猫就是一只猫,不是吗? 然而,其他类别会随着不同时间的用法而发生变化。 精神疾病的诊断标准、所谓的时髦、以及工作头衔等等,都是概念偏移的日常映射。

4.9.2分布偏移示例(略)

4.9.3分布偏移纠正

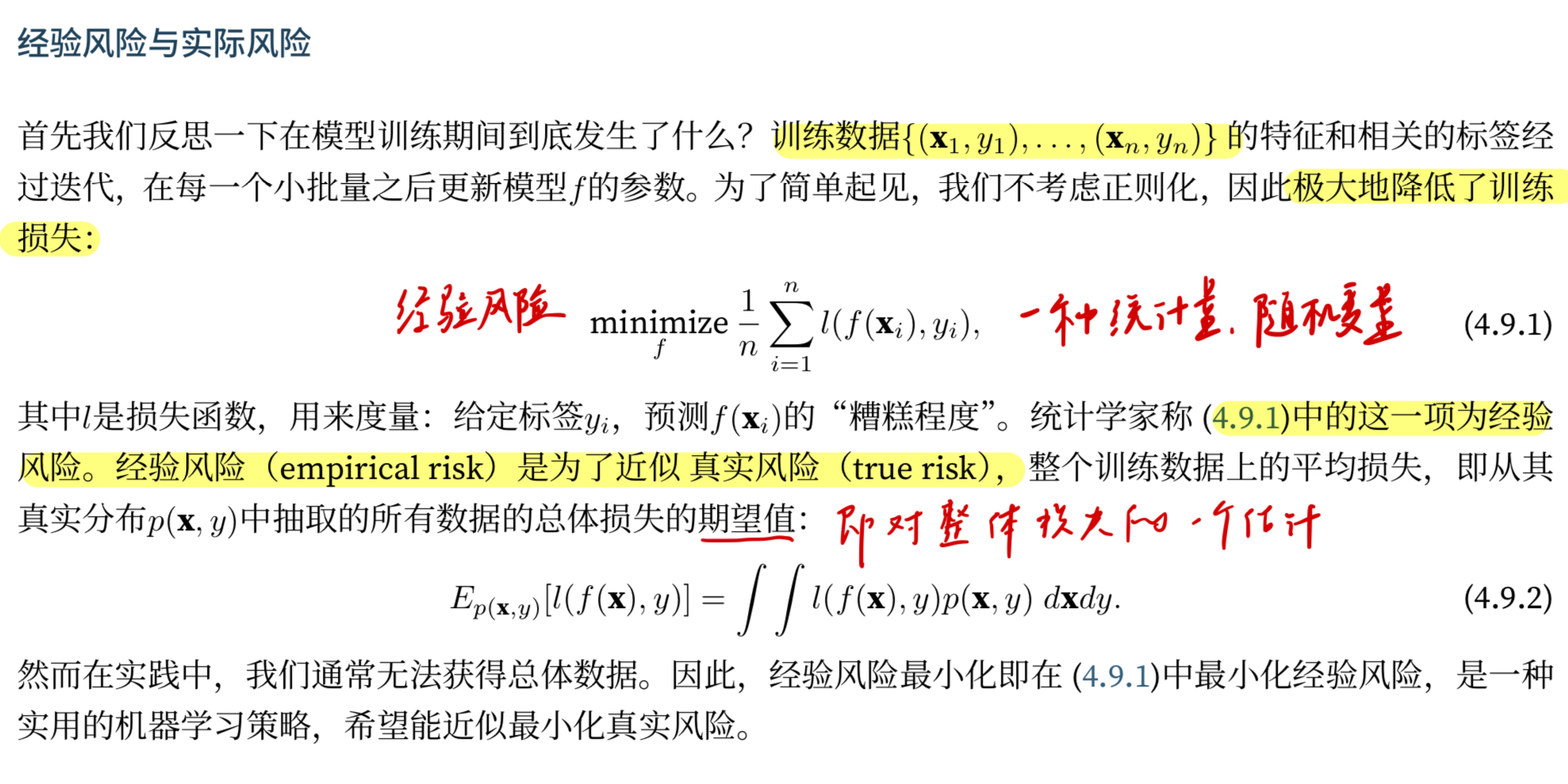

4.9.3.1经验风险和实际风险

这一部分从概率论的角度说就是实际值和观测量之间的关系,最终依据概率分布收敛得到一个预测的期望值,那么就是经验风险对于实际风险的预测。

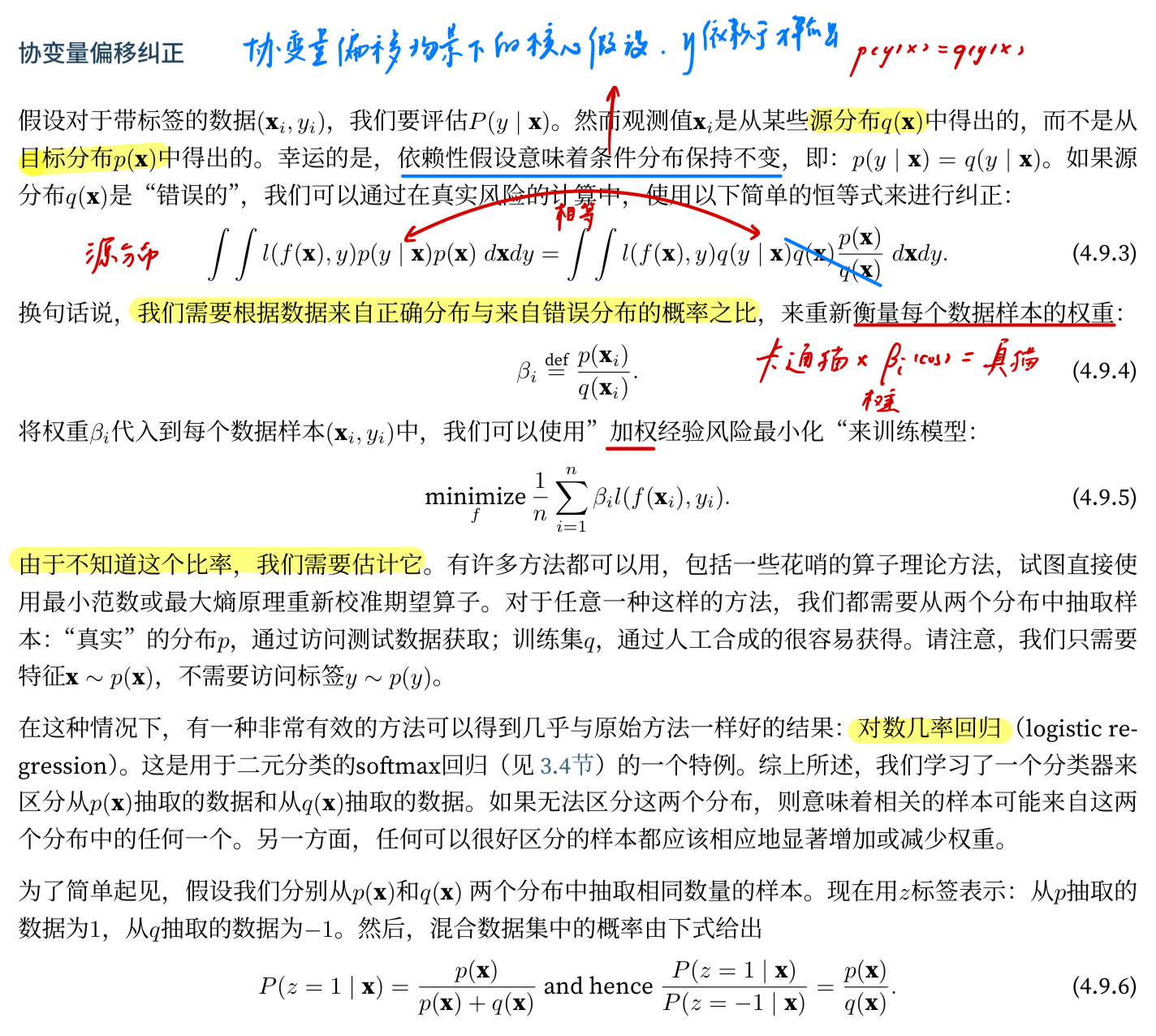

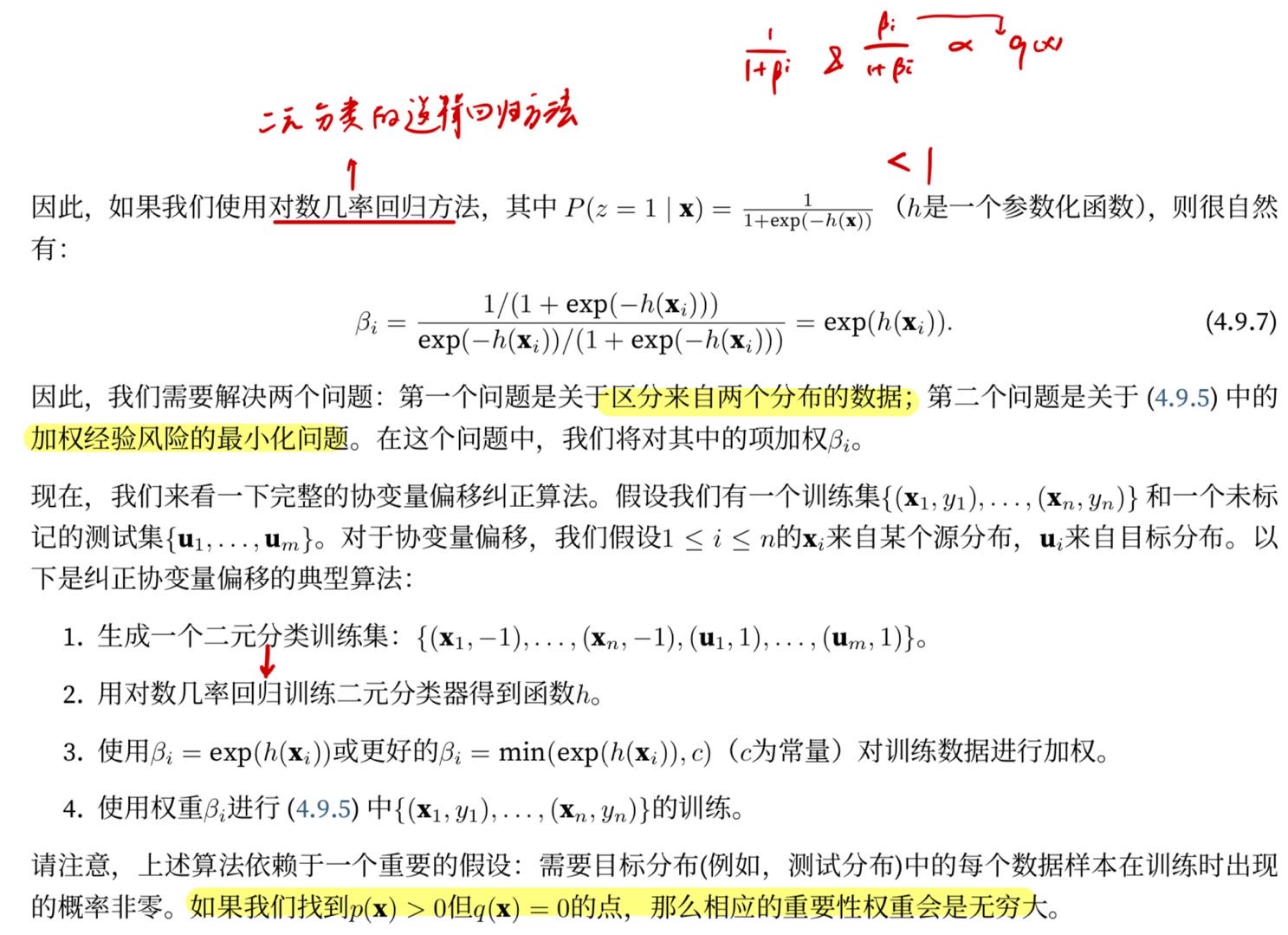

4.9.3.2. 协变量偏移纠正

“依赖性假设”具体指的是:标签 y 依赖于输入 x 的方式在源分布和目标分布下是相同的。用概率术语表达就是:条件分布 P(y | x) 保持不变。

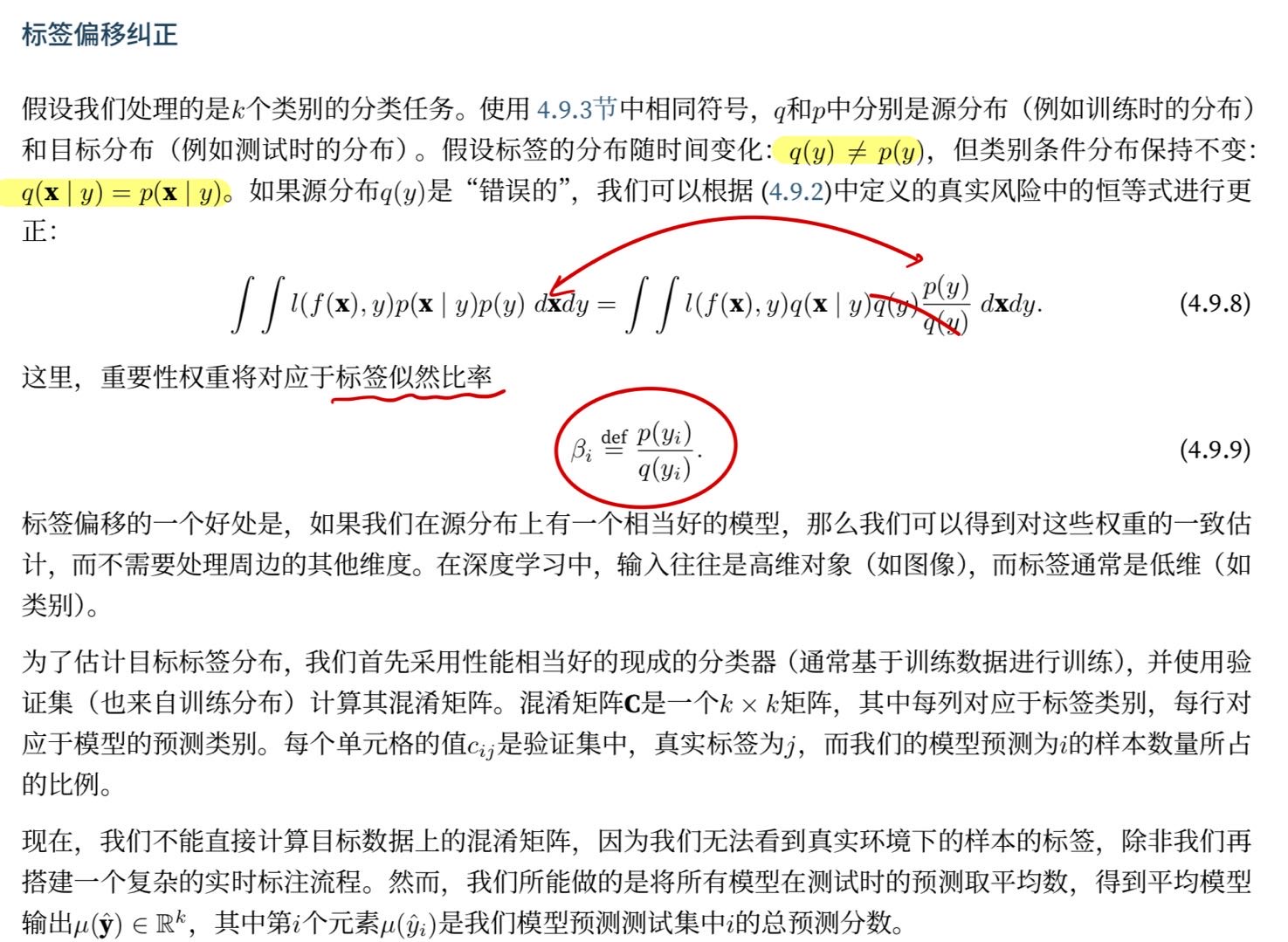

4.9.3.3. 标签偏移纠正

测试集上的预测分布 (μ̂) 近似等于混淆矩阵 (C) 乘以目标域的真实标签分布,从而得到标签似然比率。

4.9.4. 学习问题的分类法

1、批量学习:访问一组训练特征后部署模型对来自统一分布的新数据进行评分。

2、在线学习:我们首先观测到xi, 然后我们得出一个估计值f(xi), 只有当我们做到这一点后,我们才观测到yi。 然后根据我们的决定,我们会得到奖励或损失。在这个循环中,给定新的观测结果,我们会不断地改进我们的模型。

3、老虎机:可以采取的行动是有限的,可以获得更强的最优性理论保证

4、控制:pid控制器算法,自动调整超参数以获得更好的质量。

5、强化学习:强调如何基于环境而行动,以取得最大化的预期利益,就像下象棋之类的alpha狗

6、考虑到环境

996

996

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?