Controlnet更新的v1.1.4版本新预处理ip-

adapter,这项新能力简直让stablediffusion的实用性再上一个台阶。这些更新将改变sd的使用流程。

ip-adapter是什么?

ip-adapter是腾讯Ai工作室发布的一个controlnet模型,可以通过stable

diffusion的webui使用,这个新的功能简单来说,他可以识别参考图的艺术风格和内容,然后生成相似的作品,并且还可以搭配其他控制器使用。可以说SD已经学会临摹大师的绘画并且运用到自己的作品上了。

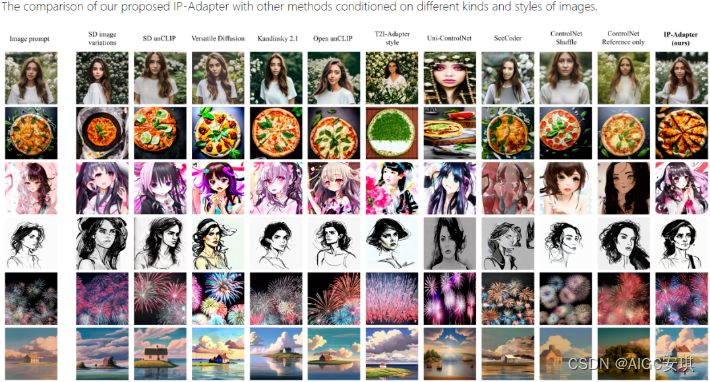

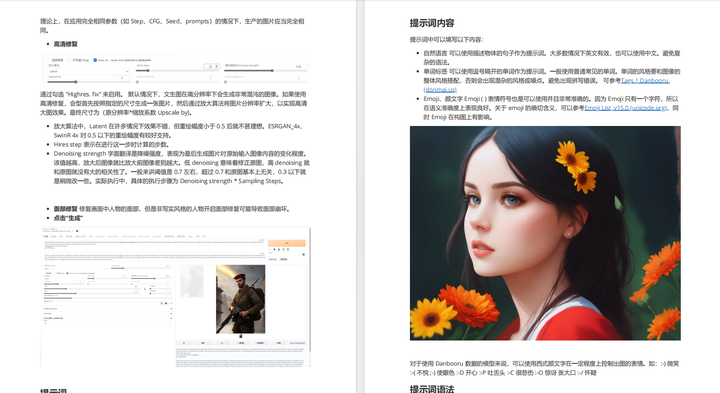

2.ip-adapter生成效果

官方对ip-adapter进行了测试,如下图,第一列是输入的图片参考,第二列是输入的其他控制参数。最后一列是使用ip-

adapter生成的效果,看测试效果能明显看出,ip-adapter的方法不仅在图像质量方面优于其他方法,而且生成的图像与参考图像更好地对齐。

ip-adapter使用SD1.5的模型效果明显优于SDXL模型的效果,不知道是不是由于官方训练时使用的基本都是SD1.5模型的原因。

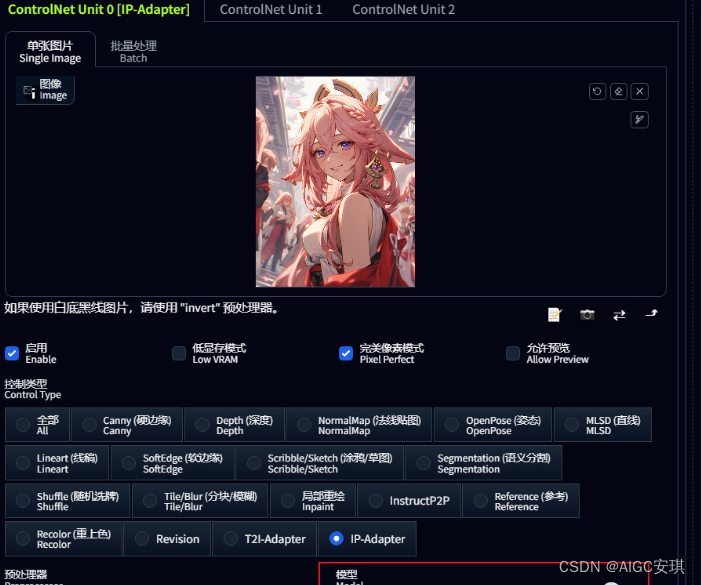

3.ip-adapter如何使用?

首先,我们打开webui界面,在controlnet选择ip-

adapter,选择一张参考图,我上传了原神八重神子,然后,我们选择一个和参考图片风格类似的二次元大模型,调整预处理器和图片尺寸,最后点击生成按钮。

生成效果对比:

从生成图可以看到人物的形象,姿态复刻得很接近了。

再使用卡通头像作为试验:受大模型以及提示词影响,相识度略有下降。

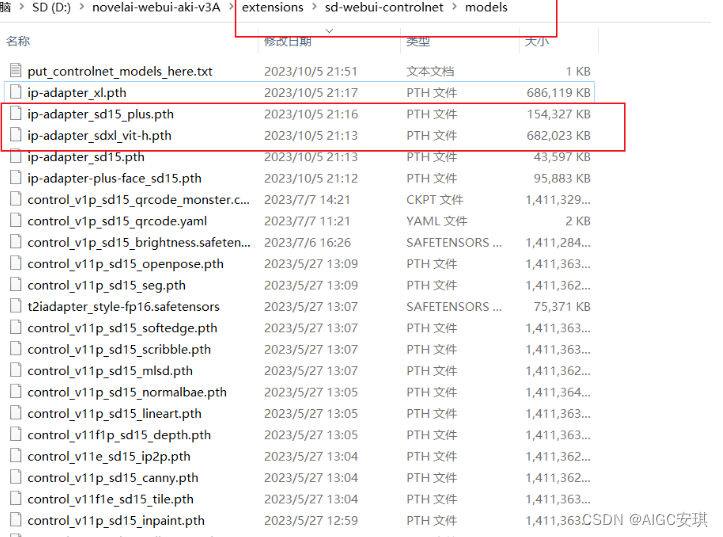

4.如何在SD WEIUI 下载使用ip-adapter呢?

环境要求:

1.将本地的stable diffusion整合包(比如秋叶版本的)webui的版本更新到v1.6。

2.将controlnet更新到v1.1.4之后的版本。

controlnet模型安装:准备好环境之后,需要下载controlnet最新的ip-adapter模型, 放到stable-diffusion-

webui根目录\extensions\sd-webui-controlnet’models。

5.ip-adapter出现错误,如何解决?

检查webui版本是否是v1.6及以后的版本。

controlnet的ip-adapter模型是否安装并启用。

如果未安装,请使用上方的网盘链接进行下载。

3.检查webui根目录\extensions\sd-webui-controlnet\annotator\downl oads\clip_vision

目录里有没有这两个模型:【clip_g.pth】【clip_h.pth】

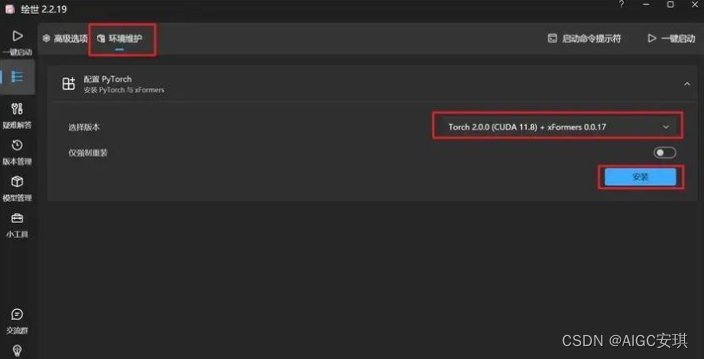

4.如果以上都不能解决问题,请更新一下pytorch版本。打开启动器,在“高级选项”-“环境维护”-选择至少torch2.0.0版本及以后的版本安装更新。

总结,在人物形象和画风复刻的2个层面上,ip-

adapter的效果可圈可点。优势就是不需要训练lora,能达到基本的一致性效果。在商业应用层面,可以精准捕捉客户对整体氛围的需求,快速生成AI效果图供客户选择。

写这篇文章的初衷,网上的Stable Diffusion教程太多了,但是我真正去学的时候发现,没有找到一个对小白友好的,被各种复杂的参数、模型的专业词汇劝退。

所以在我学了之后,给大家带来了腾讯出品的Stable Diffusion新手入门手册

希望能帮助完全0基础的小白入门,即使是完全没有代码能力和手绘能力的设计师也可以完全学得会。

软件从来不应该是设计师的限制,设计师真正的门槛是审美。

需要完整版的朋友,戳下面卡片即可直接免费领取了!

目录

- 硬件要求

- 环境部署

- 手动部署

- 整合包

- …

- 文生图最简流程

- 提示词

- 提示词内容

- 提示词语法

- 提示词模板

- …

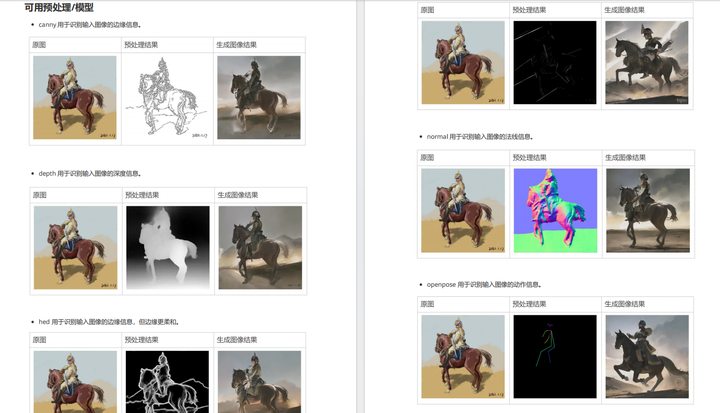

- Controlnet

- 可用预处理/模型

- 多ControlNet合成

- …

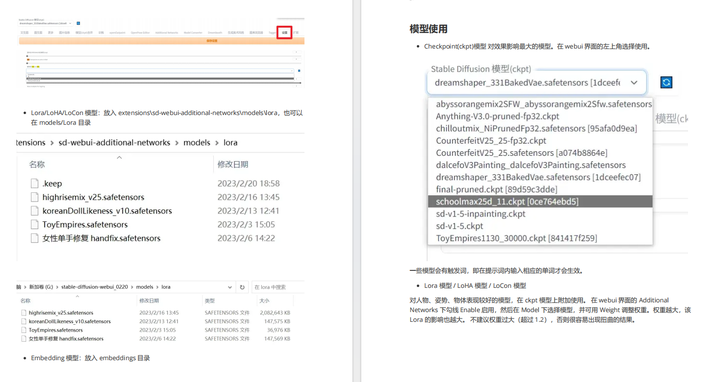

- 模型下载

- 模型安装

- 模型训练

- …

- 训练流程

- 风格训练

- 人物训练

- …

需要完整版的朋友,戳下面卡片即可直接免费领取了!

1370

1370

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?