日前,CVPR 2022 论文接收情况正式出炉。此次旷视研究院表现出色,共有 17 篇论文成功入选。

作为计算机视觉世界三大顶会之一,CVPR 每年都会吸引大量研究机构和高校参会。近年来,CVPR 的论文投稿量持续增加,据官方消息,本届大会大约 2067 篇论文被接收,相比去年,今年的接收率上升 24%。

在恭喜旷厂小伙伴喜提中选的同时,为了帮大家第一时间查阅所关注领域的研究成果,我们整理了此次旷视研究院入选论文的摘要精选,并将分上下期与大家分享,本篇为上期。

学术成果来袭,一起先睹为快吧

👇

01

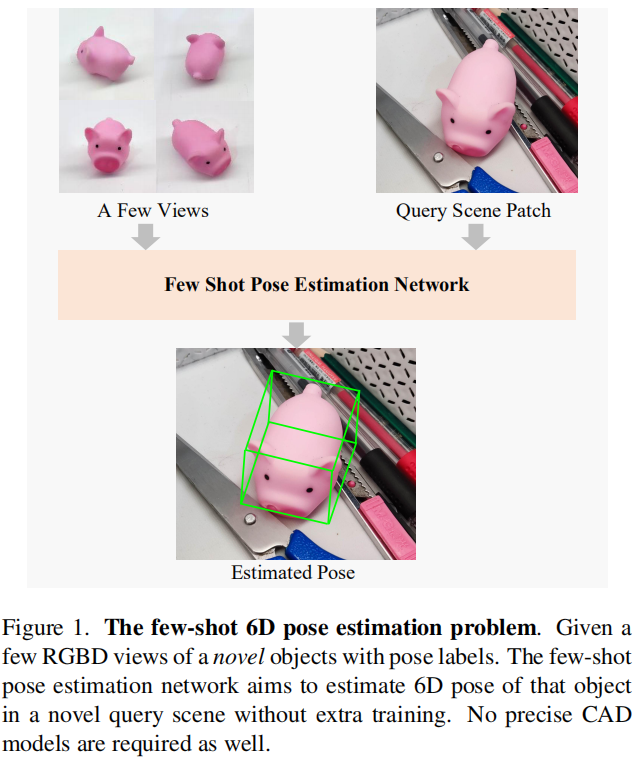

FS6D: Few-Shot 6D Pose Estimation of Novel Objects

FS6D:用于新物体的少样本 6D 位姿估计

本文提出一个少样本开集 6D 位姿估计问题:对于没见过的新物品,已训练的网络模型只需依据几张 RGBD 图像就能在新测试场景中估算出该物品的 6D 位姿,而无需依赖物品的高精度 CAD 模型以及额外的训练。为了提高模型的泛化性,我们提出一个具有丰富纹理和形态多样性的大型仿真数据集用于网络预训练。同时,我们讨论求解该问题的可行算法并提出一个稠密原型匹配网络用于 6D 位姿估计。在公开数据集上,我们的方法大幅领先于其他可行算法。

👉关键词:6D位姿估计,少样本学习,数据集和基准

https://fs6d.github.io/

02

Voxel Field Fusion for 3D Object Detection

体素场融合的三维物体检测方法

本文提出了一种名为体素场融合的用于跨模态 3D 检测的方法。为了保持跨模态信息的一致性,其通过使用光束的方式来表示并在体素场中融合图像特征。因此,我们首先使用可学习的采样器来在图像平面采集重要区域的信息,并使用光束的方式将其投影至体素场中。这一操作在保证了特征空间表示的同时增强了三维空间中上下文交互。接着我们提出使用光束方式的融合来进行跨模态的特征增强,用于在体素场中融合上下文信息。我们所提出的方法在 KITTI 和 nuScenes 数据集上均取得了领先的结果。

旷视研究院在CVPR 2022上有17篇论文入选,涉及领域包括6D位姿估计、3D物体检测、语义分割等。文章介绍了FS6D、体素场融合、实时物体检测等创新技术,提出新方法以应对少样本学习、稀疏标注等挑战,并在多个数据集上取得优秀结果。

旷视研究院在CVPR 2022上有17篇论文入选,涉及领域包括6D位姿估计、3D物体检测、语义分割等。文章介绍了FS6D、体素场融合、实时物体检测等创新技术,提出新方法以应对少样本学习、稀疏标注等挑战,并在多个数据集上取得优秀结果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

305

305

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?