✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、期刊写作与指导,代码获取、论文复现及科研仿真合作可私信或扫描文章底部二维码。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

🔥 内容介绍

多目标跟踪 (Multi-Object Tracking, MOT) 旨在对视频序列中多个目标进行持续的识别和跟踪,是计算机视觉领域一项极具挑战性的任务。传统的MOT方法主要依赖于数据关联算法,如匈牙利算法或卡尔曼滤波,然而这些方法在处理目标遮挡、快速运动以及目标外观变化等复杂场景时往往表现欠佳。近年来,强化学习 (Reinforcement Learning, RL) 凭借其强大的决策能力和适应性,逐渐成为解决MOT问题的有力工具。本文将深入探讨基于强化学习的多目标跟踪方法,并提供相应的Matlab代码示例,以期为读者提供一个全面的理解。

一、传统多目标跟踪方法的局限性

传统的MOT方法通常分为两个步骤:检测和数据关联。首先,目标检测算法(如Faster R-CNN, YOLO)在每一帧图像中检测目标,并提取目标特征(例如,颜色直方图、HOG特征)。然后,数据关联算法根据目标特征和运动信息,将不同帧中的目标进行关联,从而实现目标的持续跟踪。然而,这种方法存在以下局限性:

-

遮挡问题: 当目标发生遮挡时,目标特征提取和数据关联将变得非常困难,容易导致跟踪失败或ID切换 (ID switch)。

-

快速运动: 对于快速移动的目标,传统的卡尔曼滤波等算法难以准确预测目标的轨迹,导致跟踪精度下降。

-

外观变化: 目标的外观可能会由于光照变化、姿态变化等因素发生显著改变,这使得基于静态特征的关联算法难以有效工作。

-

计算复杂度: 对于大量目标的跟踪,传统的关联算法的计算复杂度较高,难以满足实时性要求。

二、基于强化学习的多目标跟踪方法

强化学习提供了一种新的视角来解决MOT问题。我们将MOT任务建模为一个马尔可夫决策过程 (Markov Decision Process, MDP)。其中:

-

状态 (State): 包含当前帧的目标检测结果(位置、外观特征等),以及历史跟踪信息(例如,目标轨迹、ID)。

-

动作 (Action): 表示对当前帧目标的关联操作,例如,将当前帧的检测结果与之前的跟踪结果进行匹配,或者新建一个跟踪目标。

-

奖励 (Reward): 根据跟踪结果的准确性进行定义,例如,正确匹配的目标给予正奖励,错误匹配或ID切换给予负奖励。

-

策略 (Policy): 强化学习算法学习到的策略,用于根据当前状态选择最优的动作。

通过强化学习算法(例如,深度Q网络 (DQN), 策略梯度法 (Policy Gradient))训练智能体,使其学习到一个最优策略,能够根据当前状态选择最优的关联动作,从而实现准确可靠的多目标跟踪。

三、算法设计与Matlab实现

本节将以DQN为例,简要介绍基于强化学习的MOT算法设计,并提供相应的Matlab代码片段。 由于篇幅限制,我们只提供核心部分的代码,完整的代码需要更多模块的支持,例如目标检测、特征提取等。

te);

% 辅助函数 (示例)

function reward = calculateReward(action, state)

% 计算奖励,根据匹配精度等因素决定

end

function action = selectAction(q_values, epsilon)

% epsilon-greedy策略选择动作

end

function updateDQN(state, action, reward, nextState)

% 更新DQN网络参数

end

上述代码仅为简化示例,实际应用中需要考虑更复杂的场景和更精细的算法设计。 例如,需要设计更有效的状态表示方法,包含更丰富的目标信息(如外观特征、运动轨迹等);需要设计更合理的奖励函数,以引导智能体学习到更优的策略;需要选择合适的深度学习框架和优化算法,以提高训练效率和跟踪精度。

四、总结与展望

基于强化学习的多目标跟踪方法为解决MOT问题提供了新的思路和方法。通过将MOT任务建模为MDP,并利用强化学习算法训练智能体,可以有效地处理目标遮挡、快速运动以及目标外观变化等复杂场景。然而,该方法也面临一些挑战,例如,需要大量的训练数据,训练过程复杂,且算法的实时性需要进一步提高。 未来的研究方向可以集中在:设计更高效的强化学习算法,探索更有效的状态表示和奖励函数设计方法,以及结合其他技术(如图神经网络)来进一步提升MOT的性能。 同时,针对特定应用场景的定制化算法设计也是一个重要的研究方向。 相信随着强化学习技术和计算机视觉技术的不断发展,基于强化学习的多目标跟踪方法将会在实际应用中发挥越来越重要的作用。

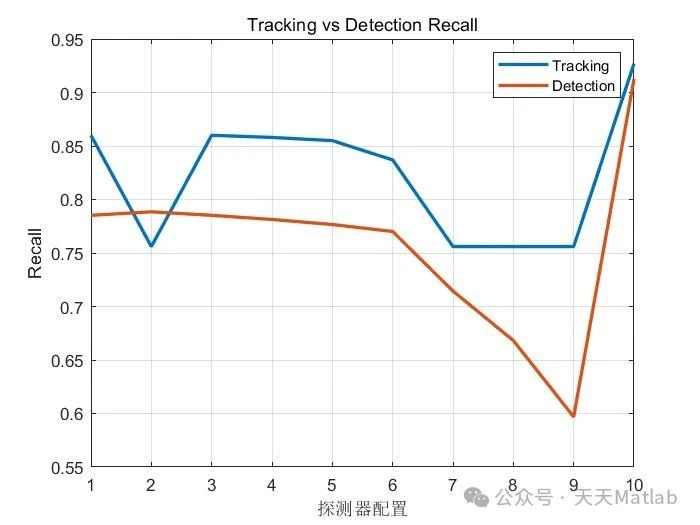

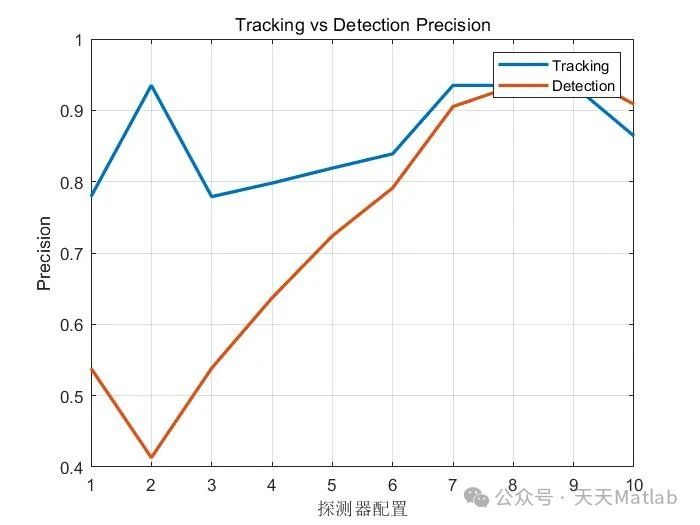

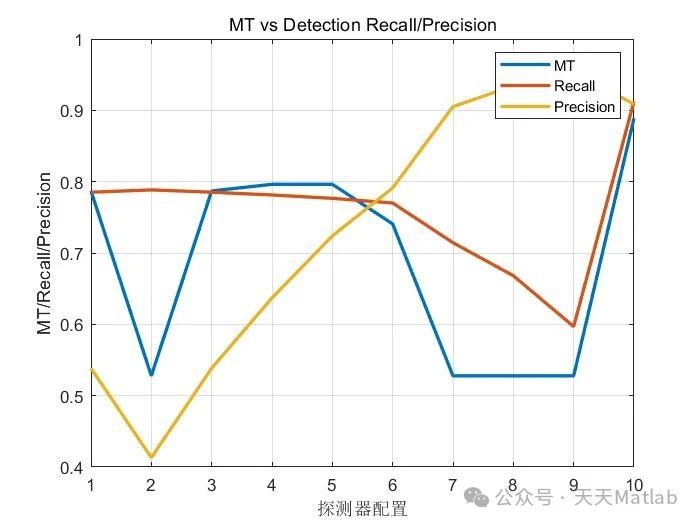

⛳️ 运行结果

🔗 参考文献

🎈 部分理论引用网络文献,若有侵权联系博主删除

🌈 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位

🌈 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

2079

2079

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?