极限学习机(Extreme Learning Machine) ELM,是由黄广斌提出来的求解单隐层神经网络的算法。

ELM最大的特点是对于传统的神经网络,尤其是单隐层前馈神经网络(SLFNs),在保证学习精度的前提下比传统的学习算法速度更快。

二、极限学习机的原理ELM是一种新型的快速学习算法,对于单隐层神经网络,ELM可以随机初始化输入权重和偏置并得到相应的输出权重。

(选自黄广斌老师的PPT)

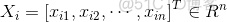

对于一个单隐层神经网络(见Figure 1),假设有 个任意的样本

个任意的样本 ,其中

,其中 ,

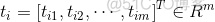

, 。对于一个有

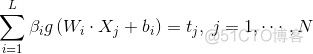

。对于一个有 个隐层节点的单隐层神经网络可以表示为

个隐层节点的单隐层神经网络可以表示为

其中, 为激活函数,

为激活函数, 为输入权重,

为输入权重, 为输出权重,

为输出权重, 是第

是第 个隐层单元的偏置。

个隐层单元的偏置。 表示

表示 和

和 的内积。

的内积。

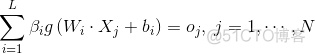

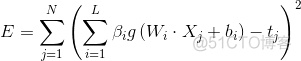

单隐层神经网络学习的目标是使得输出的误差最小,可以表示为

即存在 ,

, 和

和 ,使得

,使得

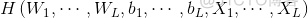

可以矩阵表示为

其中, 是隐层节点的输出,

是隐层节点的输出, 为输出权重,

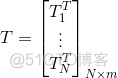

为输出权重, 为期望输出。

为期望输出。

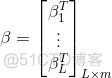

,

,

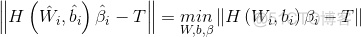

为了能够训练单隐层神经网络,我们希望得到 ,

, 和

和 ,使得

,使得

其中, ,这等价于最小化损失函数

,这等价于最小化损失函数

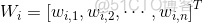

传统的一些基于梯度下降法的算法,可以用来求解这样的问题,但是基本的基于梯度的学习算法需要在迭代的过程中调整所有参数。而在ELM算法中, 一旦输入权重 和隐层的偏置

和隐层的偏置 被随机确定,隐层的输出矩阵

被随机确定,隐层的输出矩阵 就被唯一确定。训练单隐层神经网络可以转化为求解一个线性系统

就被唯一确定。训练单隐层神经网络可以转化为求解一个线性系统 。并且输出权重

。并且输出权重 可以被确定

可以被确定

其中, 是矩阵

是矩阵 的Moore-Penrose广义逆。且可证明求得的解

的Moore-Penrose广义逆。且可证明求得的解 的范数是最小的并且唯一。

的范数是最小的并且唯一。

三、粒子群算法

粒子群算法是在1995年由Eberhart博士和Kennedy博士一起提出的,它源于对鸟群捕食行为的研究。它的基本核心是利用群体中的个体对信息的共享从而使整个群体的运动在问题求解空间中产生从无序到有序的演化过程,从而获得问题的最优解。设想这么一个场景:一群鸟进行觅食,而远处有一片玉米地,所有的鸟都不知道玉米地到底在哪里,但是它们知道自己当前的位置距离玉米地有多远。那么找到玉米地的最佳策略,也是最简单有效的策略就是搜寻目前距离玉米地最近的鸟群的周围区域。

在PSO中,每个优化问题的解都是搜索空间中的一只鸟,称之为"粒子",而问题的最优解就对应于鸟群中寻找的"玉米地"。所有的粒子都具有一个位置向量(粒子在解空间的位置)和速度向量(决定下次飞行的方向和速度),并可以根据目标函数来计算当前的所在位置的适应值(fitness value),可以将其理解为距离"玉米地"的距离。在每次的迭代中,种群中的例子除了根据自身的经验(历史位置)进行学习以外,还可以根据种群中最优粒子的"经验"来学习,从而确定下一次迭代时需要如何调整和改变飞行的方向和速度。就这样逐步迭代,最终整个种群的例子就会逐步趋于最优解。

上面的解释可能还比较抽象,下面通过一个简单的例子来进行说明

在一个湖中有两个人他们之间可以通信,并且可以探测到自己所在位置的最低点。初始位置如上图所示,由于右边比较深,因此左边的人会往右边移动一下小船。

现在左边比较深,因此右边的人会往左边移动一下小船

一直重复该过程,最后两个小船会相遇

得到一个局部的最优解

将每个个体表示为粒子。每个个体在某一时刻的位置表示为,x(t),方向表示为v(t)

p(t)为在t时刻x个体的自己的最优解,g(t)为在t时刻所有个体的最优解,v(t)为个体在t时刻的方向,x(t)为个体在t时刻的位置

下一个位置为上图所示由x,p,g共同决定了

种群中的粒子通过不断地向自身和种群的历史信息进行学习,从而可以找到问题的最优解。

但是,在后续的研究中表表明,上述原始的公式中存在一个问题:公式中V的更新太具有随机性,从而使整个PSO算法的全局优化能力很强,但是局部搜索能力较差。而实际上,我们需要在算法迭代初期PSO有着较强的全局优化能力,而在算法的后期,整个种群应该具有更强的局部搜索能力。所以根据上述的弊端,shi和Eberhart通过引入惯性权重修改了公式,从而提出了PSO的惯性权重模型:

每一个向量的分量表示如下

其中w称为是PSO的惯性权重,它的取值介于【0,1】区间,一般应用中均采用自适应的取值方法,即一开始令w=0.9,使得PSO全局优化能力较强,随着迭代的深入,参数w进行递减,从而使的PSO具有较强的局部优化能力,当迭代结束时,w=0.1。参数c1和c2称为学习因子,一般设置为1,4961;而r1和r2为介于[0,1]之间的随机概率值。

整个粒子群优化算法的算法框架如下:

step1种群初始化,可以进行随机初始化或者根据被优化的问题设计特定的初始化方法,然后计算个体的适应值,从而选择出个体的局部最优位置向量和种群的全局最优位置向量。

step2 迭代设置:设置迭代次数,并令当前迭代次数为1

step3 速度更新:更新每个个体的速度向量

step4 位置更新:更新每个个体的位置向量

step5 局部位置和全局位置向量更新:更新每个个体的局部最优解和种群的全局最优解

step6 终止条件判断:判断迭代次数时都达到最大迭代次数,如果满足,输出全局最优解,否则继续进行迭代,跳转至step 3。

对于粒子群优化算法的运用,主要是对速度和位置向量迭代算子的设计。迭代算子是否有效将决定整个PSO算法性能的优劣,所以如何设计PSO的迭代算子是PSO算法应用的研究重点和难点。

四、演示代码

146

146

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?