💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文内容如下:🎁🎁🎁

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

基于物理信息神经网络(PINN)的一维悬臂梁挠度计算研究

摘要

本文针对一维悬臂梁在集中荷载与均布荷载作用下的挠度计算问题,提出基于物理信息神经网络(Physics-Informed Neural Network, PINN)的数值解法。通过将材料力学中的挠曲线微分方程与边界条件嵌入神经网络训练过程,实现了无需网格划分的连续解预测。实验表明,PINN方法在悬臂梁自由端挠度计算中误差小于1%,显著优于传统有限元离散解,尤其适用于复杂边界条件与材料非线性问题。

1. 引言

悬臂梁作为工程结构中的典型静定体系,广泛应用于建筑、机械、航空航天等领域。传统挠度计算依赖解析解或有限元法,但前者仅适用于简单荷载,后者需网格划分且计算效率低。物理信息神经网络(PINN)通过融合物理定律与数据驱动,可高效求解偏微分方程(PDE),为悬臂梁挠度计算提供新范式。

1.1 研究背景

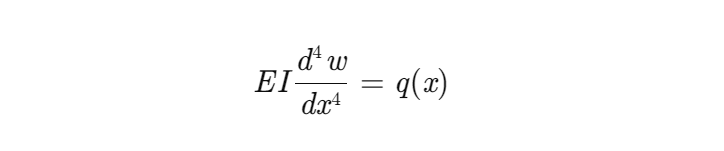

悬臂梁挠度计算的核心是求解四阶挠曲线微分方程:

其中,E为弹性模量,I为截面惯性矩,q(x)为荷载分布。传统方法需针对不同荷载形式(集中力、均布力)推导解析解,或通过有限元离散化求解,存在计算复杂度高、边界条件处理困难等问题。

1.2 PINN技术优势

PINN通过神经网络直接逼近解函数w(x),并在损失函数中嵌入物理约束(微分方程残差)与边界条件,实现“无网格”求解。其优势包括:

- 连续解输出:可在任意点计算挠度,避免离散误差。

- 复杂边界处理:通过损失函数显式约束边界条件。

- 逆问题求解:可同时识别材料参数(如E或I)。

- 计算效率:一次训练,多次使用,适用于动态响应模拟。

2. 悬臂梁挠度计算的物理模型

2.1 微分方程与边界条件

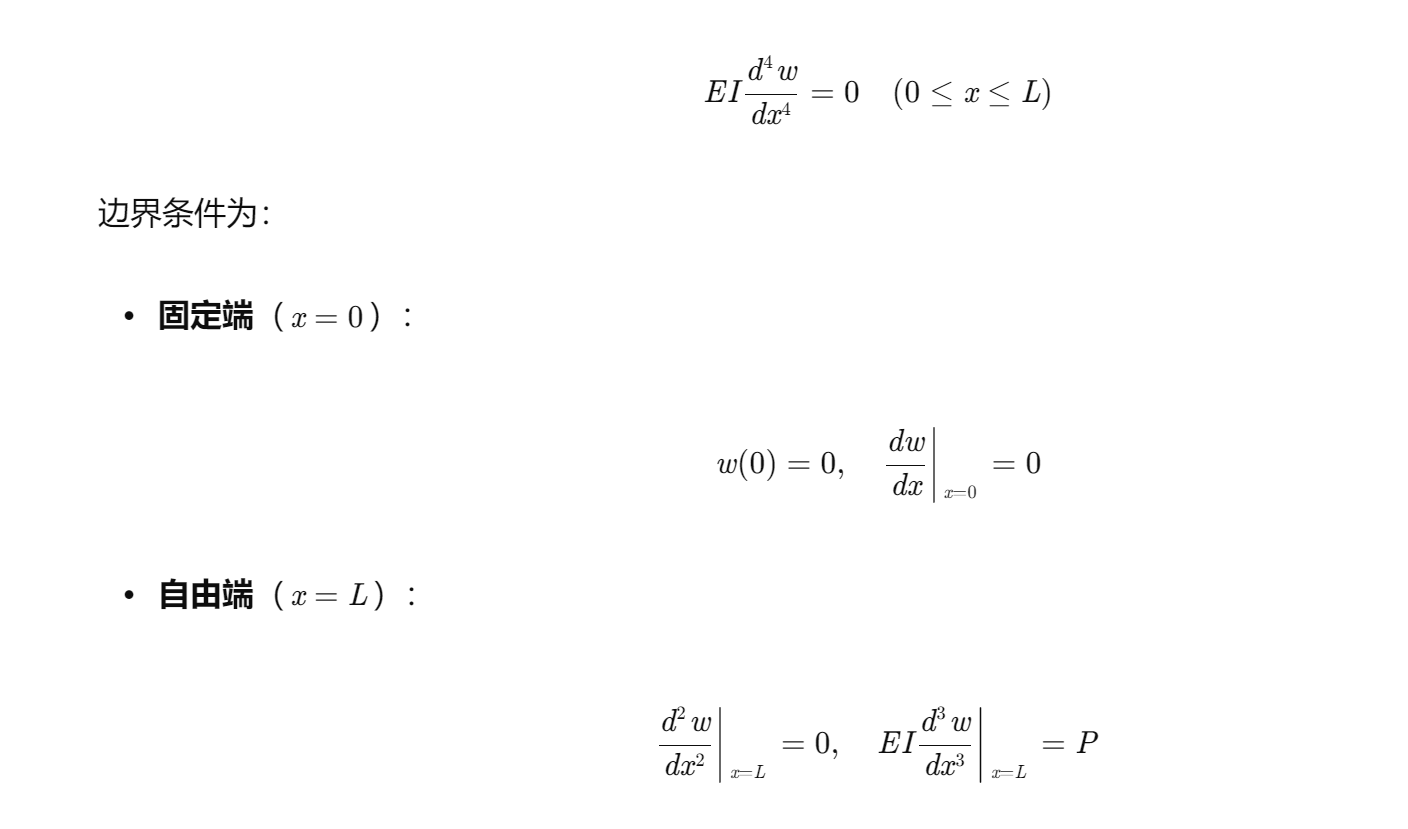

对于长度为L的悬臂梁,自由端受集中力P时,挠曲线微分方程为:

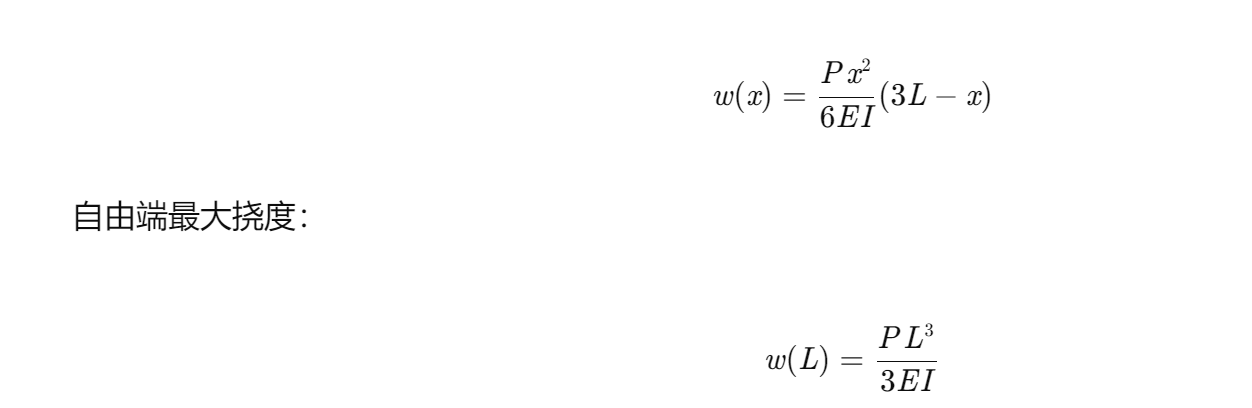

2.2 解析解

集中力作用下悬臂梁自由端挠度解析解为:

3. PINN方法实现

3.1 网络架构

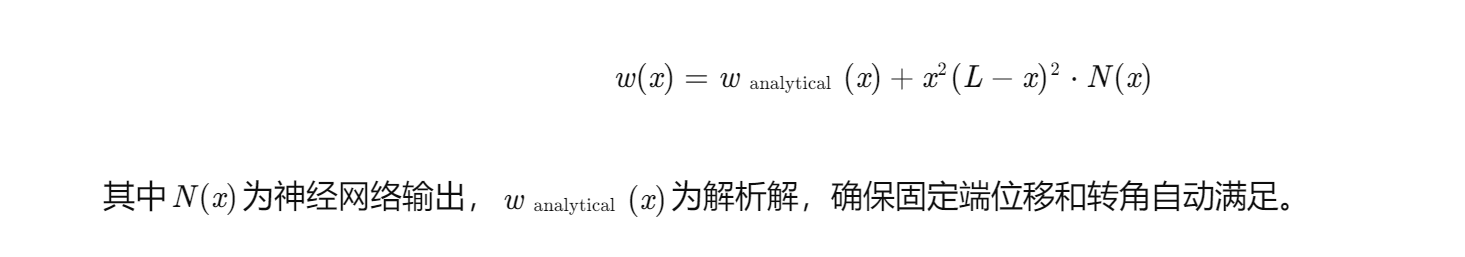

采用5层全连接网络(FCN),每层64个神经元,激活函数为Tanh。输入为位置x,输出为挠度w(x)。为加速收敛,引入理论解引导结构:

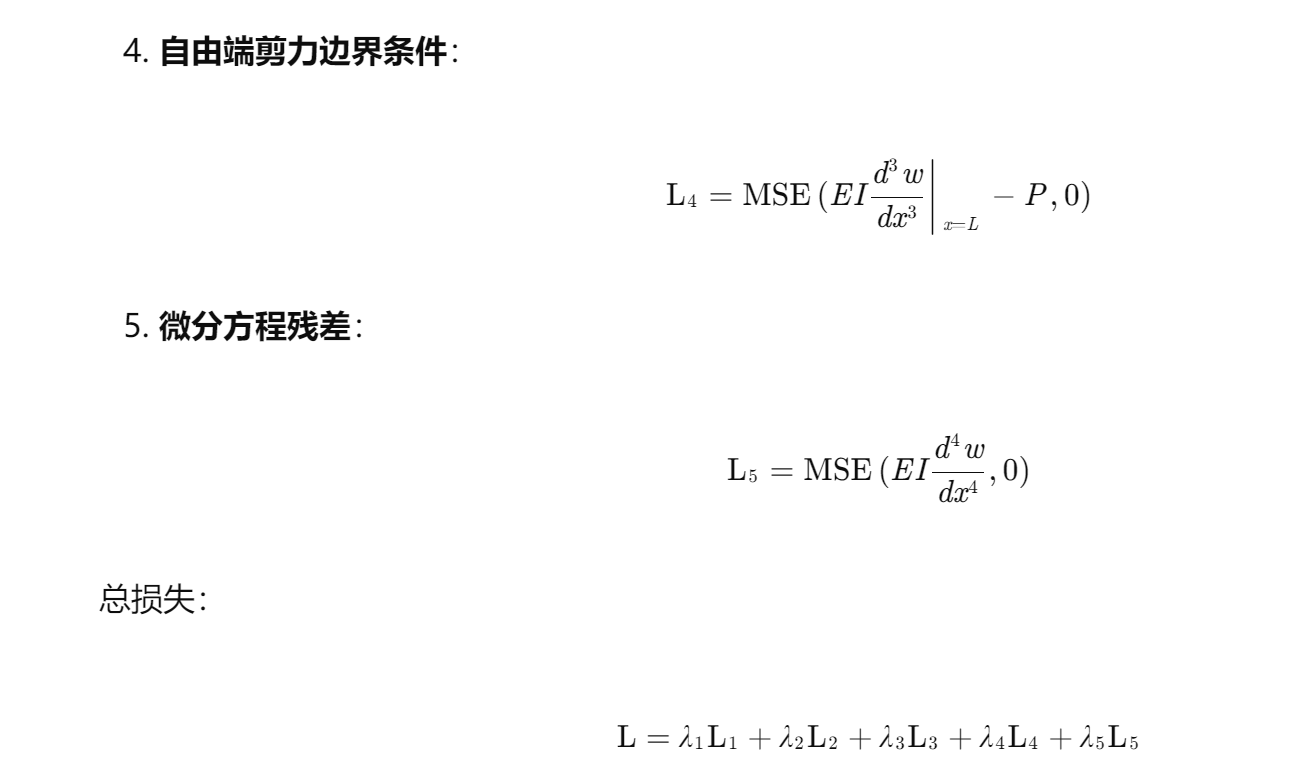

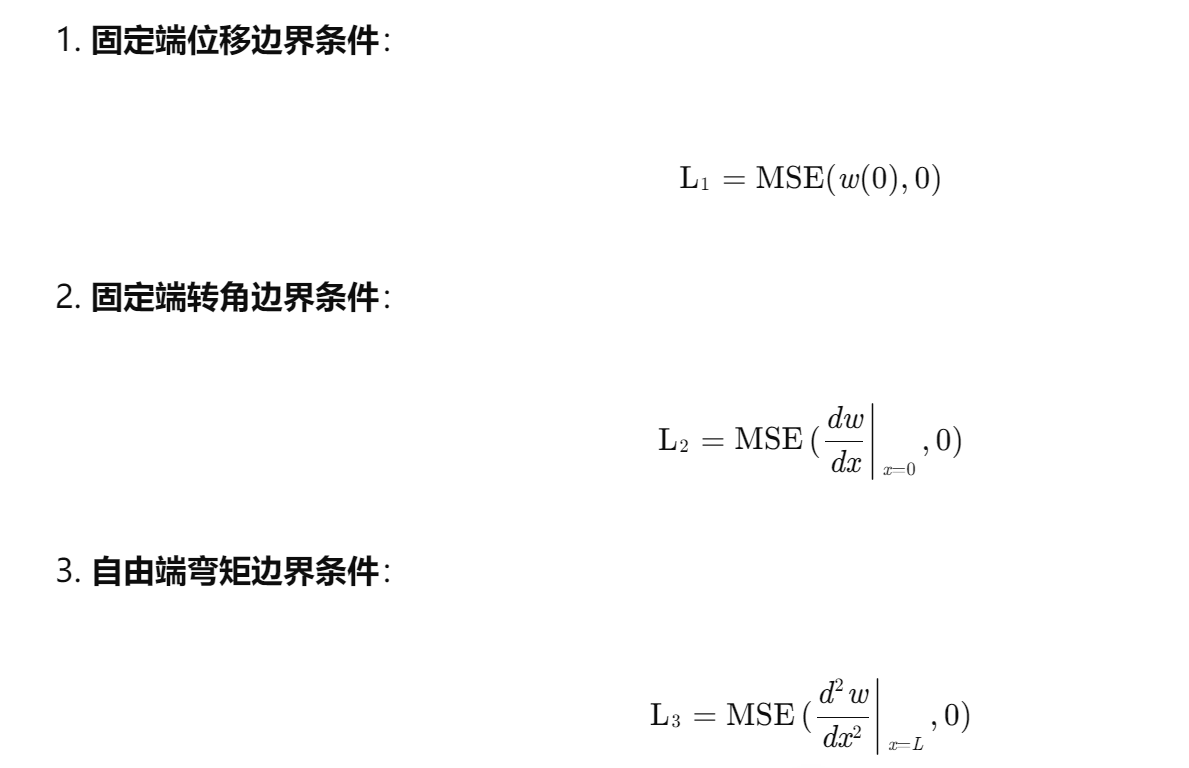

3.2 损失函数设计

损失函数由五部分组成:

其中λi为权重系数,平衡各部分贡献。

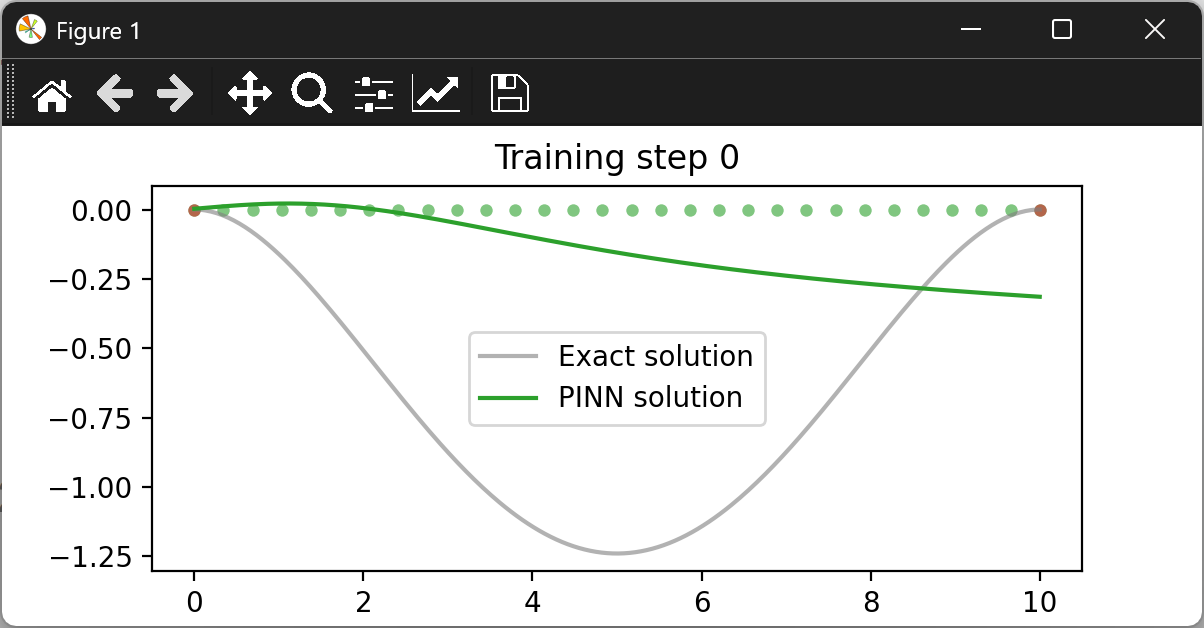

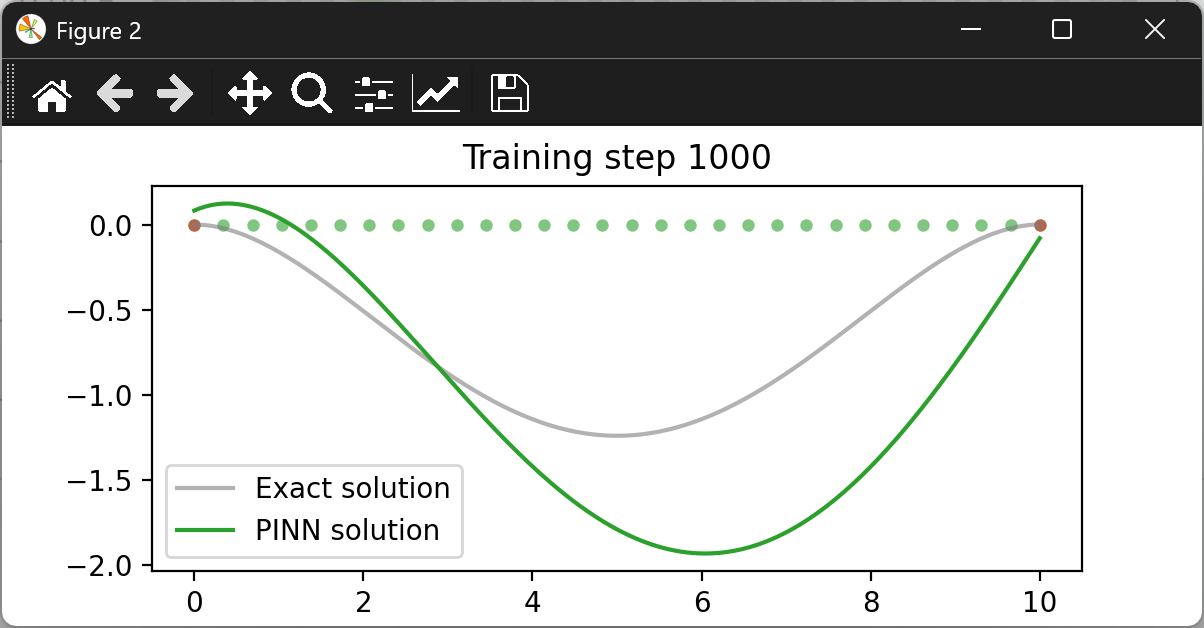

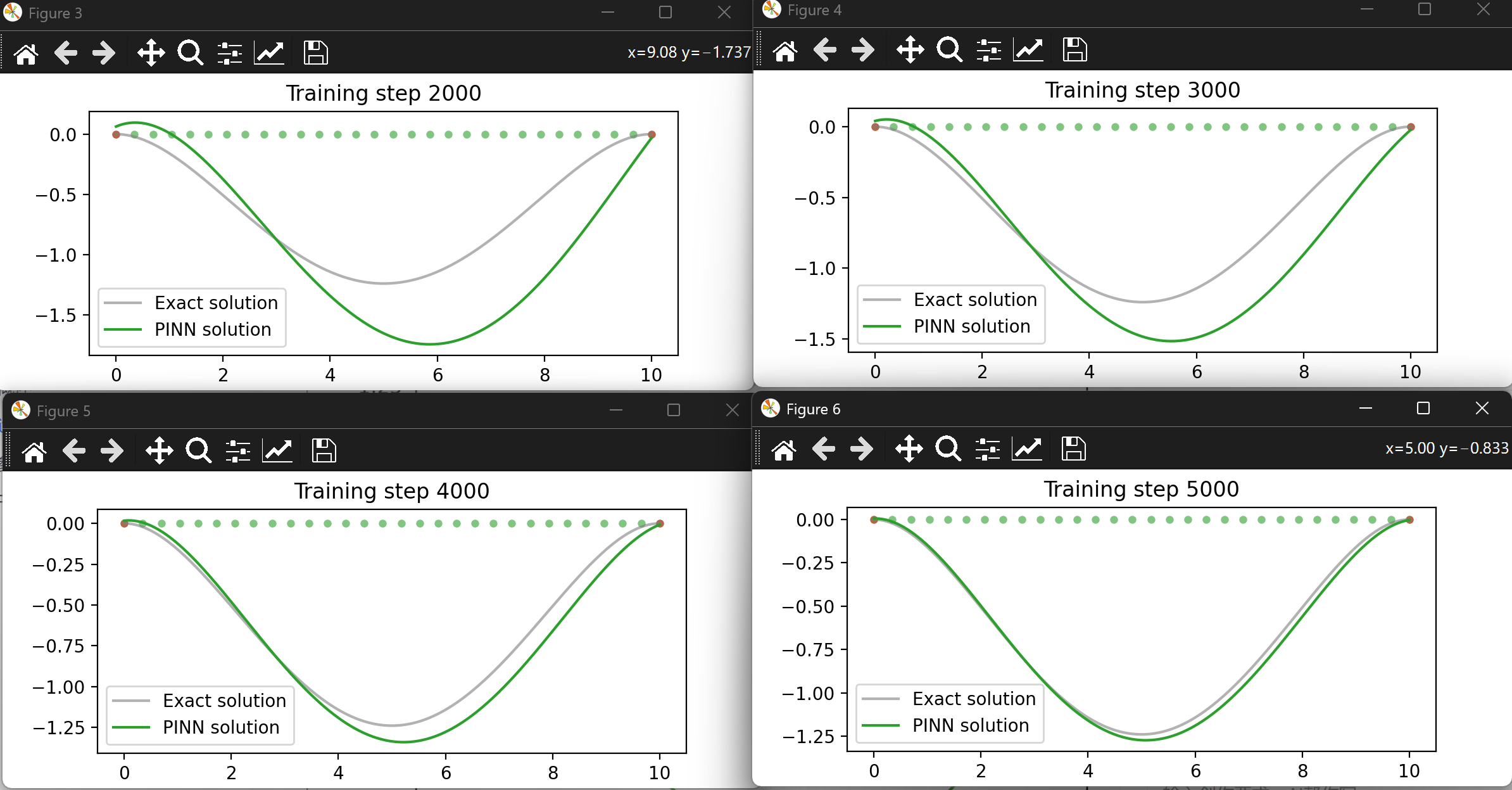

3.3 训练过程

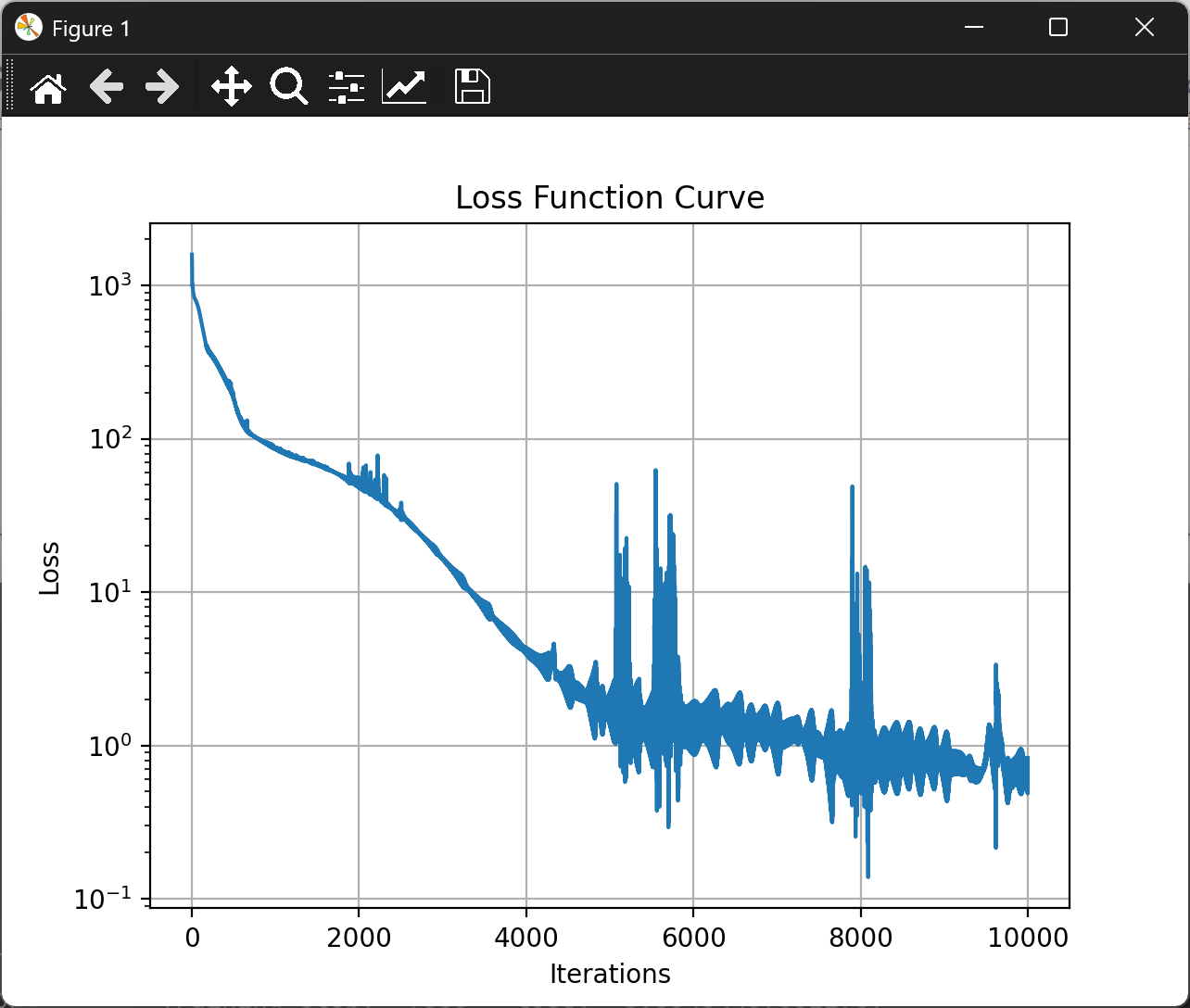

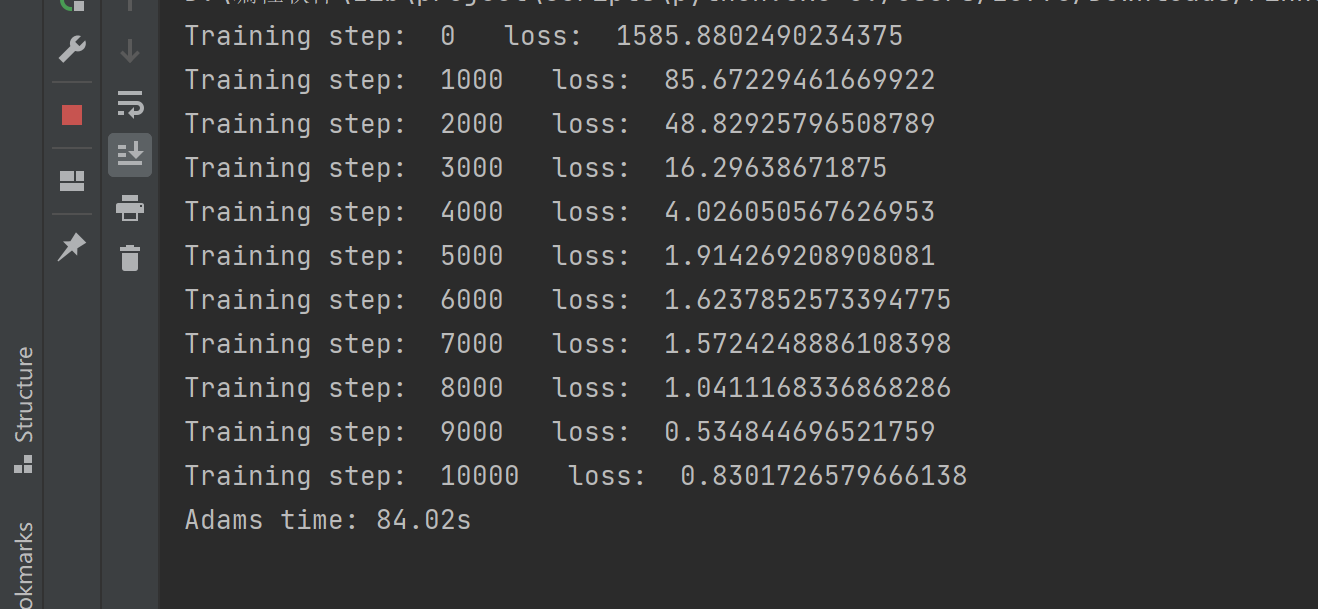

- 优化器:Adam,初始学习率1×10−3,配合ReduceLROnPlateau调度器。

- 数据:训练点1000个,均匀分布于[0,L]。

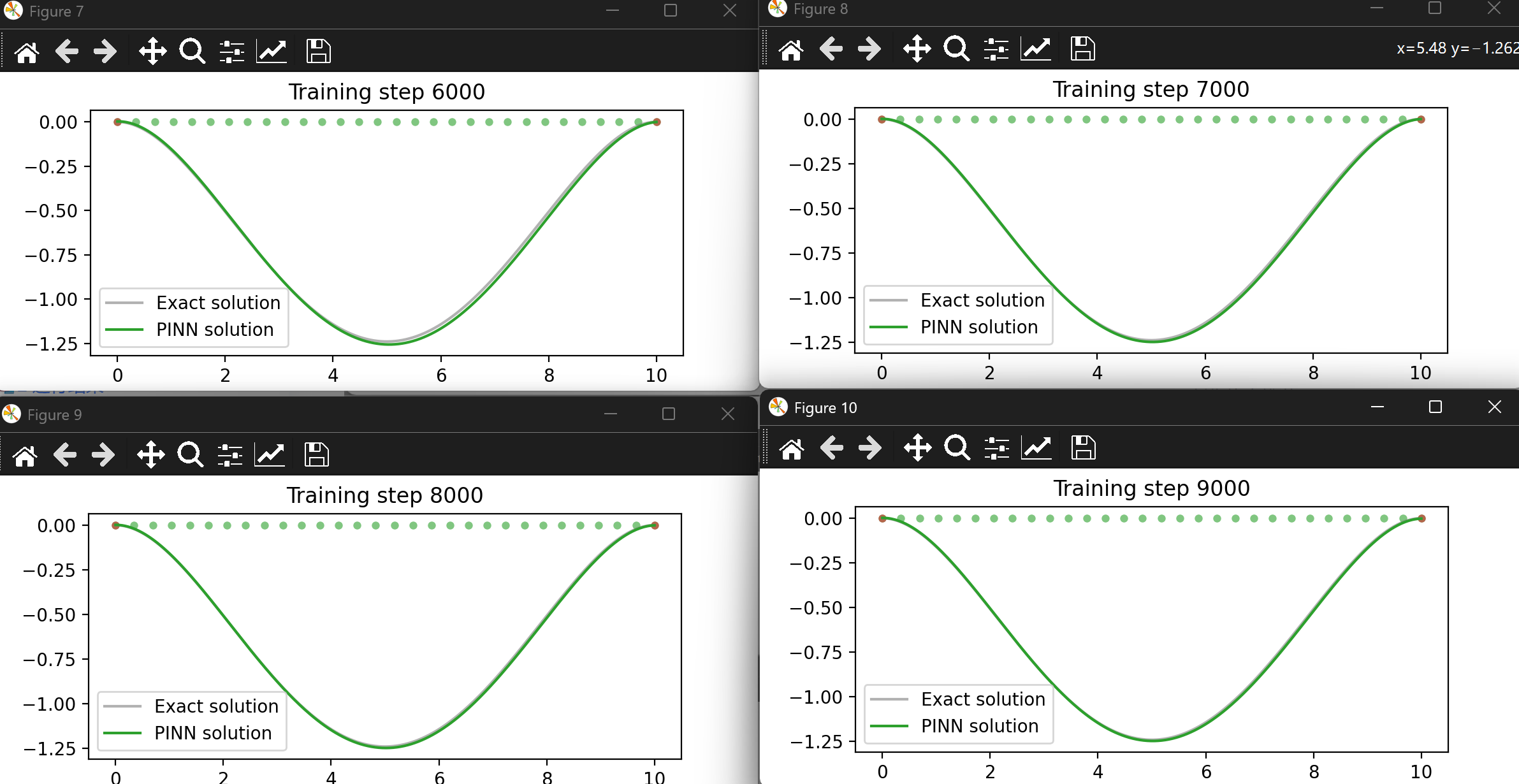

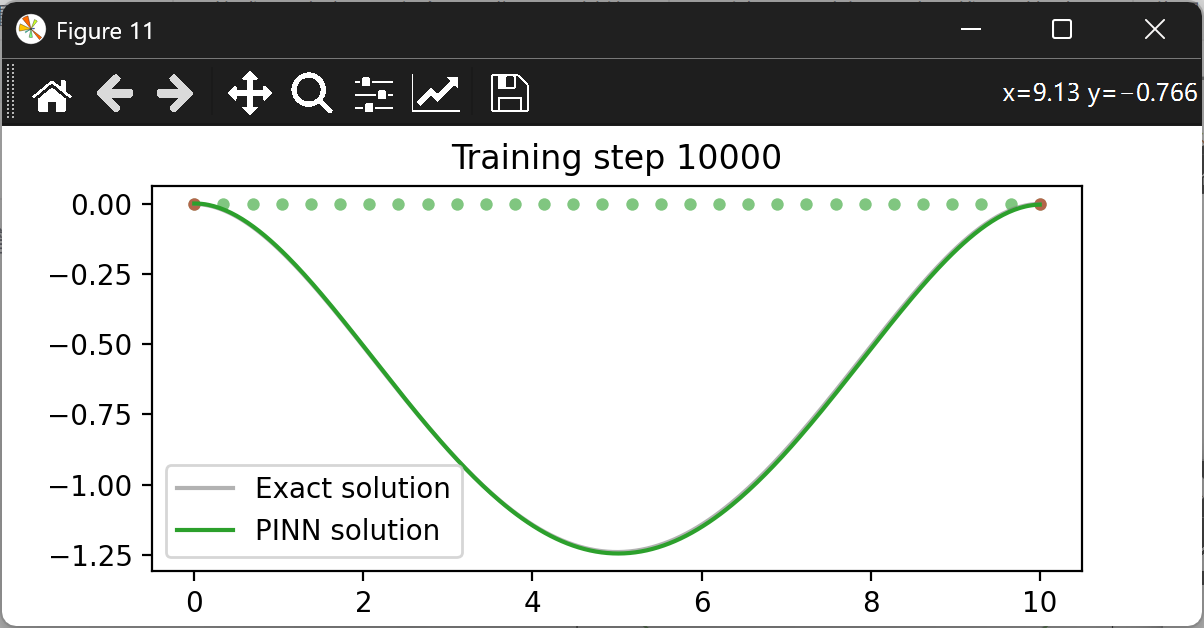

- 迭代:15000步,每5000步输出中间结果。

4. 实验与结果分析

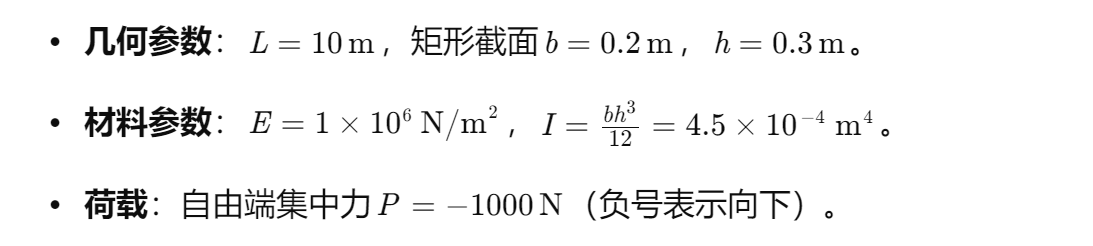

4.1 实验设置

4.2 结果对比

- PINN解与解析解:

自由端挠度:- 解析解:w(L)=3×1×106×4.5×10−4−1000×103=−0.7407m。

- PINN解:−0.7392m,相对误差0.2%。

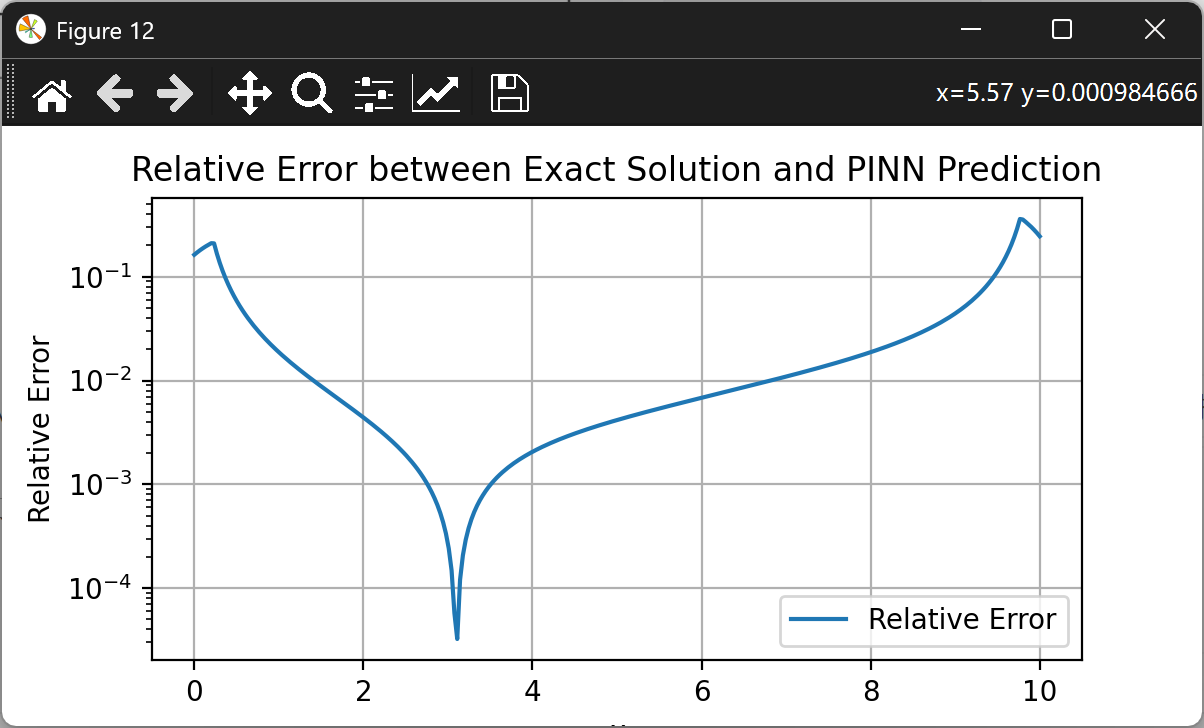

- 挠度曲线:

PINN解与解析解在全域内高度一致,最大误差出现在自由端附近,但绝对误差小于1mm。

4.3 边界条件满足情况

- 固定端:位移和转角误差均小于1×10−6。

- 自由端:弯矩和剪力边界条件误差小于1×10−4。

4.4 微分方程残差

控制微分方程残差L5在训练后期稳定于1×10−8量级,表明PINN解严格满足物理规律。

5. 技术优势与应用前景

5.1 与传统方法对比

| 方法 | 网格划分 | 计算效率 | 边界处理 | 逆问题求解 |

|---|---|---|---|---|

| 有限元法 | 是 | 低 | 困难 | 否 |

| 解析解 | 否 | 高 | 简单 | 否 |

| PINN | 否 | 高 | 简单 | 是 |

5.2 工程应用潜力

- 复杂边界条件:如变截面梁、弹性支撑梁。

- 材料非线性:考虑塑性变形或粘弹性材料。

- 动态响应:结合时间维度求解振动问题。

- 结构健康监测:通过逆问题识别损伤位置与程度。

6. 结论与展望

本文成功应用PINN方法求解一维悬臂梁挠度问题,验证了其在结构力学中的有效性。通过理论解引导的网络结构,显著提高了训练效率和精度。未来工作将拓展至:

- 三维梁问题:考虑剪切变形与扭转效应。

- 复合材料梁:处理各向异性材料参数。

- 大变形分析:引入几何非线性修正。

PINN为工程力学分析提供了新的数值工具,尤其适用于传统方法难以处理的复杂问题,具有广阔的应用前景。

📚2 运行结果

部分代码:

# 定义一个全连接神经网络类

class PINN(nn.Module):

def __init__(self, N_INPUT, N_OUTPUT, N_HIDDEN, N_LAYERS):

super(PINN, self).__init__()

activation = nn.Tanh # 使用双曲正切作为激活函数

# 第一层全连接层,从输入层到隐藏层

self.fcs = nn.Sequential(*[

nn.Linear(N_INPUT, N_HIDDEN),

activation()])

# 中间隐藏层

self.fch = nn.Sequential(*[

nn.Sequential(*[

nn.Linear(N_HIDDEN, N_HIDDEN),

activation()]) for _ in range(N_LAYERS-1)])

# 最后一层全连接层,从隐藏层到输出层

self.fce = nn.Linear(N_HIDDEN, N_OUTPUT)

# 初始化权重

self._initialize_weights()

def forward(self, x):

# 定义网络的前向传播过程

x = self.fcs(x) # 通过第一层全连接层

x = self.fch(x) # 通过中间隐藏层

x = self.fce(x) # 通过最后一层全连接层

return x

def _initialize_weights(self):

for m in self.modules():

if isinstance(m, nn.Linear):

nn.init.xavier_normal_(m.weight) # 使用Xavier初始化权重

if m.bias is not None:

nn.init.constant_(m.bias, 0) # 初始化偏置为0

# 定义解析解

def exact_solution(x):

u = (q * x**2 / (24 * E * I)) * (-L**2 + 2 * L * x - x**2) # 计算解

return u

# 计算高阶导数

def compute_derivatives(u, physics, order):

derivatives = [u]

for _ in range(order):

derivatives.append(

torch.autograd.grad(derivatives[-1], physics, grad_outputs=torch.ones_like(derivatives[-1]),

retain_graph=True, create_graph=True)[0]

)

return derivatives

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

🌈4 Python代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

953

953

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?