递归神经网络(RNN)

RNN是最强大的模型之一,它使我们能够开发如分类、序列数据标注、生成文本序列(例如预测下一输入词的SwiftKey keyboard应用程序),以及将一个序列转换为另一个序列(比如从法语翻译成英语的语言翻译)等应用程序。大多数模型架构(如前馈神经网络)都没有利用数据的序列特性。例如,我们需要数据呈现出向量中每个样例的特征,如表示句子、段落或文档的所有token。前馈网络的设计只是为了一次性地查看所有特征并将它们映射到输出。让我们看一个文本示例,它显示了为什么顺序或序列特性对文本很重要。I had cleaned my car和I had my car cleaned两个英文句子,用同样的单词,但只有考虑单词的顺序时,它们才意味着不同的含义。

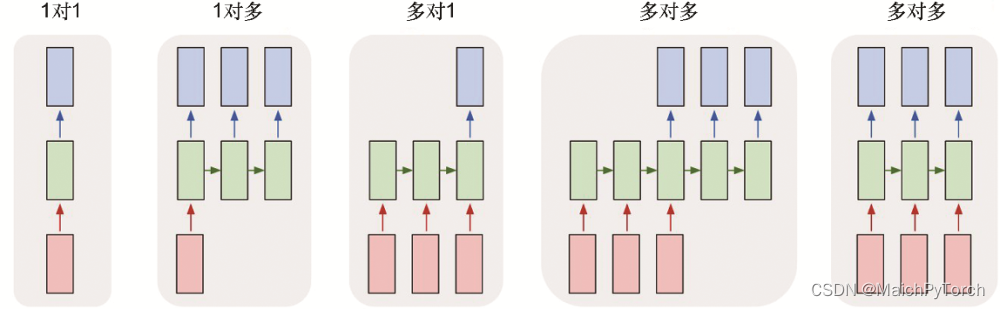

人类通过从左到右阅读词序列来理解文本,并构建了可以理解文本数据中所有不同内容的强大模型。RNN的工作方式有些许类似,每次只查看文本中的一个词。RNN也是一种包含某特殊层的神经网络,它并不是一次处理所有数据而是通过循环来处理数据。由于RNN可以按顺序处理数据,因此可以使用不同长度的向量并生成不同长度的输出。图6.3提供了一些不同的表示形式。

递归神经网络(RNN)是强大的模型,适用于处理序列数据,如文本分类、序列标注和语言翻译。RNN通过循环处理数据,保留序列信息,允许不同长度的输入和输出。本文介绍了RNN的工作原理,包括状态向量的传递和输出向量的生成,以及如何通过Python代码实现RNN。

递归神经网络(RNN)是强大的模型,适用于处理序列数据,如文本分类、序列标注和语言翻译。RNN通过循环处理数据,保留序列信息,允许不同长度的输入和输出。本文介绍了RNN的工作原理,包括状态向量的传递和输出向量的生成,以及如何通过Python代码实现RNN。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6267

6267

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?