立个flag,这是未来一段时间打算做的Python教程,敬请关注。

1 数据及应用领域

2 算法理论基础

3 SHAP 理论基础

上述三条目录的基本原理已在前置推文中做过详细介绍,需要学习了解的请转到如下链接:

https://mp.weixin.qq.com/s/Kq6_UHmOP0Efml5ztlZOAw

✔ 程序能画非常直观的可视化

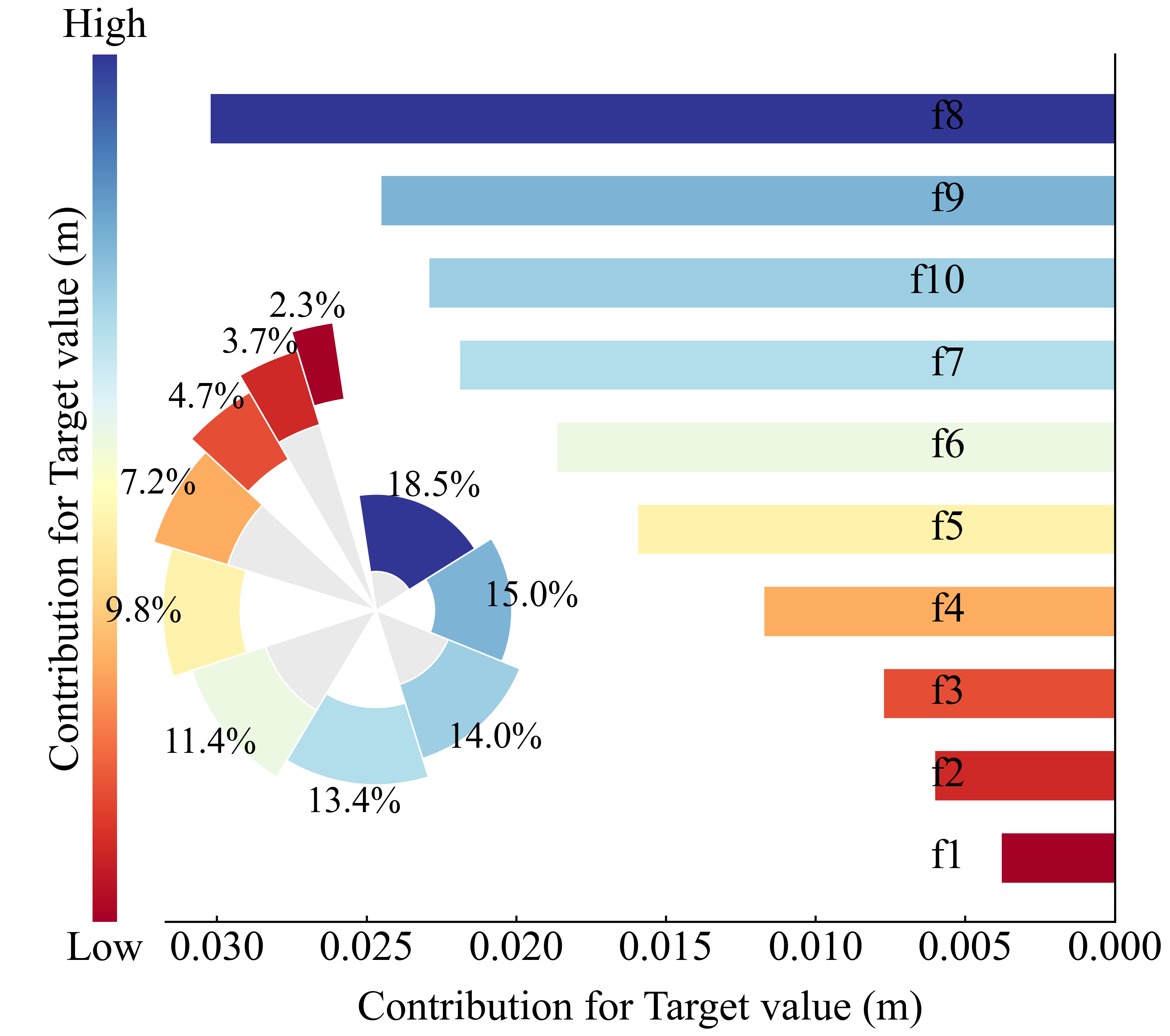

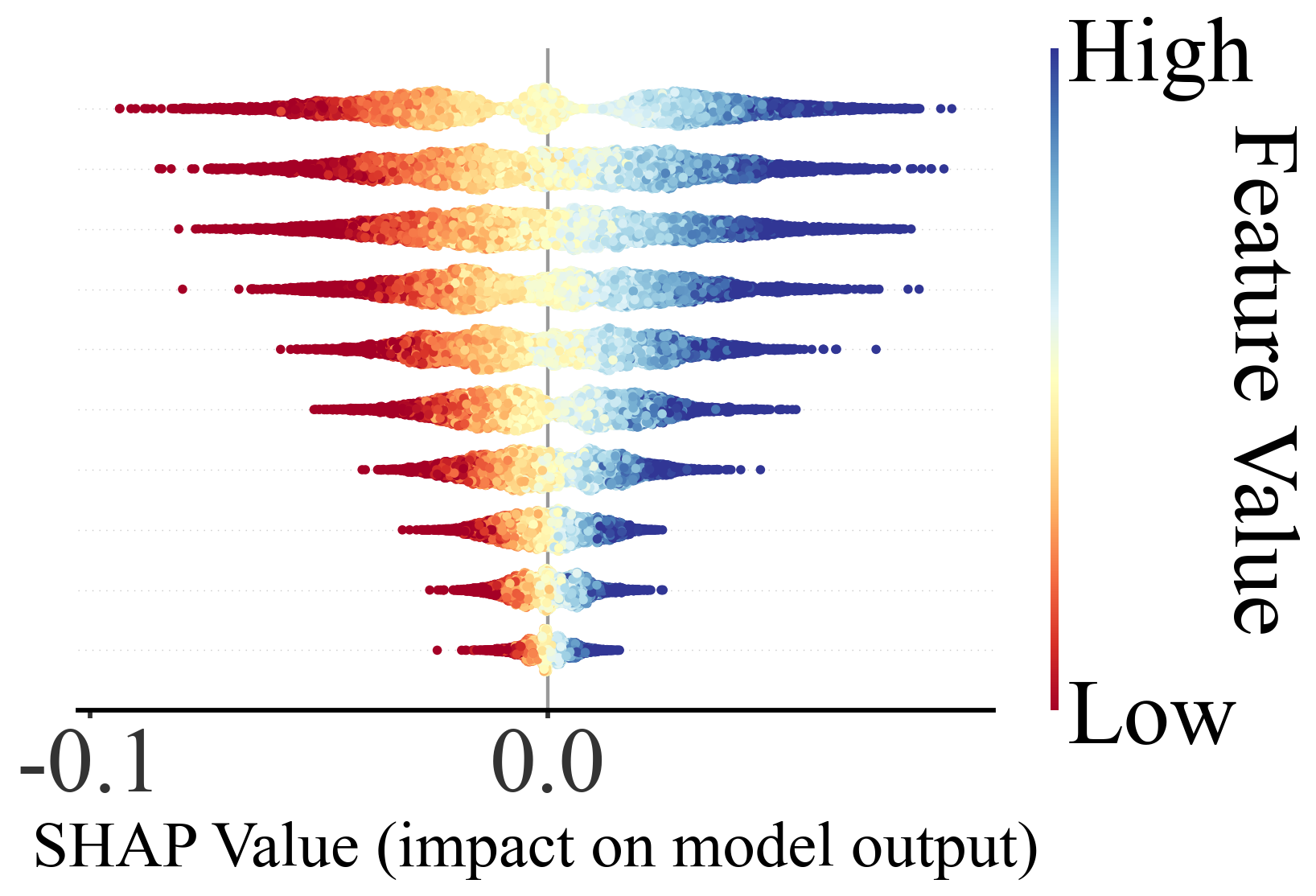

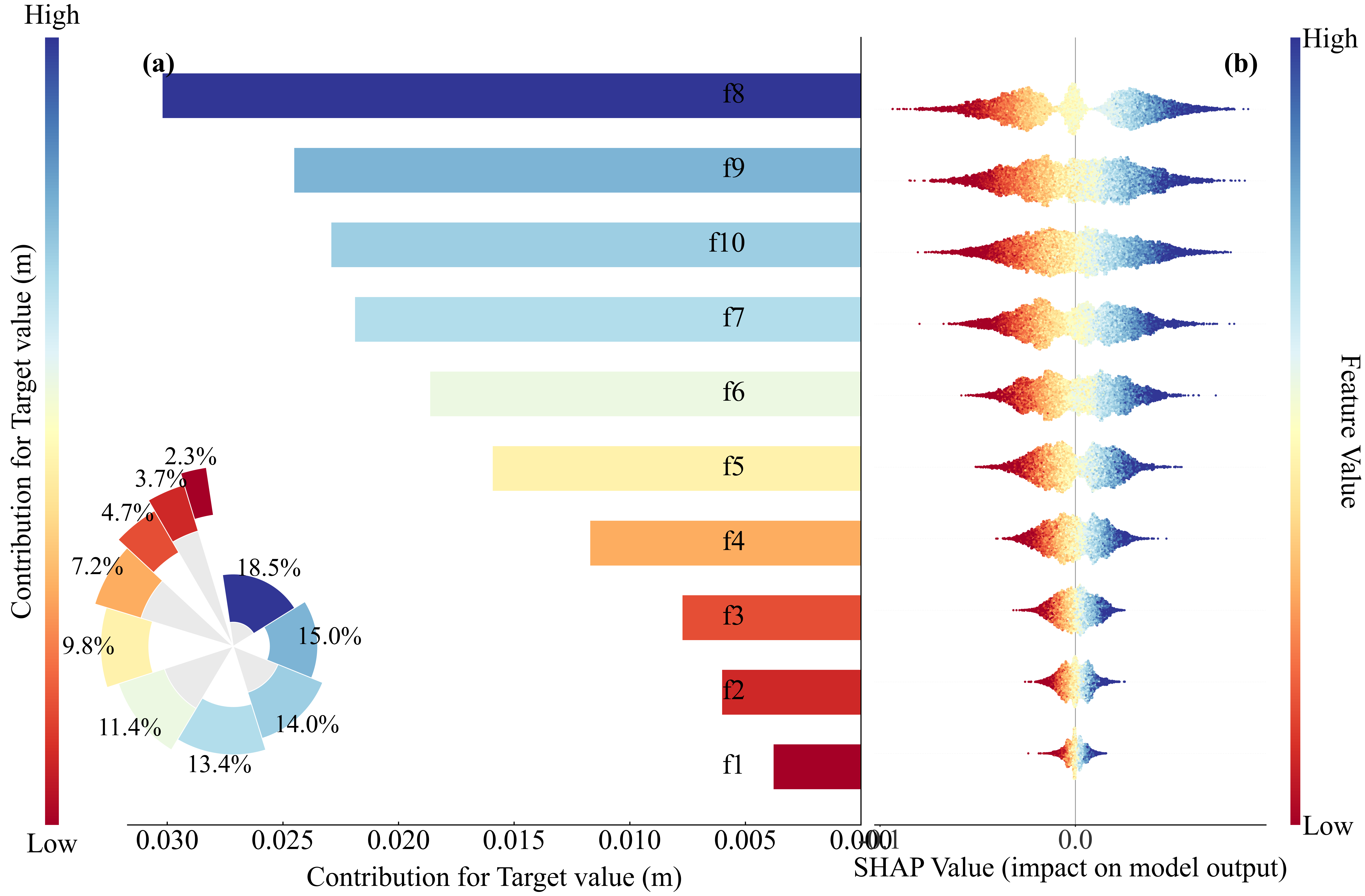

本程序SHAP带的图包括:

这些图都是发论文神器。

论文价值:可解释性直接提升一档

SCI 论文里 reviewer 最爱问:

-

“模型的物理解释是什么?”

-

“为什么这个特征如此重要?”

-

“模型是不是只是黑盒?”

你用 SHAP,一张 beeswarm plot 就能回答所有问题。

无论你是:XGBoost、CatBoost、LightGBM、Random Forest、Gradient Boosting、NGBoost、决策树,SHAP 都能解释。

4 其他图示

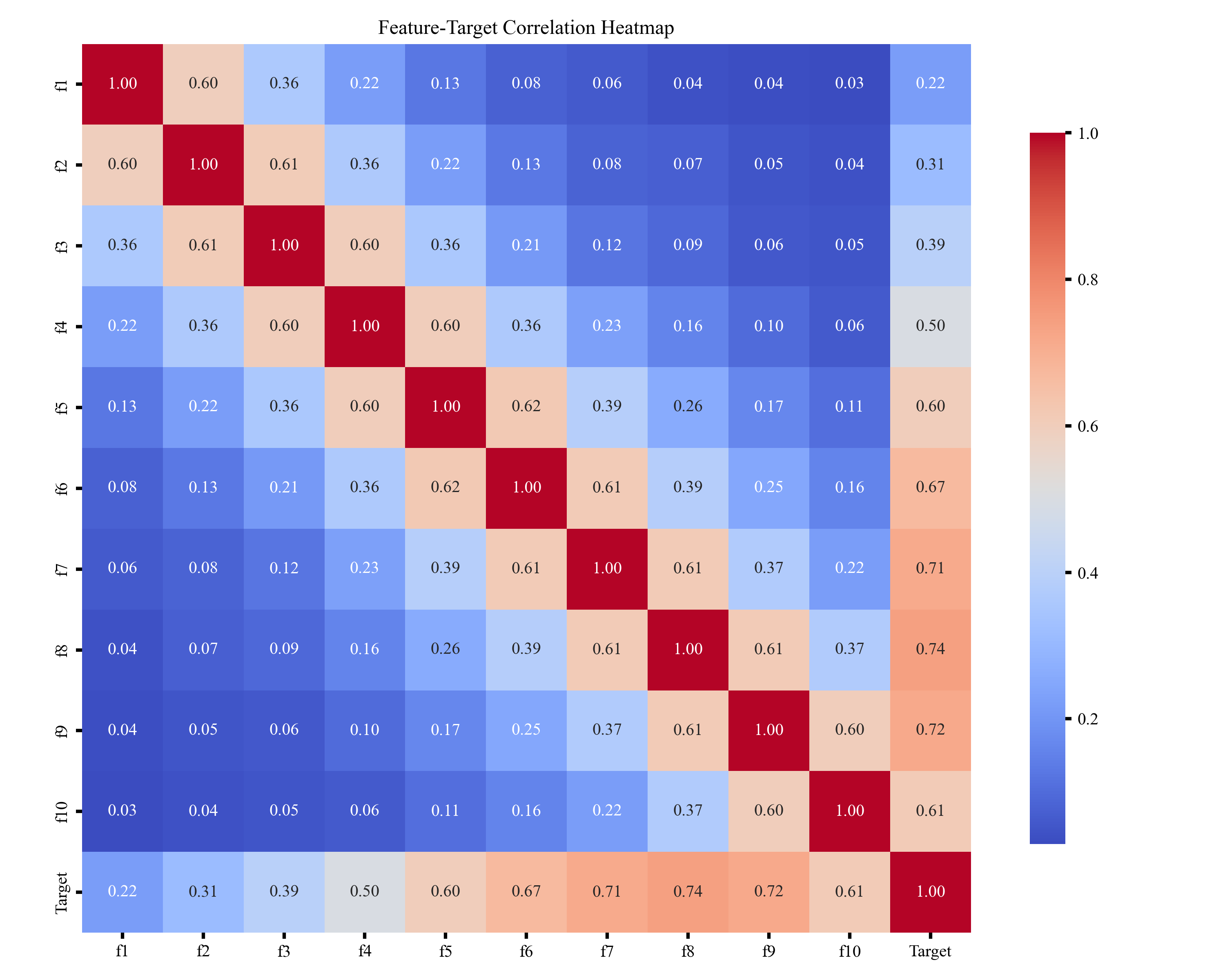

🎲 一、特征值相关性热图

特征值相关性热图用于展示各特征之间的相关强弱,通过颜色深浅体现正负相关关系,帮助快速识别冗余特征、强相关特征及可能影响模型稳定性的变量,为后续特征选择和建模提供参考。

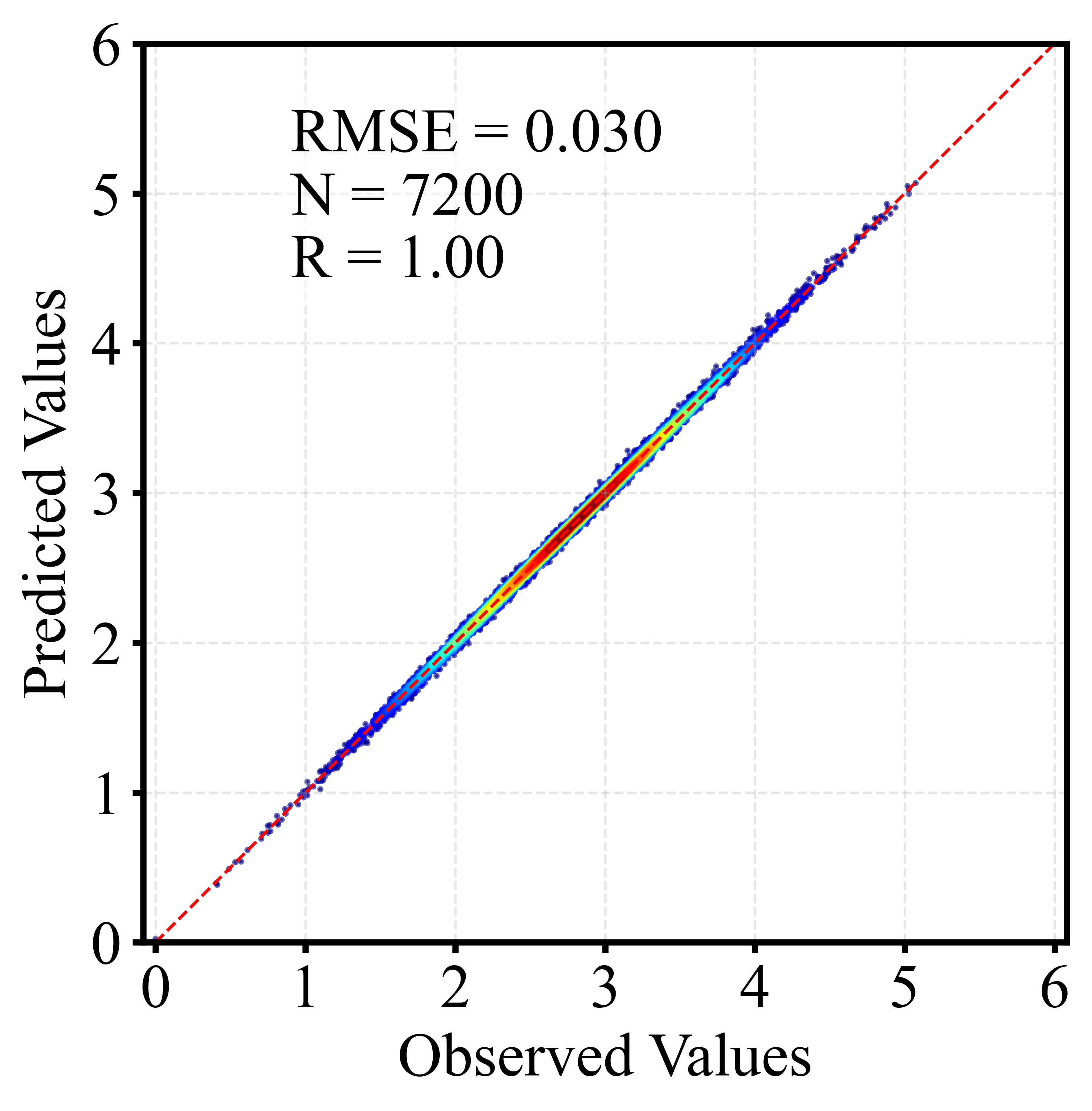

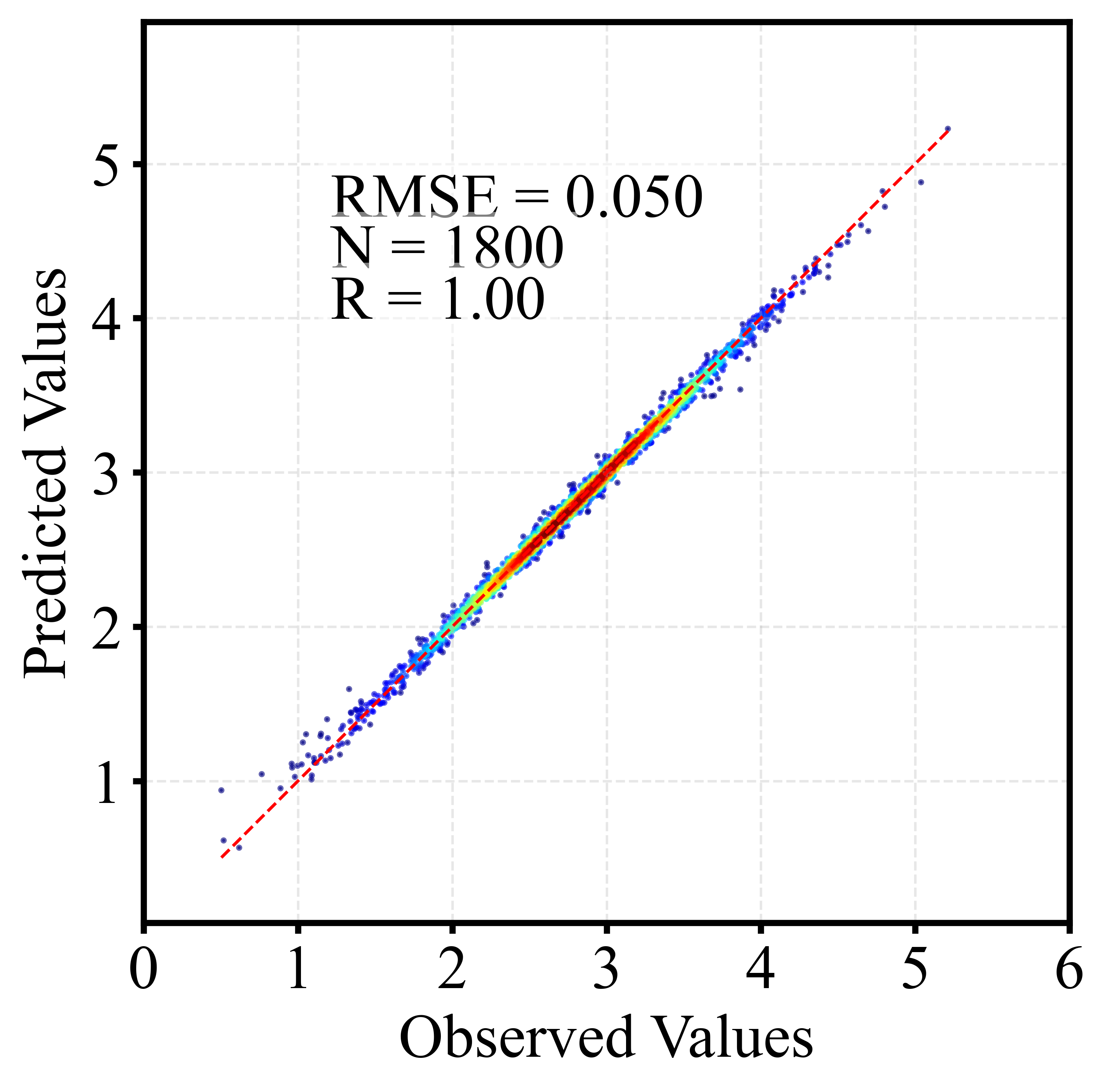

🎲 二、散点密度图

散点密度图通过颜色或亮度反映点的聚集程度,用于展示大量样本的分布特征。相比普通散点图,它能更直观地呈现高密度区域、异常点及整体趋势,常用于回归分析与模型评估。以下为训练集和测试集出图效果。

🎲 三、随机搜索参数优化算法及示意图

🌟 1、随机搜索是什么?

一句话概括:

“随机搜索就是在超参数空间里不断“抽样试验”,从而找到表现最好的参数组合。

不同于按顺序走格子的调参方式,随机搜索会在整个参数空间中“自由跳跃”,每次从可能区域里随机挑选出一个参数组合,用最直接的方式评估模型的表现。

🌟 2、它的核心思路其实很聪明

虽然名字叫“随机”,但它背后的逻辑却非常高效。

✔ 1. 更广的覆盖范围

每次抽取的点都可能落在搜索空间的不同区域,让模型在有限的预算里探索更多潜在好参数。

✔ 2. 支持多种采样策略

你可以让 learning_rate 以对数分布抽取、让 n_estimators 偏向更大值,这让随机搜索能更贴近真实优化需求。

✔ 3. 每一次试验都独立有效

不依赖复杂的历史记录,适用于快速尝试、快速验证的场景。

换句话说: 它简单,但“简单得很有效”。

🌟 3、为什么它在实际调参中被广泛使用?

在许多模型中,超参数空间往往非常大,比如:

-

XGBoost 的树深、学习率、子采样比例

-

神经网络的学习率、层数、节点数

-

CatBoost、LightGBM 的几十种可调参数

随机搜索能在这些复杂空间里迅速落点—— 不需要把所有组合都跑一遍,也不需要构建额外的代理模型,只需要不断抽样并测试结果。尤其在遥感反演、深度学习任务中,这种轻量但高覆盖的方式,往往能快速找到一个令人满意的初步最优解。

🌟 4、它适合什么场景?

简单总结几个典型应用:

-

模型初调:快速找到可行参数范围

-

大搜索空间:超参数众多、组合巨大时

-

训练成本高:希望用少量试验找到较好解

-

模型表现敏感:需要探索更大范围避免局部最优

这也是为什么随机搜索常被当作调参的起步策略,先探索,再进一步细化。

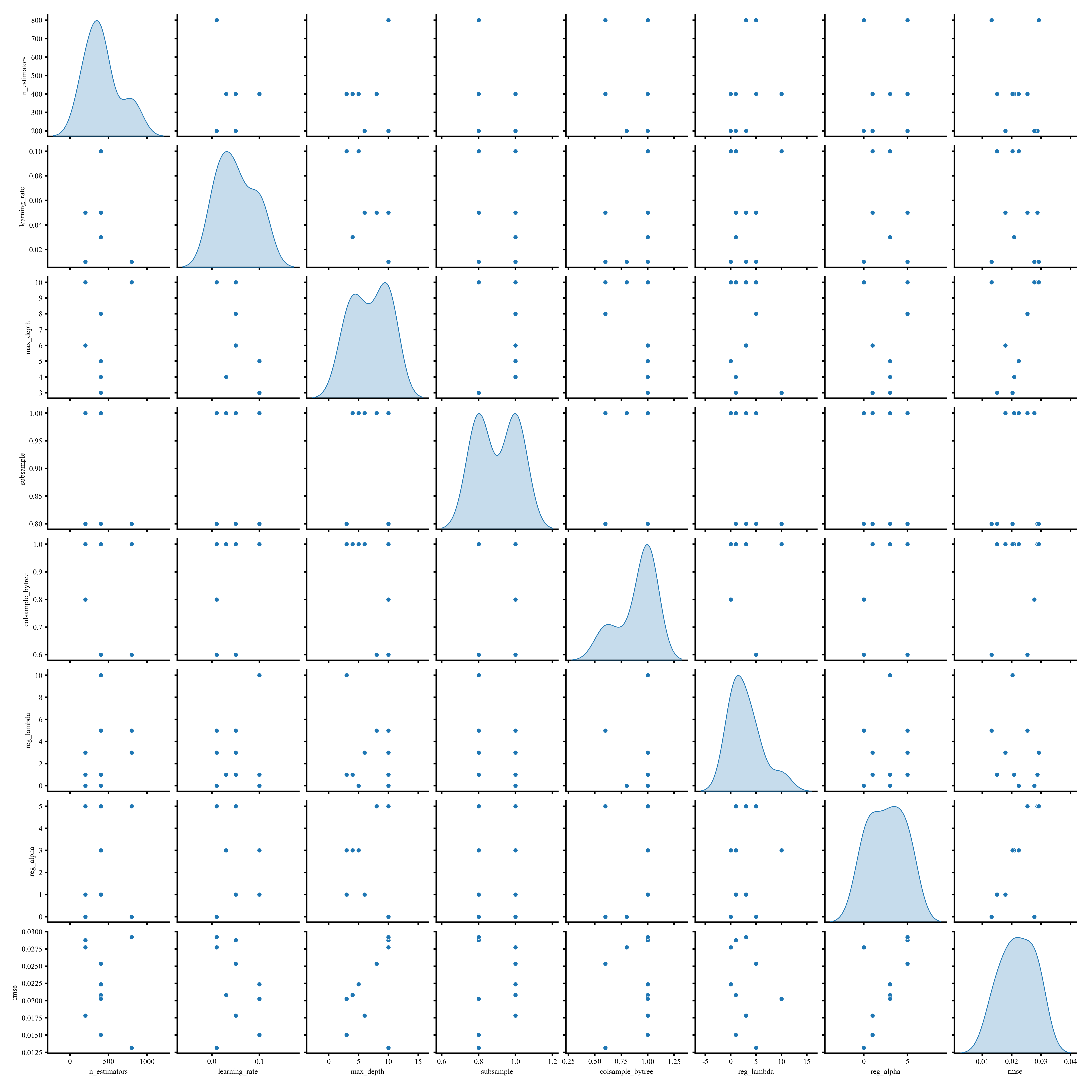

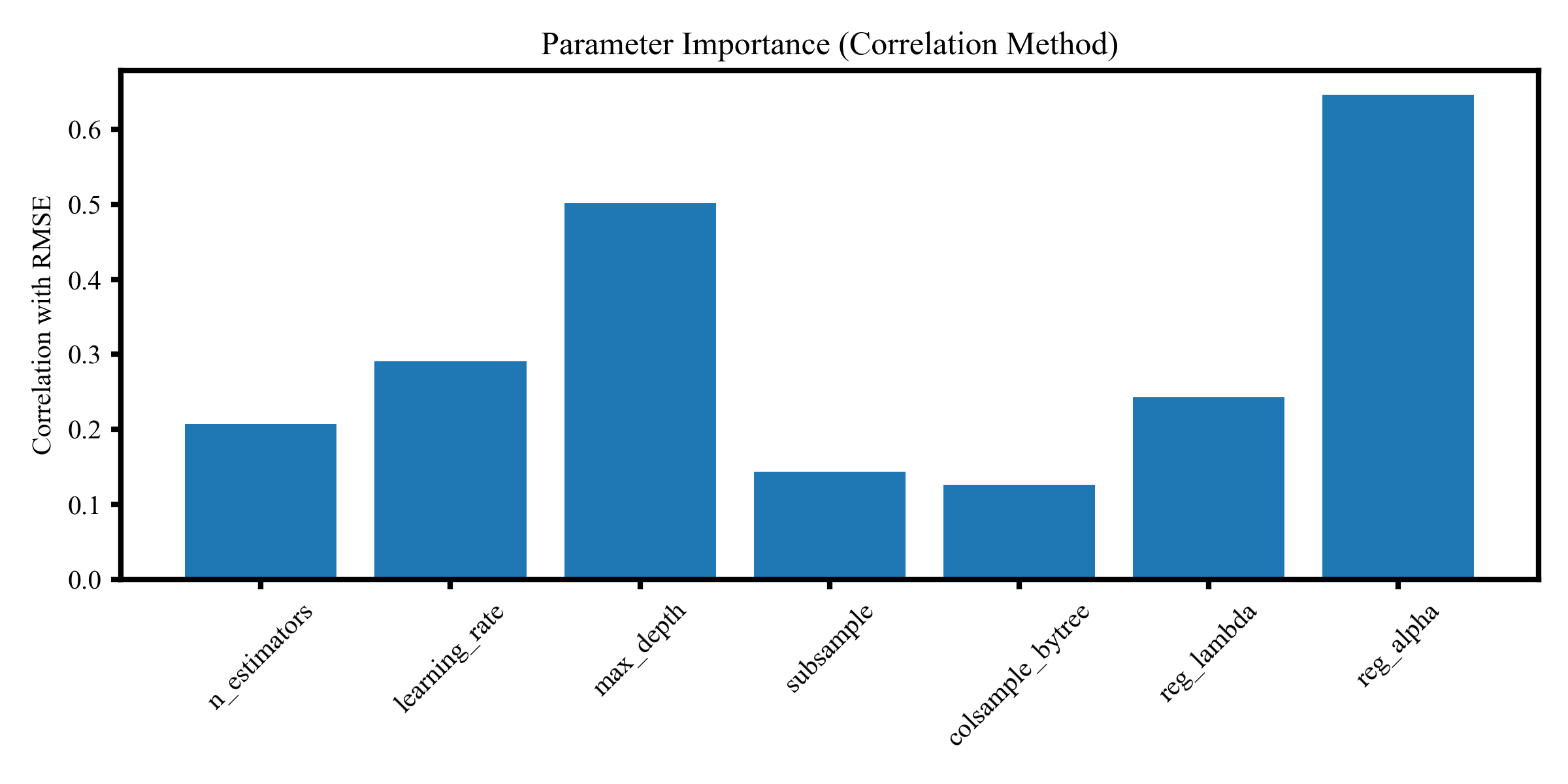

🌟 5. 程序能画非常直观的可视化

该图为超参数的成对散点矩阵图,展示不同超参数之间的分布特征与潜在关系,对角线上为各参数的概率密度分布,可用于分析参数空间结构与抽样多样性。

该图展示超参数与模型误差的相关性重要性排名,不同柱状高度反映各参数对 RMSE 的影响强弱,其中 reg_alpha、max_depth 和 learning_rate 贡献最高,有助于确定调参重点方向。

5 代码包含具体内容一览

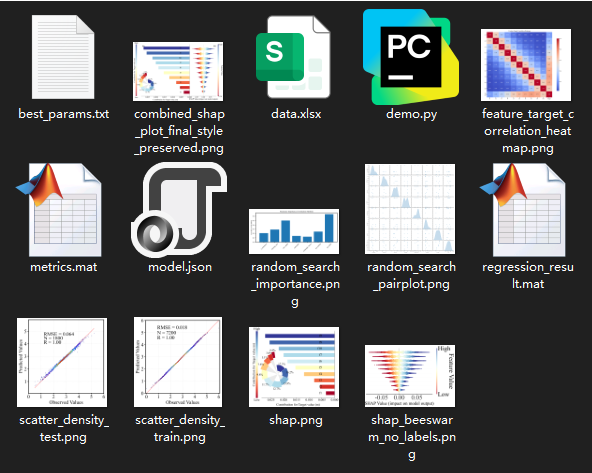

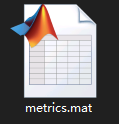

我的代码程序中将参数最优值输出到当前目录的best_params.txt文本中,

并将训练集和测试集的精度评估指标保存到 metrics. Mat 矩阵中。共两行,第一行代表训练集的,第二行代表测试集的;共 7 个精度评估指标,分别代表 R, R2, ME, MAE, MAPE, RMSE 以及样本数量。

保存的regression_result.mat数据中分别保存了名字为Y_train、y_pred_train、y_test、y_pred_test的矩阵向量。

同样的针对大家各自的数据训练出的模型结构也保存在model.json中,方便再一次调用。

调用的程序我在程序中注释了,如下

# 加载模型

# model.load_model("model.json")

主程序如下,其中从1-10,每一步都有详细的注释,要获取完整程序,请转下文代码获取

# =========================================================

# 主程序

# =========================================================

def main():

print("=== 1. 读取数据 ===")

data = pd.read_excel("data.xlsx")

X = data.iloc[:, :10].values

y = data.iloc[:, 10].values

feature_names = list(data.columns[:10])

print("=== 2. 划分训练与测试 ===")

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)

print("=== 3. 归一化 ===")

scaler_X = MinMaxScaler()

scaler_y = MinMaxScaler()

X_train_norm = scaler_X.fit_transform(X_train)

X_test_norm = scaler_X.transform(X_test)

y_train_norm = scaler_y.fit_transform(y_train.reshape(-1, 1)).ravel()

print("=== 4. 模型训练 ===")

model = train_model(X_train_norm, y_train_norm)

print("=== 5. 预测(反归一化到原始尺度) ===")

y_pred_train_norm = model.predict(X_train_norm)

y_pred_test_norm = model.predict(X_test_norm)

y_pred_train = scaler_y.inverse_transform(

y_pred_train_norm.reshape(-1, 1)

).ravel()

y_pred_test = scaler_y.inverse_transform(

y_pred_test_norm.reshape(-1, 1)

).ravel()

print("=== 6. 模型评估 ===")

metrics_train = evaluate_model(y_train, y_pred_train)

metrics_test = evaluate_model(y_test, y_pred_test)

print("\n训练集评估指标:")

for k, v in metrics_train.items():

print(f" {k}: {v:.4f}" if isinstance(v, float) else f" {k}: {v}")

print("\n测试集评估指标:")

for k, v in metrics_test.items():

print(f" {k}: {v:.4f}" if isinstance(v, float) else f" {k}: {v}")

print("=== 7. 保存结果到 MAT 文件 ===")

result_dict = {

"y_train": y_train.astype(float),

"y_pred_train": y_pred_train.astype(float),

"y_test": y_test.astype(float),

"y_pred_test": y_pred_test.astype(float),

}

savemat("regression_result.mat", result_dict)

print("已保存 regression_result.mat")

# 按指标顺序排列

metrics_matrix = np.array([

[metrics_train['R'], metrics_test['R']],

[metrics_train['R2'], metrics_test['R2']],

[metrics_train['ME'], metrics_test['ME']],

[metrics_train['MAE'], metrics_test['MAE']],

[metrics_train['MAPE'], metrics_test['MAPE']],

[metrics_train['RMSE'], metrics_test['RMSE']],

[metrics_train['样本数'], metrics_test['样本数']]

], dtype=float)

savemat("metrics.mat", {"metrics": metrics_matrix})

print("已保存 metrics.mat(矩阵大小 7×2)")

print("=== 8. SHAP 分析 ===")

X_combined = np.vstack([X_train_norm, X_test_norm])

X_df = pd.DataFrame(X_combined, columns=feature_names)

# shap_results = shap_analysis(model, X_combined, feature_names)

plot_shap_dependence(model, X_combined, feature_names, X_df)

print("=== 9. 密度散点图 ===")

plot_density_scatter(

y_test, y_pred_test, save_path="scatter_density_test.png"

)

plot_density_scatter(

y_train, y_pred_train, save_path="scatter_density_train.png"

)

print("=== 10. 相关性热图 ===")

correlation_heatmap(data, feature_names)

print("=== 完成!===")

if __name__ == "__main__":

main()

6 代码获取

Python | 随机搜索参数优化的XGBoost+SHAP可解释性分析回归预测及可视化算法

新手小白/python 初学者请先根据如下链接教程配置环境,只需要根据我的教程即可,不需要安装 Python 及 pycharm 等软件。如有其他问题可加微信沟通。

Anaconda 安装教程(保姆级超详解)【附安装包+环境玩转指南】

https://mp.weixin.qq.com/s/uRI31yf-NjZTPY5rTXz4eA

4985

4985

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?