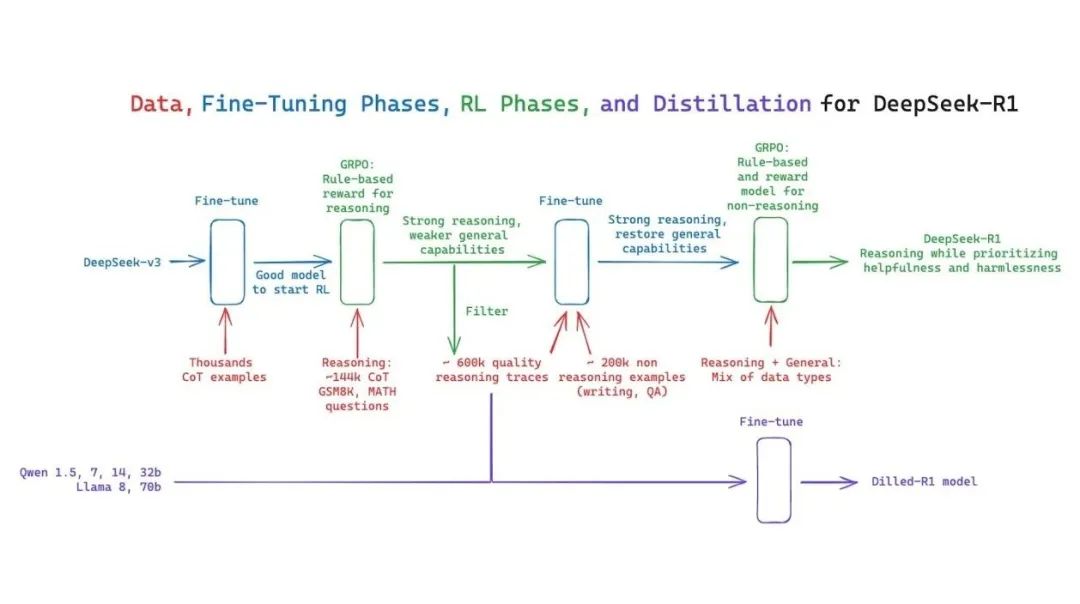

**DeepSeek****推出了第一代推理模型——****DeepSeek-R1-Zero和DeepSeek-R1,**通过强化学习激励大型语言模型(LLMs)的推理能力。

**

DeepSeek-R1-Zero是一个未经监督微调(SFT)这一初步步骤,直接通过大规模强化学习(RL)训练的模型。通过强化学习,DeepSeek-R1-Zero自然地展现出众多强大且引人入胜的推理行为。然而,它也面临着可读性差和语言混杂等挑战。**

为了解决这些问题并进一步提升推理性能,DeepSeek推出了DeepSeek-R1,该模型在强化学习之前加入了多阶段训练和冷启动数据。DeepSeek-R1在推理任务上的性能可与OpenAI-o1-1217****相媲美。

为了支持研究界,DeepSeek开源了DeepSeek-R1-Zero、DeepSeek-R1,以及基于Qwen和Llama从DeepSeek-R1中提炼出的六个密集模型(15亿、70亿、80亿、140亿、320亿、700亿参数)。

一、有监督微调(SFT)

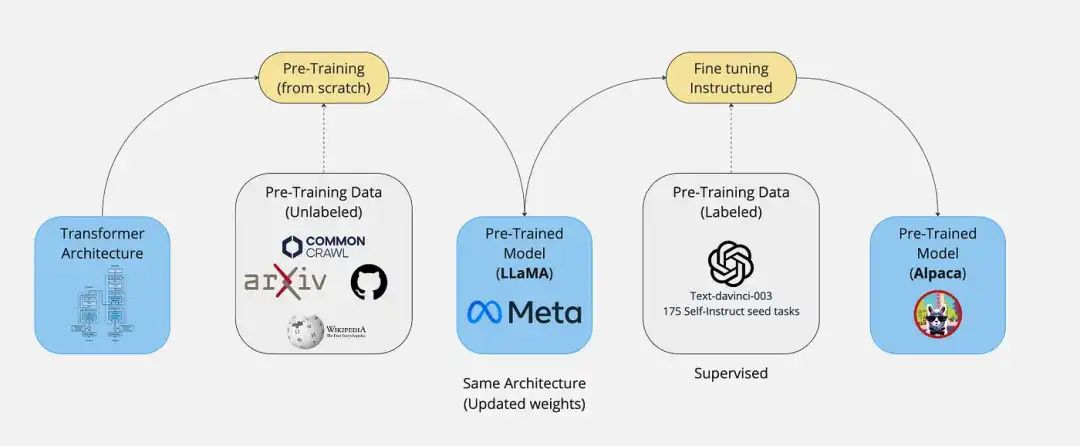

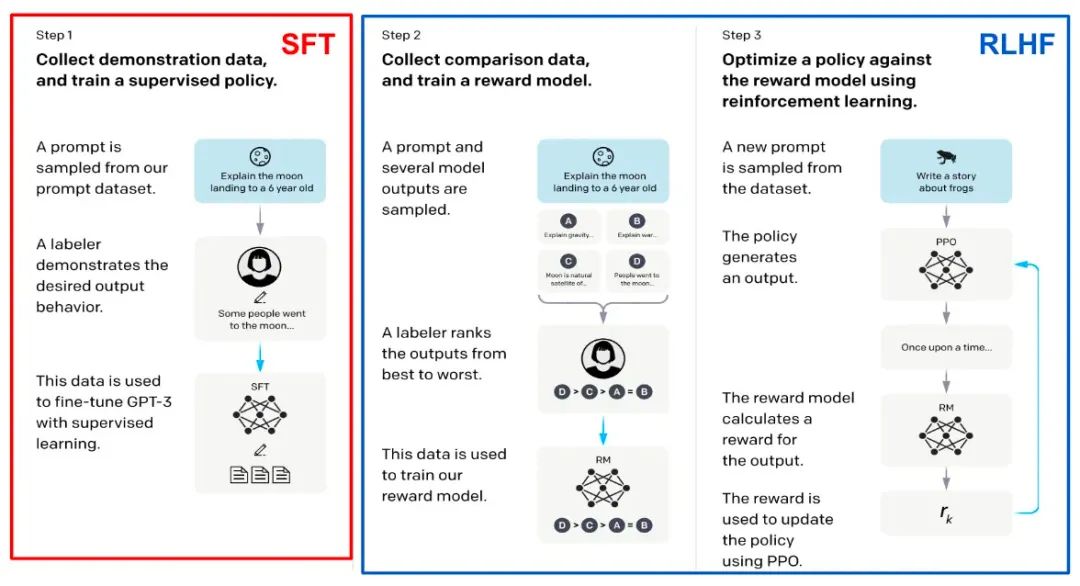

有监督微调(Supervised Fine-Tuning,SFT)是什么?有监督微调是指在已经训练好的大型语言模型(如GPT、Llama等)基础上,通过使用有标注的特定任务数据进行进一步的训练,从而使模型具备在特定任务或领域上表现更好的能力**。这种技术通常涉及对模型权重的微调,以最小化任务特定的损失函数。**

有监督微调(SFT)的核心在于利用有限的标注数据,对预训练模型进行精细化调整。预训练模型通常是在大规模无监督数据集上训练的,已经掌握了语言的基本结构和知识。通过引入标注数据,模型可以针对特定任务进行微调,学习如何在该任务上进行预测和推理。

******DeepSeek-R1为什么不使用有监督微调(SFT)********?DeepSeek-R1摒弃了传统的有监督微调作为初步步骤的做法,**旨在通过纯粹的强化学习(RL)来训练模型,以激发模型的自主学习能力。

这一理念认为,通过让模型在自主试错中学习正确的方法(即Self play),可以更符合人类的思维规则,同时提升模型的适应性和灵活性。

DeepSeek-R1通过强化学习提升了自主学习能力,无需依赖大量标注数据,从而实现了与有监督微调模型相媲美的推理性能,这一特性不仅降低了数据成本,还显著增强了模型的适应性。

二、强化学习(RL)

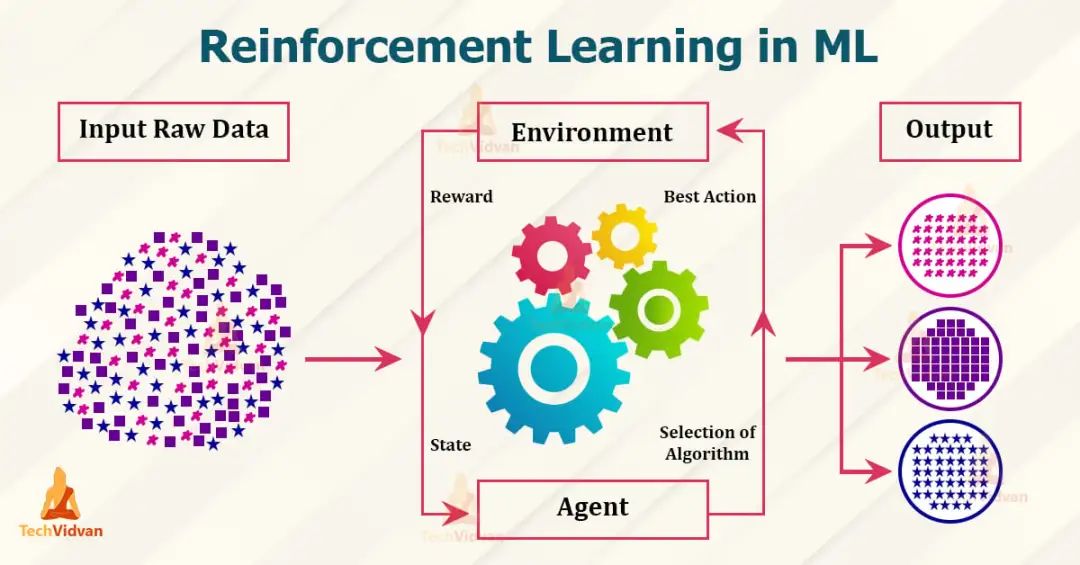

******强化学习(Reinforcement Learning, RL)******是什么?强化学习专注于探索模型如何通过与环境的互动,利用试错方式学习最优策略,旨在最大化累积奖励。

强化学习的核心在于模型(通常被称为智能体)会在环境中执行一系列动作,并根据这些动作所获得的奖励来不断优化其行为策略。在DeepSeek中,强化学习被用于提升模型的推理能力。

DeepSeek-R1********************为什么使用强化学习(RL)?DeepSeek-R1采用强化学习是为了提升推理能力并减少对监督数据的依赖,实现模型在复杂环境中的自我优化与进化。

DeepSeek-R1利用强化学习来训练模型,使其能够在特定任务环境中(如数字游戏、数学推理题等)通过不断尝试和反馈来学习如何改进策略,以获得更高的奖励。这个过程类似于人类的学习方式,即通过试错和经验积累来逐渐掌握技能********。****

2024最新版优快云大礼包:《AGI大模型学习资源包》免费分享**

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

3893

3893

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?