对于AI产品经理来说,掌握大模型“微调”能力,是从构想产品到落地业务的关键一环。这篇文章从0到1拆解大模型微调的核心方法、数据策略和落地路径,并用通俗案例帮你真正理解「如何让一个通用大模型为我所用」。

一、微调是啥?为什么我们要“调”大模型?

通俗来说,大模型预训练好比一个人读完了整个互联网的百科全书,它什么都知道一点,但没有特别擅长的领域。

但你的业务是“交管报告生成”“非现场执法判断”“医院病历摘要”“金融问答”这种极强专业性任务。这时,直接使用通用模型往往答非所问,语气风格也不对。这就需要微调:

✅ 预训练:让模型成为“通才” ✅ 微调:让它变成“专家”

二、主流微调方法都有哪些?如何选?

举例理解: 你想让模型生成一份“交通违法行为汇总报告”:

-

用 Prompt 就像你不断提示它:“请写一份总结”

-

用 LoRA 就是给模型植入一个“写交通报告”的小能力插件

-

用 RAG 则是让它在一个交通规则数据库里边查边写

三、数据才是微调的灵魂:如何构建数据集?

“没有好数据,哪怕模型再大,也没用。”

数据格式范式(Instruction Tuning 通用格式):

{

构建流程建议:

-

确定微调任务类型:分类/摘要/风格改写/问答?

-

设计样本模板:例如从“语音问询”变成“标准报告语言”

-

借助 GPT 生成初版数据,再由人工校对优化

-

打标签:精细标注风格、准确性、格式

-

小批量试训验证质量

✅ 建议起量:500–2000 条高质量样本 + 数据多样性设计

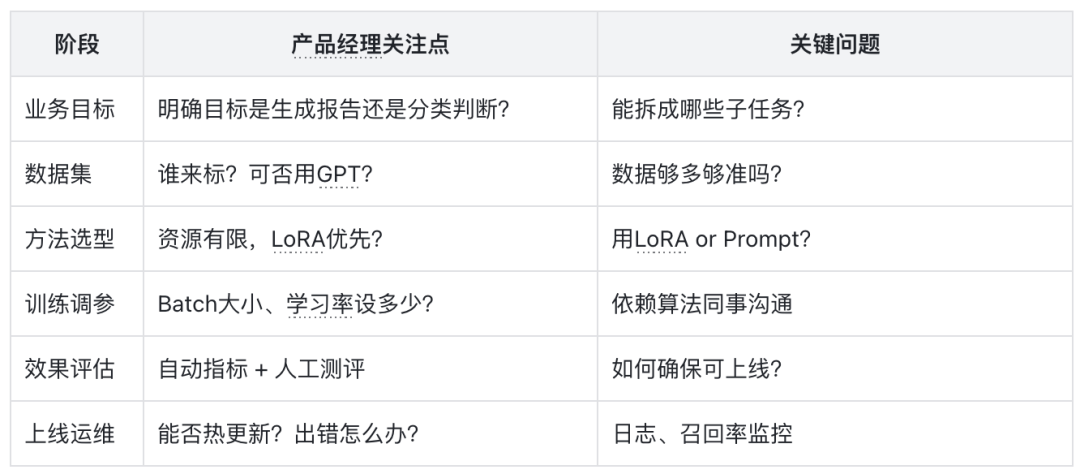

四、微调流程全景图

业务目标 → 数据构建 → 方法选择 → 参数配置 → 模型训练 → 效果验证 → 上线部署

每一步你可以关注:

五、效果评估:不能只靠模型说好,还要“人”说好

实用建议:先用小数据做试验,不满意就改 Prompt 和模板,再扩大规模微调。

六、产品经理做微调,最容易踩的坑有哪些?

-

误区1:把微调当成 Prompt 魔法升级,其实核心是“数据质量”。

-

误区2:以为算法团队包办全部微调,其实数据、场景、标准都需要产品主导。

-

误区3:忽视上线后的监控和维护,模型能力衰退不可忽视。

正确姿势:主导业务拆解 + 联合产数策划 + 引导GPT助力标注 + 主抓评估上线闭环

结语:微调是你和大模型之间的“握手协议”

产品经理想让 AI 为你所用,最重要的不是“懂算法”,而是会拆业务、做数据、控流程、评效果。大模型不是万能的,但通过微调,它可以变得非常懂你。

2024最新版优快云大礼包:《AGI大模型学习资源包》免费分享**

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?